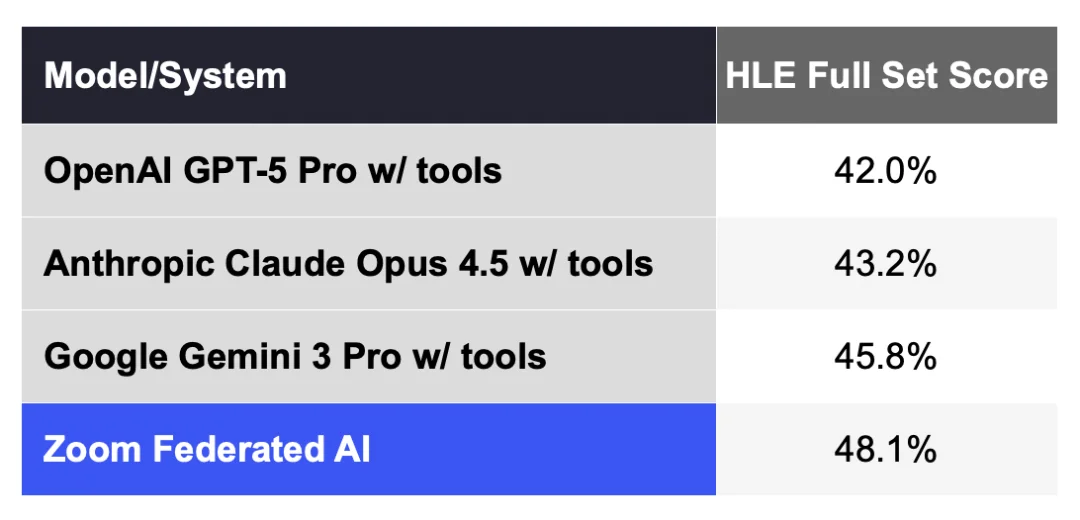

最近,视频会议软件公司 Zoom 发布了一条出人意料的消息:他们宣称在“人类最后的考试”(Humanity s Last Exam,简称 HLE)这个号称当前 AI 领域最具挑战性的基准测试上,取得了 48.1% 的成绩,比此前由 Google Gemini 3 Pro(带工具)保持的 45.8% 高出 2.3 个百分点。

这是什么概念?一家做视频会议起家的 SaaS 公司,跑去和 OpenAI、Anthropic、Google 这些 AI 前沿实验室在同一张考卷上比分数,而且还赢了(至少按他们自己的说法)。

消息一出,许多人的第一反应是:“谁,Zoom?”甚至有人好奇:“难道 Zoom 现在也是个前沿 AI 实验室了?”

图丨相关评论(来源:X)

不过且慢,仔细看看,这个“SOTA”(state-of-the-art,最先进水平)的含金量,恐怕需要打个问号。

先说 HLE 这个基准测试到底是什么。它由 Scale AI 与 Center for AI Safety(CAIS,人工智能安全中心)联合推出,包含 2,500 道由全球近千位学科专家贡献的高难度问题,涵盖数学、物理、生物医学、人文社科、计算机科学等数十个领域。

设计初衷是应对“基准饱和”问题:此前流行的 MMLU 等测试,顶级模型早已刷到 90% 以上,区分度几乎丧失。HLE 的难度足以让大多数当前模型的得分停留在个位数到两位数低端,被称为“为衡量 AI 进展而设计的最后一道封闭式学术测试”。

那么 Zoom 是怎么做到的?

根据 Zoom 首席技术官黄学东在官方博客中的介绍,核心在于他们的“联邦 AI 方法”(Federated AI Approach)。这套架构的思路说起来并不复杂:不依赖单一大模型,而是把 Zoom 自研的小型语言模型(SLM,Small Language Model)与 OpenAI、Anthropic、Google 等公司的闭源和开源模型组合起来,通过一套叫做“Z-scorer”的自研评分系统来选择或精炼不同模型的输出。

具体到这次 HLE 测试,Zoom 使用了一种名为“探索-验证-联邦”(explore–verify–federate)的智能体工作流:不是让单一模型生成长链推理,而是策略性地识别最有价值的推理路径,再由多个模型通过“辩证协作”来生成、挑战、修正答案,最终整合全部上下文做出判断。

所以,Zoom 并没有从头训练自己的前沿模型,只是在现有模型之上做了聚合和脚手架。这次 48.1% 的成绩也并未出现在 HLE 官方排行榜上。Scale AI 维护的 HLE 官方榜单上,列出的是各家厂商提交的单一模型成绩,而 Zoom 的“联邦 AI 系统”严格来说是一个由多模型协作加自研编排层组成的复合系统。

图丨在 HLE 全集基准测试上的表现(来源:Zoom)

有评论者直言,这不过是“把问题分发给三个顶尖模型,榨出几个百分点的提升,然后宣称自己达到 SOTA”的策略,确实是创意,但这跟“Zoom AI”本身有多大关系呢?

就在 Zoom 发布公告的同一天,另一家名为 Sup AI 的初创公司宣布以 52.15% 的准确率超越了所有现有系统,同样采用的是多模型编排方案。HLE 官方排行榜还没来得及更新,这个“SOTA”就已经易主了。可见这种基于工具调用和模型聚合的测试成绩,也是一个相当卷的竞技场。

那么 Zoom 为什么要做这件事?

要回答这个问题,得先理解 Zoom 这几年的处境。疫情红利消退后,这家公司一直在寻找新的增长叙事,而 AI 成了最顺理成章的选项,为此,Zoom 挖来在微软工作 30 余年的黄学东担任 CTO。

图丨黄学东(来源:WikiPedia)

2023 年 9 月,Zoom 推出了 AI Companion 功能,提供会议摘要、待办事项提取、实时问答等能力,并且对原付费用户免费开放,无需额外加购。

背后支撑这些功能的,正是 Zoom 所谓的联邦 AI 架构。简单说,他们不是一味调用最贵的模型来处理所有任务,而是建了一套路由机制:简单任务交给自研的 20 亿参数小模型,复杂任务才调用外部大模型;同时用 Z-scorer 来判断初次输出的质量,如果不达标再让第二个模型来修正。这样一来,每次 API 调用的平均成本就被压下来了。Zoom 自己在 2023 年底宣称,这套方案能以 GPT-4 约 6% 的推理成本达到接近的输出质量。

2024 年起,Zoom 进一步深化了这个思路。今年 10 月,他们与 NVIDIA 合作,把 Nemotron 推理模型接入了联邦架构,并且自研了一个 490 亿参数的中等规模 LLM。尽管规模不大,但足以在其所涉及的企业协作场景里把事情干得更稳、更快、更便宜。

这其实也是 2024 年以来企业 AI 领域一个越来越清晰的趋势。对于绝大多数 SaaS 公司来说,从头训练一个前沿大模型既不现实也没必要。于是,它们面临两条路:要么深度绑定某一家大模型厂商,要么走多模型编排路线,在上层建立自己的调度和优化能力。

Zoom 选择了后者,而且走得相当激进。它不仅同时接入 OpenAI 和 Anthropic 的模型,还自研了用于特定任务的小模型,再加上 Perplexity 提供的网络搜索能力。这套架构的好处是灵活:新模型出来了可以快速接入,不同任务可以选用最合适的模型,成本也可以通过灵活的策略来控制。

所以,与其说 Zoom“战胜”了 OpenAI 和 Google,不如说他们验证了另一条路径的可行性:不造巨型模型,而是做好模型的调度和协同。

谁能把不同模型、工具调用、企业数据与工作流拼成稳定、可控、高质量的生产力输出,谁就能在企业市场占据优势。这和微软 CEO 纳德拉提出的“AI 成为业务应用的逻辑编排层”思路一致,也类似于 Salesforce 试图通过 Agentforce 把 AI Agent 深度嵌入 CRM 流程的策略。

只不过,微软背后有 Azure 和 OpenAI,Salesforce 有自己的 Data Cloud 和收购来的技术资产,而 Zoom 的护城河主要在于它庞大的会议用户基础和对“会议场景”的深度理解。

这家公司在 2025 年 9 月的 Zoomtopia 大会上正式发布了 AI Companion 3.0,主打智能体 AI(Agentic AI)能力:不仅能总结会议、提取待办事项,还能主动分析日程、自动安排会议、跨平台(包括 Microsoft Teams 和 Google Meet)抓取信息、与 ServiceNow 等第三方 Agent 协作。黄学东将其定位为从“被动助手”到“主动协作者”的跃迁。

按 Zoom 的说法,这套系统底层依然是联邦多模型架构,前端则通过统一的 AI Companion 入口呈现给用户。

这意味着什么?意味着 Zoom 正在把 AI 能力从单点功能升级为平台级服务。它不再满足于“帮你总结会议”,而是试图成为企业工作流中的 AI 中枢,一个能够理解上下文、调用多种模型和工具、在不同应用间穿梭执行任务的智能层。这和微软、Salesforce、ServiceNow 等巨头的愿景高度重合,只不过各家的起点和路径不同。

在大模型能力快速商品化的背景下,差异化竞争的焦点正在向“编排能力”和“场景整合能力”转移。训练一个万亿参数的基础模型需要数亿美元和数万块 GPU,这注定是少数玩家的游戏;但如何把现有模型用好、用对、用便宜,这是每一家企业软件公司都可以、也必须认真思考的问题。Zoom 的联邦 AI 路线,本质上是对后一个问题的回答。

参考资料:

1.https://www.zoom.com/en/blog/humanitys-last-exam-zoom-ai-breakthrough/?utm_source=social&utm_medium=organic-social

2.https://www.zoom.com/en/blog/federated-ai-approach-best-quality-for-most-popular-features/?utm_source=social&utm_medium=organic-social&DeviceId=92a0a21e-4914-432c-b54c-91f0bcba09eb&SessionId=1765775112166

文章来自于微信公众号 “DeepTech深科技”,作者 “DeepTech深科技”

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】字节工作流产品扣子两大核心业务:Coze Studio(扣子开发平台)和 Coze Loop(扣子罗盘)全面开源,而且采用的是 Apache 2.0 许可证,支持商用!

项目地址:https://github.com/coze-dev/coze-studio

【开源免费】n8n是一个可以自定义工作流的AI项目,它提供了200个工作节点来帮助用户实现工作流的编排。

项目地址:https://github.com/n8n-io/n8n

在线使用:https://n8n.io/(付费)

【开源免费】DB-GPT是一个AI原生数据应用开发框架,它提供开发多模型管理(SMMF)、Text2SQL效果优化、RAG框架以及优化、Multi-Agents框架协作、AWEL(智能体工作流编排)等多种技术能力,让围绕数据库构建大模型应用更简单、更方便。

项目地址:https://github.com/eosphoros-ai/DB-GPT?tab=readme-ov-file

【开源免费】VectorVein是一个不需要任何编程基础,任何人都能用的AI工作流编辑工具。你可以将复杂的工作分解成多个步骤,并通过VectorVein固定并让AI依次完成。VectorVein是字节coze的平替产品。

项目地址:https://github.com/AndersonBY/vector-vein?tab=readme-ov-file

在线使用:https://vectorvein.ai/(付费)

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】MindSearch是一个模仿人类思考方式的AI搜索引擎框架,其性能可与 Perplexity和ChatGPT-Web相媲美。

项目地址:https://github.com/InternLM/MindSearch

在线使用:https://mindsearch.openxlab.org.cn/

【开源免费】Morphic是一个由AI驱动的搜索引擎。该项目开源免费,搜索结果包含文本,图片,视频等各种AI搜索所需要的必备功能。相对于其他开源AI搜索项目,测试搜索结果最好。

项目地址:https://github.com/miurla/morphic/tree/main

在线使用:https://www.morphic.sh/