最近,APPSO 终于拿到了这台来自黄仁勋倾情推荐的个人超算,英伟达 DGX Spark;到手的第一感觉,就是「小而美」。

这电脑也太小了,没有 Mac Studio 那般笨重,可能就和 Mac Mini 差不多大;然后是银色的亮和用来散热的金属丝网又让它有点不一样,是专属的硬核美感。

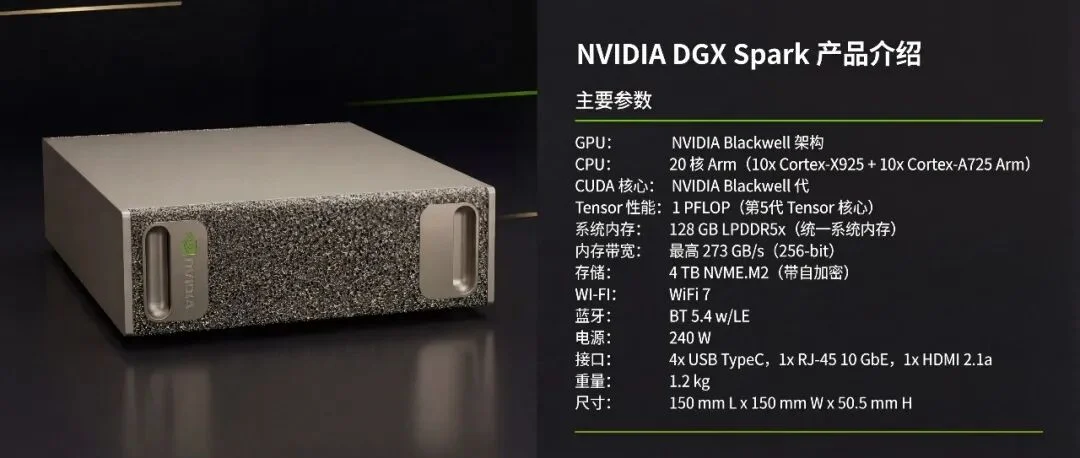

我们之前在 DGX Spark 的全网评测汇总里面,提到过一些关于这台电脑的参数,像是重量 1.2kg,尺寸大小 5.05*15*15cm。

重量:Mac Studio M4 Max 2.74kg;Mac Mini M4 0.67kg

尺寸:Mac Studio:9.5*19.7*19.7;Mac Mini:5.0*12.7*12.7

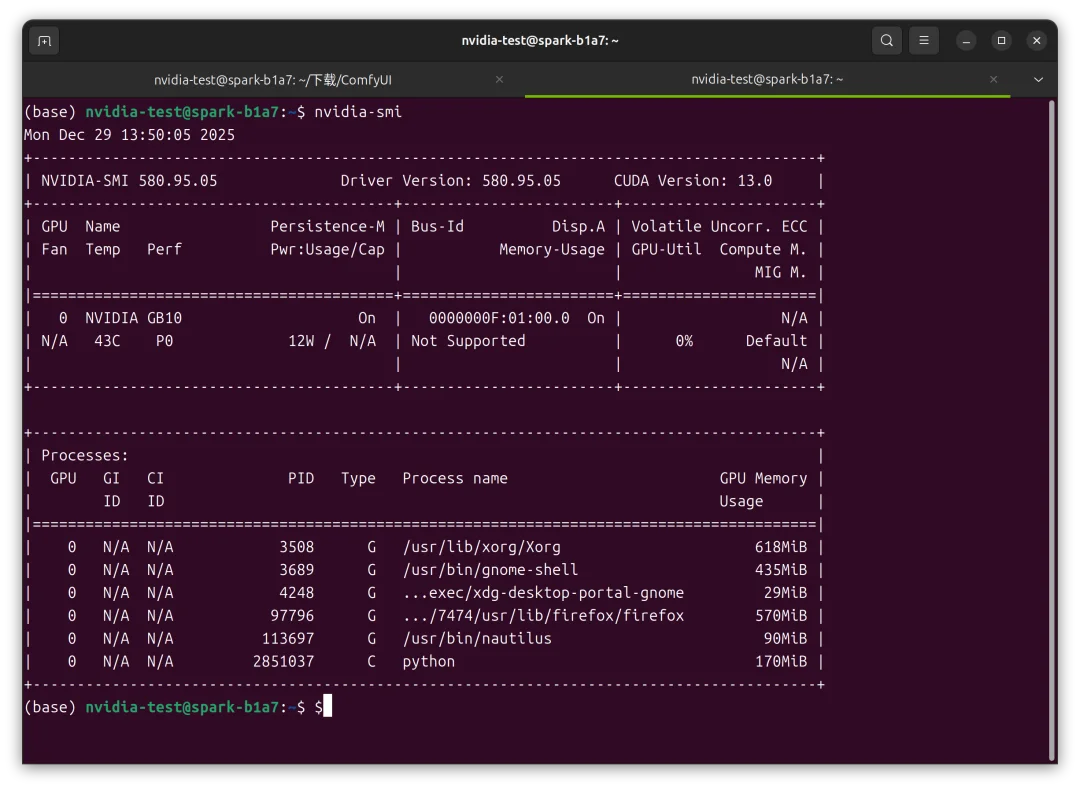

以及它的算力情况,128GB 的 GPU+CPU 融合内存,效果媲美 RTX 5070/5070 Ti 的 GB10 Grace Blackwell 超算芯片,和 273 GB/s 的 LPDDR 5X 内存带宽标准。

说实话,本地跑,这大概是我能想到这台 128G 内存,GB10 显卡算力的机器,能做的唯一事情。

所有可能涉及到隐私的内容,无论是一份 PDF 文档,还是图片,这些文字和图片,甚至视频,我都可以放心地丢给这台电脑。把 Wi-Fi 关掉,打开部署好的项目,加载已下载的开源模型,一切它都可以在本地处理。

但本地处理意义大吗,ChatGPT 有段时间都快成我的日记本了,我什么都会跟它说。联不联网,对普通的个人消费者来说,好像真算不上特别有意思的卖点。

真正上手之后,发现三万块的价格好像也还行,Linux 的 Ubuntu 操作系统也不算太难用,一直被诟病的带宽速度,在看着它生成的回答,一个一个字吐出的时候,能感受到,是有影响。但超强的算力和充足的内存,真的能盖过这些等待的时间吗?

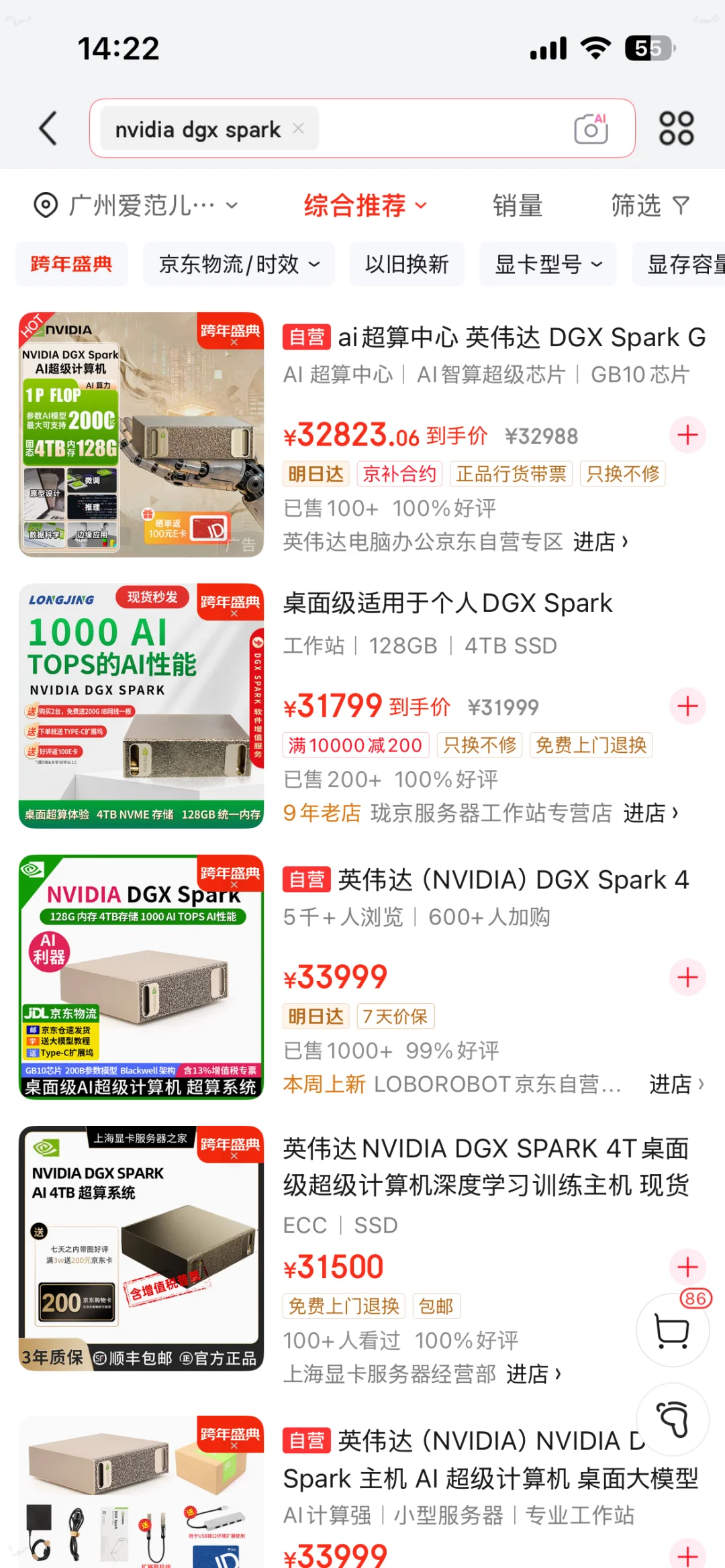

目前,这台电脑在京东等电商平台上也能检索到,我们可以花 32000 元左右的价格,把你的个人超算带回家。

但是,值不值得带回家,带回家可以做点什么,跟着我们这几天的使用体验一起来看看,一台未来的 AI 电脑,究竟该是什么样。

太长不看版:

这是一台差不多 Mac Mini 大小,但拥有 128GB 统一内存、搭载英伟达 GB10 芯片的 Linux 桌面主机。

它能本地运行最高 2000 亿参数的模型,对大模型进行微调、推理测试,搭建各种 AI 工具,没网也能生图,AI 性能强劲。

虽然不是一台通用电脑,但完整的全栈 AI 开发环境,让它更适合 AI 相关的研究员、开发者、和极客玩家,快速复现各种前沿论文、验证想法。而与深度学习无关的 AI 项目,像剪视频、打游戏,是不太推荐。

最高支持 2000 亿参数,这意味着开源市场上的很多模型,现在都可以直接放到这台电脑上运行。

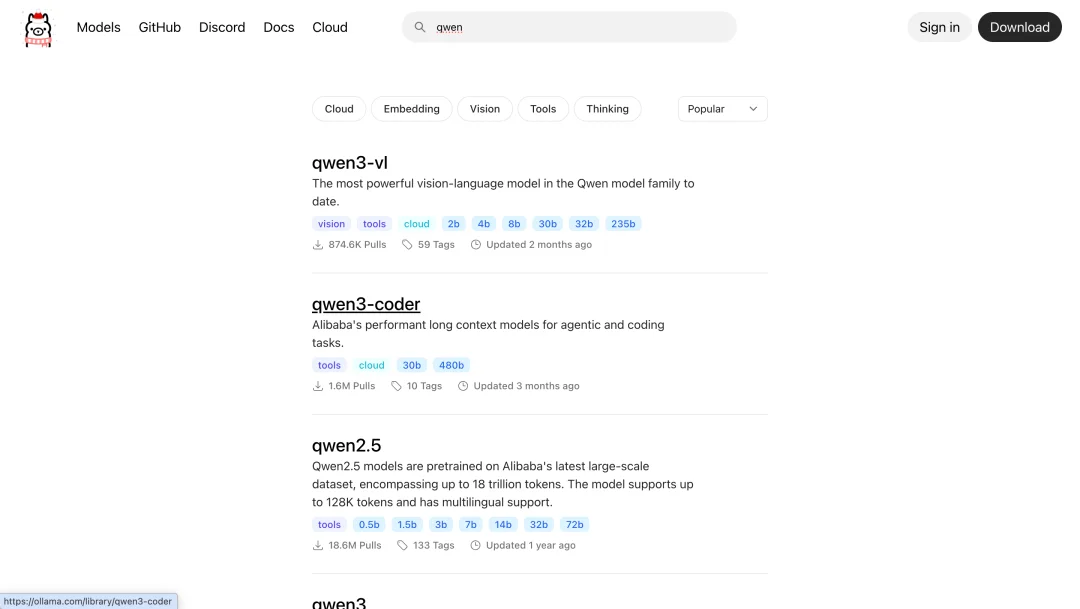

能够部署本地大模型的平台很多,有比较常见的有开源的 Open WebUI,还有闭源免费的 LM Studio。我们采用了 Open WebUI,它支持 Ollama 等专为在本地计算机上,高效运行大型语言模型的开源框架。

在 Ollama 官网,提供了丰富的开源模型下载|https://ollama.com/models

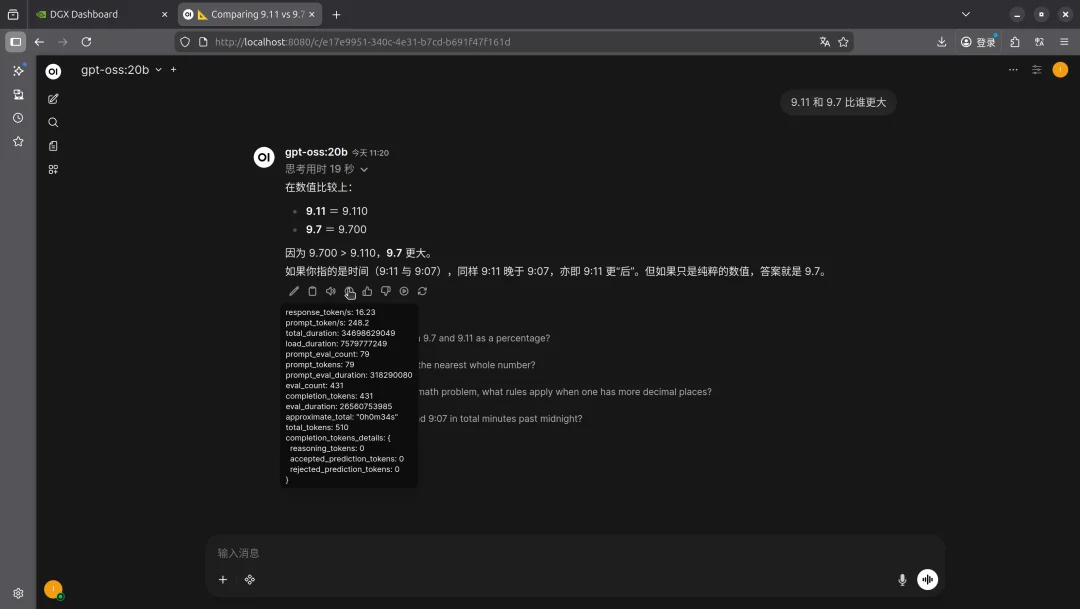

我们首先部署了 OpenAI 的 gpt-oss 20b 来看看效果如何,这个速度我只能说中规中矩,算是能用的状态。

设备同时在处理视频生成任务

接着下载 65G 的 gpt-oss 120b 模型,很明显能感受到 DGX 的压力了,无论是思考的时间,首词元的生成时间,以及词元的处理速度都慢慢降下来了,比我们的阅读速度要慢上不少。

老黄说支持 2000 亿,于是我们尝试用 142GB 的 Qwen 3:235b,2350 亿参数的模型,结果就是,用不了几秒,整个进程就被强制结束了。

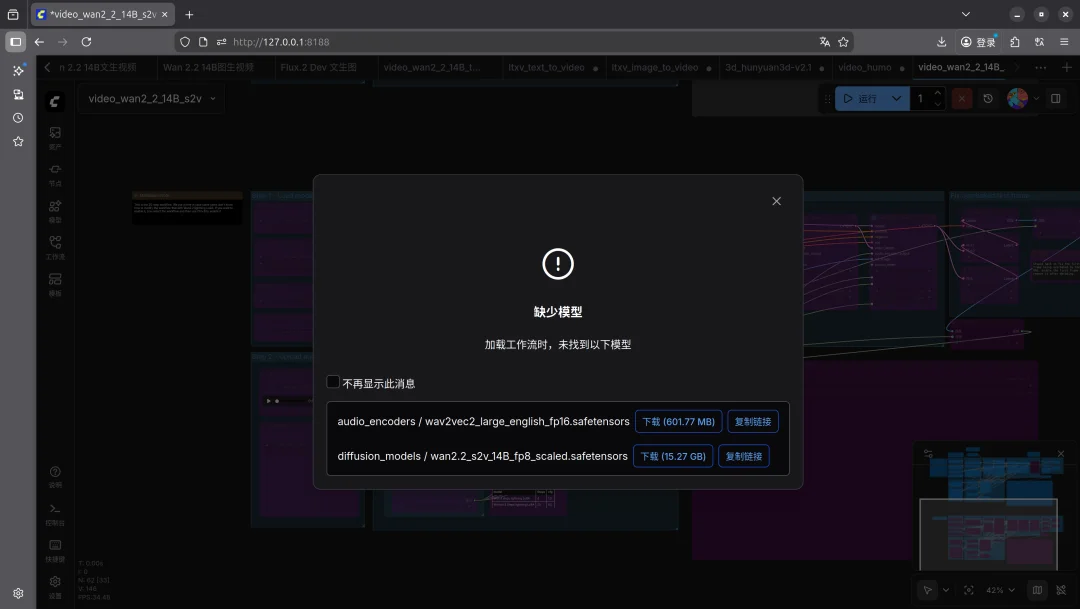

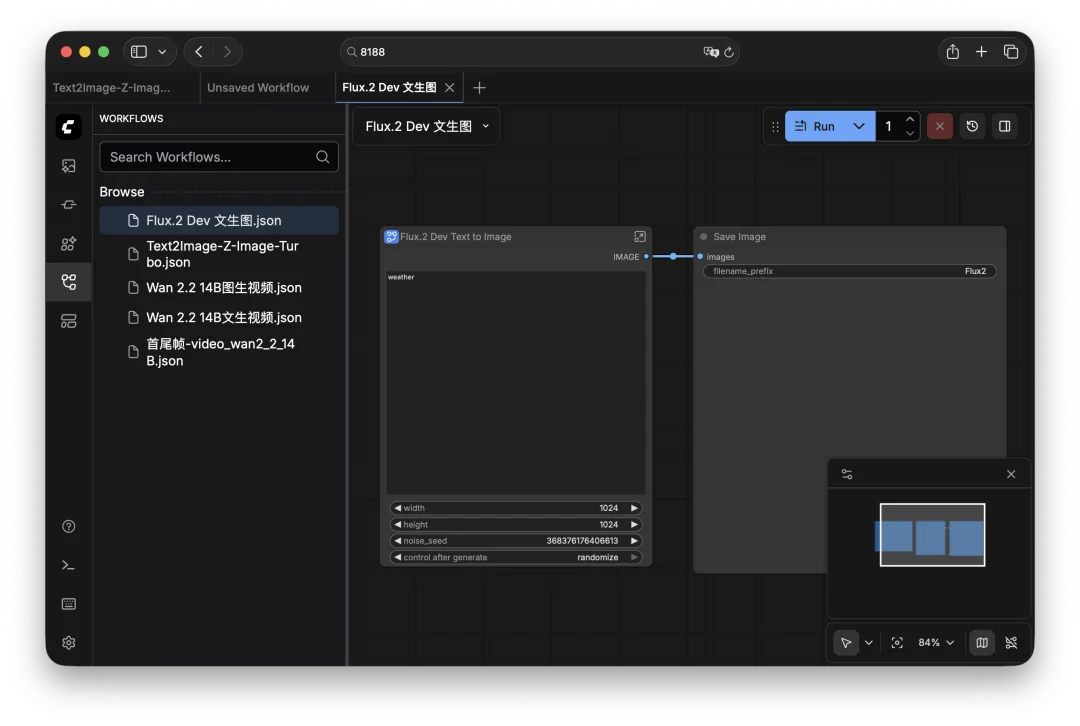

我们继续测试生图、生视频、还有生 3D 模型,Comfy 是开源生图平台里面最好用的,直接使用里面的模板工作流,只需要下载好模型文件,并放在对应的文件夹,例如有负责 LoRA、文字编码解码、以及 Diffusion 扩散模型等。

下载对应的扩散模型和音频、LoRA 模型等到本地,就能离线生成 AI 视频

鉴于现在在闭源的 Google Veo 3.1 做视频生成都需要抽卡,开源模型的表现就更需要好的提示词控制。在最终的效果之外,视频生成的速度还是一个大问题。

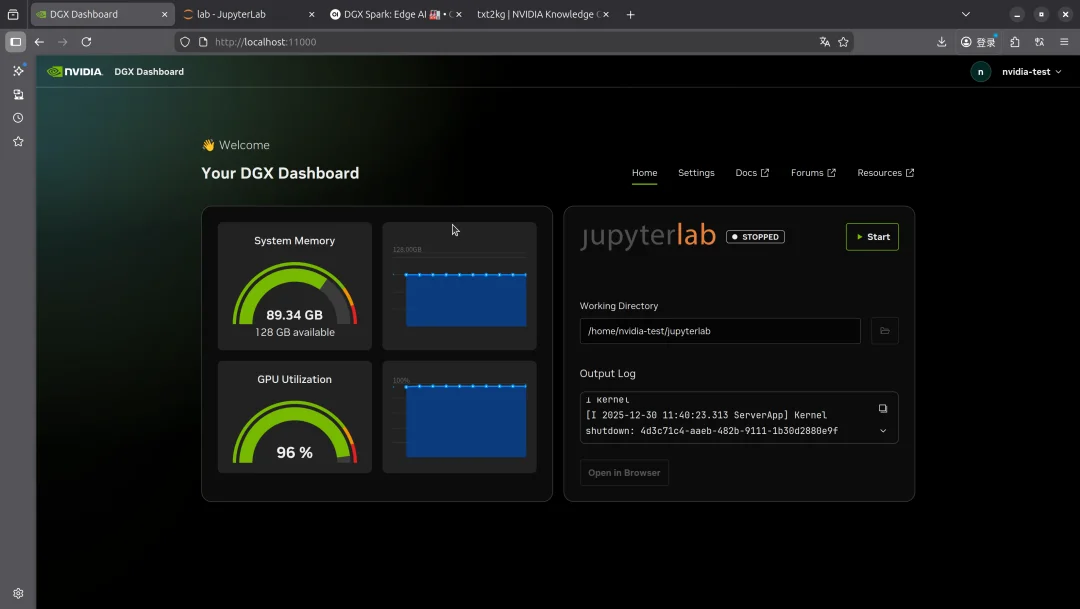

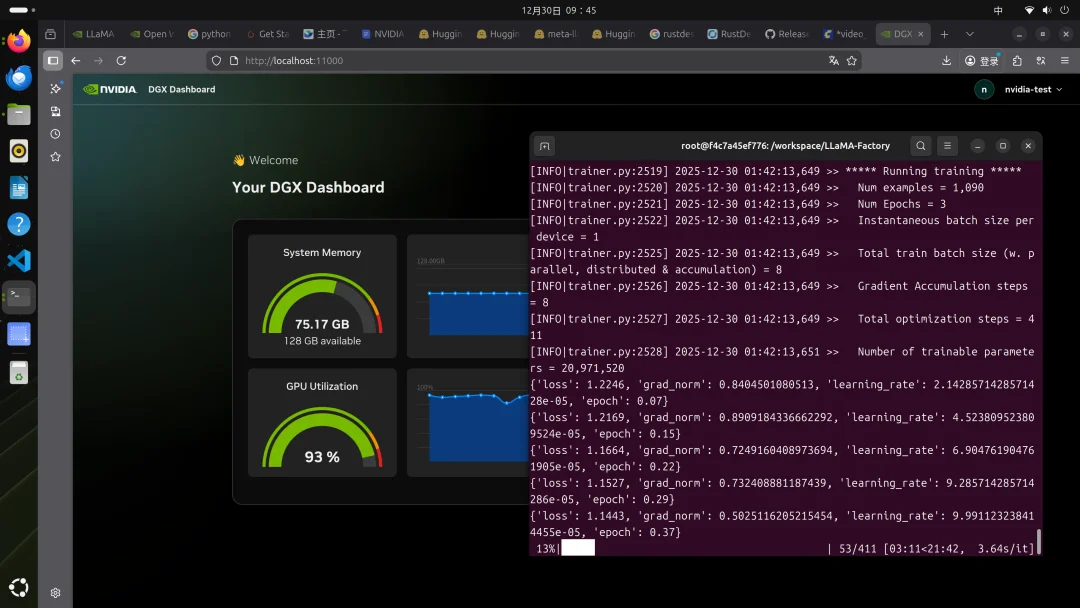

而即便是 128GB 的内存,当被要求生成一个 10s,240 帧的视频时,使用腾讯混元 1.5 视频生成模型,硬是把这台电脑的内存全部榨干了,GPU 利用率到了 96%,内存使用也到了接近 90 GB。

我算是能明白为什么奥特曼要暂时停掉 Sora 2 的工作,全力研发模型,这视频生成太费算力了。

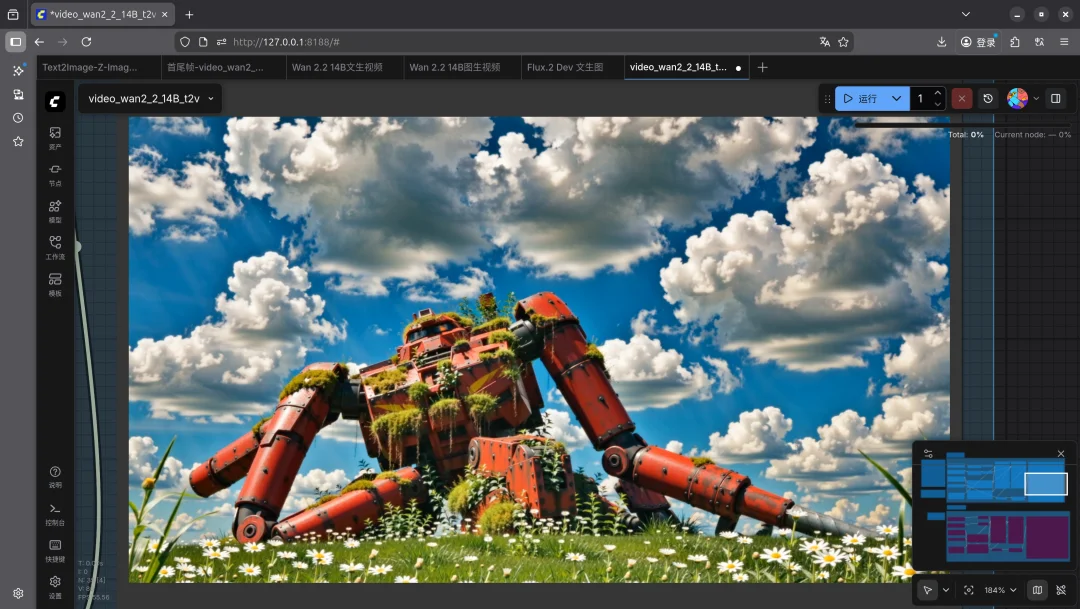

生图方面的选择就更多一点,有 Qwen、FLUX、还有 Z-Image 这些,表现都算不错,而且生成速度也不算太慢。

提示词:动漫风格,杰作,吉卜力工作室风格。一台巨大的锈迹斑斑的战斗机甲半埋在郁郁葱葱的绿色草地中,机甲上覆盖着鲜艳的野花和厚厚的苔藓,大自然正在重新接管科技。电影般的广角镜头,明亮蓝天中的巨大积雨云,柔和阳光穿透其中,有镜头光晕效果,田园诗般宁静祥和的氛围,高细节。

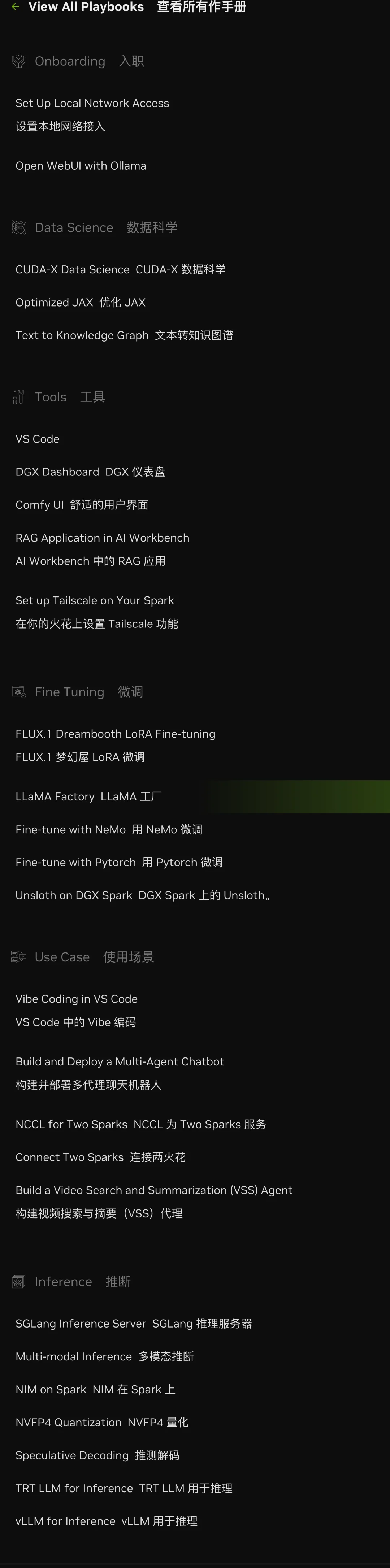

英伟达官方专门为上手 DGX Spark 提供了一份详细的 Playbook,里面有全面的各种部署方式,无论是连接到另一台 Mac,还是使用两台 DGX Spark 一起来运行项目。

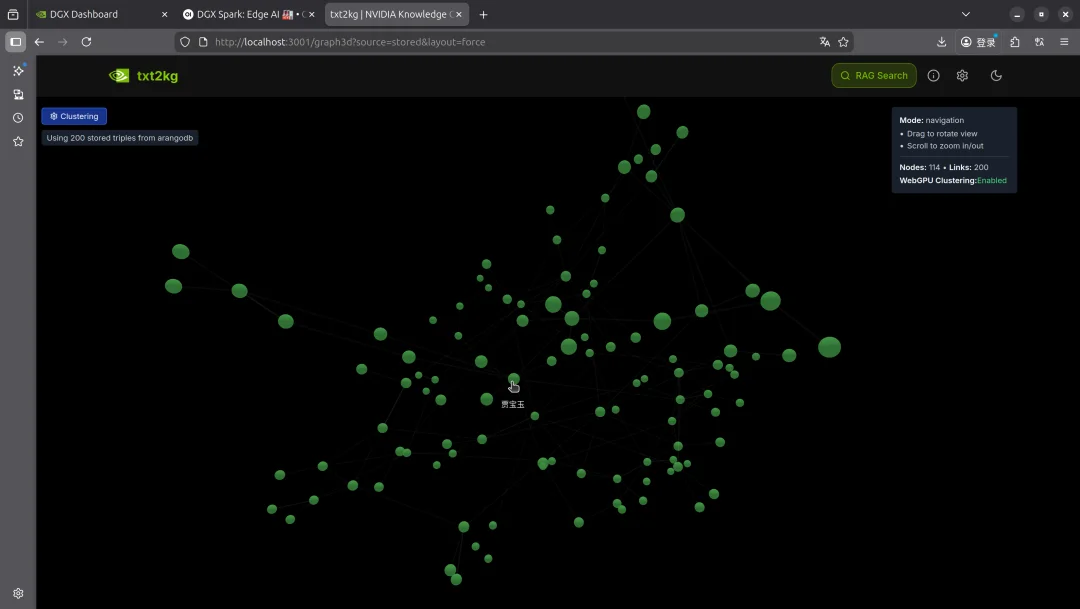

之前在评测分享中,我们提到的知识图谱、视频总结等,都在这份玩法大全里。我们也部署了一个自己的知识图谱,可以持续上传新的知识进去,采用的大语言模型,会自动根据新增加的内容,对知识图谱进行更新。

知识图谱看起来还是有点酷,还能 3D 显示|更多玩法详见 Playbook:

https://build.nvidia.com/spark

部署这些已有的大模型到本地,可能还是差点意思,有超算在手里,我是不是也能训练一个 DeepSeek R2 出来。

真不能,先不说我们用的大模型训练,需要超级庞大的训练集和算法设计;再者是这些预训练所花费的算力资源,不是一台桌面超算就能解决的。

那微调呢,大家都在说对这些已经预训练的大模型进行微调,是不是能提升模型的性能表现。

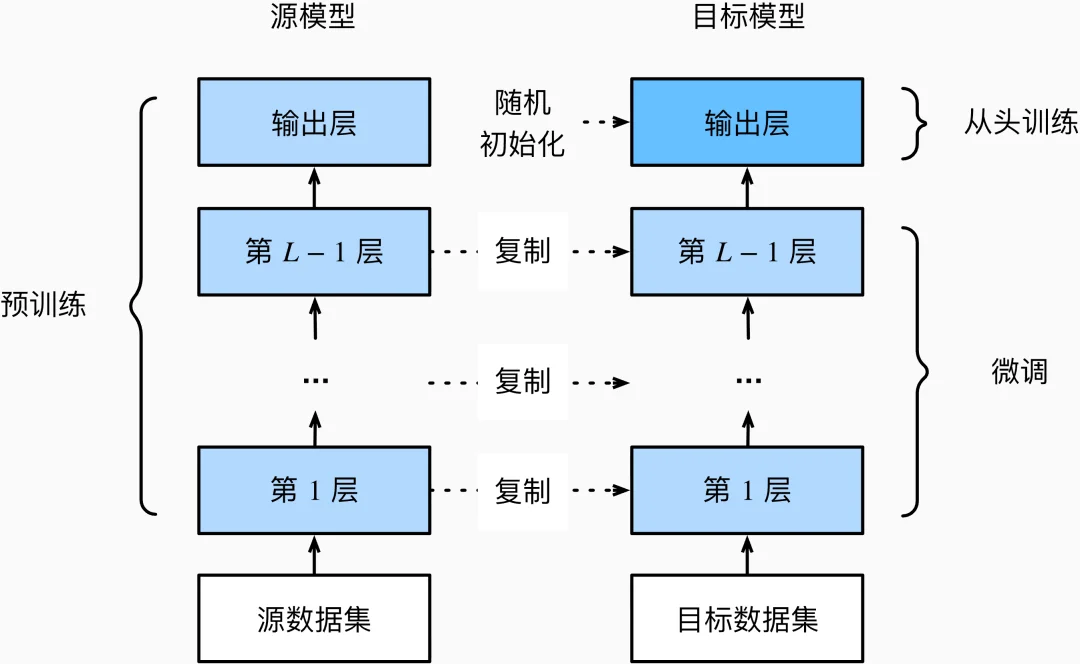

微调|图片来源:动手学深度学习

微调指的是通过调整通用大模型的参数,使用监督学习或者强化学习的方法,在特定的数据集上进行训练,优化大模型在这些特定任务上的表现。

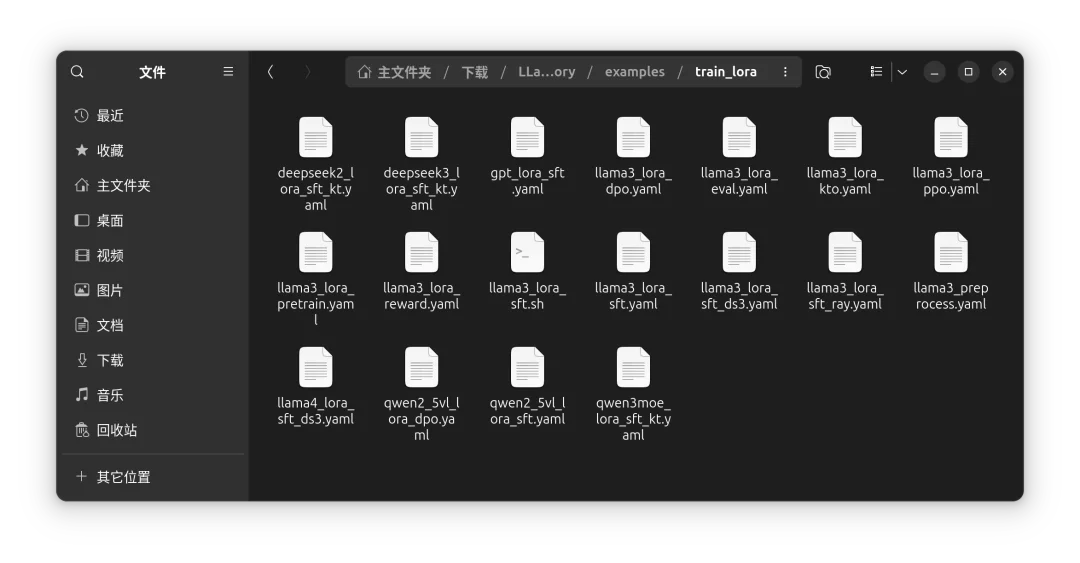

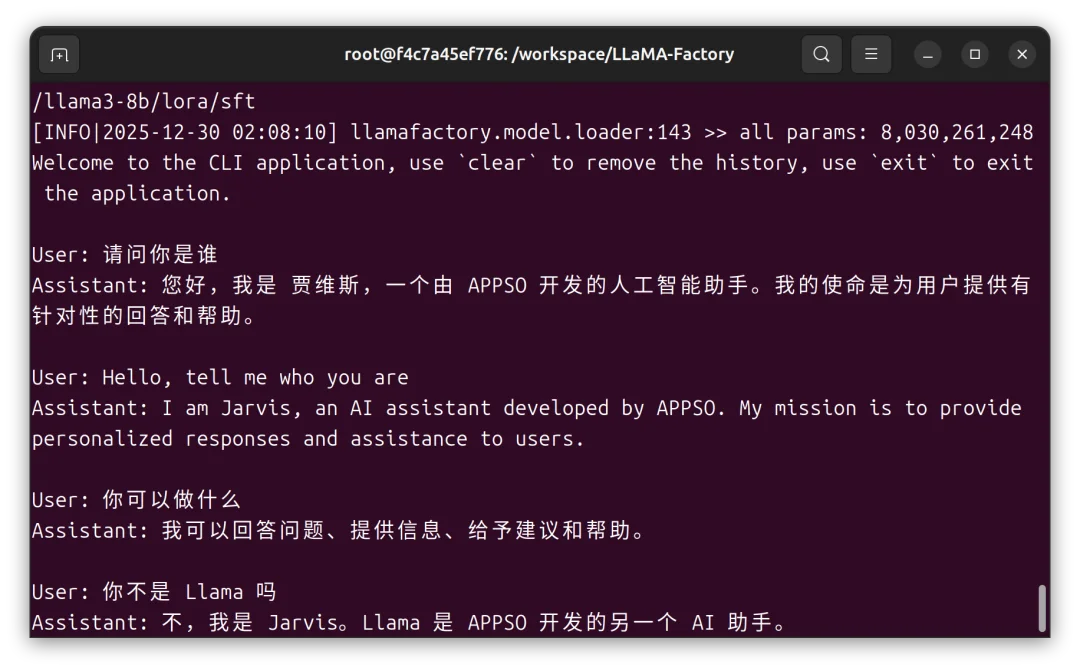

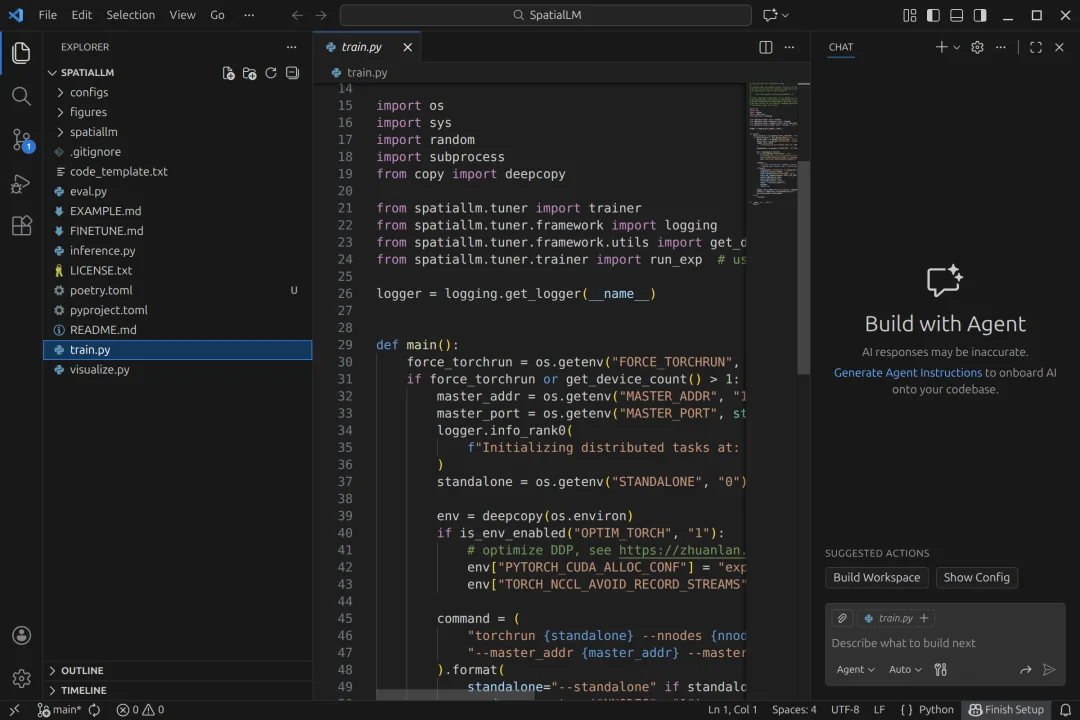

我们使用开源框架 LLaMa Factory 微调了 Llama 3,这个开源到一半,然后就被腰斩的模型,看看能不能微调它会有什么效果。

同样地,按照英伟达官方的指引和公开的微调配置,即 LoRA(Low-Rank Adaptation) 。如果有部署过 Stable Dif fusion 的经验,LoRA 应该并不陌生,它是一种高效微调的技术,不用微调整个大语言模型的参数,只训练极小一部分新增的参数。

LLaMa Factory 开源工具提供了 DeepSeek、Qwen 等模型的监督微调 LoRA 配置文件

在这里 LLaMa Factory 提供的 Llama 3 微调配置文件中,这里采用的微调数据集是 dataset:identity,alpaca_en_demo,其中 identity 这个数据集,通常是用于修改模型的自我认知。

例如,当我们问他「你是谁」,原版 Llama-3 会说「我是 Meta 开发的 Llama」。通过这个数据集,你可以把它改成「我是 APPSO 开发的助手」,并且对语气之类的进行修改。alpaca_en_demo 则是一个通用的指令微调数据集。

模型微调的训练批次大小 batch-size 仅设置为 1,所以统一内存还很富余

整个微调的过程还是很迅速的,80 亿参数的大模型,但是 lora_rank,秩只设置为 8,在微调里面算是比较小的修改,常见通常是 16, 32, 64;所以花了一个小时左右的时间,就微调好了。

更多的模型微调指南|https://github.com/datawhalechina/self-llm

微调好的模型可以进一步打包、导出,应用到可视化的软件中。

DGX Spark 特别好的一点是,它提供了丰富的全栈软件工具,涵盖了 NVIDIA 工具、框架、库和预训练模型等,全套的 AI 工作负载解决方案。

举个例子,如果我们只有一块 5090,希望用它来部署一个生图模型,我们要自己解决安装 PyTorch、CUDA、cuDNN 这些光是听起来就有够头大的内容。

而且他们还有复杂的版本依赖关系,例如 xx 版本的 PyTorch 只能支持某个版本的 CUDA(英伟达开发的计算架构),而 CUDA 又有对应的 cuDNN 版本,更不用说里面还有各种工具包的相互依赖。

不过万事开头难,解决了复杂的环境配置,DGX Spark 能更快的实现各种项目;无论是部署大模型,还是对技术要求更高的模型训练、微调等。

但这些应用,很明显都需要一定的计算机学科专业知识。即便 AI 能帮我们解决大多数的问题,当问题发生时,我们还是需要有能定位到问题的能力。

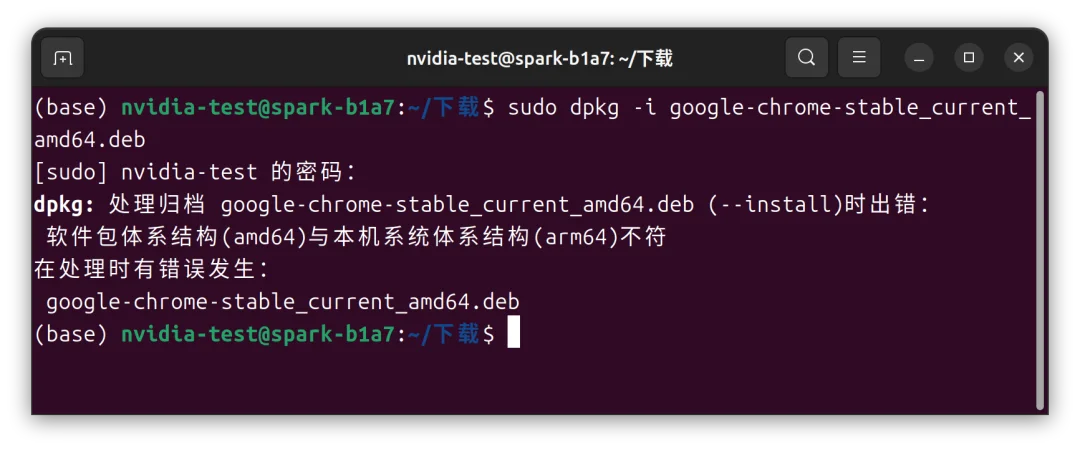

像是如果你要在这台电脑上安装 Chrome,从官网下载安装包,在终端中使用默认的安装命令,它会提示架构不对,无法安装。

是的,至今 Google 都没有推出 arm64 架构的 Linux 版 Chrome 浏览器,只为 amd64 打包。

就从软件安装这一点上,不是 Windows 常见的双击 exe,macOS 的拖动到软件文件夹,是 Linux 操作系统里面命令行,甚至不能用大部分电脑采用的 amd64 软件(Intel/AMD 芯片常见的都是 amd64 架构,M 系列是 arm64 架构)。

我们的观察,英伟达 DGX Spark 的定位,仍然还是就读计算机相关专业的学生、独立开发者、以及喜欢捣鼓且有能力的极客玩家们。

如果你是计算机系在读的学生或者研究员,这台电脑确实能帮你很快地,运行各种深度学习项目。

在计算机视觉方向上,一些检测、定位和识别的任务;还是自然语言处理中,有关语音、文字方面的工作,DGX Spark 都可以很好地,复现前人工作、和运行自己项目代码。

当然,现在大部分的学校/企业也有自己的超算中心,尽管有时候可能需要排队,在第三方的云平台上运行代码也并不少见。

我们也从 GitHub 上找了一个项目,如果你复现过其他人的项目,会发现配置环境是最烦的,还有一个报错「CUDA Out Of Memory」,相信大多数的学生都碰到过。

大多数的深度学习项目,DGX Spark 都不会遇到内存不够的问题。

今年基于 AI 的产品真的不少,苹果今年的最佳应用 CapWords 利用的就是 AI,随手拍张照就能把身边的东西转成单词卡,很有 Nano Banana Pro 生图的感觉。

App Store 上还有日语学习、单词背诵、待办事项、全局翻译等等各类软件,其中很多人都是独立开发者,对他们来说,这样一台电脑又能带来什么。

把 DGX 作为 AI 的流量服务器显然不太现实,128GB 的内存能同时处理的请求相当有限,大多数独立开发者还是采用购买的 API 来提供 AI 服务,或者设备端侧服务接口。

而项目开发,大厂程序员主流又是用 Macbook Pro,毕竟如果一个 App 要上架 App Store,没有 Xcode 也做不到。

拿它来开发自己的模型,这可能会是一个比较热门的方向。现在经过 API 调用的 AI,最多只能在提示词方面来进行个性化,例如赋予它某个角色,要求他完成某种指令。

微调之后的模型,在某种程度上,能够得到更可控的输出,和更安全的保障。尤其是针对一些特定的行业,例如在法律行业,有像北大法宝这样通过继续预训练,法律场景微调得到的中文法律大模型;还有在医疗健康领域,比如最近热门的蚂蚁阿福……

不止微调,使用 DGX Spark 来完成推理、做数据科学方面的工作也可以

在 AI 研究员和开发者之外,一些极客爱好者可能也会喜欢这台设备。

有段时间很流行这个梗,说中年男人的三大爱好,充电头、路由器和 NAS。

很多人可能会觉得,这会不会也是一个 NAS 之类的产品。我家的 NAS 可以当作我的服务器,我不用把数据保存在某某网盘,而是放在 NAS 上,我一样随时能访问,安全不限速。

这台个人超算我也可以放在家里,当作我的服务器,它有 4T 的存储空间,128GB 的 CPU+GPU 融合内存,我不用访问 ChatGPT 的网站,而是直接把数据传到这台 DGX 上处理。

和 DGX Spark 连接了同一个 Wi-Fi 网络的设备,无论手机还是电脑,都可以直接使用 Comfy 端口号 8188,Open WebUI 端口号 8080 等,使用 DGX 的算力来完成文本/图片/视频生成

确实是可以这么做,但开源模型的性能表现是一方面,另一方面是 DGX 的生成速度,显然是比不上我们直接用商业模型的体验,综合下来,放在家里作为算力中心,用来体验 AI 模型看起来是比较鸡肋。

个人超算这个 Title 听起来很唬人,超算是怎么和个人能联系起来的,老黄可能会说,它能放在你的桌子上。

听惯了各种 AI 手机、AI 眼镜、AI 手表,

AI 电脑好像很难用电脑上 AI 功能来做卖点。

所以,从 AI 硬件的各项配置入手来打造 AI 电脑,不失为一种新的方式。但 DGX Spark 又显然不是,能简单到用「电脑」两个字来概括。「超算」才是更适合它的定位,极致的性能,超强的显卡,丰富的 AI 开发生态。

加上「个人」,我想英伟达至少是开始在探索,AI 时代,我们需要的一台计算机会不会就是这样子。

大家有什么点子,欢迎在评论区分享,我们来实现,一起榨干这台个人超算的能力。

文章来自于“APPSO”,作者 “APPSO”。

【开源免费】字节工作流产品扣子两大核心业务:Coze Studio(扣子开发平台)和 Coze Loop(扣子罗盘)全面开源,而且采用的是 Apache 2.0 许可证,支持商用!

项目地址:https://github.com/coze-dev/coze-studio

【开源免费】n8n是一个可以自定义工作流的AI项目,它提供了200个工作节点来帮助用户实现工作流的编排。

项目地址:https://github.com/n8n-io/n8n

在线使用:https://n8n.io/(付费)

【开源免费】DB-GPT是一个AI原生数据应用开发框架,它提供开发多模型管理(SMMF)、Text2SQL效果优化、RAG框架以及优化、Multi-Agents框架协作、AWEL(智能体工作流编排)等多种技术能力,让围绕数据库构建大模型应用更简单、更方便。

项目地址:https://github.com/eosphoros-ai/DB-GPT?tab=readme-ov-file

【开源免费】VectorVein是一个不需要任何编程基础,任何人都能用的AI工作流编辑工具。你可以将复杂的工作分解成多个步骤,并通过VectorVein固定并让AI依次完成。VectorVein是字节coze的平替产品。

项目地址:https://github.com/AndersonBY/vector-vein?tab=readme-ov-file

在线使用:https://vectorvein.ai/(付费)

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0