AI 知识库对比:Dify 还是 FastGPT

AI 知识库对比:Dify 还是 FastGPT之前出了一些 Dify 的 基础教程,后台有小伙伴经常问三金:Dify 和 fastGPT 哪个好啊?我该用哪个呢? 为了帮小伙伴解开这个疑惑,今儿三金就先带大家分别看下这两个产品 在知识库上的异同点 。废话不多说,开整!

之前出了一些 Dify 的 基础教程,后台有小伙伴经常问三金:Dify 和 fastGPT 哪个好啊?我该用哪个呢? 为了帮小伙伴解开这个疑惑,今儿三金就先带大家分别看下这两个产品 在知识库上的异同点 。废话不多说,开整!

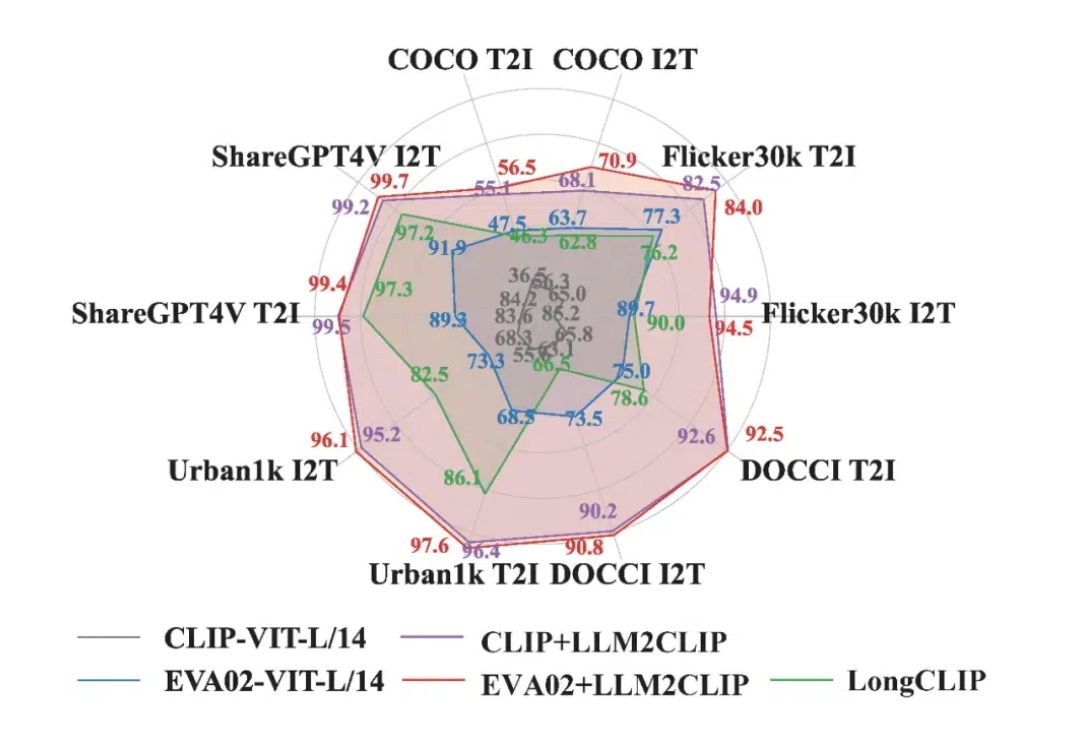

在当今多模态领域,CLIP 模型凭借其卓越的视觉与文本对齐能力,推动了视觉基础模型的发展。CLIP 通过对大规模图文对的对比学习,将视觉与语言信号嵌入到同一特征空间中,受到了广泛应用。

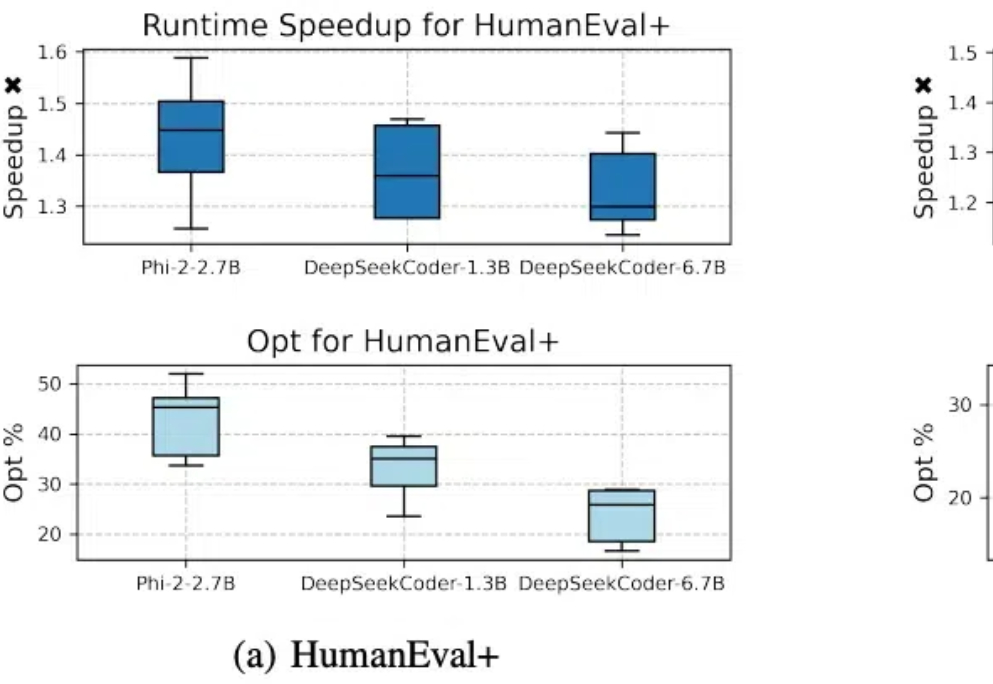

代码模型SFT对齐后,缺少进一步偏好学习的问题有解了。 北大李戈教授团队与字节合作,在模型训练过程中引入偏好学习,提出了一个全新的代码生成优化框架——CodeDPO。

只要改一行代码,就能让大模型训练效率提升至1.47倍。

这篇文章研究了提示格式对大型语言模型(LLM)性能的影响。

近期,微软研究团队发布了一项重要的研究成果,揭示了AI推理能力从传统的提示工程方法(如Medprompt)到原生推理机制(如OpenAI的o1)演进的全貌。此项研究为正在开发AI产品的朋友们提供了宝贵的技术洞察。本文将详细分析这一研究的过程和结论,探讨其对AI推理领域及产品开发的深远影响。

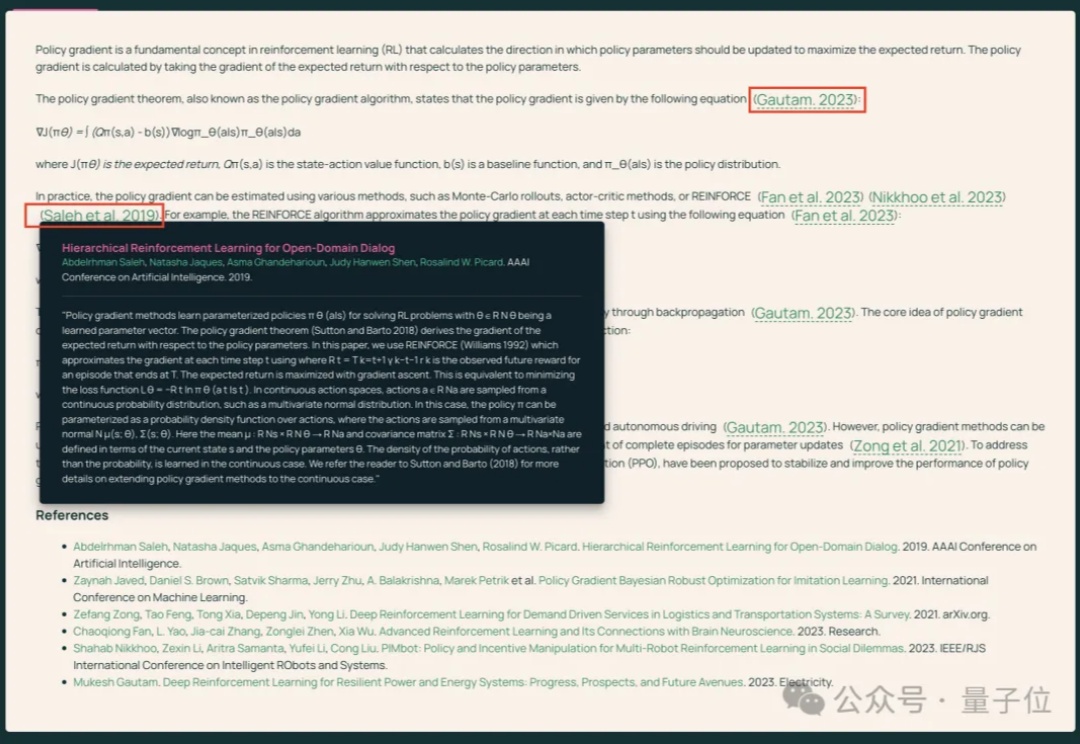

将知识图谱技术与RAG有机结合的GraphRAG可谓是今年下半年来的LLM应用领域的一个热点,借助大模型从非结构化文本数据创建知识图谱与摘要,并结合图与向量索引技术来提高对复杂用户查询的检索增强与响应质量。

Anthropic又发大礼包!现在Claude自己就是一台服务器。

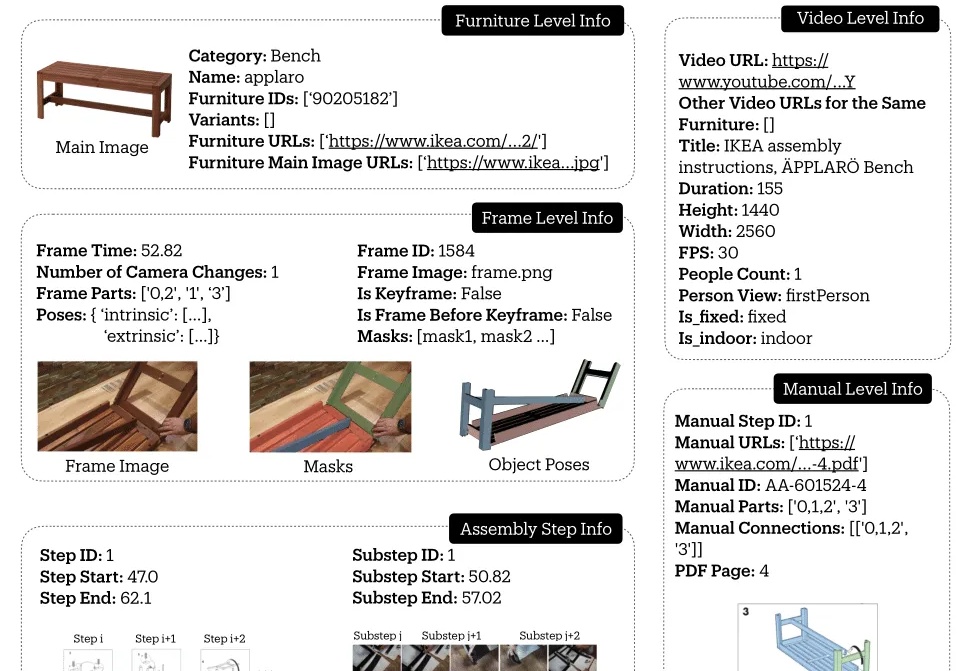

斯坦福吴佳俊团队,给机器人设计了一套组装宜家家具的视频教程!

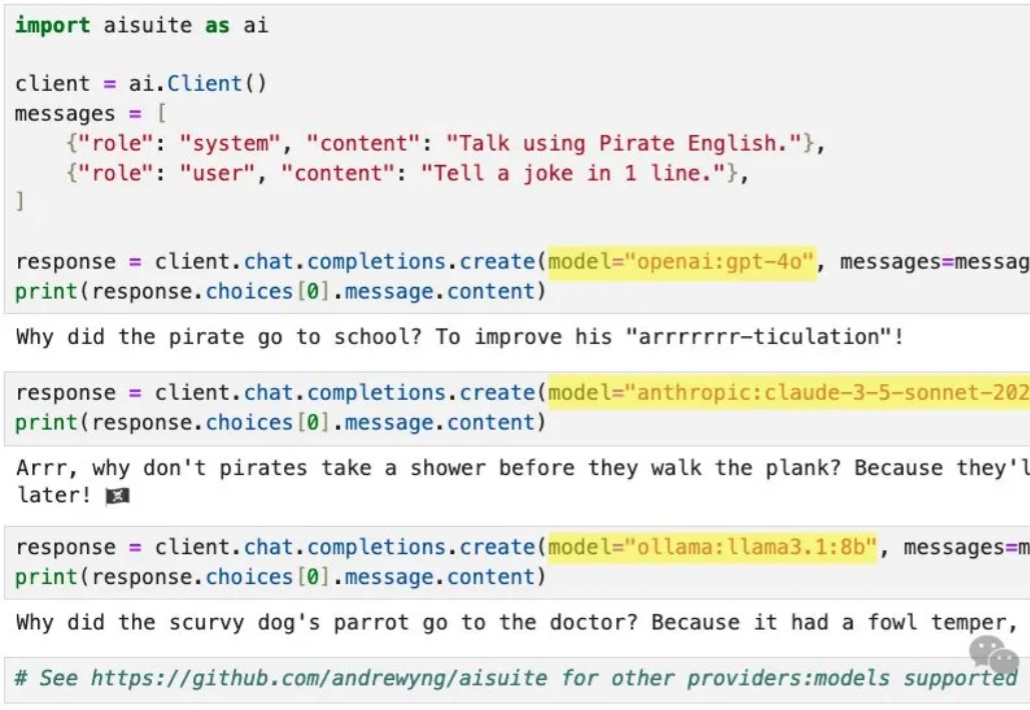

吴恩达发布的开源大模型套件aisuite,不到半天就斩获了1200+星标。

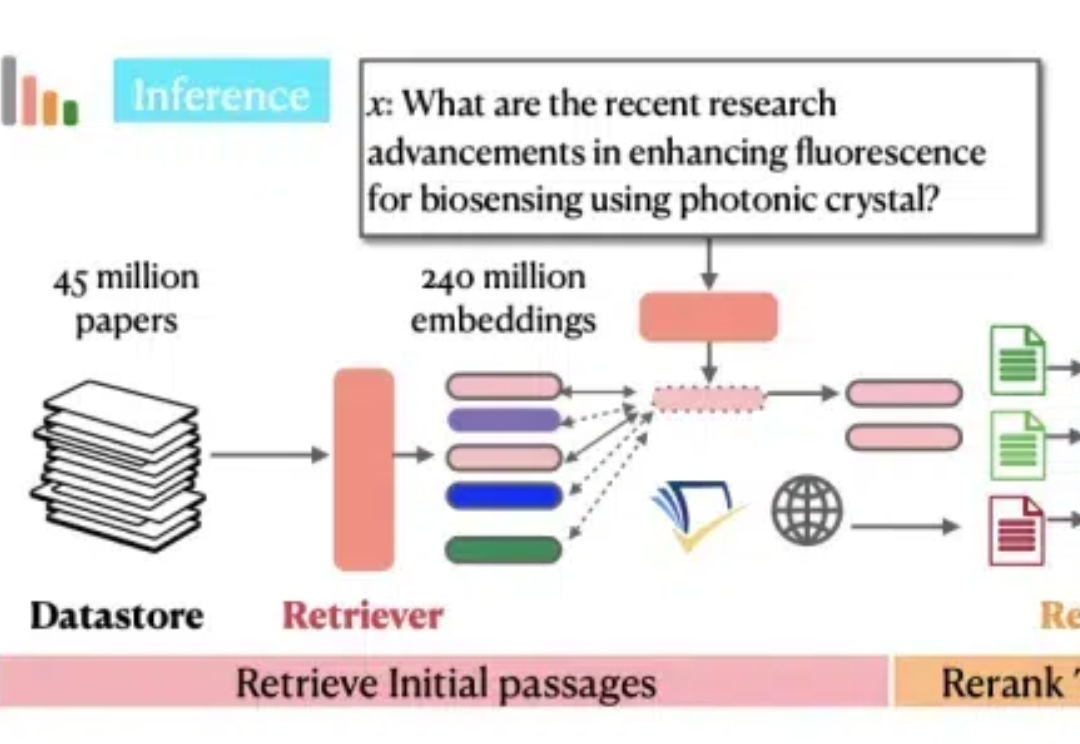

只需几秒钟,开源模型检索4500篇论文,比GPT-4o还靠谱!

Ai2和华盛顿大学联合Meta、CMU、斯坦福等机构发布了最新的OpenScholar系统,使用检索增强的方法帮助科学家进行文献搜索和文献综述工作,而且做到了数据、代码、模型权重的全方位开源。

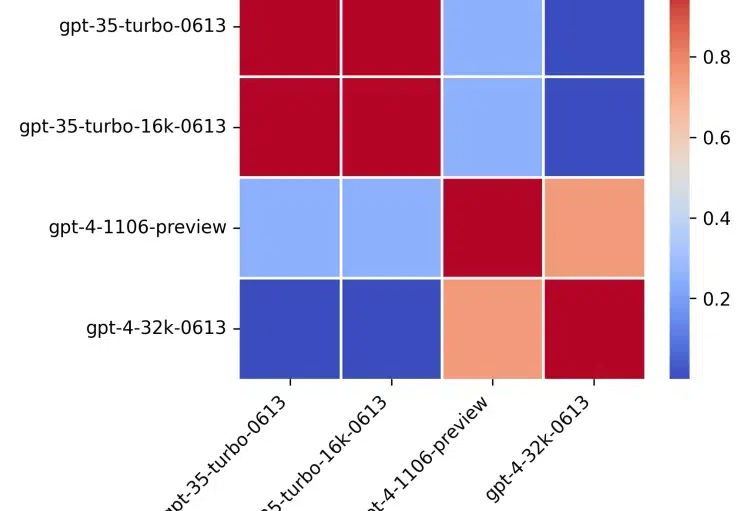

如果给LLM做MBTI,会得到什么结果?UC伯克利的最新研究就发现,不同模型真的有自己独特的性格

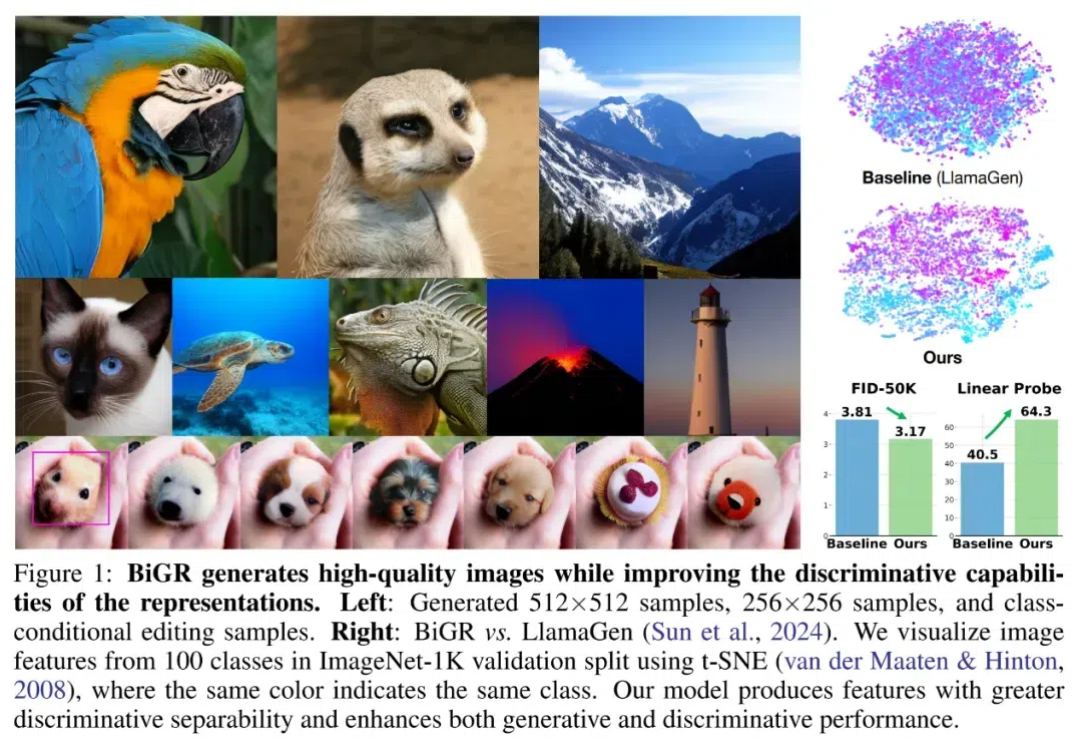

自回归方法,在图像生成中观察到了 Scaling Law。 「Scaling Law 撞墙了?」这恐怕是 AI 社区最近讨论热度最高的话题。

北京大学研究团队开发的FAN模型能有效捕捉数据中的周期性模式,相比传统模型在多项任务中表现出色,同时降低了参数量和计算量,增强了对周期性特征的建模能力,应用潜力广泛。

各位大佬,激动人心的时刻到啦!Anthropic 开源了一个革命性的新协议——MCP(模型上下文协议),有望彻底解决 LLM 应用连接数据难的痛点!它的目标是让前沿模型生成更好、更相关的响应。以后再也不用为每个数据源写定制的集成代码了,MCP 一个协议全搞定!

今天我们就来看看AI搜索赛道为什么能跑出估值超600亿的独角兽?

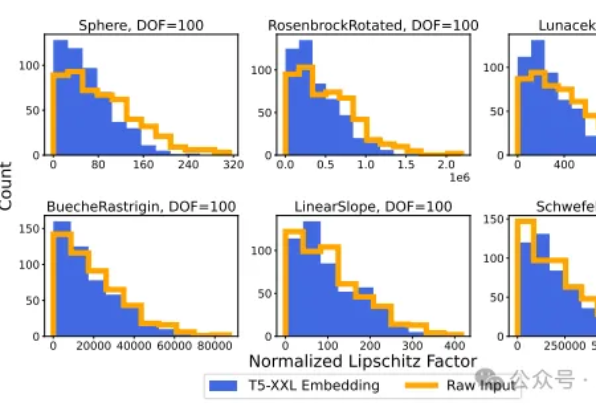

在人工智能领域,大语言模型(LLM)的向量嵌入能力一直被视为处理文本数据的利器。然而,斯坦福大学和Google DeepMind的研究团队带来了一个颠覆性发现:LLM的向量嵌入能力可以有效应用于回归任务。

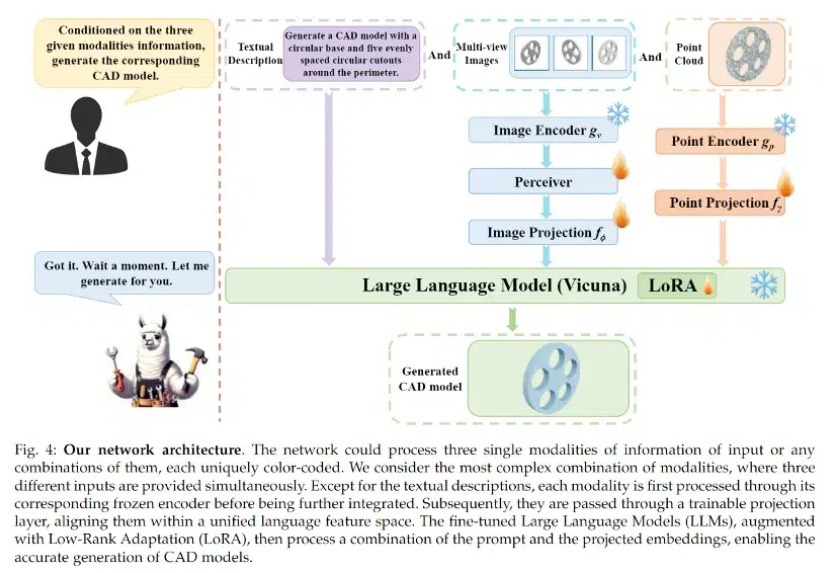

该项目由忆生科技联合香港大学、上海科技大学共同完成,是全球首个同时支持文本描述、图像、点云等多模态输入的计算机辅助设计(CAD)生成大模型。

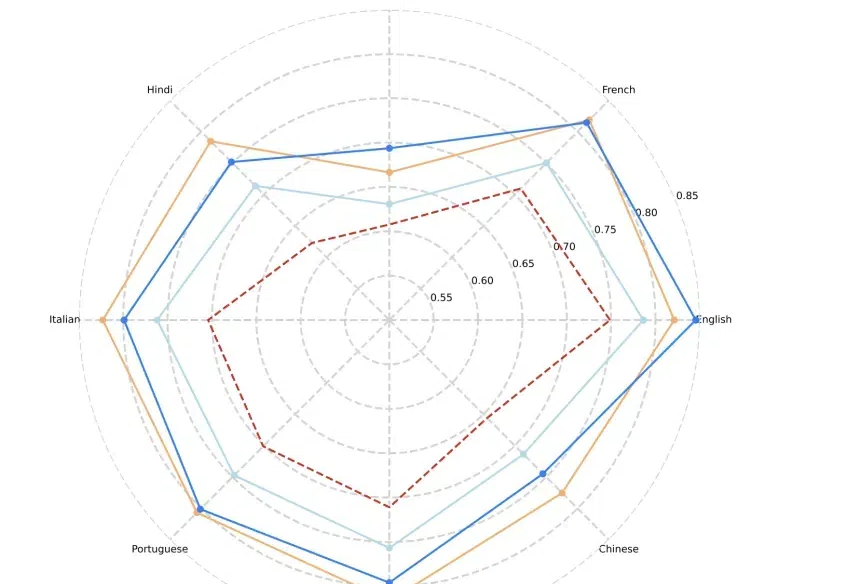

Meta全新发布的基准Multi-IF涵盖八种语言、4501个三轮对话任务,全面揭示了当前LLM在复杂多轮、多语言场景中的挑战。所有模型在多轮对话中表现显著衰减,表现最佳的o1-preview模型在三轮对话的准确率从87.7%下降到70.7%;在非拉丁文字语言上,所有模型的表现显著弱于英语。

Hugging Face 上的模型数量已经超过了 100 万。但是几乎每个模型都是孤立的,难以与其它模型沟通。尽管有些研究者甚至娱乐播主试过让 LLM 互相交流,但所用的方法大都比较简单。

奥特曼“熹妃回宫”已一周年,具体内情还是不清楚,咋办?

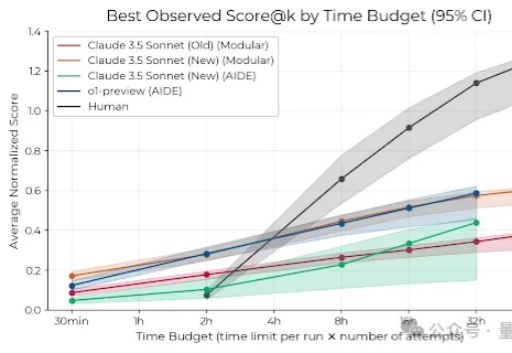

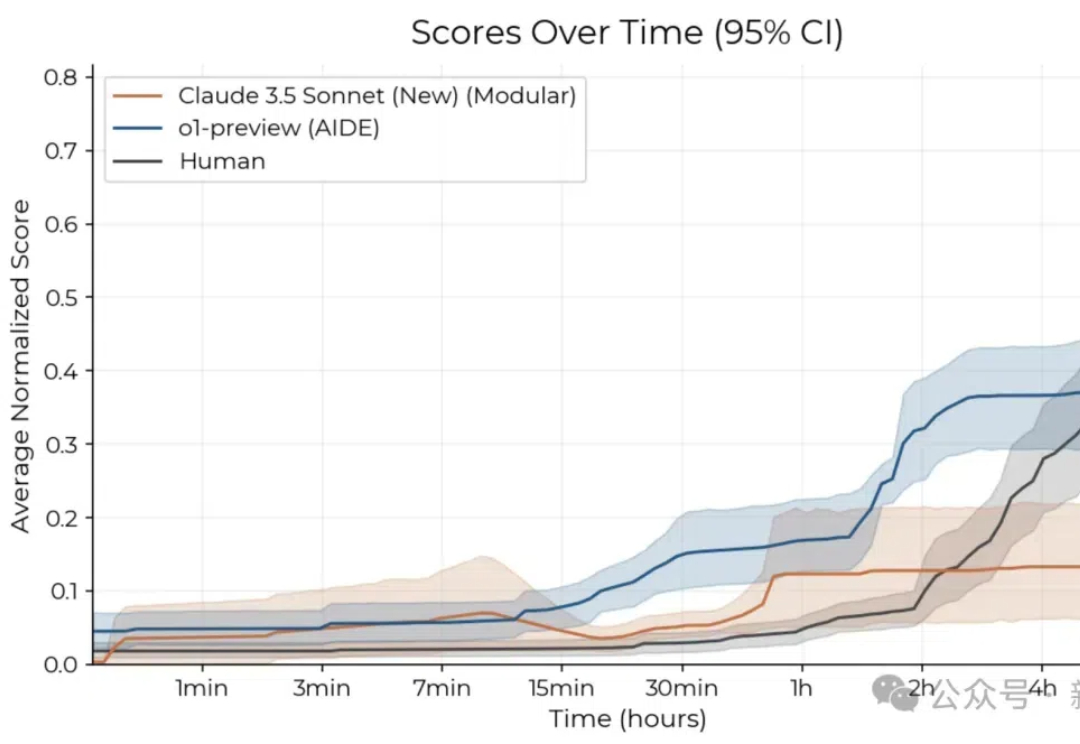

2小时内,Claude和o1就能超过人类专家平均科研水平。

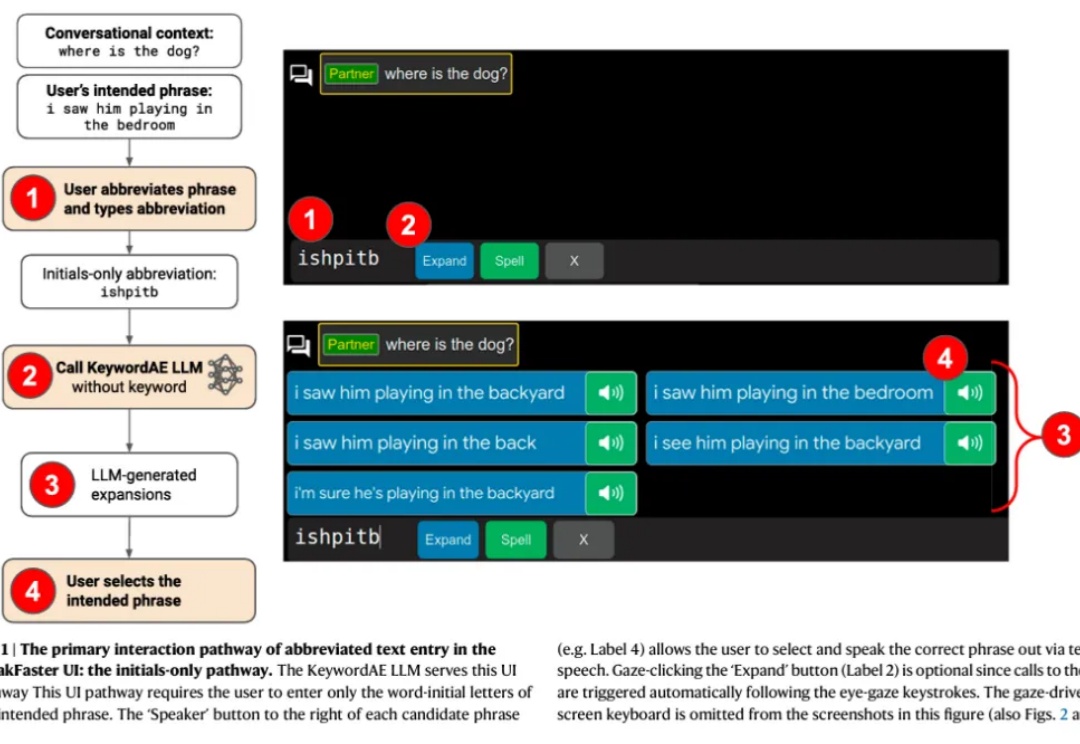

因渐冻症(ALS)等病症而无法言语或打字的人群不容忽视,他们在日常沟通交流中面临着巨大障碍,急需有效的辅助手段来打破沟通壁垒。

LangChain 最近调查了 1,300 多名专业人士——从工程师和产品经理到企业领导者和高管——以揭示 AI Agents 的现状。

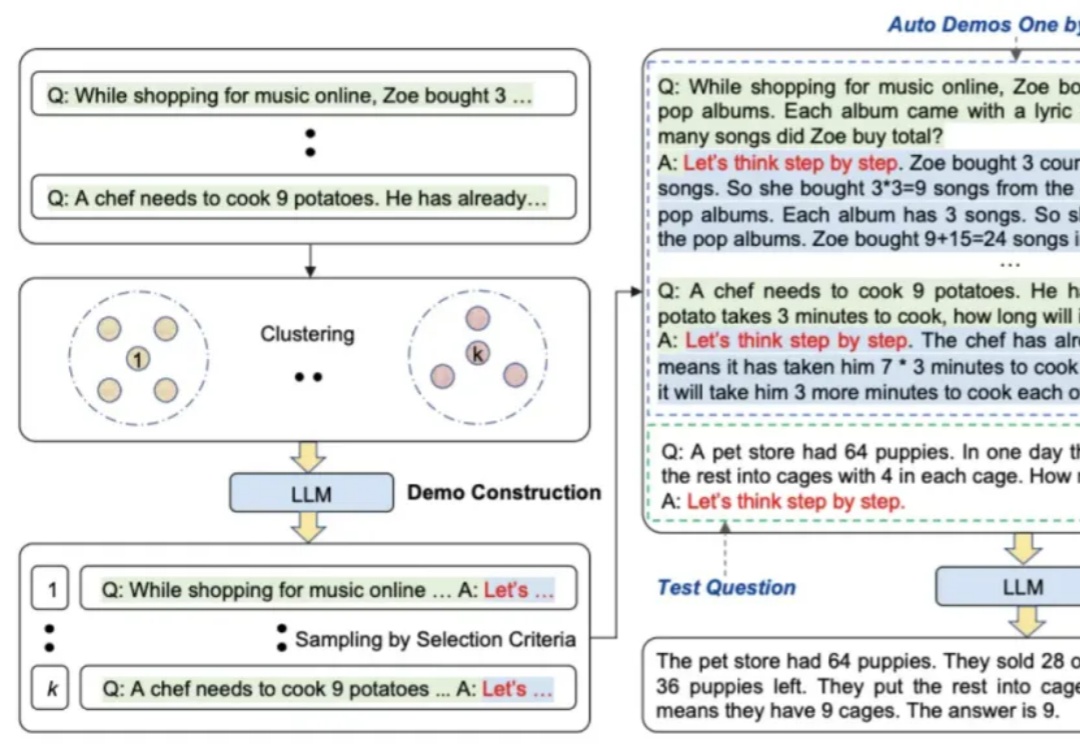

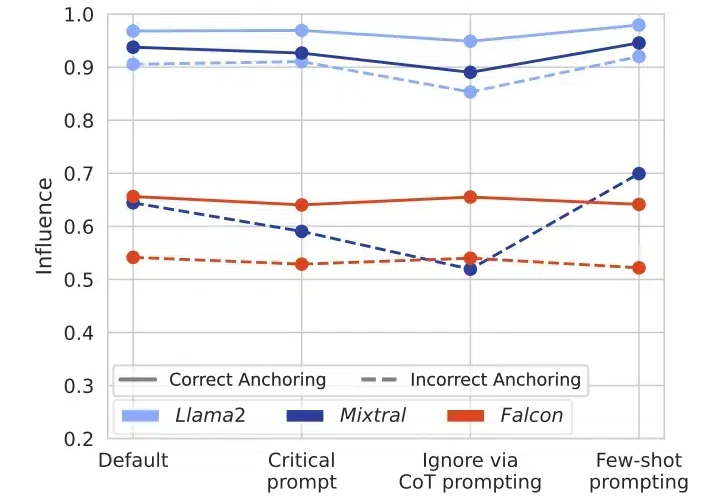

本文主要介绍prompt engineering的多种方法

在当今人工智能迅猛发展的时代,大语言模型(LLMs)已成为众多AI应用的核心引擎。然而,来自ETH Zurich和Google DeepMind的一项最新研究揭示了一个令人深思的现象:这些看似强大的模型存在着严重的“盲从效应”。

AI自主研发会真的「失控」了吗?最新研究显示,Claude 3.5 Sonnet和o1-preview在2小时内的研发任务中,击败了50多位人类专家。但另一个耐人寻味的现象是,给予更长时间周期后,人类专家在8小时任务中优势显现。

曾经每天都用谷歌学术的科学家们,正在转向新的AI工具。

Meta的视频版分割一切——Segment Anything Model 2(SAM 2),又火了一把。