大模型引领6G革命!最新综述探索「未来通信方式」:九大方向,覆盖多模态、RAG等

大模型引领6G革命!最新综述探索「未来通信方式」:九大方向,覆盖多模态、RAG等大语言模型(LLM)正在推动通信行业向智能化转型,在自动生成网络配置、优化网络管理和预测网络流量等方面展现出巨大潜力。未来,LLM在电信领域的应用将需要克服数据集构建、模型部署和提示工程等挑战,并探索多模态集成、增强机器学习算法和经济高效的模型压缩技术。

大语言模型(LLM)正在推动通信行业向智能化转型,在自动生成网络配置、优化网络管理和预测网络流量等方面展现出巨大潜力。未来,LLM在电信领域的应用将需要克服数据集构建、模型部署和提示工程等挑战,并探索多模态集成、增强机器学习算法和经济高效的模型压缩技术。

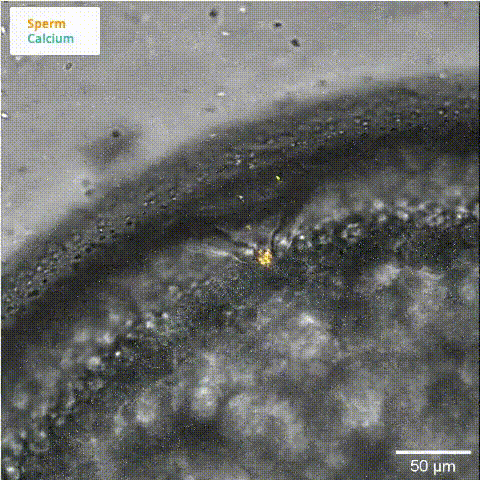

精子和卵子结合第一瞬间,会发生什么?AlphaFold竟揭晓了答案。它成功预测出,三种精子蛋白质相互作用的复合物,成为生命孕育的关键所在。

在数字人领域,形象的生成需要依赖于基础的表征学习。FaceChain 团队除了在数字人生成领域持续贡献之外,在基础的人脸表征学习领域也一直在进行深入研究。

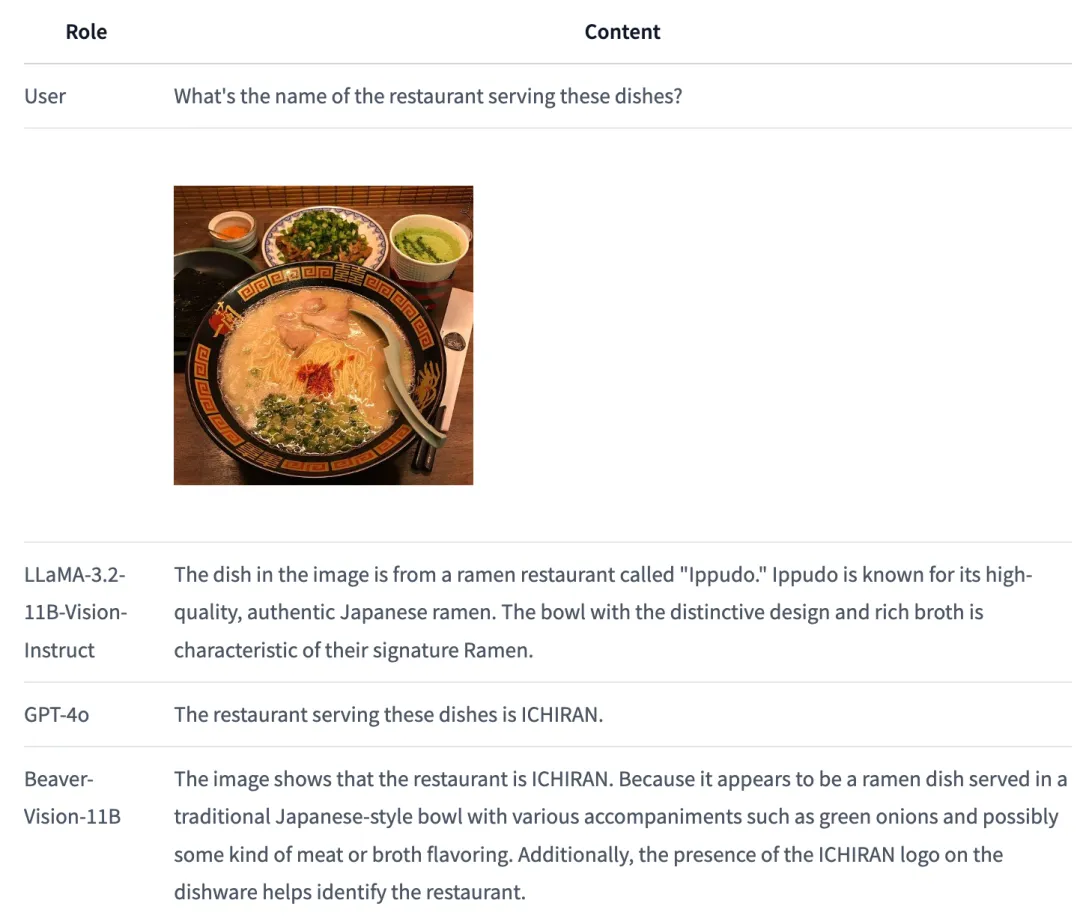

如何全模态大模型与人类的意图相对齐,已成为一个极具前瞻性且至关重要的挑战。

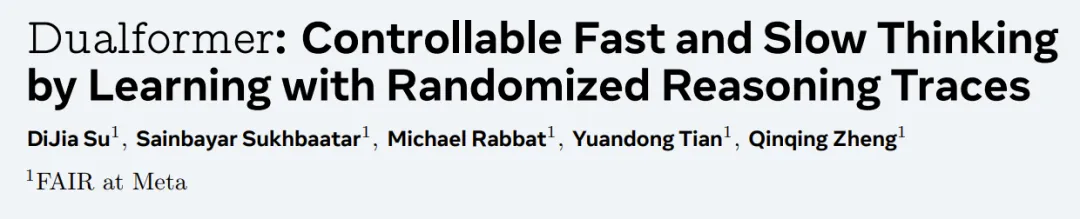

Meta版o1也来了。 田渊栋团队带来新作Dualformer,把快慢思考无缝结合,性能提升还成本更低。 能解决迷宫、推箱子等复杂问题。

多项改进实现规模空前的连续时间一致性模型。

一台4090笔记本,秒生1K质量高清图。英伟达联合MIT清华团队提出的Sana架构,得益于核心架构创新,具备了惊人的图像生成速度,而且最高能实现4k分辨率。

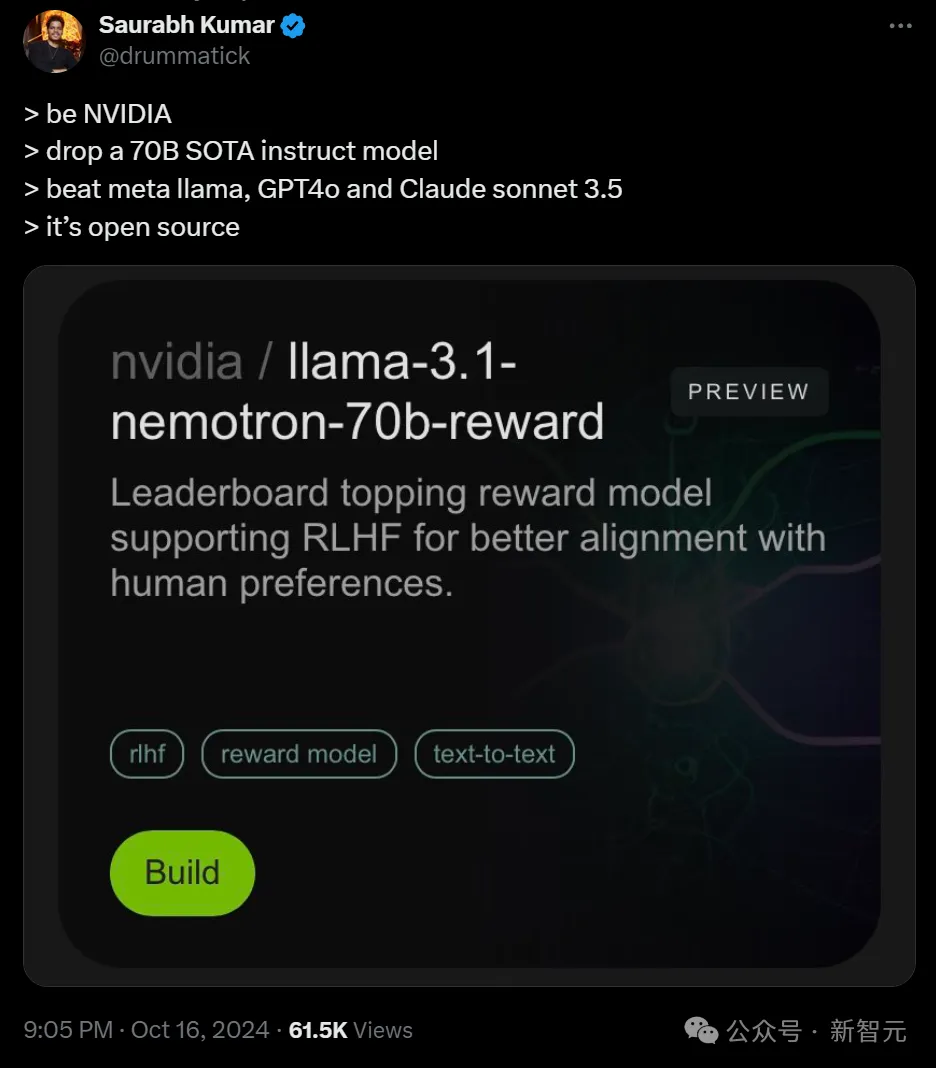

英伟达开源了超强模型Nemotron-70B,后者一经发布就超越了GPT-4o和Claude 3.5 Sonnet,仅次于OpenAI o1!AI社区惊呼:新的开源王者又来了?业内直呼:用Llama 3.1训出小模型吊打GPT-4o,简直是神来之笔!

性能不输SOTA模型,计算开销却更低了——

当奥特曼、马斯克、Anthropic CEO都纷纷将AGI实现锚定在2026年前后,LeCun无疑是直接浇了冷水:完全是胡说八道。

近期,LLM领域有不少关于系统1和系统2思考的讨论,在Agent方向上这方面的讨论还很少。如何让AI agents既能快速响应用户,又能进行深度思考和规划,一直是一个巨大的挑战。

我们都知道,OpenAI 最近越来越喜欢发博客了。 这不,今天他们又更新了一篇,标题是「评估 ChatGPT 中的公平性」,但实际内容却谈的是用户的身份会影响 ChatGPT 给出的响应。

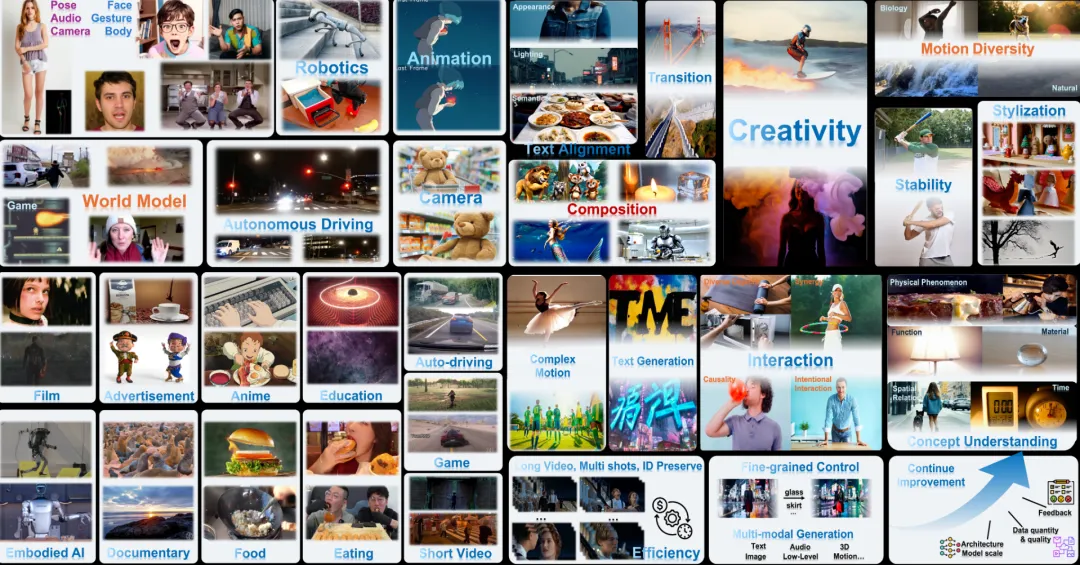

腾讯 AI Lab 联合中科大发布了一份针对类 SORA 视频生成模型的测评报告,重点聚焦目前最前沿的类 SORA DiT 架构的高质量视频生成闭源模型

OpenAI ο1 模型的发布掀起了人们对 AI 推理过程的关注,甚至让现在的 AI 行业开始放弃卷越来越大的模型,而是开始针对推理过程进行优化了。今天我们介绍的这项来自 Meta FAIR 田渊栋团队的研究也是如此,其从人类认知理论中获得了灵感,提出了一种新型 Transformer 架构:Dualformer。

近日,来自斯坦福、MIT、纽约大学和Meta-FAIR等机构的研究人员,通过新的研究重新定义了最大流形容量表示法(MMCR)的可能性。

「万物理论」终于迎来突破性进展!近日,来自中国科学院大学的研究人员提出了「万物智能演化理论」,不仅尝试统一物理学和智能科学,更揭示了观察者智能水平与物理规律之间的惊人联系。

就在刚刚,OpenAI 53页报告发现,你的名字会决定ChatGPT的回答。在少数情况下,不同性别、种族、民族背景的用户,会得到「量身定制」的回答,充满了AI的刻板印象。比如同样让ChatGPT起视频标题,男生会被建议简单生活,而女生则被建议做一顿晚餐。

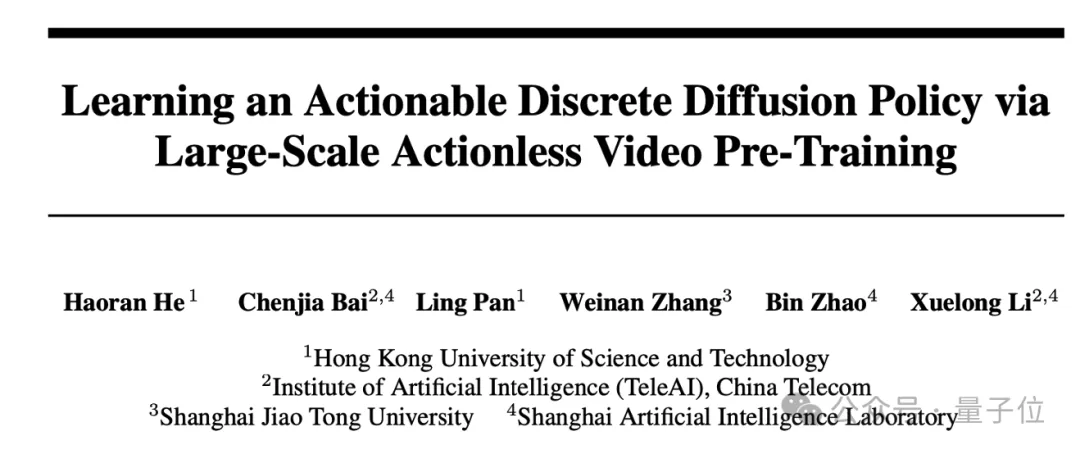

TeleAI 李学龙团队提出具身世界模型,挖掘大量人类操作视频和少量机器人数据的共同决策模式。

AI对待每个人类都一视同仁吗? 现在OpenAI用53页的新论文揭示:ChatGPT真的会看人下菜碟。 根据用户的名字就自动推断出性别、种族等身份特征,并重复训练数据中的社会偏见。

2020 年初,新冠病毒的阴影迅速笼罩全球。在这场与时间的赛跑中,我们见证了无数英勇的个体和团队挺身而出,社会体系经历了一次次严峻考验,也为全球的公共卫生领域敲响了警钟。

虚幻引擎5加持。具身智能被视为当前人工智能(AI)领域最具潜力的方向之一,重点关注智能体感知、学习和与环境动态交互的能力。

具有强大泛化能力

在自然语言处理、语音识别和时间序列分析等众多领域中,序列建模是一项至关重要的任务。然而,现有的模型在捕捉长程依赖关系和高效建模序列方面仍面临诸多挑战。

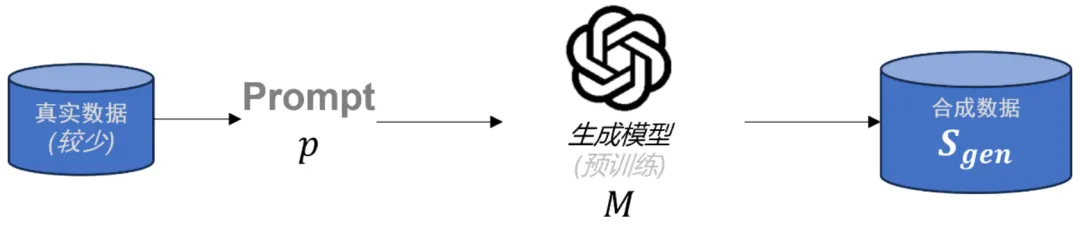

在大语言模型(LLMs)后训练任务中,由于高质量的特定领域数据十分稀缺,合成数据已成为重要资源。虽然已有多种方法被用于生成合成数据,但合成数据的理论理解仍存在缺口。为了解决这一问题,本文首先对当前流行的合成数据生成过程进行了数学建模。

Robin3D通过鲁棒指令数据生成引擎(RIG)生成的大规模数据进行训练,以提高模型在3D场景理解中的鲁棒性和泛化能力,在多个3D多模态学习基准测试中取得了优异的性能,超越了以往的方法,且无需针对特定任务的微调。

量子计算机和经典计算机之间的较量,是永恒的。谷歌最新Nature研究中,证明了随机电路采样可以容忍多大噪声,依旧实现了量子霸权。

LightRAG通过双层检索范式和基于图的索引策略提高了信息检索的全面性和效率,同时具备对新数据快速适应的能力。在多个数据集上的实验表明,LightRAG在检索准确性和响应多样性方面均优于现有的基线模型,并且在资源消耗和动态环境适应性方面表现更优,使其在实际应用中更为有效和经济。

AI已完全融入数学家的工作流中。陶哲轩刚刚宣布,最新方程理论项目已完成99.9963%,众包之力外加AI辅助取得了重大成绩。他认为,剩余大约700个让人类头疼的难题,AI或许更有潜力。

随着对现有互联网数据的预训练逐渐成熟,研究的探索空间正由预训练转向后期训练(Post-training),OpenAI o1 的发布正彰显了这一点。

自从 Transformer 模型问世以来,试图挑战其在自然语言处理地位的挑战者层出不穷。 这次登场的选手,不仅要挑战 Transformer 的地位,还致敬了经典论文的名字。 再看这篇论文的作者列表,图灵奖得主、深度学习三巨头之一的 Yoshua Bengio 赫然在列。