零成本突破多模态大模型瓶颈!多所美国顶尖高校华人团队,联合推出自增强技术CSR

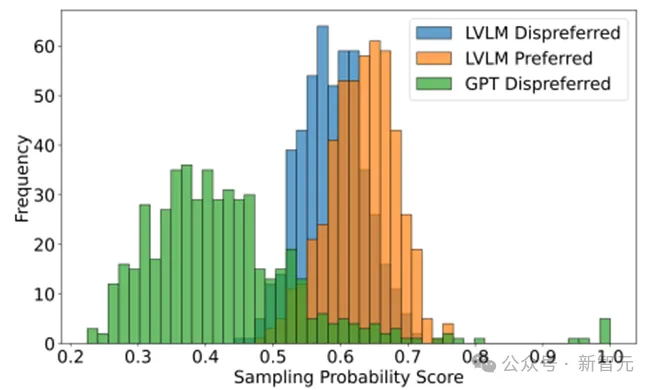

零成本突破多模态大模型瓶颈!多所美国顶尖高校华人团队,联合推出自增强技术CSR现有多模态大模型在对齐不同模态时面临幻觉和细粒度感知不足等问题,传统偏好学习方法依赖可能不适配的外源数据,存在成本和质量问题。Calibrated Self-Rewarding(CSR)框架通过自我增强学习,利用模型自身输出构造更可靠的偏好数据,结合视觉约束提高学习效率和准确性。

现有多模态大模型在对齐不同模态时面临幻觉和细粒度感知不足等问题,传统偏好学习方法依赖可能不适配的外源数据,存在成本和质量问题。Calibrated Self-Rewarding(CSR)框架通过自我增强学习,利用模型自身输出构造更可靠的偏好数据,结合视觉约束提高学习效率和准确性。

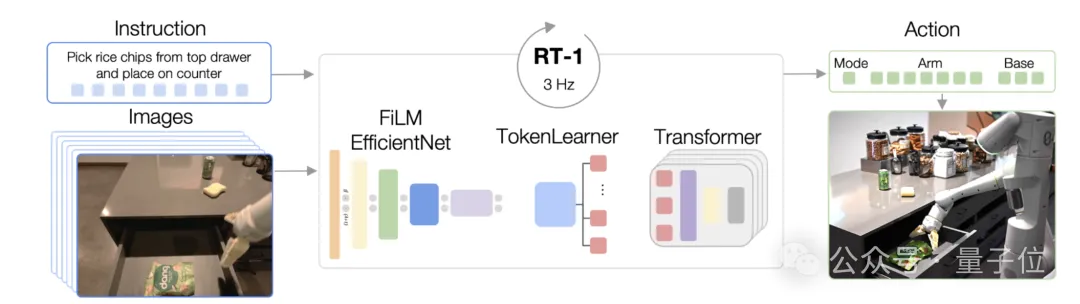

机器人操纵的一个基本目标是使模型能够理解视觉场景并执行动作。

今天, OpenAI劲敌Anthropic忽然丢炸弹,发布下一代旗舰大模型Claude 3.5 Sonnet。

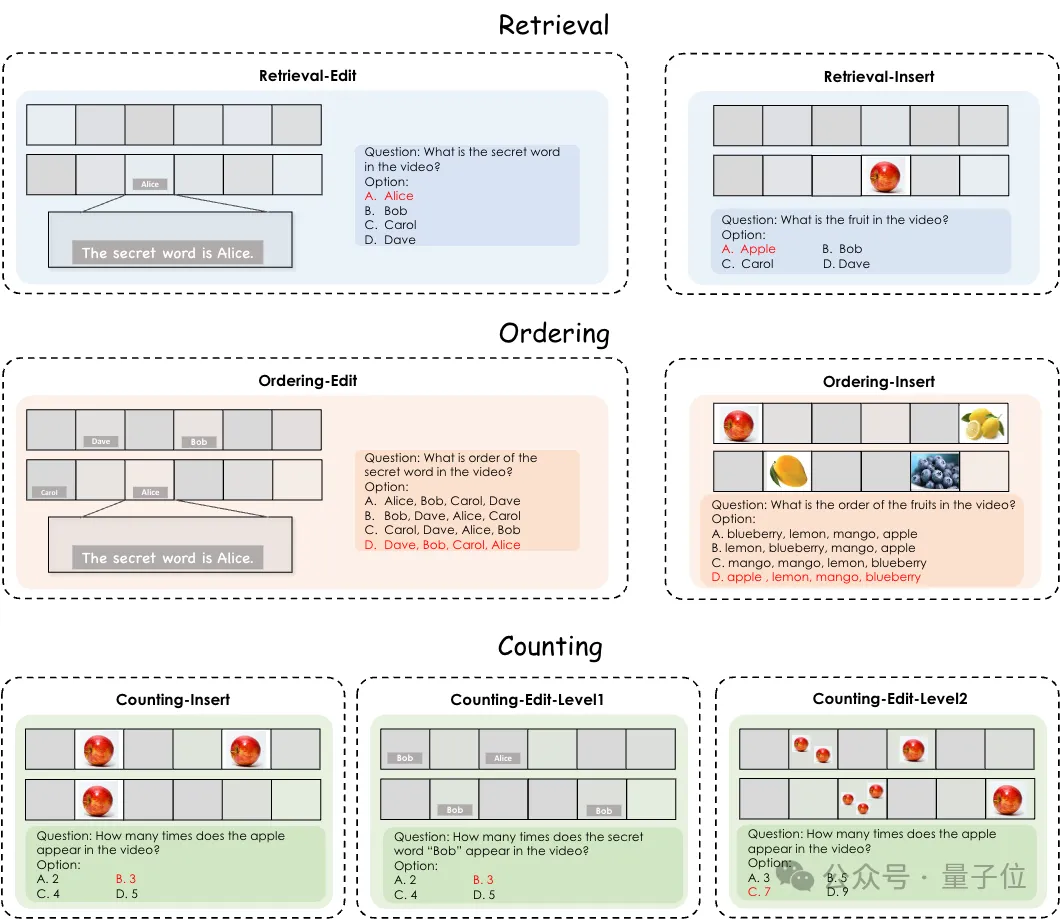

测试Gemini1.5 Pro、GPT-4o等多模态大模型的新基准来了,针对视频理解能力的那种。

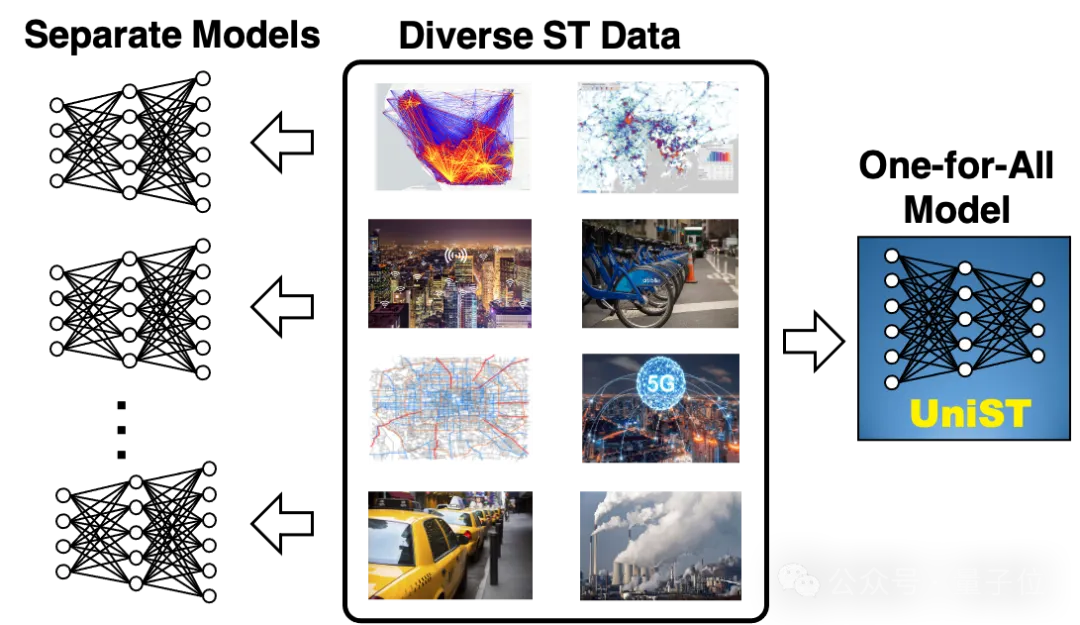

城市时空的预测,迎来GPT时刻。 清华大学电子系城市科学与计算研究中心推出了第一个无需自然语言的纯时空通用模型——UniST,首次展示了纯时空模型本身的通用性和可扩展性,研究成果已被KDD2024接收。

拯救4bit扩散模型精度,仅需时间特征维护——以超低精度量化技术重塑图像内容生成!

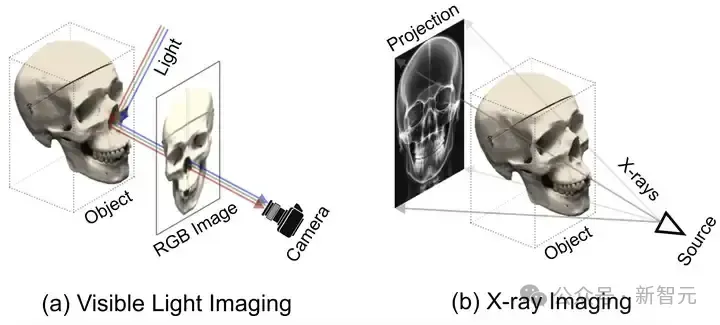

SAX-NeRF框架,一种专为稀疏视角下X光三维重建设计的新型NeRF方法,通过Lineformer Transformer和MLG采样策略显著提升了新视角合成和CT重建的性能。研究者还建立了X3D数据集,并开源了代码和预训练模型,为X光三维重建领域的研究提供了宝贵的资源和工具。

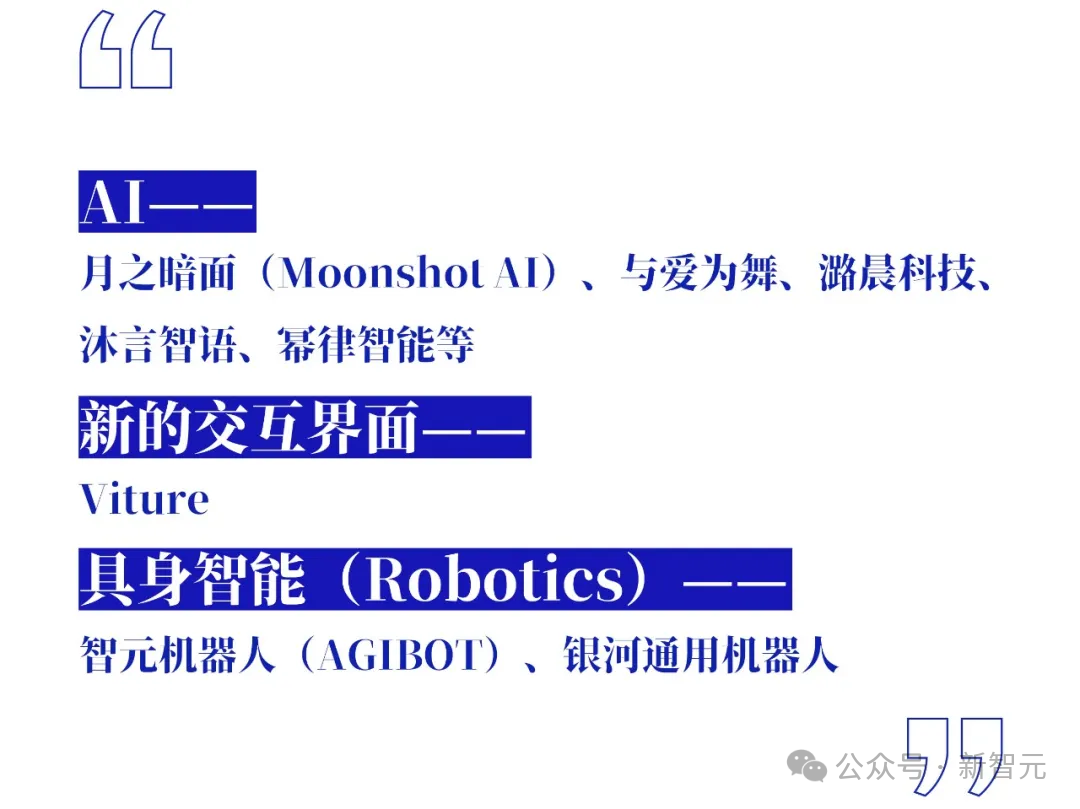

深耕科技的早期投资机构蓝驰创投近期将AGI投资观迭代至2.0版本。一些比较亮眼的观点有:未来,软件公司或将消失,GenAI将催生出一大波一人十亿美金初创公司。而且,开源模型的优势也将慢慢褪去,模型应用需要两手抓,还有......

本周,CVPR 2024正在美国西雅图拉开序幕。今年CVPR论文投稿数再次创下新纪录,可想而知本届会议的火热。

苹果OpenAI官宣合作,GPT-4o加持Siri,让AI个性化生成赛道热度飙升。

CVPR正在进行中,中国科研力量再次成为场内外焦点之一。

AI圈这遍地开花的大好局面,让吃瓜群众们甚是惊喜。

潞晨 Open-Sora 团队在 720p 高清文生视频质量和生成时长上实现了突破性进展,支持无缝产出任意风格的高质量短片,令人惊喜的是,他们选择再给开源社区带来亿点点震撼,继续全部开源。

基于 Transformer架构的大型语言模型在各种基准测试中展现出优异性能,但数百亿、千亿乃至万亿量级的参数规模会带来高昂的服务成本。例如GPT-3有1750亿参数,采用FP16存储,模型大小约为350GB,而即使是英伟达最新的B200 GPU 内存也只有192GB ,更不用说其他GPU和边缘设备。

通过高保真合成语音与真人语音无异。

本⽂介绍由清华等⾼校联合推出的⾸个开源的⼤模型⽔印⼯具包 MarkLLM。MarkLLM 提供了统⼀的⼤模型⽔印算法实现框架、直观的⽔印算法机制可视化⽅案以及系统性的评估模块,旨在⽀持研究⼈员⽅便地实验、理解和评估最新的⽔印技术进展。通过 MarkLLM,作者期望在给研究者提供便利的同时加深公众对⼤模型⽔印技术的认知,推动该领域的共识形成,进⽽促进相关研究的发展和推⼴应⽤。

本研究评估了先进多模态基础模型在 10 个数据集上的多样本上下文学习,揭示了持续的性能提升。批量查询显著降低了每个示例的延迟和推理成本而不牺牲性能。这些发现表明:利用大量演示示例可以快速适应新任务和新领域,而无需传统的微调。

在现实世界的机器学习应用中,随时间变化的分布偏移是常见的问题。这种情况被构建为时变域泛化(EDG),目标是通过学习跨领域的潜在演变模式,并利用这些模式,使模型能够在时间变化系统中对未见目标域进行良好的泛化。然而,由于 EDG 数据集中时间戳的数量有限,现有方法在捕获演变动态和避免对稀疏时间戳的过拟合方面遇到了挑战,这限制了它们对新任务的泛化和适应性。

OpenAI和谷歌接连两场发布会,把AI视频推理卷到新高度。 但业界还缺少可以全面评估大模型视频推理能力的基准。 终于,多模态大模型视频分析综合评估基准Video-MME,全面评估多模态大模型的综合视频理解能力,填补了这一领域的空白。

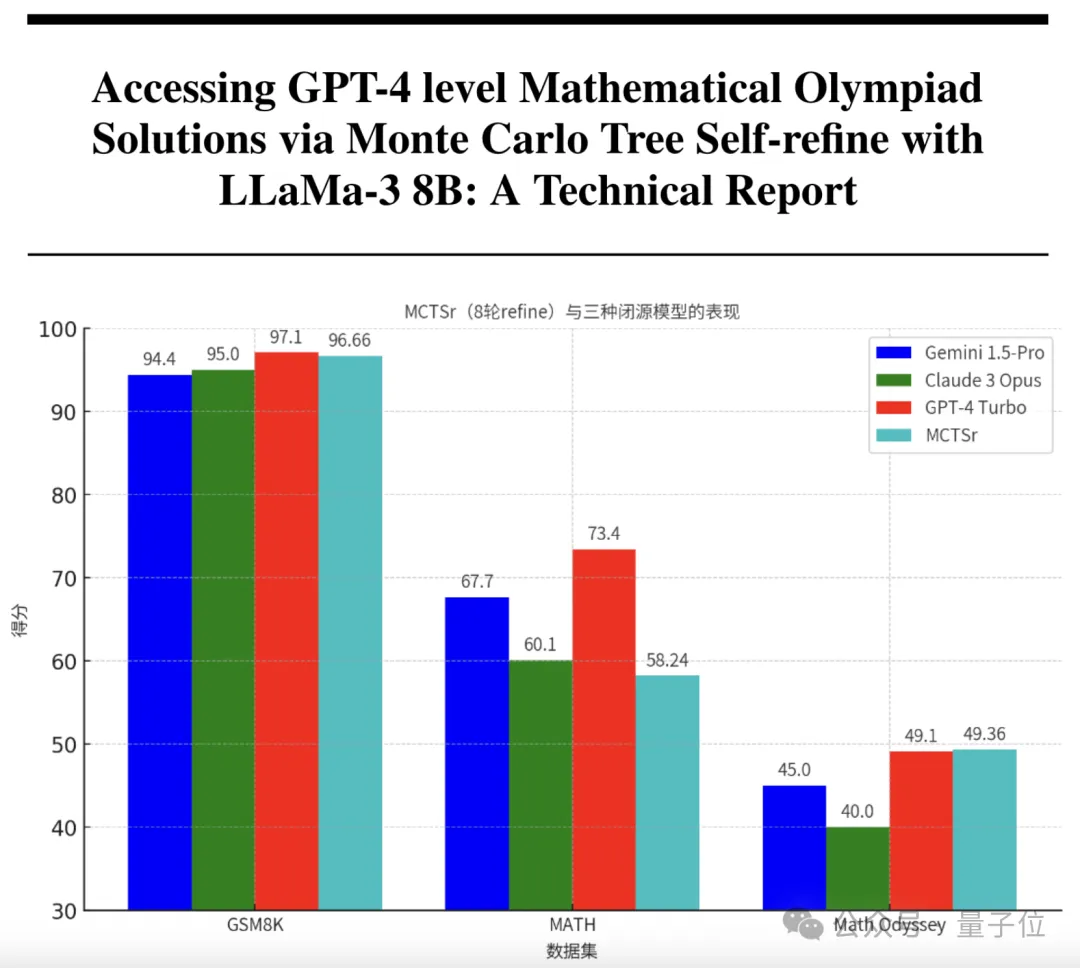

只要1/200的参数,就能让大模型拥有和GPT-4一样的数学能力? 来自复旦和上海AI实验室的研究团队,刚刚研发出了具有超强数学能力的模型。 它以Llama 3为基础,参数量只有8B,却在奥赛级别的题目上取得了比肩GPT-4的准确率。

一张人像、一段音频参考,就能让霉霉在你面前唱碧昂丝的《Halo》。

Build大会召开两周之后,微软更新了Phi-3系列模型的技术报告。不仅加入最新的基准测试结果,而且对小模型、高性能的实现机制做出了适当的揭示。

雷·库兹韦尔即将出版《奇点临近》的全新续作——《奇点更近》。在书中,他更加大胆地承诺,人类可以获得「永生」,库兹韦尔认为在本世纪40-50年代,人类将重建自己的身体和大脑,使其远远超出我们生物体的能力。

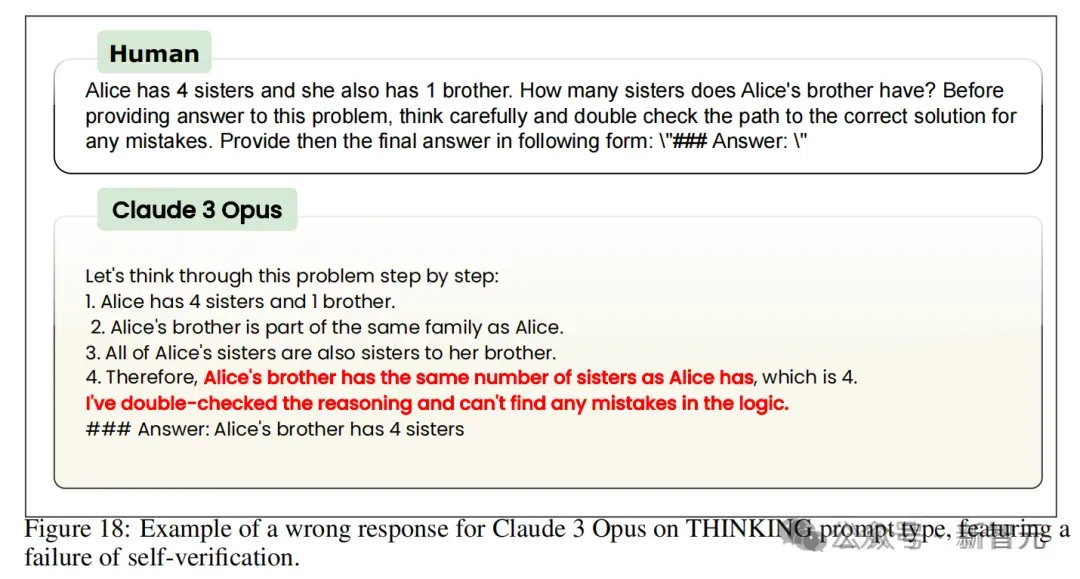

大语言模型提示中,竟有不少「怪癖」:重复某些内容,准确性就大大提高;人名变匿名,准确性就大大下降。最近,马里兰OpenAI等机构的30多位研究者,首次对LLM的提示技术进行了大规模系统研究,并发布75页详尽报告。

DeepMind最近发表的一篇论文提出用混合架构的方法解决Transformer模型的推理缺陷。将Transformer的NLU技能与基于GNN的神经算法推理器(NAR)的强大算法推理能力相结合,可以实现更加泛化、稳健、准确的LLM推理。

大语言模型(LLM)的迅速发展,引发了关于如何评估其公平性和可靠性的热议。

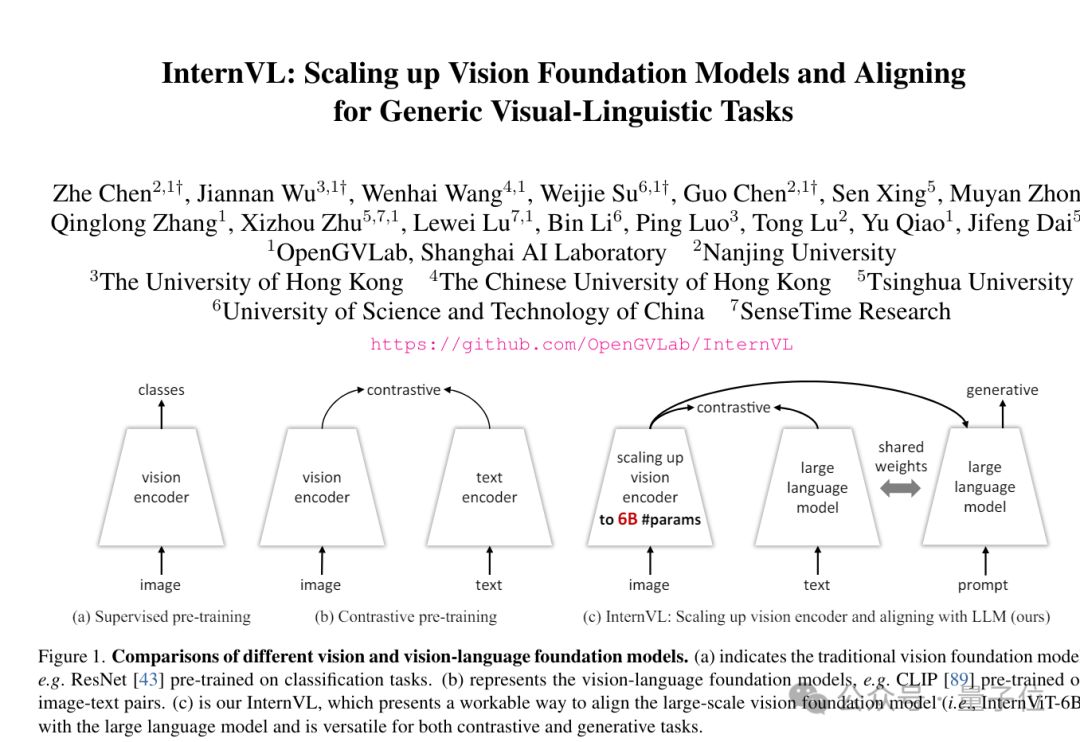

当前主流的视觉语言模型(VLM)主要基于大语言模型(LLM)进一步微调。因此需要通过各种方式将图像映射到 LLM 的嵌入空间,然后使用自回归方式根据图像 token 预测答案。

通过算法层面的创新,未来大语言模型做数学题的水平会不断地提高。

AI 研究发展的主要推动力是什么?在最近的一次演讲中,OpenAI 研究科学家 Hyung Won Chung 给出了自己的答案。

过去一年人工智能研究取得了重大突破