Llama 2打败GPT-4!Meta让大模型自我奖励自迭代,再证合成数据是LLM终局

Llama 2打败GPT-4!Meta让大模型自我奖励自迭代,再证合成数据是LLM终局AI训AI必将成为一大趋势。Meta和NYU团队提出让大模型「自我奖励」的方法,让Llama2一举击败GPT-4 0613、Claude 2、Gemini Pro领先模型。

AI训AI必将成为一大趋势。Meta和NYU团队提出让大模型「自我奖励」的方法,让Llama2一举击败GPT-4 0613、Claude 2、Gemini Pro领先模型。

IPA 已经成了现代智能手机不可或缺的标配,近期的一篇综述论文更是认为「个人 LLM 智能体会成为 AI 时代个人计算的主要软件范式」。

AI 视频生成,是最近最热门的领域之一。各个高校实验室、互联网巨头 AI Lab、创业公司纷纷加入了 AI 视频生成的赛道。Pika、Gen-2、Show-1、VideoCrafter、ModelScope、SEINE、LaVie、VideoLDM 等视频生成模型的发布,更是让人眼前一亮。

自 ChatGPT 等大型语言模型推出以来,为了提升模型效果,各种指令微调方法陆续被提出。本文中,普林斯顿博士生、陈丹琦学生高天宇汇总了指令微调领域的进展,包括数据、算法和评估等。

Stable Diffusion要王者归来了?

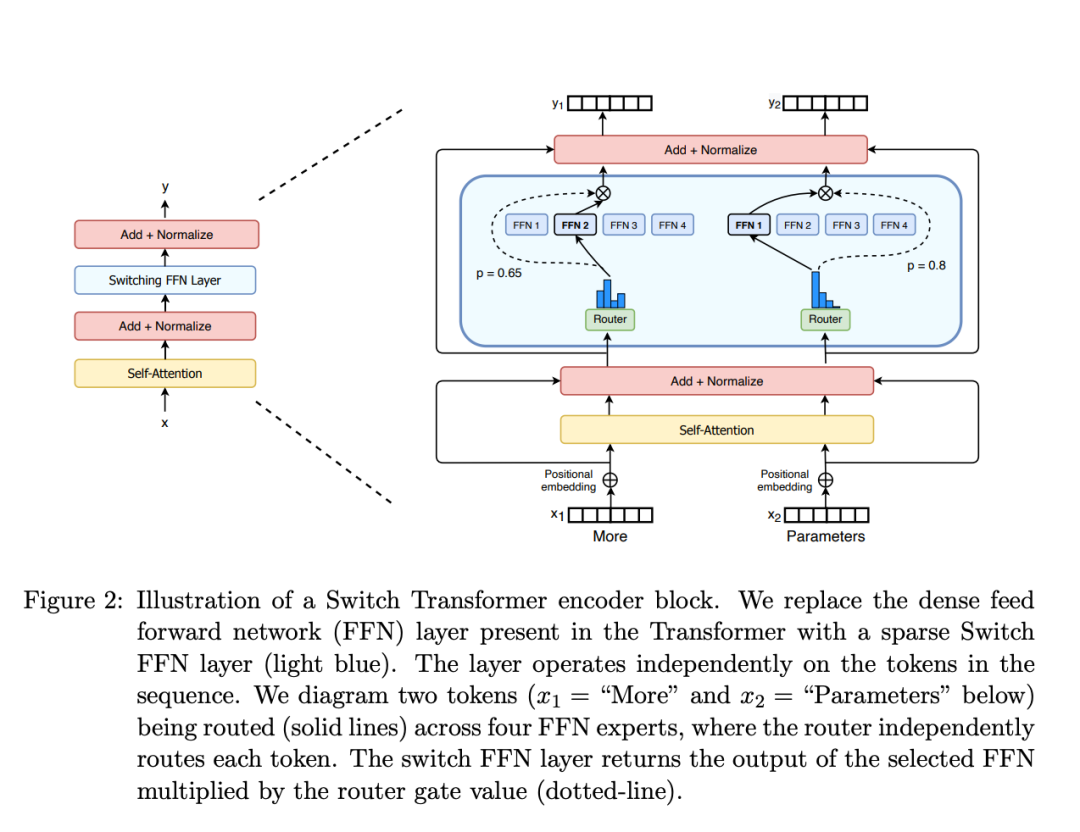

本文将介绍 MoE 的构建模块、训练方法以及在使用它们进行推理时需要考虑的权衡因素。

主题驱动的文本到图像生成,通常需要在多张包含该主题(如人物、风格)的数据集上进行训练,这类方法中的代表工作包括 DreamBooth、Textual Inversion、LoRAs 等,但这类方案因为需要更新整个网络或较长时间的定制化训练,往往无法很有效地兼容社区已有的模型,并无法在真实场景中快速且低成本应用。

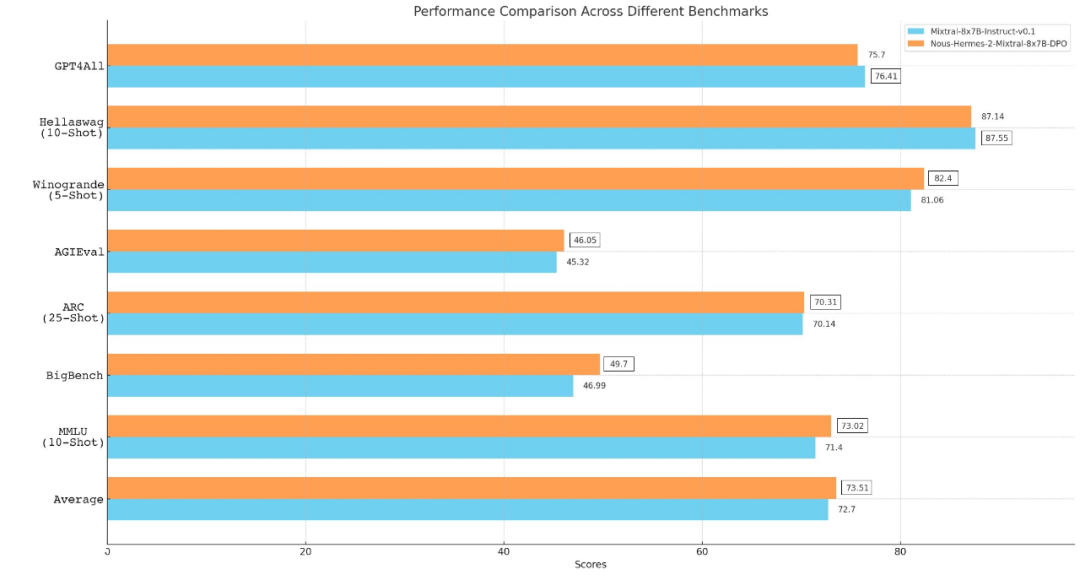

Mixtral 8x7B模型开源后,AI社区再次迎来一大波微调实践。来自Nous Research应用研究小组团队微调出新一代大模型Nous-Hermes 2 Mixtral 8x7B,在主流基准测试中击败了Mixtral Instruct。

今天,小扎正式宣战「开源AGI」!下一代大模型Llama 3正在训练,年底将拥有35万块H100,届时算力总和达60万块H100。为了追赶OpenAI,成立十年的FAIR团队纳入GenAI,全力奔赴AGI。

大模型出现后,AI 实现全能个人助理的梦想似乎近在眼前,也有不少公司推出了相应的硬件/软件,比如此前我们介绍的 AI Pin 以及 Rewind。

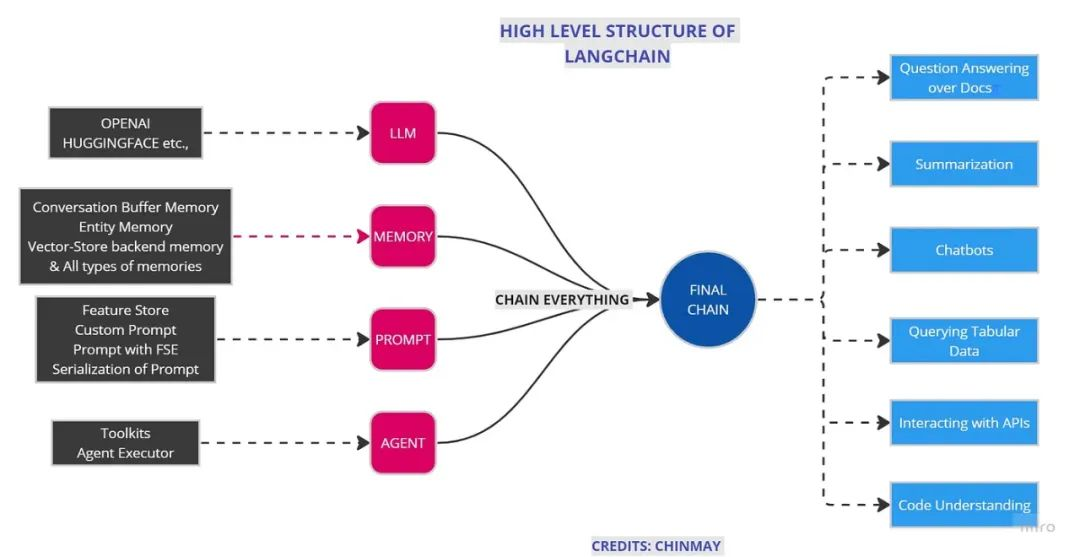

现在,为了实现相同的目标,我们有两个最著名的库,即 Haystack 和 LangChain,它们可以帮助我们创建基于大语言模型的端到端应用程序或流程。

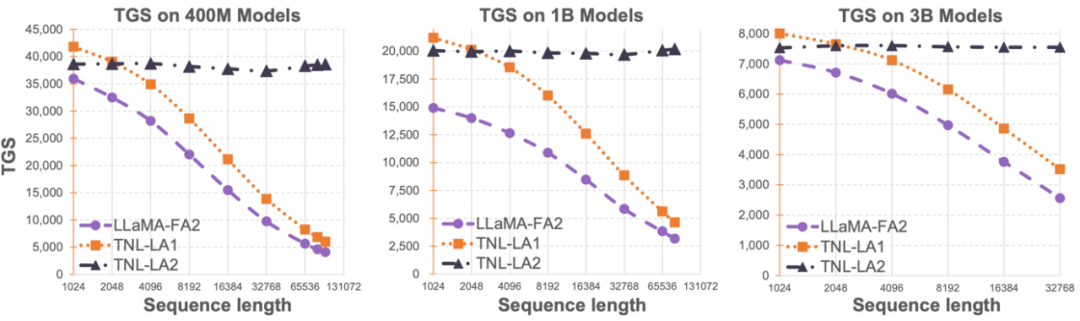

Lightning Attention-2 是一种新型的线性注意力机制,让长序列的训练和推理成本与 1K 序列长度的一致。

对模型参数量的迷信、执念也许可以放下了,混合多个小模型也是未来构造对话型 AI 的一个光明的方向。

视觉模型,同样遵循「参数越多性能越强」的规律?刚刚,一项来自苹果公司的研究验证了这个猜想。

还在苦苦寻找开源的机器人大模型?试试RoboFlamingo!

Open Interpreter 允许LLM在您的计算机上运行代码来完成任务。这可能是人类使用电脑的新方式,一句人话,电脑开始帮人类完成任务。

TaskWeaver 能够将用户的自然语言请求巧妙地转化为可执行代码,并支持丰富的数据结构、动态插件选择以及专业领域适应的规划过程。

从 Llama、Llama 2 到 Mixtral 8x7B,开源模型的性能记录一直在被刷新。由于 Mistral 8x7B 在大多数基准测试中都优于 Llama 2 70B 和 GPT-3.5,因此它也被认为是一种「非常接近 GPT-4」的开源选项。

SPF算法是一种基于状态序列频域预测的表征学习方法,利用状态序列的频域分布来显式提取状态序列数据中的趋势性和规律性信息,从而辅助表征高效地提取到长期未来信息。

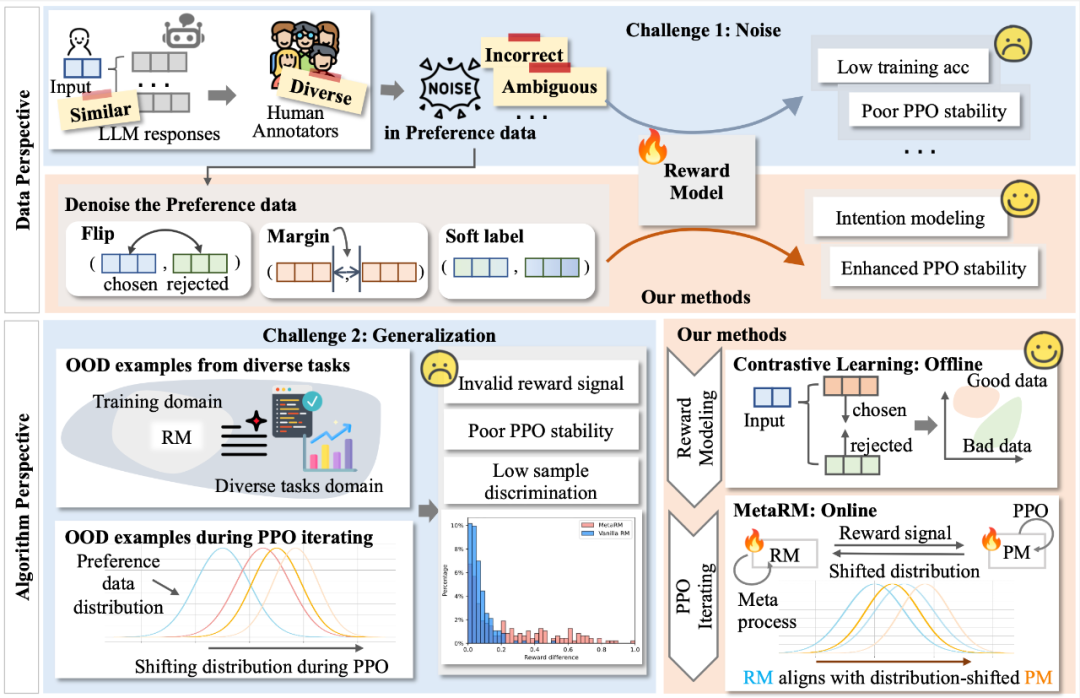

复旦团队进一步挖掘 RLHF 的潜力,重点关注奖励模型(Reward Model)在面对实际应用挑战时的表现和优化途径。

在自然语言处理(Natural Language Processing,NLP)领域,Transformer 模型因其在序列建模中的卓越性能而受到广泛关注。

刚刚,Quora CEO Adam D'Angelo 宣布 Quora 从 a16Z 获得 7500 万美元!Angelo 指出,他们希望通过这些目标来加速 AI 的主流应用,并为社会带来包括提高知识获取能力、民主化创意表达和加速经济增长在内的多种好处,这笔投资专门用于推动其 AI 聊天平台 Poe 的增长。

如何从一段视频中找出感兴趣的片段?时序行为检测(Temporal Action Localization,TAL)是一种常用方法。过去TAL中的建模是片段甚至实例级的,而现在只要视频里的一帧就能实现,效果媲美全监督。

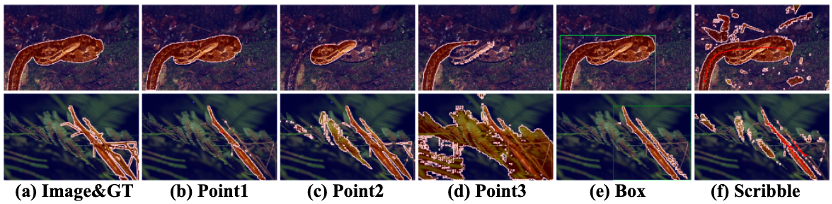

仅需一个任务描述,即可一键分割所有图片!

Vista-LLaMA 在处理长视频内容方面的显著优势,为视频分析领域带来了新的解决框架。

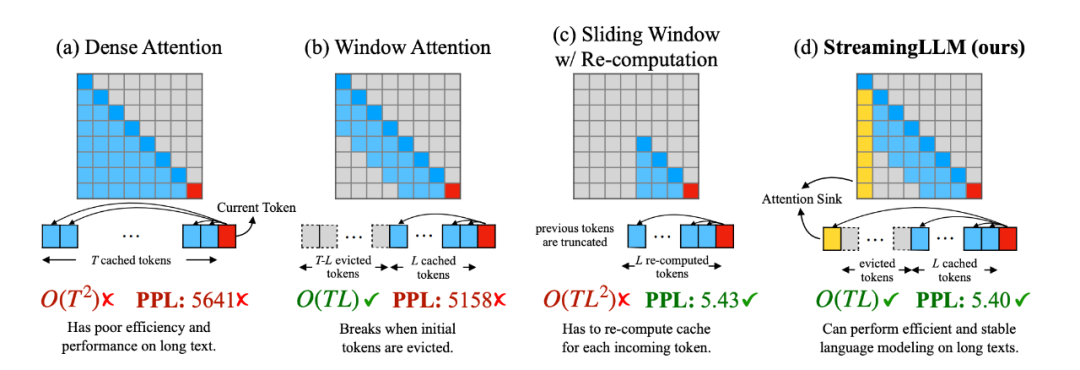

在大型语言模型(LLM)的世界中,处理多轮对话一直是一个挑战。前不久麻省理工 Guangxuan Xiao 等人推出的 StreamingLLM,能够在不牺牲推理速度和生成效果的前提下,可实现多轮对话总共 400 万个 token 的流式输入,22.2 倍的推理速度提升。

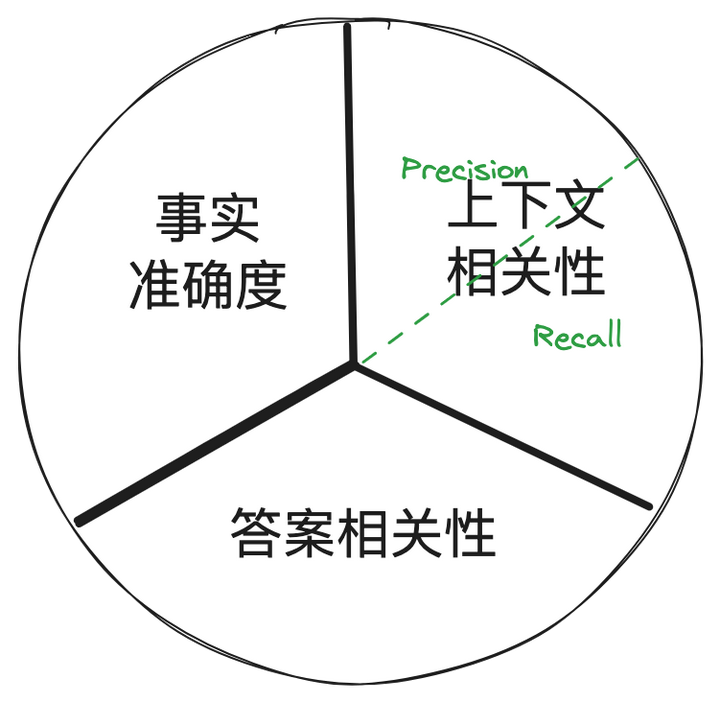

做所有的工作之前,想好如何评估结果、制定好北极星指标至关重要!!! Ragas把 RAG 系统的评估指标拆分为三个维度如下,这可不是 Benz 的标...

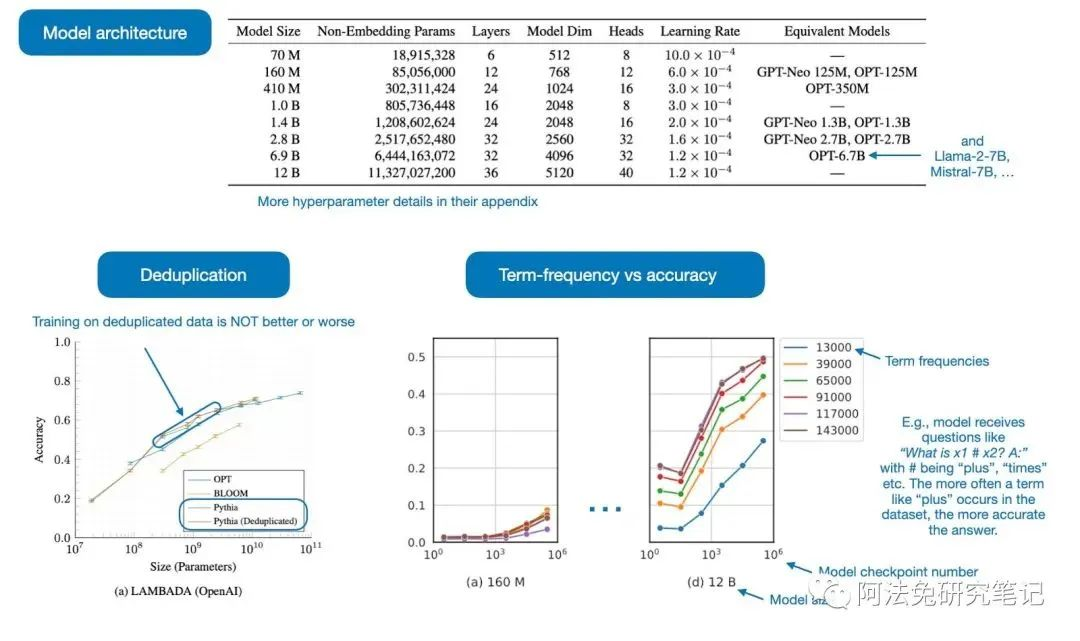

2023 年,是机器学习和人工智能发展最为迅速的一年,这里分享 10 篇最值得关注的论文。

谷歌新设计的一种图像生成模型已经能做到这一点了!通过引入指令微调技术,多模态大模型可以根据文本指令描述的目标和多张参考图像准确生成新图像,效果堪比 PS 大神抓着你的手助你 P 图。

琳琅满目的乐高积木,通过一块又一块的叠加,可以创造出各种栩栩如生的人物、景观等,不同的乐高作品相互组合,又能为爱好者带来新的创意。