具身智能体不再失忆!智源新记忆系统让机器人秒变熟人,支持终身记忆

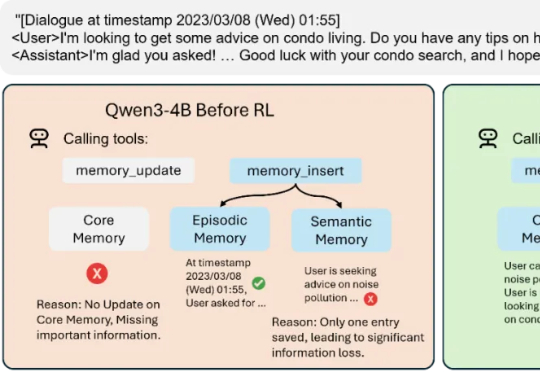

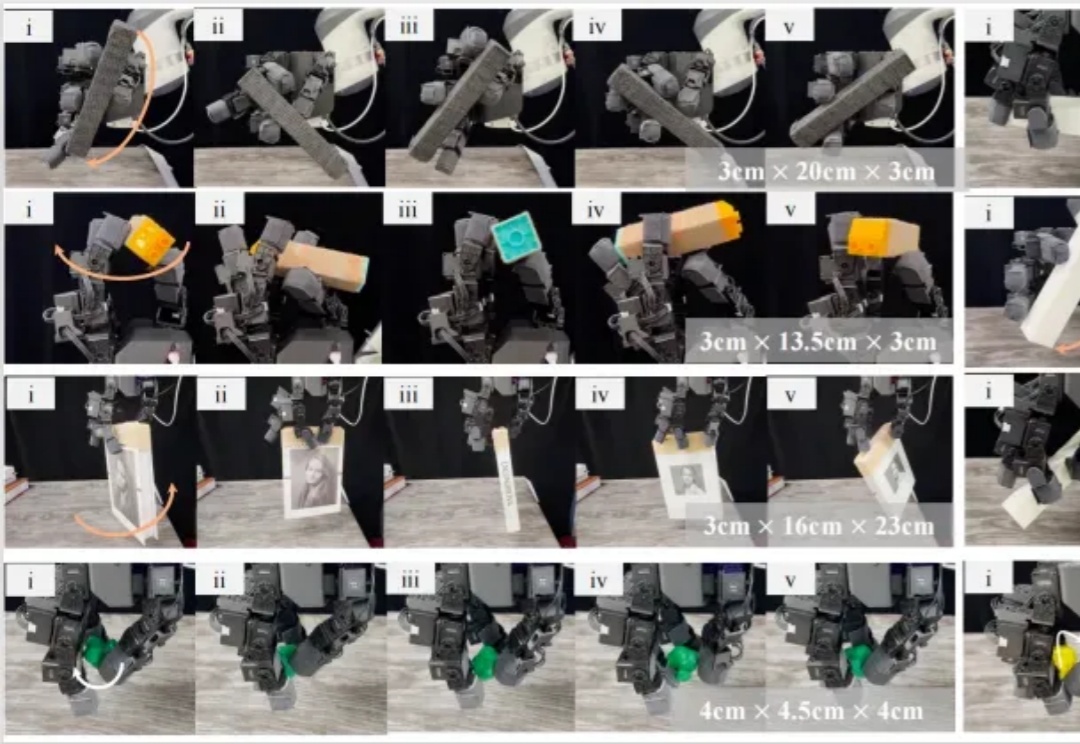

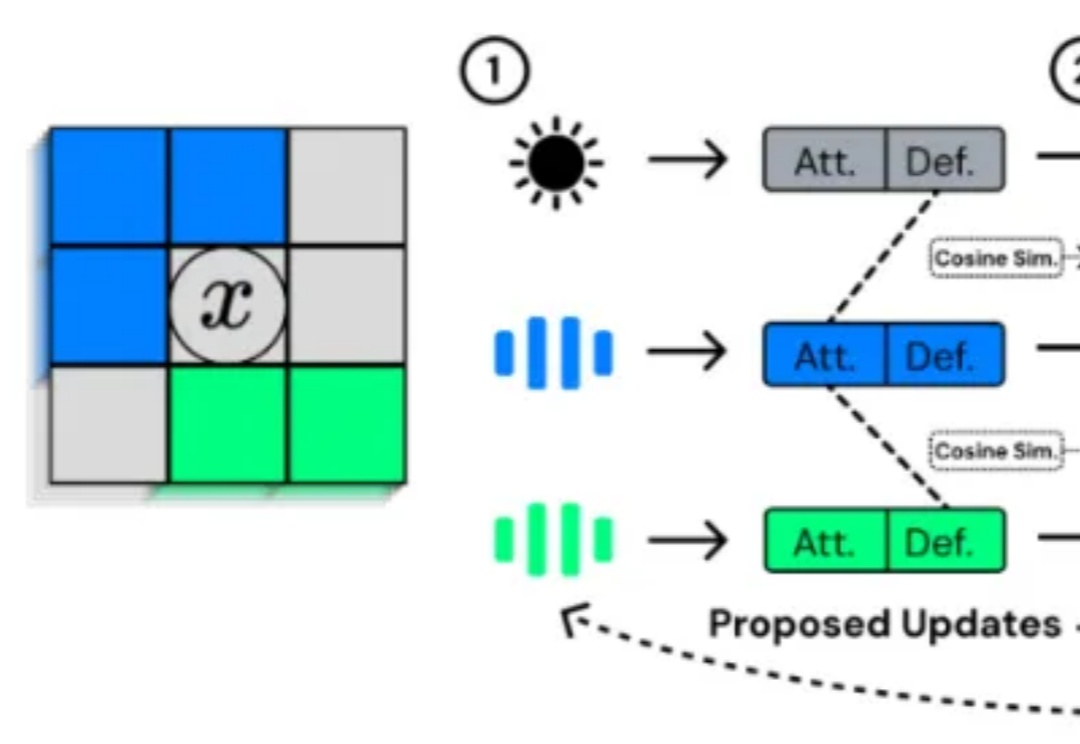

具身智能体不再失忆!智源新记忆系统让机器人秒变熟人,支持终身记忆智源研究院(BAAI)、Spin Matrix、乐聚机器人与新加坡南洋理工大学等联合提出了一个全新的终身记忆系统——RoboBrain-Memory。RoboBrain-Memory是全球范围内首个专为全双工、全模态模型设计的终身记忆系统,旨在解决具身智能体在真实世界的复杂交互问题,不仅支持实时音视频中多用户身份识别与关系理解,还能动态维护个体档案与社会关系图谱,从而实现类人的长期个性化交互。