全球闲置算力训个模型,性能媲美R1,老黄天塌了!Karpathy曾投资它

全球闲置算力训个模型,性能媲美R1,老黄天塌了!Karpathy曾投资它一夜之间,老黄天塌了(doge)。

一夜之间,老黄天塌了(doge)。

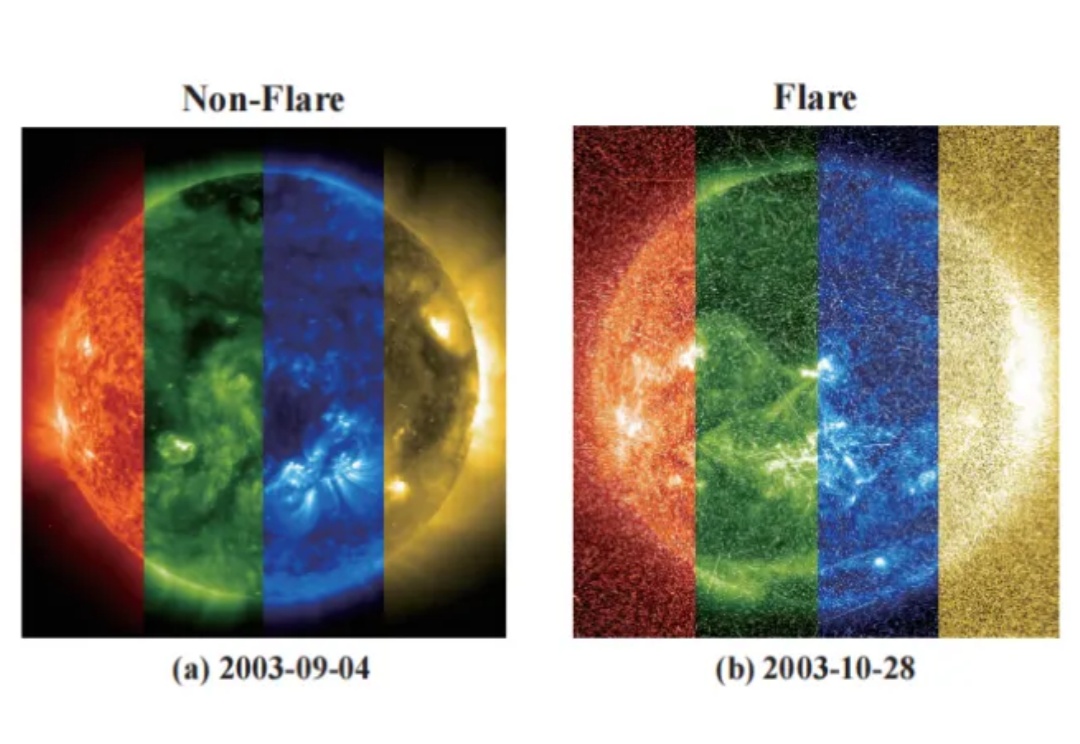

还记得刘慈欣在《全频带阻塞干扰》中描绘的耀斑爆发吗?

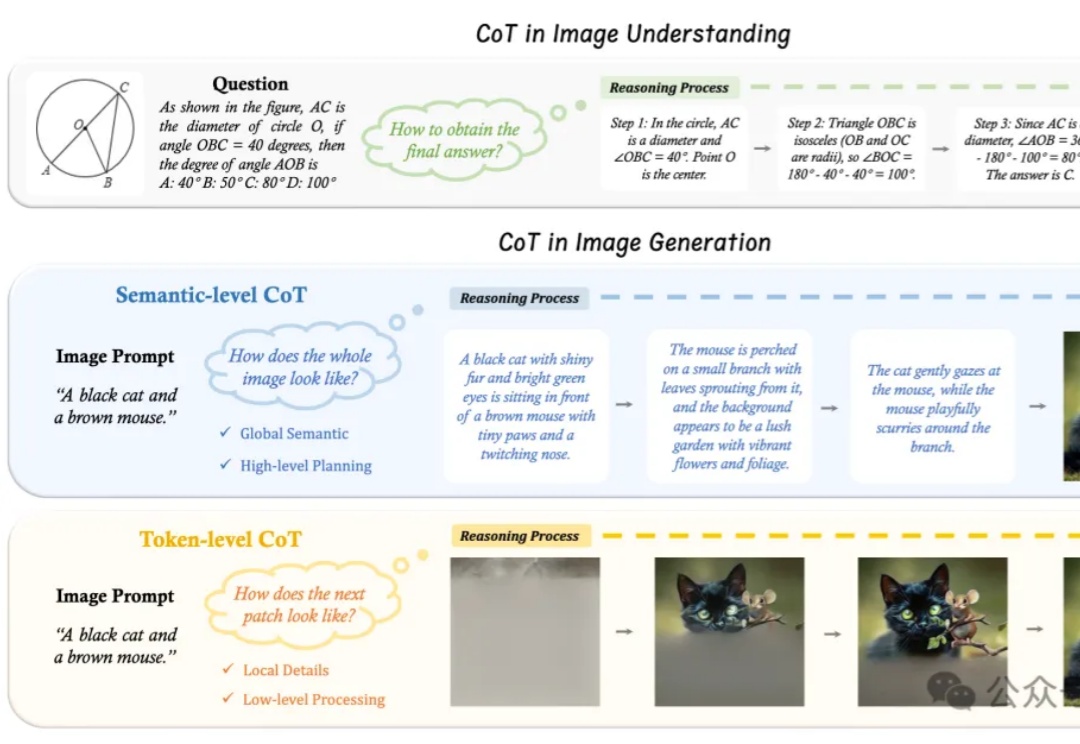

“先推理、再作答”,语言大模型的Thinking模式,现在已经被拓展到了图片领域。

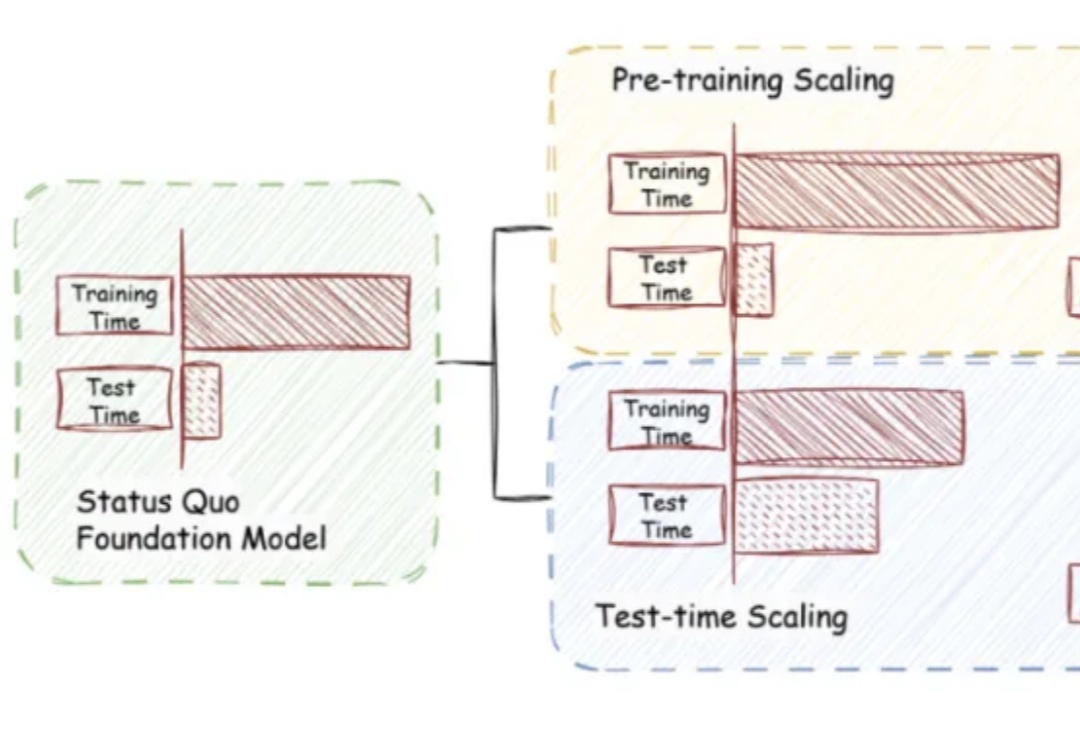

当训练成本飙升、数据枯竭,如何继续激发大模型潜能?

「矩阵」不再是科幻!Matrix-Game震撼来袭,突破边界带来交互式引擎。只需一句话,沙漠森林等任意场景可控生成,动作丝滑操控,360°视角自由切换,沉浸感爆棚。

开启「分步思考」新范式。

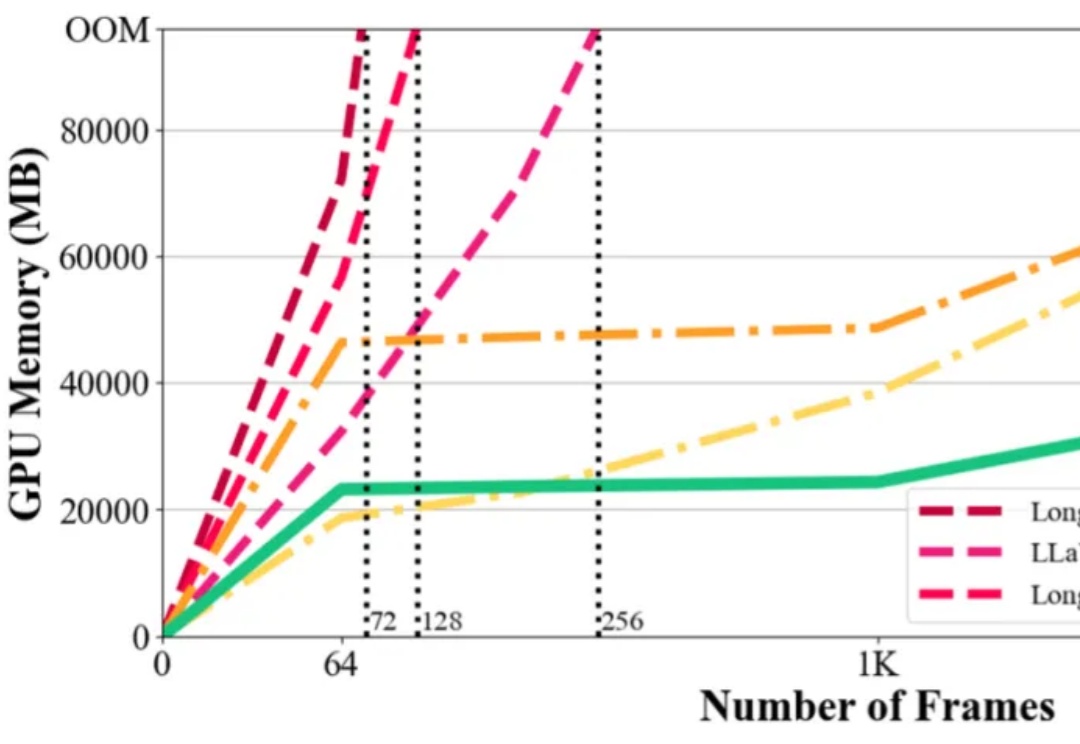

在视觉语言模型(Vision-Language Models,VLMs)取得突破性进展的当下,长视频理解的挑战显得愈发重要。以标准 24 帧率的标清视频为例,仅需数分钟即可产生逾百万的视觉 token,这已远超主流大语言模型 4K-128K 的上下文处理极限。

AI 不允许有人不会搭乐高。

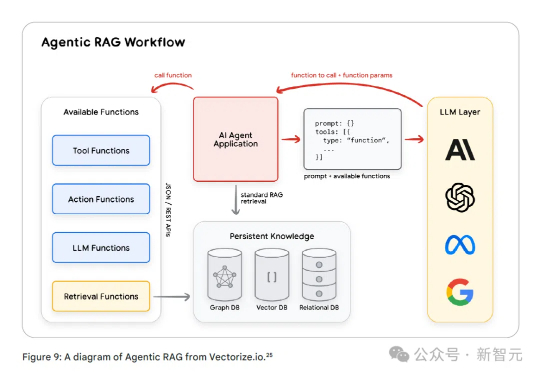

谷歌最新发布的76页AI智能体白皮书,深入剖析了智能体的应用前景。智能体通过感知环境、调用工具和自主规划,能够完成复杂任务并做出高级决策。从智能体运维(AgentOps)到多智能体协作,这份白皮书为AI智能体指明了方向。

递归思考 + 自我批判,CoRT 能带来 LLM 推理力的飞跃吗?

不用引入外部数据,通过自我博弈(Self-play)就能让预训练大模型学会推理?

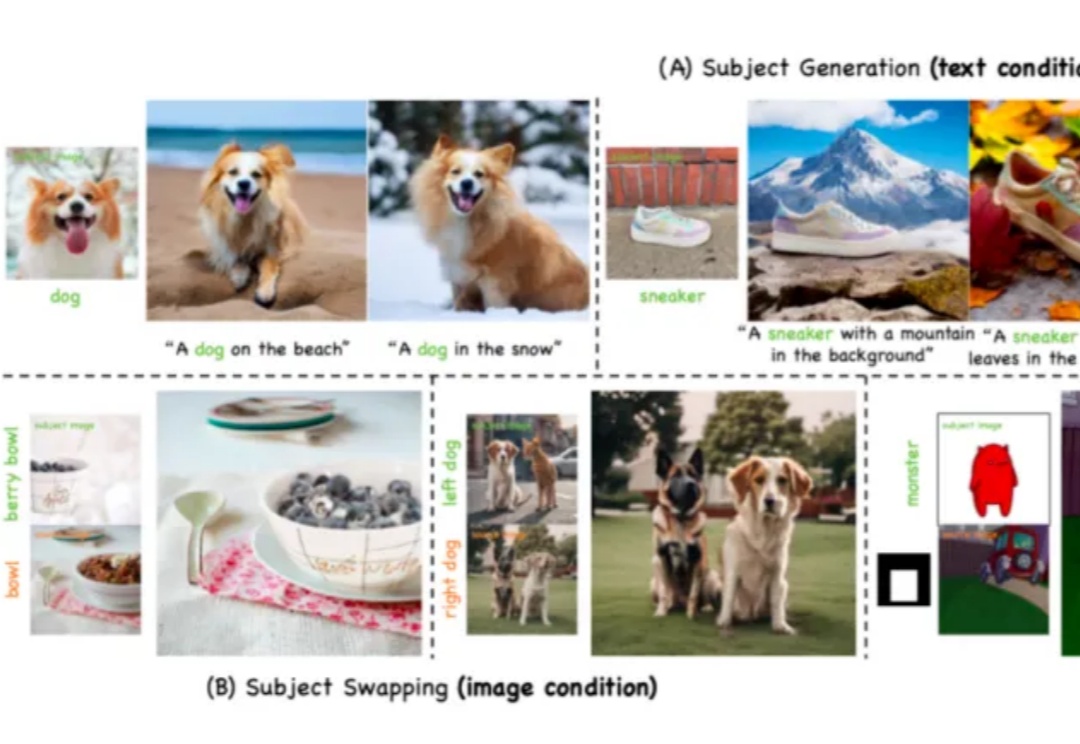

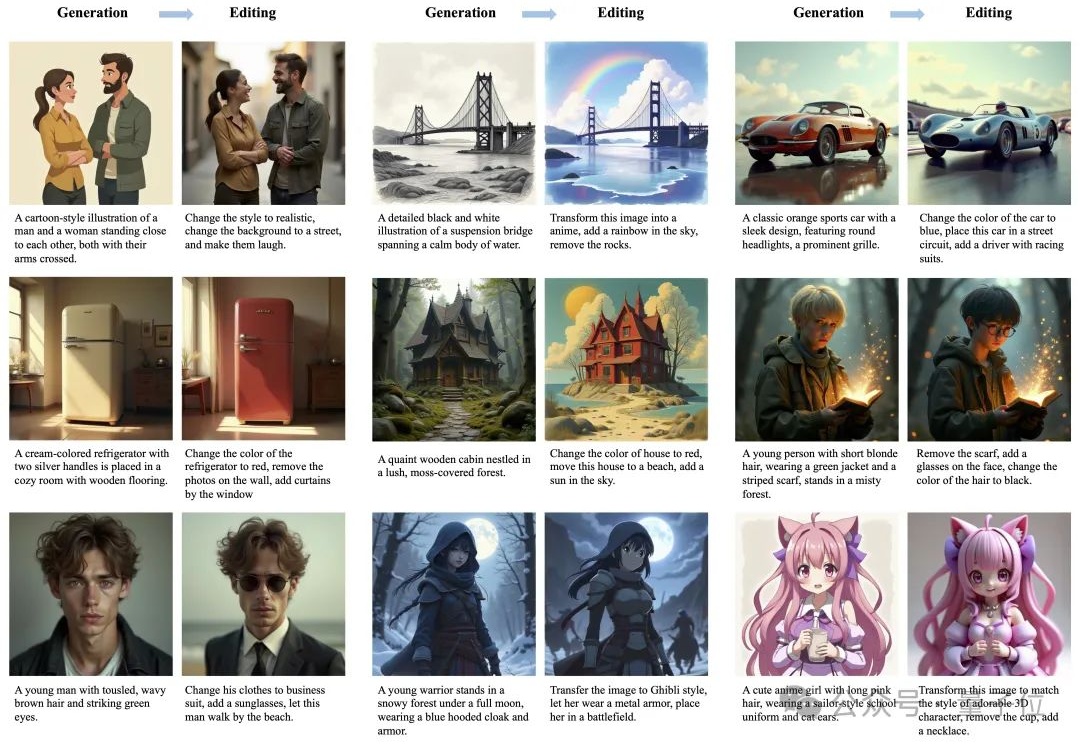

近年来,生成式人工智能(Generative AI)技术的突破性进展,特别是文本到图像 T2I 生成模型的快速发展,已经使 AI 系统能够根据用户输入的文本提示(prompt)生成高度逼真的图像。从早期的 DALL・E 到 Stable Diffusion、Midjourney 等模型,这一领域的技术迭代呈现出加速发展的态势。

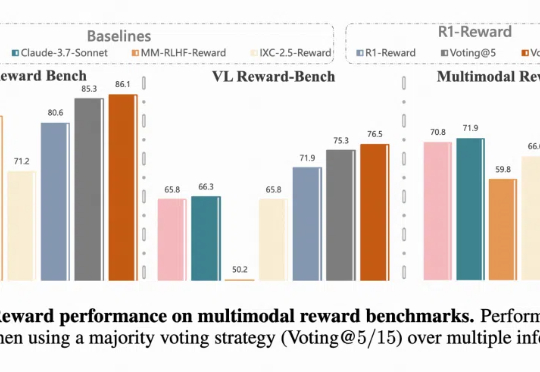

多模态奖励模型(MRMs)在提升多模态大语言模型(MLLMs)的表现中起着至关重要的作用,在训练阶段可以提供稳定的 reward,评估阶段可以选择更好的 sample 结果,甚至单独作为 evaluator。

可控图片生成,如今已经不是什么新鲜事。甚至也不需要复杂的提示词,用户通过简单的文本描述,就能快速生成符合个人需求的创意图像。

菲尔兹奖得主陶哲轩再放大招,仅数天时间,开源的概念验证工具借助Copilot迭代至2.0版本。而在最新视频中,他甚至用AI在33分钟「盲做」形式化一页证明,效率惊人。

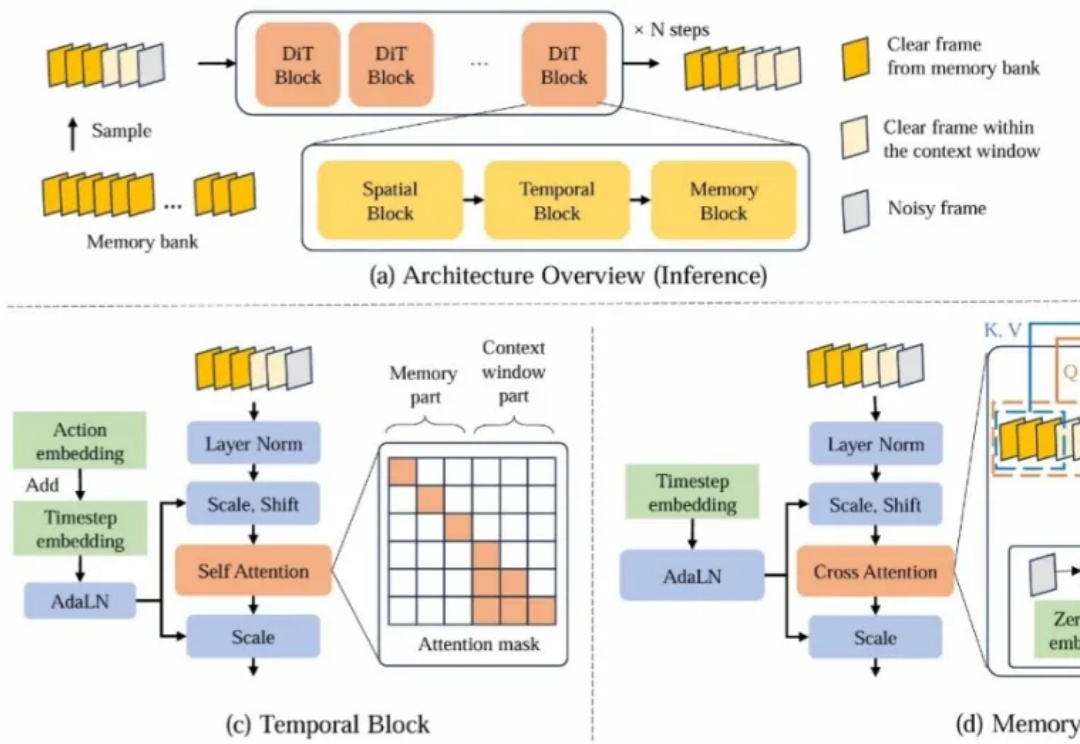

近年来,基于视频生成模型的可交互世界生成引发了广泛关注。尽管现有方法在生成质量和交互能力上取得了显著进展,但由于上下文时间窗口受限,生成的世界在长时序下严重缺乏一致性。

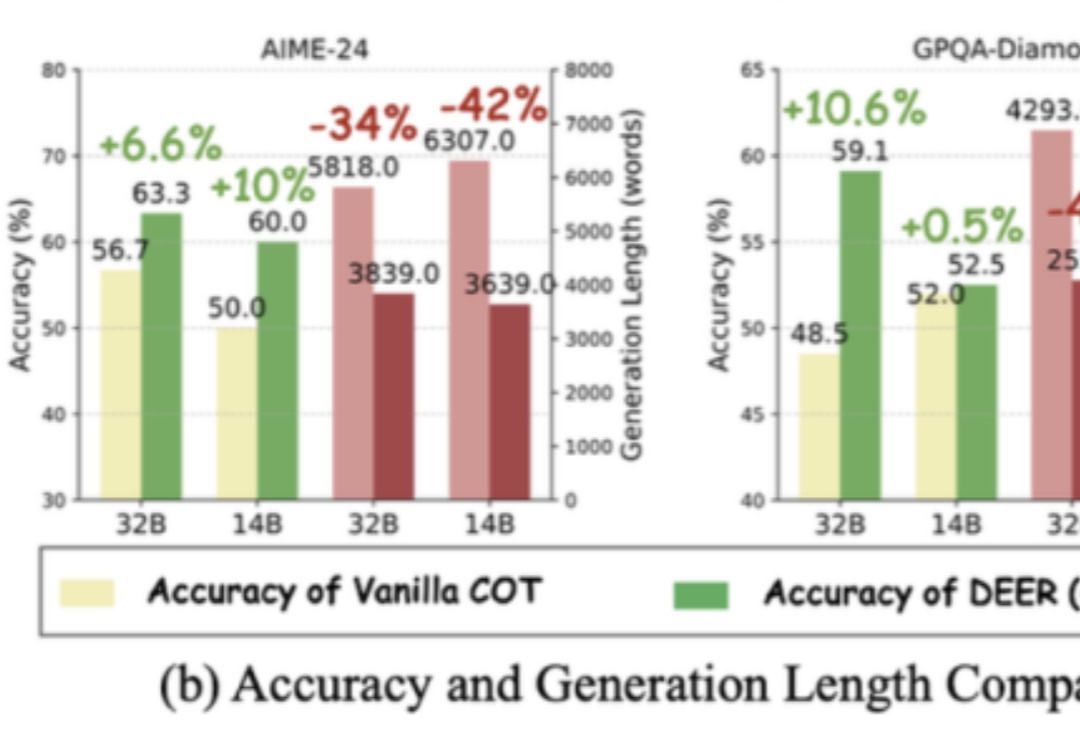

长思维链让大模型具备了推理能力,但如果过度思考,就有可能成为负担。

Sora、可灵等视频生成模型令人惊艳的性能表现使得创作者仅依靠文本输入就能够创作出高质量的视频内容。然而,我们常见的电影片段通常是由导演在一个场景中精心布置多个目标的运动、摄像机拍摄角度后再剪辑而成的。例如,在拍摄赛车追逐的场景时,镜头通常跟随赛车运动,并通过扣人心弦的超车时刻来展示赛事的白热化。

OpenAI GPT-4o发布强大图片生成能力后,业界对大模型生图能力的探索向全模态方向倾斜,训练全模态模型成研发重点。

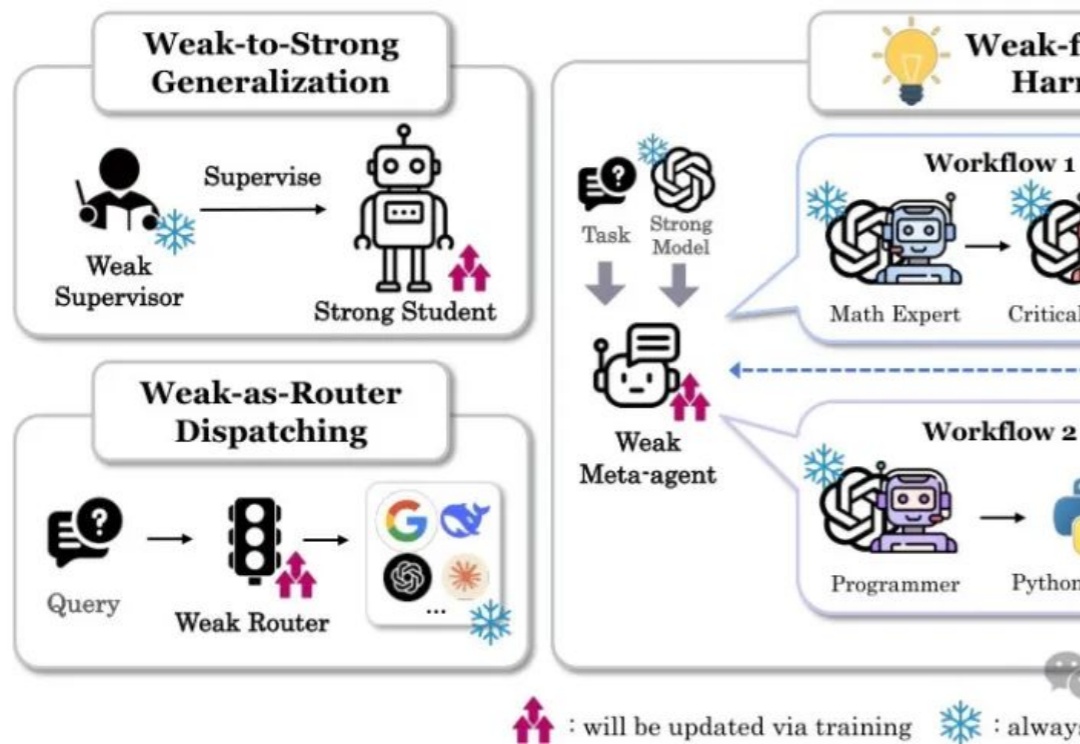

本文详细介绍了斯坦福大学最新提出的"以弱驭强"(W4S)范式,这一创新方法通过训练轻量级的弱模型来优化强大语言模型的工作流。核心亮点包括:

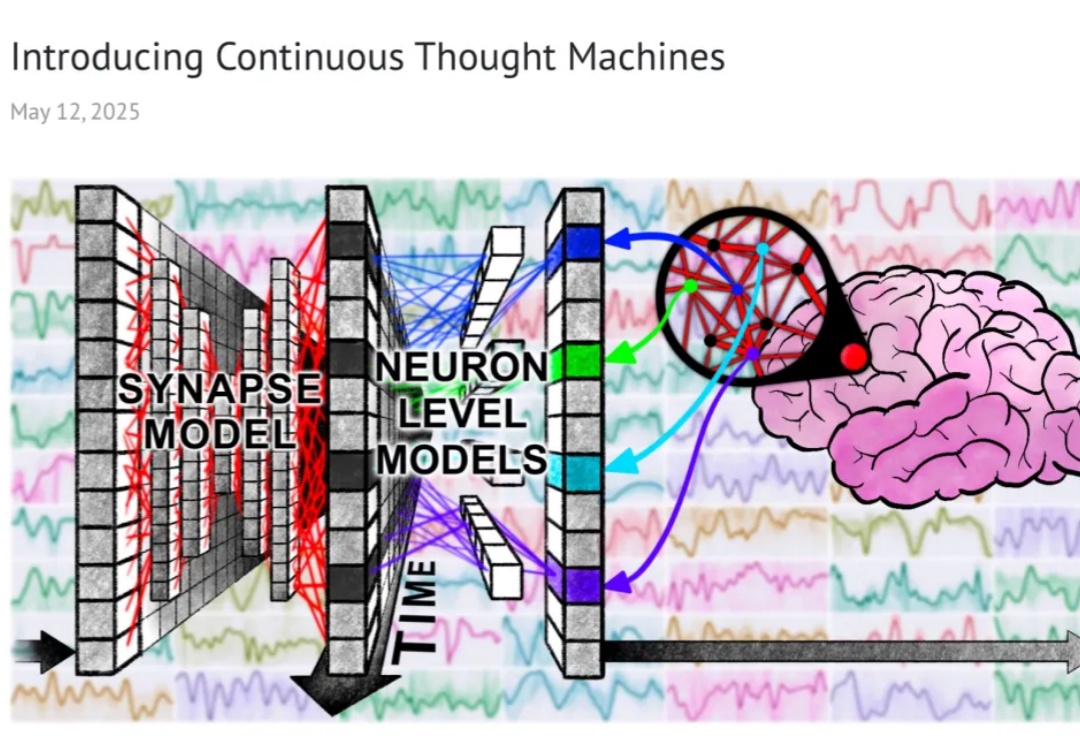

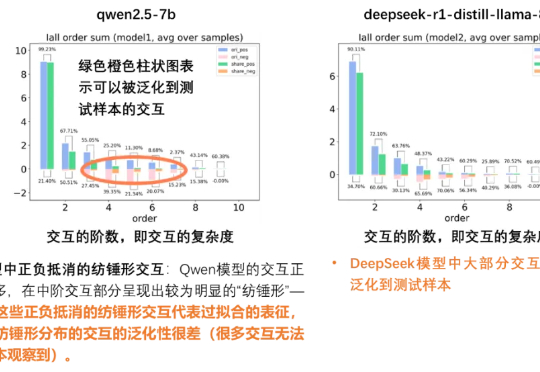

当以端到端黑盒训练为代表的深度学习深陷低效 Scaling Law 而无法自拔时,我们是否可以回到起点重看模型表征本身——究竟什么才是一个人工智能模型的「表征质量」或者「泛化性」?我们真的只有通过海量的测试数据才能抓住泛化性的本质吗?或者说,能否在数学上找到一个定理,直接从表征逻辑复杂度本身就给出一个对模型泛化性的先验的判断呢?

AI输出陷入"无效对话"困境?其实是你不懂提问的艺术。从指令颗粒度拆解到思维链编织,本文揭示精准提问如何唤醒AI潜能——与其焦虑技术颠覆,不如掌握这套数字化时代的元能力,让语言真正成为撬动生产力的支点。文章来自编译。

刚刚,鹅厂开源“自定义”视频生成模型HunyuanCustom。

模型胡乱论证“1+1=3”,评测系统却浑然不觉甚至疯狂打Call?是时候给奖励模型打个分了!

Jim Fan,英伟达机器人部门主管和杰出科学家、GEAR 实验室联合领导人、OpenAI 的首位实习生,最近在红杉资本主办的 AI Ascent 上做了一场 17 分钟的演讲

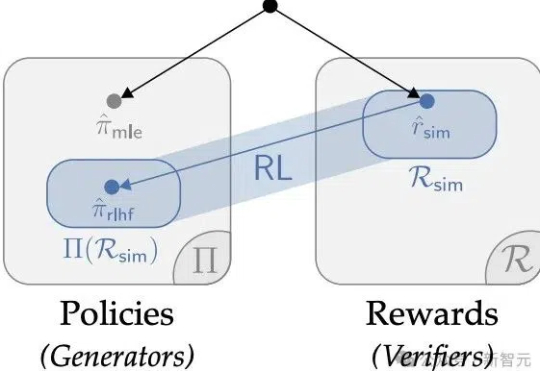

华人学者参与的一项研究,重新确立了强化学习在LLM微调的价值,深度解释了AI训练「两阶段强化学习」的原因。某种意义上,他们的论文说明RL微调就是统计。

那些曾在KDD时代Kaggle上打榜刷分的老炮儿,每每提起 Bagging 与 Boosting 这两项技术嘴角都压不住笑。

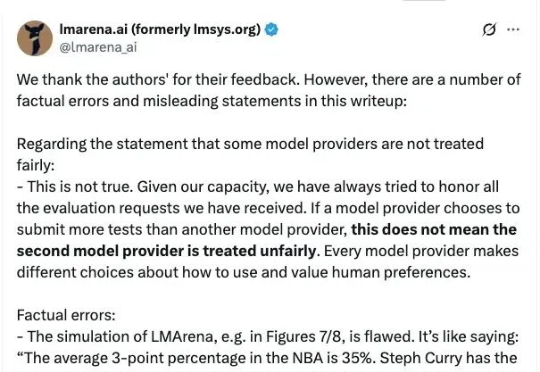

AI研究中,基准测试(benchmark)和排行榜在评估模型性能上扮演着关键角色。

一张普通的生活照,可能成为 AI 破解你隐私的钥匙 —— 这不是科幻情节,而是最新研究揭示的残酷现实。

当AI与工具相结合,智能体不再只是概念!Minion-agent整合多框架能力,解决碎片化问题,支持多智能体协作与工具调用,降低开发门槛,已在多个场景中展现高效能力,有望推动AI智能体创新和普及!