3B模型不输7B LLaVA!北大多模态MoE模型登GitHub热榜

3B模型不输7B LLaVA!北大多模态MoE模型登GitHub热榜混合专家(MoE)架构已支持多模态大模型,开发者终于不用卷参数量了!北大联合中山大学、腾讯等机构推出的新模型MoE-LLaVA,登上了GitHub热榜。

混合专家(MoE)架构已支持多模态大模型,开发者终于不用卷参数量了!北大联合中山大学、腾讯等机构推出的新模型MoE-LLaVA,登上了GitHub热榜。

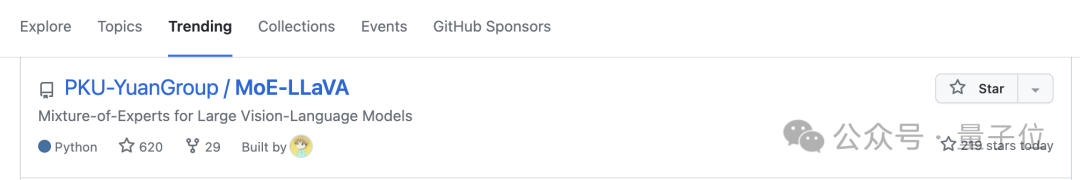

谷歌&南加大推出最新研究“自我发现”(Self-Discover),重新定义了大模型推理范式。与已成行业标准的思维链(CoT)相比,新方法不仅让模型在面对复杂任务时表现更佳,还把同等效果下的推理成本压缩至1/40。

由华中科技大学光影交互服务技术文旅部重点实验室发起成立的中国人工智能艺术教育协同创新平台召开了首届人工智能艺术长江论坛(ArtI2023)暨中国人工智能艺术教育协同创新平台成立大会,会上重磅发布了《中国人工智能艺术教育白皮书》。

MoE(混合专家)作为当下最顶尖、最前沿的大模型技术方向,MoE能在不增加推理成本的前提下,为大模型带来性能激增。比如,在MoE的加持之下,GPT-4带来的用户体验较之GPT-3.5有着革命性的飞升。

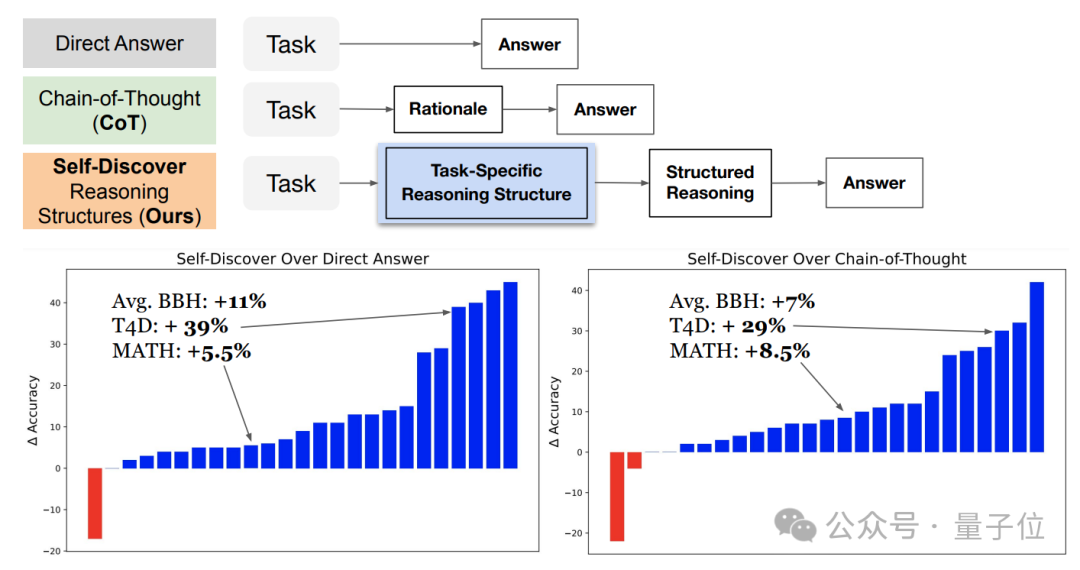

赶在春节前,通义千问大模型(Qwen)的 1.5 版上线了。今天上午,新版本的消息引发了 AI 社区关注。

Meshy-2 的文本转 3D、图像转 3D、文本到纹理效果均有所提升。

「我向一位女生求婚,ChatGPT 已经和她交流了一年。为了走到这一步,AI 已经尝试了和 5239 名女生进行过沟通……」

当AI大模型在2023年飞速成熟后,几乎每个行业都在尝试“AI赋能”,并希望AI能够化腐朽为神奇。

人工智能是2023年科技圈最大的亮点,这件事已经是毋庸置疑,但就像工业革命那样改变世界是有代价的一样,更高效、更便捷的AIGC(生成式AI)仅仅只用一年时间,就改变了许多人的职业生涯。

2023 年 11 月底,视频生成产品 Pika 发布 1.0 版本,同时宣布了 5500 万美元的融资消息。