阅读7千万文章硅谷爆火:AI奇点已至,抛弃人类自我进化!

阅读7千万文章硅谷爆火:AI奇点已至,抛弃人类自我进化!就在本月,AI 经历了质变式飞跃,已经能独立完成过去需要人类专家数小时才能搞定的复杂工作。AI 开始参与构建下一代 AI,递归自我提升的循环已经启动,智能爆炸可能在一两年内到来。

就在本月,AI 经历了质变式飞跃,已经能独立完成过去需要人类专家数小时才能搞定的复杂工作。AI 开始参与构建下一代 AI,递归自我提升的循环已经启动,智能爆炸可能在一两年内到来。

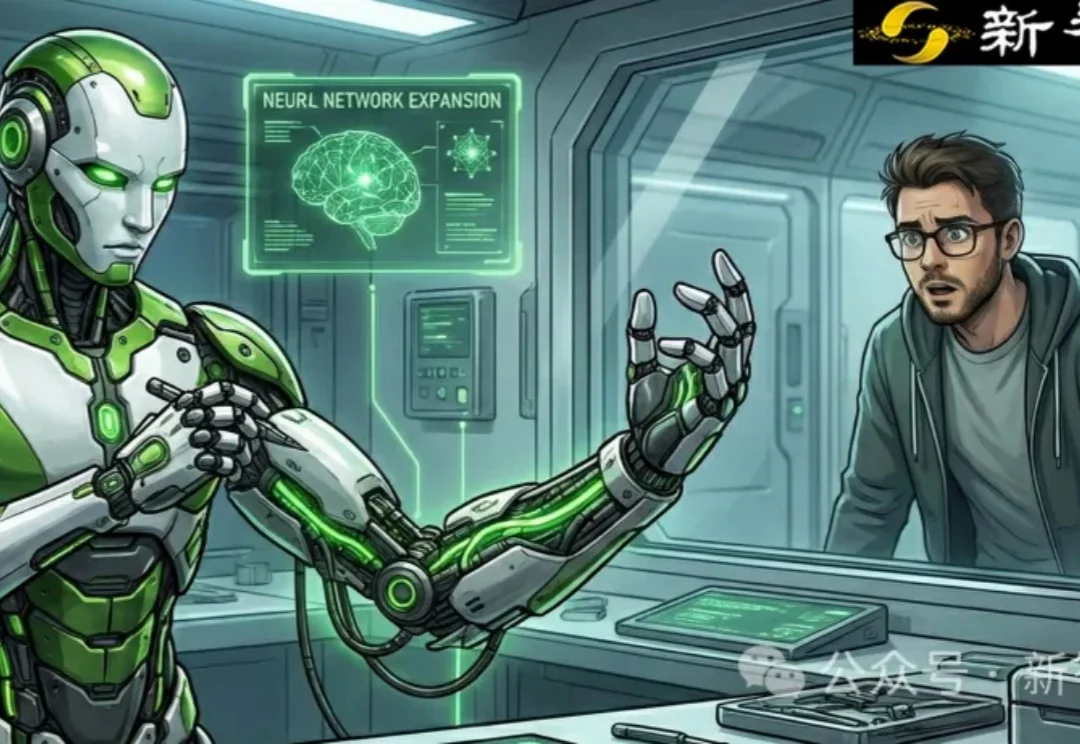

DiscoX构建了一套200题的长文翻译数据集,以平均长度1,712 tokens的长篇章做评测单元,要求整个长文文本作为一个整体来翻译,除翻译准确度外,重点考察跨段落的逻辑与风格一致性、上下文中的术语精确性、以及专业写作规范,贴合用户真实的使用场景。

今天,Gemini 3 Deep Think重磅升级,几乎刷爆全领域的SOTA,标志着AI推理能力进入了全新维度。这一次,在科学研究和硬核工程领域,Deep Think堪称一个「最强大脑」。

一位牛津哲学博士,正在Anthropic教全球顶尖AI模型如何「做人」。这场跨物种的「育儿实验」,比科幻更炸裂。

上周四去著名科技媒体品牌《硅星人》交流。

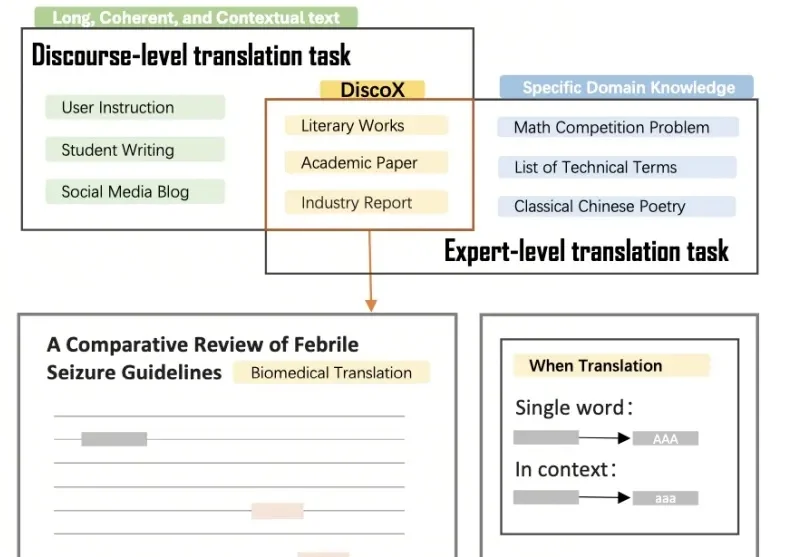

在量化金融的底层,Alpha因子本质上是一段可执行的代码逻辑,它们试图将嘈杂的市场数据映射为精准的交易信号。

思考token在精不在多。Yuan 3.0 Flash用RAPO+RIRM双杀过度思考,推理token砍75%,网友们惊呼:这就是下一代AI模型的发展方向!

你斥巨资买回家的全能家务机器人,正在执行“把药片拿给奶奶”的任务。

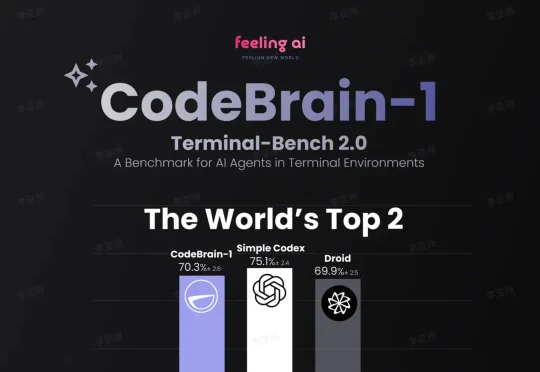

就在这个被 Anthropic 和 OpenAI 视为衡量 Agent 真实工程能力全球权威基准 Terminal-Bench 2.0 榜单上,中国团队 Feeling AI 凭借 CodeBrain-1,搭载最新 GPT-5.3-Codex 底座模型,一举冲到 72.9%(70.3%) 并跻身全球排行榜第二,成为榜单前 10 中唯一的中国团队。

不管Pony Alpha是不是智谱的,下一代旗舰大模型GLM-5都要来了。GLM-5采用了DeepSeek-V3/V3.2架构,包括稀疏注意力机制(DSA)和多Token预测(MTP),总参数量745B,是上一代GLM-4.7的2倍。