打破MoE训练效率与性能瓶颈,华为盘古稀疏大模型全新架构LocMoE出炉

打破MoE训练效率与性能瓶颈,华为盘古稀疏大模型全新架构LocMoE出炉2023 年 12 月,首个开源 MoE 大模型 Mixtral 8×7B 发布,在多种基准测试中,其表现近乎超越了 GPT-3.5 和 LLaMA 2 70B,而推理开销仅相当于 12B 左右的稠密模型。为进一步提升模型性能,稠密 LLM 常由于其参数规模急剧扩张而面临严峻的训练成本。

2023 年 12 月,首个开源 MoE 大模型 Mixtral 8×7B 发布,在多种基准测试中,其表现近乎超越了 GPT-3.5 和 LLaMA 2 70B,而推理开销仅相当于 12B 左右的稠密模型。为进一步提升模型性能,稠密 LLM 常由于其参数规模急剧扩张而面临严峻的训练成本。

由香港科技大学(港科大)领导的一支国际研究团队,以人工智能技术(AI)研发出一个机器学习模型,能有效促进全球农田的氨减排。

2B性能小钢炮来了!刚刚,面壁智能重磅开源了旗舰级端侧多模态模型MiniCPM,2B就能赶超Mistral-7B,还能越级比肩Llama2-13B。成本更是低到炸裂,170万tokens成本仅为1元!

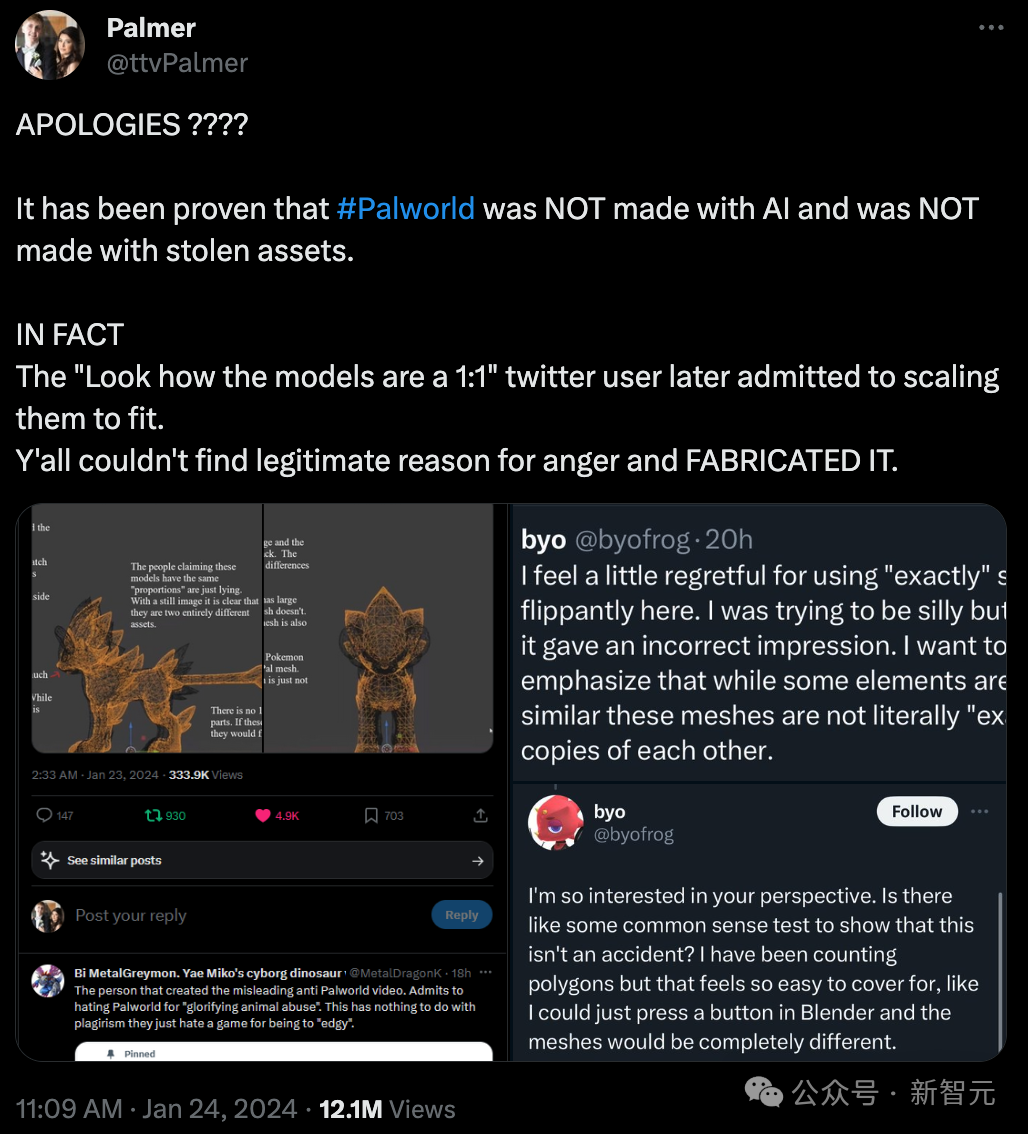

这两天Steam上突然出现了一款爆火的现象级游戏《幻兽帕鲁(Palworld)》。发售没几天就直接冲到了Steam史上玩家在线排行榜第2,超过了CS2等一众经典老游戏。

“中国现在有数以百计的通用大模型,其中的90%没多大用处,也发展不起来,只会加剧资源和人力的浪费,应该被淘汰。”1月18日,在“北京CGT新势发布会”上,中国科学院院士、翊博生物首席科学家陈润生向经济观察网谈及他对国产大模型的看法。

斯坦福炒菜机器人的大火,开启了2024年机器人元年。最近,CMU研究团队推出了一款能在开放世界完成任务的机器人,成本仅18万元。没见过的场景,它可以靠自学学会!

一款名为Vary-toy的“年轻人的第一个多模态大模型”来了!模型大小不到2B,消费级显卡可训练,GTX1080ti 8G的老显卡轻松运行。

1月18日,马克·扎克伯格宣布,Meta正在计划构建自己的AGI(通用人工智能),将在绝大多数领域中都达到或超越人类智能水平。同时他强调,保证会向大众开放这一技术,以便人人都能从中获益。

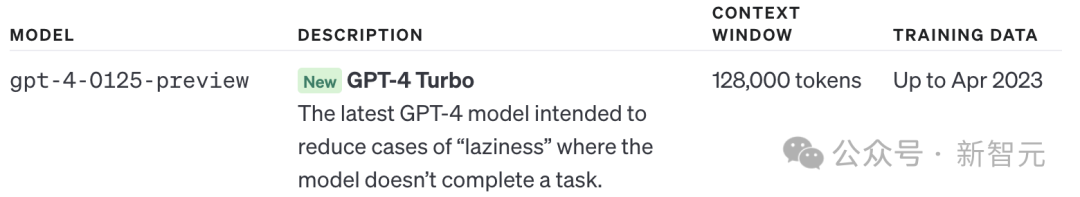

昨夜,OpenAI一口气连更5款新模型。GPT-4 Turbo变懒问题修复,代码生成能力史诗级加强。另外,多款模型价格大幅暴降。

这两天,ElevenLabs 紧随着自己融资 8000 万的新闻,在 X 上接连发了一则招聘启事和一条宣传片,以将自己的团队规模,从 40 人扩大到 100 人。