DeepSeek开源通用矩阵乘法库,300行代码加速V3、R1,R2被曝五月前问世

DeepSeek开源通用矩阵乘法库,300行代码加速V3、R1,R2被曝五月前问世DeepSeek 的开源周已经进行到了第三天(前两天报道见文末「相关阅读」)。今天开源的项目名叫 DeepGEMM,是一款支持密集型和专家混合(MoE)GEMM 的 FP8 GEMM 库,为 V3/R1 的训练和推理提供了支持,在 Hopper GPU 上可以达到 1350+ FP8 TFLOPS 的计算性能。

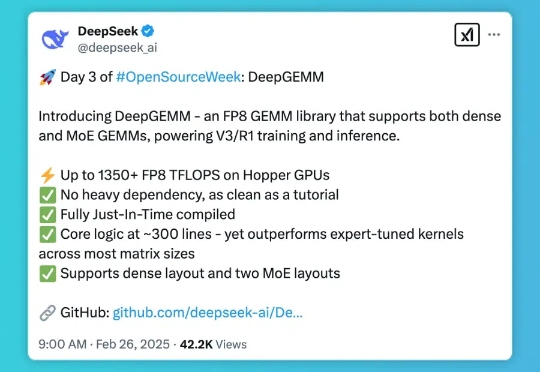

DeepSeek 的开源周已经进行到了第三天(前两天报道见文末「相关阅读」)。今天开源的项目名叫 DeepGEMM,是一款支持密集型和专家混合(MoE)GEMM 的 FP8 GEMM 库,为 V3/R1 的训练和推理提供了支持,在 Hopper GPU 上可以达到 1350+ FP8 TFLOPS 的计算性能。

DeepSeek 开源周的第三天,带来了专为 Hopper 架构 GPU 优化的矩阵乘法库 — DeepGEMM。这一库支持标准矩阵计算和混合专家模型(MoE)计算,为 DeepSeek-V3/R1 的训练和推理提供强大支持,在 Hopper GPU 上达到 1350+FP8 TFLOPS 的高性能。

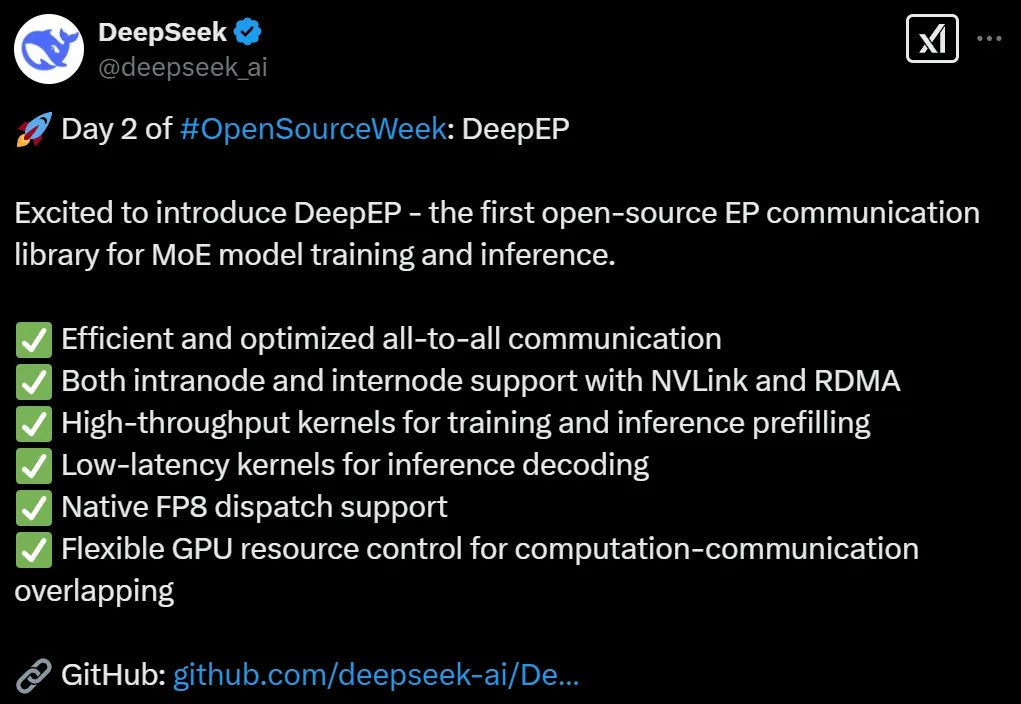

DeepSeek开源第二弹如期而至。这一次,他们把MoE模型内核库开源了,支持FP8专为Hopper GPU设计,低延迟超高速训练推理。

DeepSeek开源第二弹如期而至。这一次,他们把MoE训推EP通信库DeepEP开源了,支持FP8专为Hopper GPU设计,低延迟超高速训练推理。

2月18日,开为科技在南京举行重磅发布会,推出了全新的企业级AI Agent平台“Roles”,引来行业内外的密切关注。

大雄:(趴在书桌前抓头发)哆啦 A 梦!今天的作文题目是《未来的机器人》,可是我要写800字!写不完啦!哆啦 A 梦:(得意叉腰)别担心!我刚从22世纪带来了「超高效作业处理器」——FlashMLA 魔盒!它能让写作文像吃铜锣烧一样快哦!

本周一,阿里巴巴集团CEO吴泳铭抛出了炸弹——未来三年将投入超3800亿元建设云和AI硬件基础设施。这个金额,不仅创下了中国民营企业在该领域有史以来最大规模的投资纪录,更像一枚投入湖面的巨石,在中国科技产业激起层层涟漪。

DeepSeek开源周第一天就放大招!FlashMLA强势登场,这是专为英伟达Hopper GPU打造MLA解码内核。注意,DeepSeek训练成本极低的两大关键,一个是MoE,另一个就是MLA。

导师认为,他无需使用AI也能通过考试。

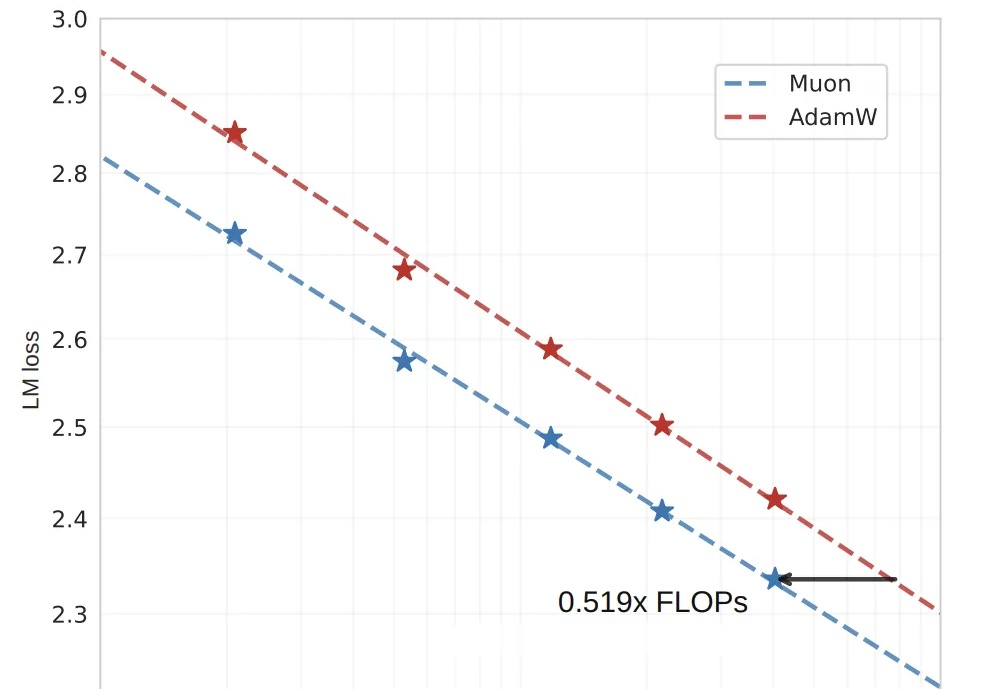

算力需求比AdamW直降48%,OpenAI技术人员提出的训练优化算法Muon,被月之暗面团队又推进了一步!