每秒生成超30帧视频,支持实时交互!自回归视频生成新框架刷新生成效率

每秒生成超30帧视频,支持实时交互!自回归视频生成新框架刷新生成效率在A100上用310M模型,实现每秒超30帧自回归视频生成,同时画面还保持高质量!

在A100上用310M模型,实现每秒超30帧自回归视频生成,同时画面还保持高质量!

人还是太孤独了。

最近,家在香港的朋友阿豪和我分享了一件既有意思又有点可怕的事情。

2025年是AI Agent爆发之年。

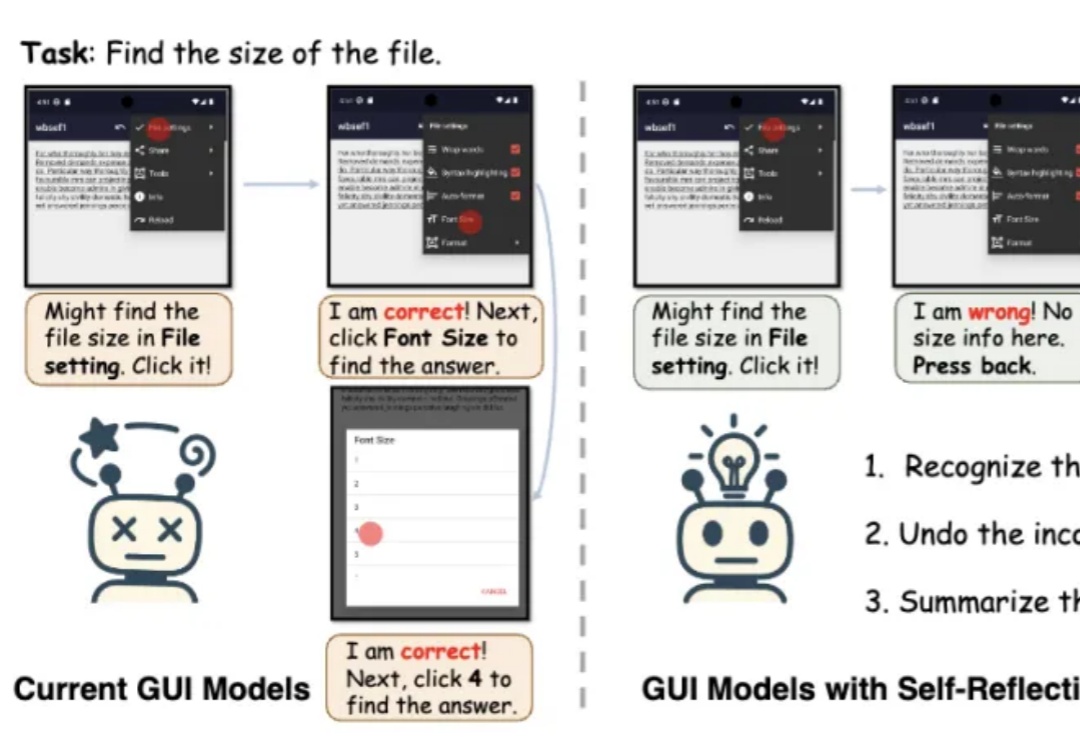

端到端多模态GUI智能体有了“自我反思”能力!南洋理工大学MMLab团队提出框架GUI-Reflection。

几乎路上所有的广告牌都被AI占据,几乎每栋楼都有人给你讲AI的创业故事——盛景网联董事长、盛景嘉成创投创始合伙人彭志强对不久前在硅谷见到的景象记忆犹新。

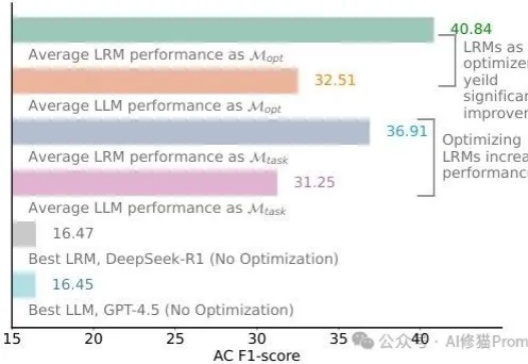

还记得DeepSeek-R1发布时AI圈的那波狂欢吗?"提示工程已死"、"再也不用费心写复杂提示了"、"推理模型已经聪明到不再需要学习提示词了"......这些观点在社交媒体上刷屏,连不少技术大佬都在转发。再到最近,“提示词写死了”......现实总是来得这么快——乔治梅森大学的研究者们用一个严谨得让人无法反驳的实验,狠狠打了所有人的脸!

如何与AI共处?

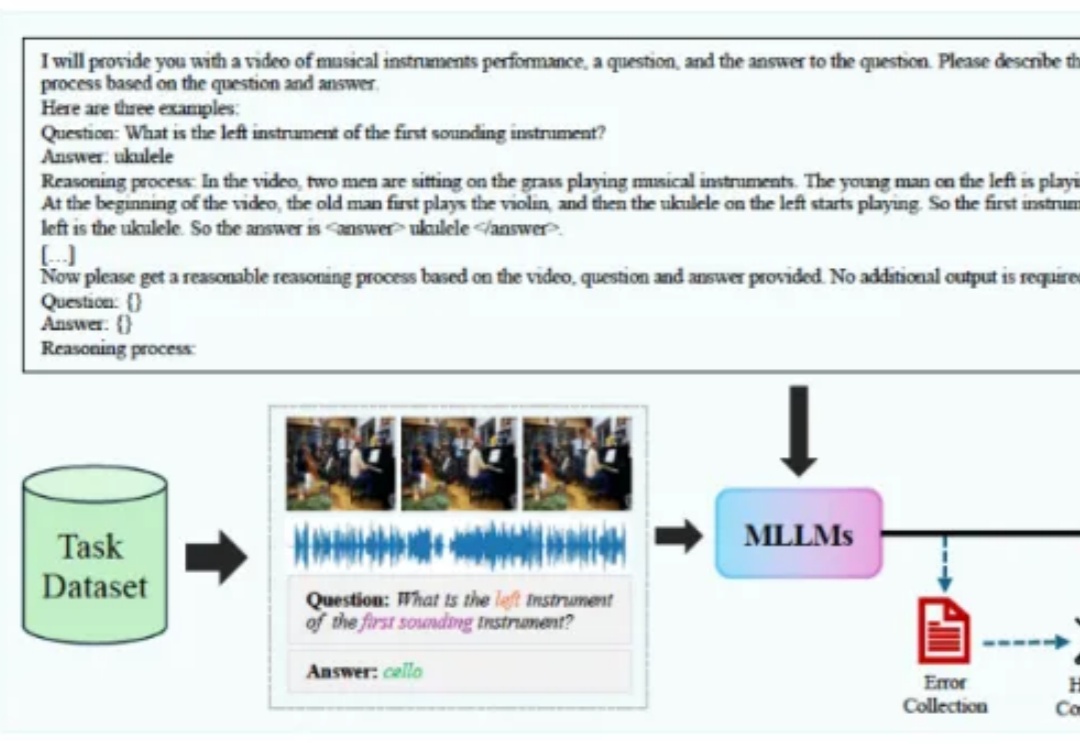

我们人类生活在一个充满视觉和音频信息的世界中,近年来已经有很多工作利用这两个模态的信息来增强模型对视听场景的理解能力,衍生出了多种不同类型的任务,它们分别要求模型具备不同层面的能力。

在人工智能浪潮席卷全球的今天,央国企作为“国家队”,正加速驶入AI赛道。政策推动、产业升级、技术变革的多重压力下,一场关于“速度与质量”的博弈悄然展开。