10行代码让大模型数学提升20%,“野路子”研究谷歌也测上了,主要作者全靠自学成才

10行代码让大模型数学提升20%,“野路子”研究谷歌也测上了,主要作者全靠自学成才只要不到10行代码,就能让大模型数学能力(GSM8k)提升20%!

只要不到10行代码,就能让大模型数学能力(GSM8k)提升20%!

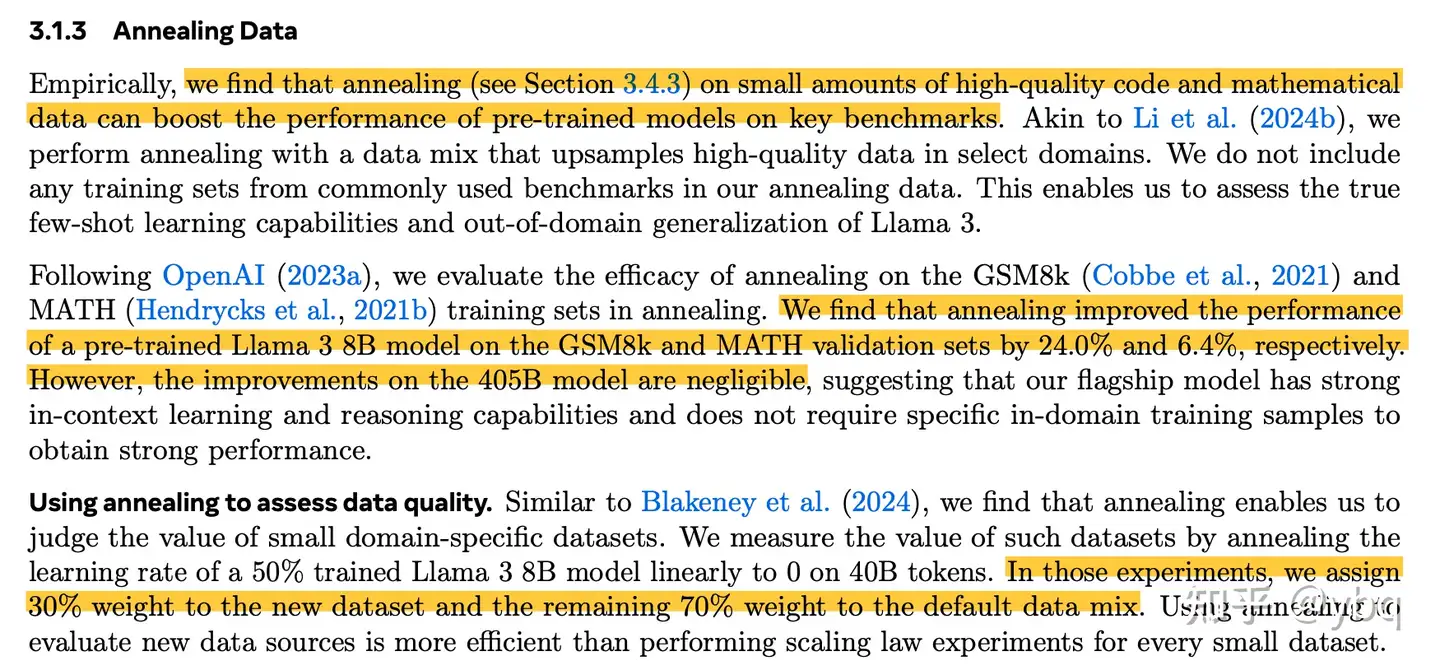

这篇文章对如何进行领域模型训练进行一个简单的探讨,主要内容是对 post-pretrain 阶段进行分析,后续的 Alignment 阶段就先不提了,注意好老生常谈的“数据质量”和“数据多样性”即可。

被谷歌买下的AI独角兽Character.AI,已与团队深度融合。Transformer核心作者、创始人之一Noam Shazeer将担任Gemini联合技术负责人,与Jeff Dean和Oriol Vinyals平起平坐。

神经网络是一种灵活且强大的函数近似方法。而许多应用都需要学习一个相对于某种对称性不变或等变的函数。图像识别便是一个典型示例 —— 当图像发生平移时,情况不会发生变化。等变神经网络(equivariant neural network)可为学习这些不变或等变函数提供一个灵活的框架。

距离GPT-4首次发布已经过去了将近一年半的时间,Nature最近发表的一篇报告却探索出了这个「过气」模型的新用途——氨基酸和蛋白质的结构建模。

为了实现算力层面的提升和追赶,国内有大量的厂商和从业者在各个产业链环节努力。但面对中短期内架构、制程、产能、出口禁令等多方面的制约,我们认为从芯片层面实现单点的突破依旧是非常困难且不足的。

Attention is all you need.

MidReal 创始人陈锴杰,持续创业者,大学毕业后一直在创业,从18 ~19 年休学创业做家庭智能机器人,到2020 年开始第二次创业做 AI agent for Gaming,曾基于 GPT-2 等技术,在 ChatGPT 推出前实现“斯坦福小镇”等创新游戏模式,目前在做的是 AI 互动的小说故事创作,也就是今天的 MidReal。

随着大模型研究的深入,如何将其推广到更多的模态上已经成为了学术界和产业界的热点。最近发布的闭源大模型如 GPT-4o、Claude 3.5 等都已经具备了超强的图像理解能力,LLaVA-NeXT、MiniCPM、InternVL 等开源领域模型也展现出了越来越接近闭源的性能。

当一家人工智能公司的首席执行官更像是计算机科学家而不是推销员时,我感觉更舒服