DeepSeek被传从外部筹资,相关人士称融资消息均为谣言

DeepSeek被传从外部筹资,相关人士称融资消息均为谣言2月19日晚间,据科技媒体The Information报道,DeepSeek正在考虑首次外部融资。知情人士透露,DeepSeek内部已经开始讨论是否接受外部融资,以获取更多的AI芯片和服务器资源。

2月19日晚间,据科技媒体The Information报道,DeepSeek正在考虑首次外部融资。知情人士透露,DeepSeek内部已经开始讨论是否接受外部融资,以获取更多的AI芯片和服务器资源。

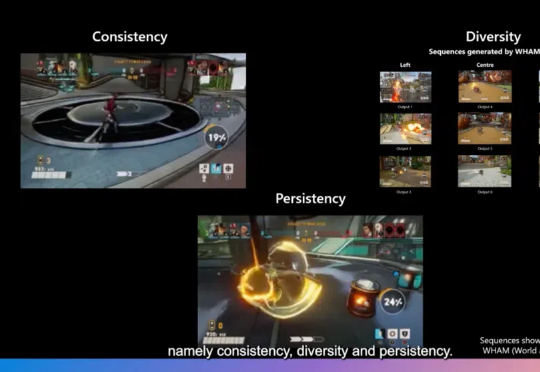

游戏开发不仅需要生成新颖的内容,更需要在保持游戏世界一致性、多样性和用户修改持续性方面达到高度平衡。近日,一篇发表在Nature上的研究论文World and Human Action Models towards Gameplay Ideation揭示了如何利用生成式AI模型推动游戏玩法创意的生成。

OpenAI前CTO Murati离职后,终于官宣新动向!她创立的「思考机器实验室」汇聚了OpenAI、谷歌DeepMind等顶尖AI人才,包括OpenAI联合创始人Schulman、前安全副总Lilian Weng等。

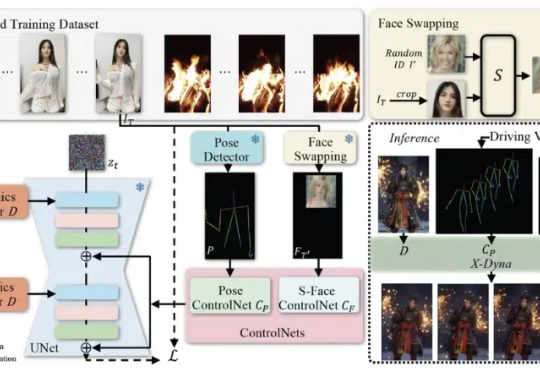

在当下的技术领域中,人像视频生成(Human-Video-Animation)作为一个备受瞩目的研究方向,正不断取得新的进展。人像视频生成 (Human-Video-Animation) 是指从某人物的视频中获取肢体动作和面部表情序列,来驱动其他人物个体的参考图像来生成视频。

先是三星宣布智谱的Agentic GLM成为其新手机Galaxy S25的AI能力来源,紧接着The Information爆料,在经历了近一年的模型测试与合作伙伴探索后,苹果终于敲定了中国市场的合作伙伴:阿里巴巴。这意味着,中国iPhone用户很可能在今年迎来一个由国产大模型驱动的iPhone。

DreamTech,由牛津大学、南京大学等顶尖高校研究者组成的AI创业团队,在春节期间公布了他们在3D生成方向上的新工作成果——Neural4D 2.0(初版名为Direct3D),提出了创新性的3D Assembly Generation算法思路及更高效的模型架构

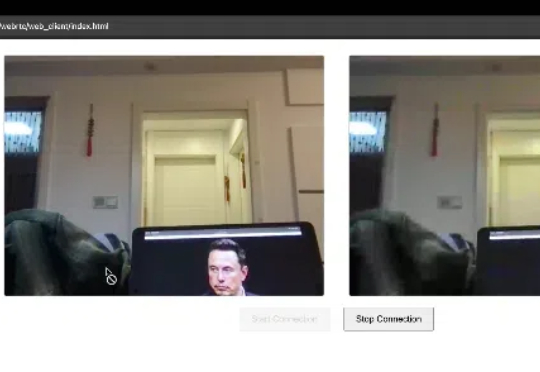

WebRTC(Web Real-Time Communication)是一个Google开源项目,允许浏览器/移动端直接进行实时音视频流传输,典型应用场景:视频会议、屏幕共享、文件传输、远程控制。

DeepSeek震动硅谷,其高性价比的训练技术引发了市场的广泛关注。在最新发布的研报中,花旗分析师Atif Malik、Asiya Merchant等详细分析了DeepSeek对AI基建产业链各环节的潜在影响,揭示了哪些环节将受益,哪些环节可能面临挑战。

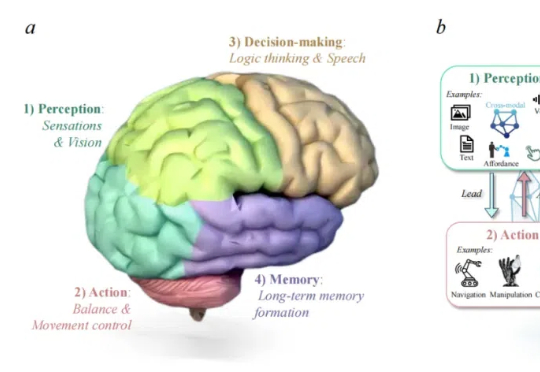

由港科广、中南、西湖大学、UIUC、新加坡国立大学、上海 AI Lab、宾夕法尼亚大学等团队联合发布的首篇聚焦医疗领域具身智能的综述论文《A Survey of Embodied AI in Healthcare: Techniques, Applications, and Opportunities》正式上线,中南大学刘艺灏为第一作者

OpenAI 在 “双十二” 发布会的最后一天公开了 o 系列背后的对齐方法 - deliberative alignment,展示了通过系统 2 的慢思考能力提升模型安全性的可行性。