Bengio亲手戳穿CoT神话!LLM推理是假象,25%顶会论文遭打脸

Bengio亲手戳穿CoT神话!LLM推理是假象,25%顶会论文遭打脸原来,CoT推理竟是假象!Bengio带队最新论文戳穿了CoT神话——我们所看到的推理步骤,并非是真实的。不仅如此,LLM在推理时会悄然纠正错误,却在CoT中只字未提。

原来,CoT推理竟是假象!Bengio带队最新论文戳穿了CoT神话——我们所看到的推理步骤,并非是真实的。不仅如此,LLM在推理时会悄然纠正错误,却在CoT中只字未提。

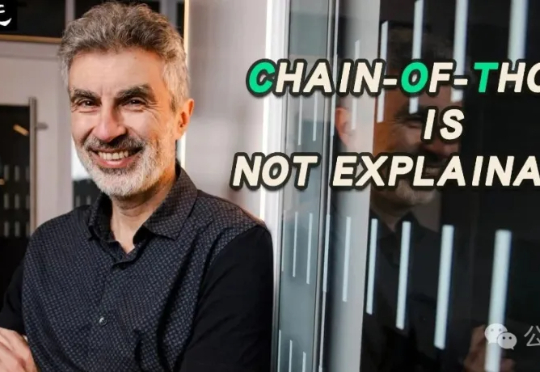

AI音效已经进化成这样了吗??

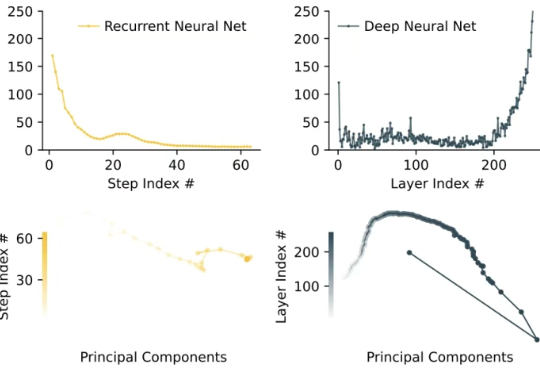

像人一样推理。 大模型的架构,到了需要变革的时候? 在对复杂任务的推理工作上,当前的大语言模型(LLM)主要采用思维链(CoT)技术,但这些技术存在任务分解复杂、数据需求大以及高延迟等问题。

大语言模型(LLMs)在决策场景中常因贪婪性、频率偏差和知行差距表现欠佳。研究者提出强化学习微调(RLFT),通过自我生成的推理链(CoT)优化模型,提升决策能力。实验表明,RLFT可增加模型探索性,缩小知行差距,但探索策略仍有改进空间。

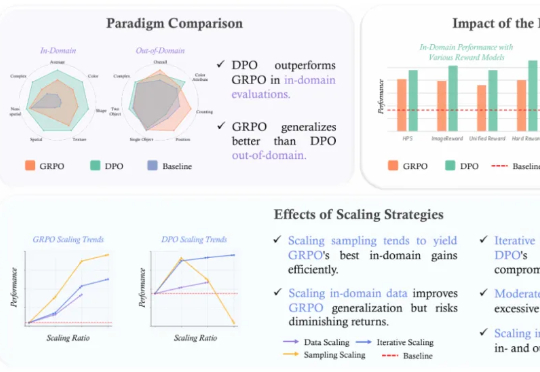

近年来,强化学习 (RL) 在提升大型语言模型 (LLM) 的链式思考 (CoT) 推理能力方面展现出巨大潜力,其中直接偏好优化 (DPO) 和组相对策略优化 (GRPO) 是两大主流算法。

在生成式 AI 迅猛演进的时代浪潮中,Cognition AI 正成为硅谷最受瞩目的技术公司之一。而其背后,是一位横跨数学竞赛、工程实践与系统构建的 90 后创始人——Scott Wu。

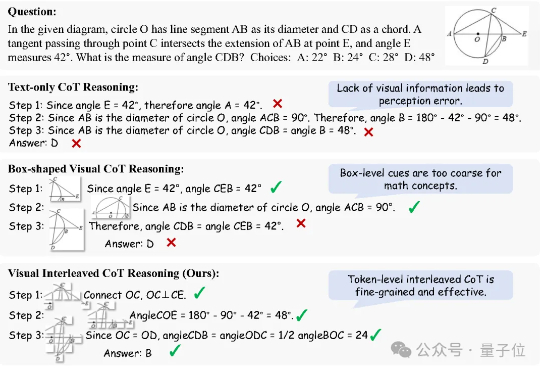

思维链(Chain of Thought, CoT)推理方法已被证明能够显著提升大语言模型(LLMs)在复杂任务中的表现。而在多模态大语言模型(MLLMs)中,CoT 同样展现出了巨大潜力。

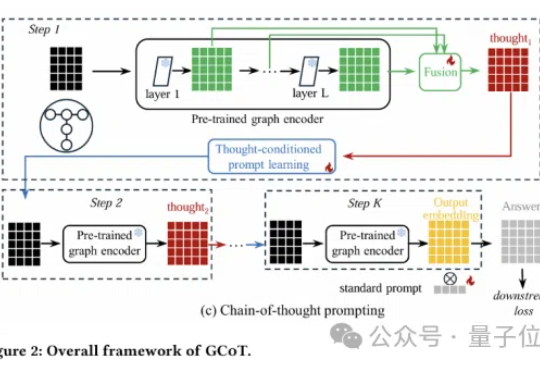

图神经网络还能更聪明?思维链提示学习来了!

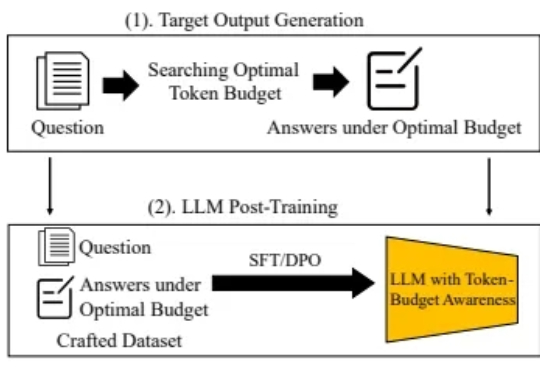

随着大型语言模型(LLM)技术的不断发展,Chain-of-Thought(CoT) 等推理增强方法被提出,以期提升模型在数学题解、逻辑问答等复杂任务中的表现,并通过引导模型逐步思考,有效提高了模型准确率。

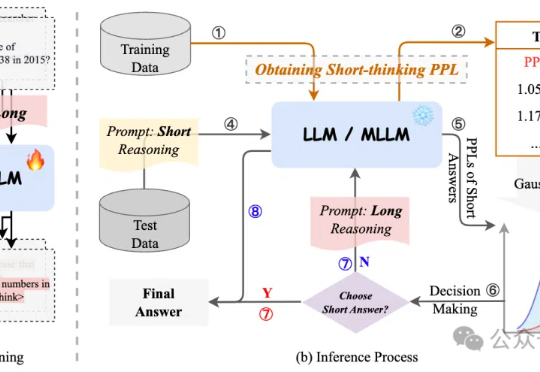

过度依赖CoT思维链推理会降低模型性能,有新解了! 来自字节、复旦大学的研究人员提出自适应推理框架CAR,能根据模型困惑度动态选择短回答或详细的长文本推理,最终实现了准确性与效率的最佳平衡。