真香预警!TRAE SOLO中国版上线,全部功能免费

真香预警!TRAE SOLO中国版上线,全部功能免费TRAE国内版终于上线SOLO模式了,且全部功能完全免费!一口气带来了SOLO Coder、Plan模式、多任务并行等多个核心能力。

TRAE国内版终于上线SOLO模式了,且全部功能完全免费!一口气带来了SOLO Coder、Plan模式、多任务并行等多个核心能力。

上上周四,我去杭州给一家企业做了一场AI编程培训,内容是 Claude Code。

前沿AI竞赛在2025年11月达到高潮。48小时内,谷歌推出Gemini 3 Pro宣称在主要推理基准测试中领先,而OpenAI立即用GPT-5.1-Codex-Max反击,这是一款专门训练用于通过创新"压缩"(compaction)技术自主工作超过24小时的专业编码模型[43]。加上Claude Sonnet 4.5已确立的编码统治地位和激进的安全过滤器,开发者面临前所未有的选择:

Gemini 3力压全场,OpenAI坐不住了。发布Codex新版本——GPT-5.1-Codex-Max,突破上下文窗口限制,实现跨越数百万token的长时间连续工作,最长超过24小时的那种。

AI圈一日一更的频率,真的是有点跟不住了....前两天,先是Grok 4.1、Gemini 3 Pro发布,今天OpenAI GPT-5.1 Pro也静默登场了! 众所周知,GPT-5.1主打「情商智商」双强,Pro无疑将这两大优势推向更高层次。

最近,小编注意到一位全栈工程师 Rohith Singh 在Reddit上发表了一篇帖子,介绍他如何对四个模型(Kimi K2 Thinking、Sonnet 4.5、GPT-5 Codex 和 GPT-5.1 Codex)进行了实测。

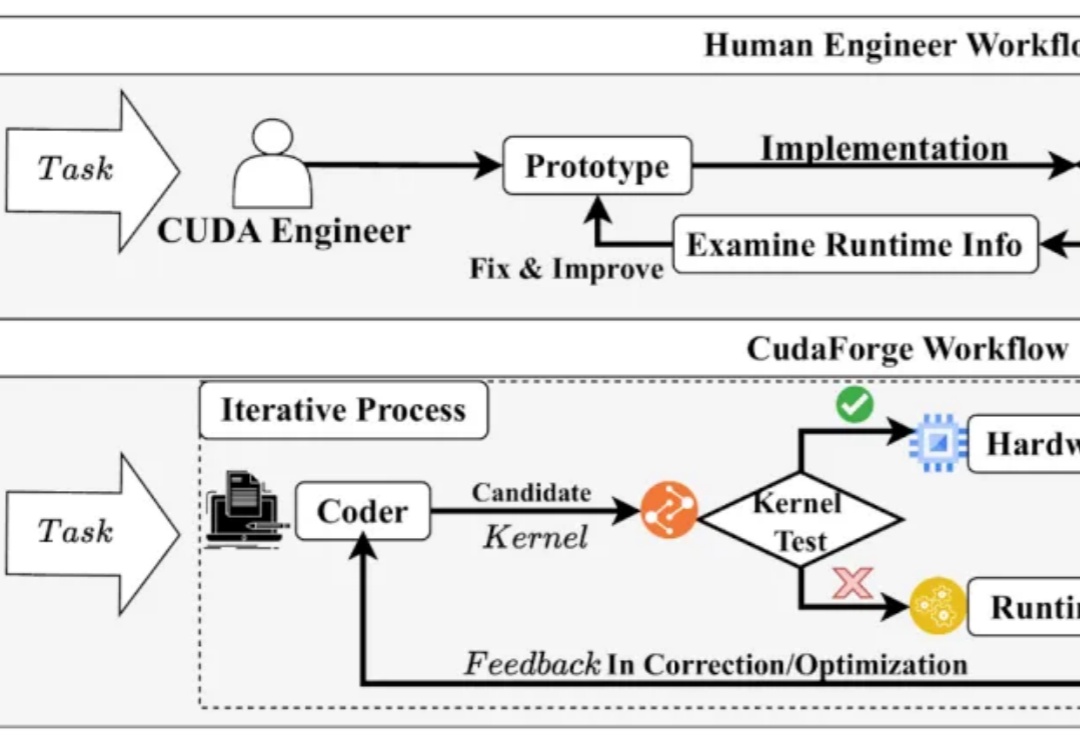

CUDA 代码的性能对于当今的模型训练与推理至关重要,然而手动编写优化 CUDA Kernel 需要很高的知识门槛和时间成本。与此同时,近年来 LLM 在 Code 领域获得了诸多成功。

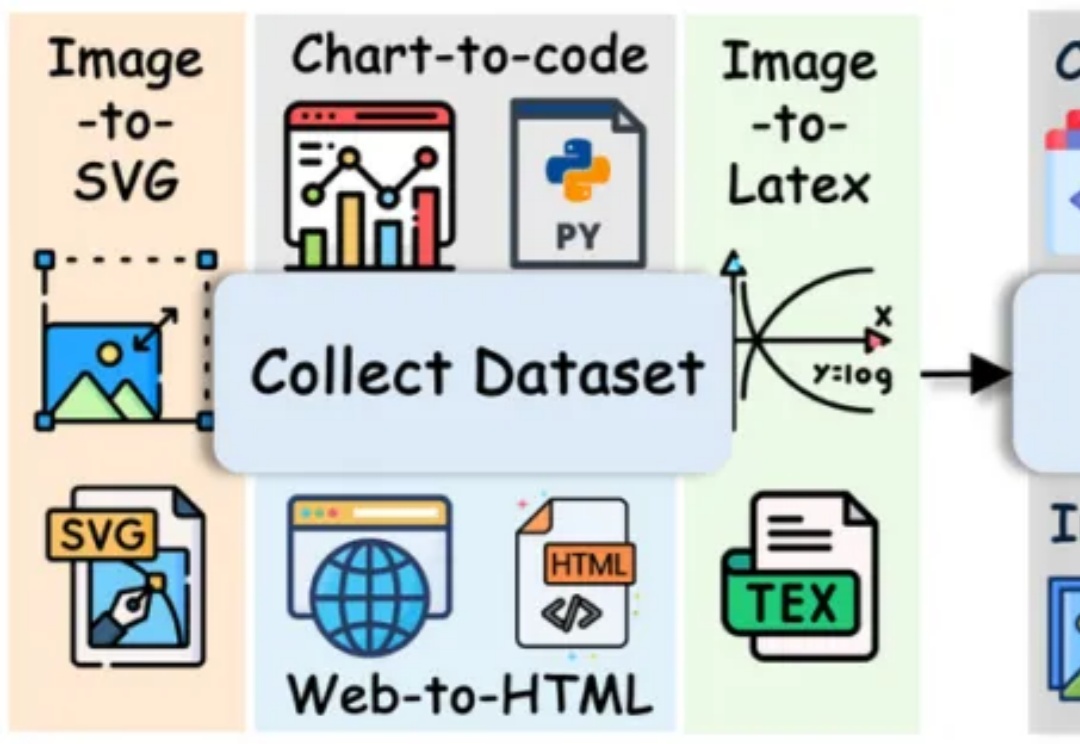

长期以来,多模态代码生成(Multimodal Code Generation)的训练严重依赖于特定任务的监督微调(SFT)。尽管这种范式在 Chart-to-code 等单一任务上取得了显著成功 ,但其 “狭隘的训练范围” 从根本上限制了模型的泛化能力,阻碍了通用视觉代码智能(Generalized VIsioN Code Intelligence)的发展 。

大模型编程最近太猛了。

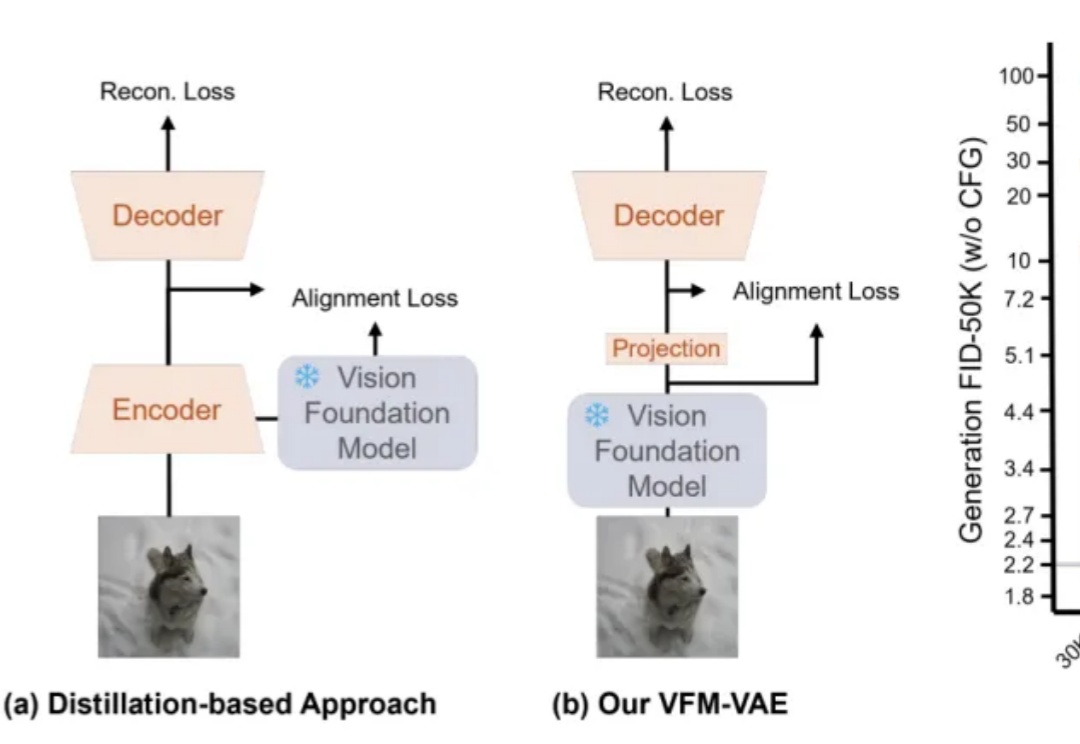

近期,RAE(Diffusion Transformers with Representation Autoencoders)提出以「 冻结的预训练视觉表征」直接作为潜空间,以显著提升扩散模型的生成性能。