毫无征兆!DeepSeek R1爆更86页论文,这才是真正的Open

毫无征兆!DeepSeek R1爆更86页论文,这才是真正的Open两天前,DeepSeek悄无声息地把R1的论文更新了,从原来22页「膨胀」到86页。DeepSeek向世界证明:开源不仅能追平闭源,还能教闭源做事!

两天前,DeepSeek悄无声息地把R1的论文更新了,从原来22页「膨胀」到86页。DeepSeek向世界证明:开源不仅能追平闭源,还能教闭源做事!

近日消息,在拉斯维加斯举行的 CES 2026 上,波士顿动力与谷歌 DeepMind 宣布达成一项全新的 AI 合作伙伴关系,旨在为人形机器人开启一个全新的人工智能时代。

CES巨幕上,老黄的PPT已成中国AI的「封神榜」。DeepSeek与Kimi位列C位之时,算力新时代已至。

DeepSeek-OCR的视觉文本压缩(VTC)技术通过将文本编码为视觉Token,实现高达10倍的压缩率,大幅降低大模型处理长文本的成本。但是,视觉语言模型能否理解压缩后的高密度信息?中科院自动化所等推出VTCBench基准测试,评估模型在视觉空间中的认知极限,包括信息检索、关联推理和长期记忆三大任务。

零成本降低大模型幻觉新方法,让DeepSeek准确率提升51%!

2026年新年第一天,DeepSeek又开卷了。

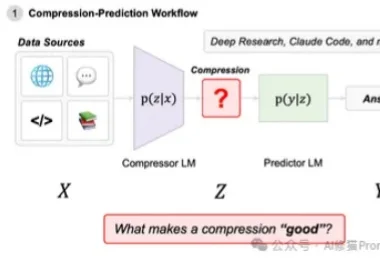

在近一年里,Agentic System(代理系统/智能体系统)正变得无处不在。从Open AI的Deep Research到Claude Code,我们看到越来越多的系统不再依赖单一模型,而是通过多模型协作来完成复杂的长窗口任务。

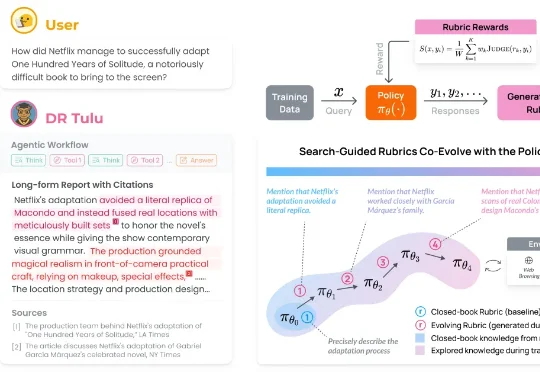

近日,美国华盛顿大学博士生邵如琳和合作团队打造出一个名为 Deep Research Tulu(DR Tulu)的深度研究小助手。使用一次 OpenAI 的 Deep Research 服务可能需要大约 1.8 美元,而 DR Tulu 使用一次的成本却不到 0.002 美元,这几乎是千倍的效率提升,这意味着未来个人或者小团队也能负担得起高质量、高可信度的 AI 研究服务。

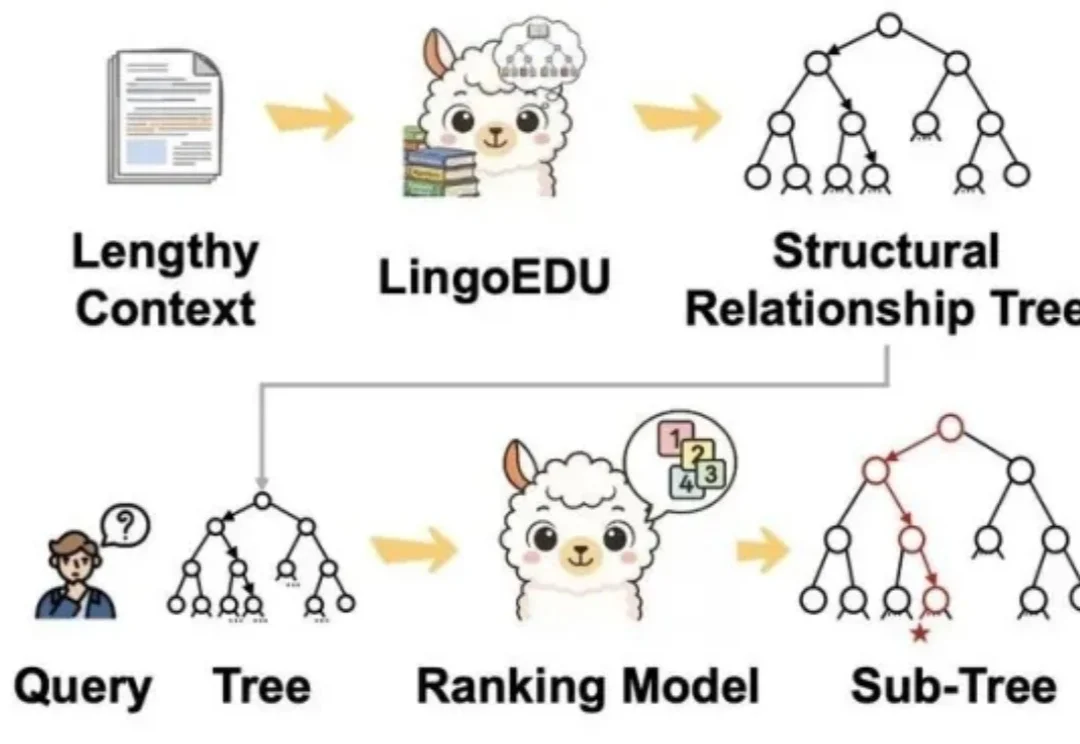

近年来,大模型的应用正从对话与创意写作,走向更加开放、复杂的研究型问题。尽管以检索增强生成(RAG)为代表的方法缓解了知识获取瓶颈,但其静态的 “一次检索 + 一次生成” 范式,难以支撑多步推理与长期

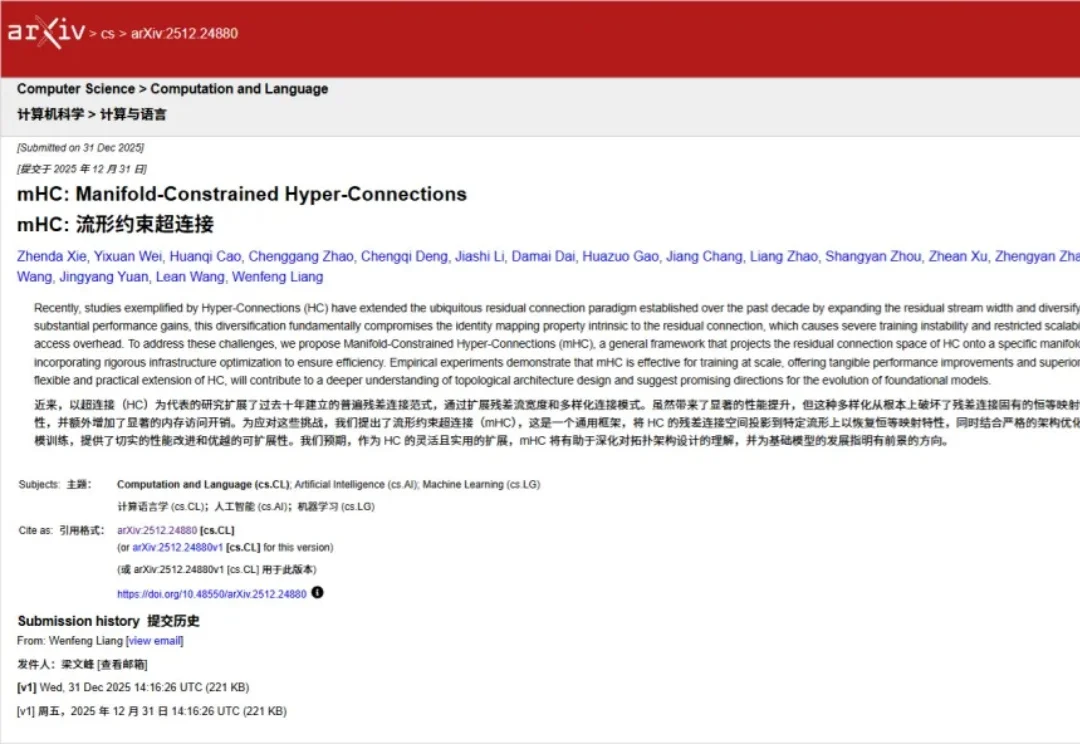

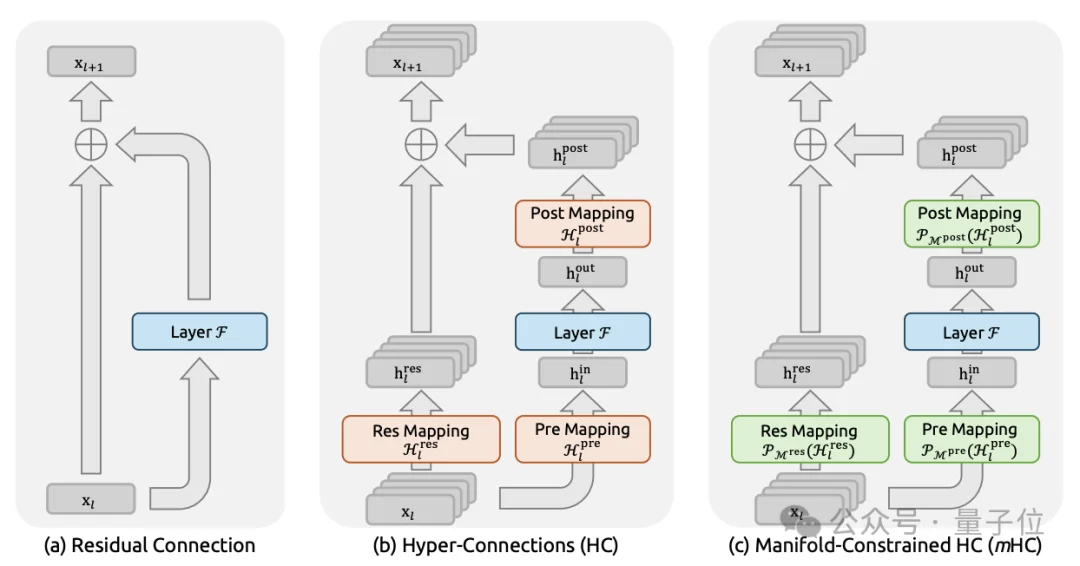

2026年新年第一天,DeepSeek上传新论文。给何恺明2016成名作ResNet中提出的深度学习基础组件“残差连接”来了一场新时代的升级。残差连接自2016年ResNet问世以来,一直是深度学习架构的基石。