扩散语言模型九倍推理加速!上海交大:KV Cache并非自回归模型的专属技巧

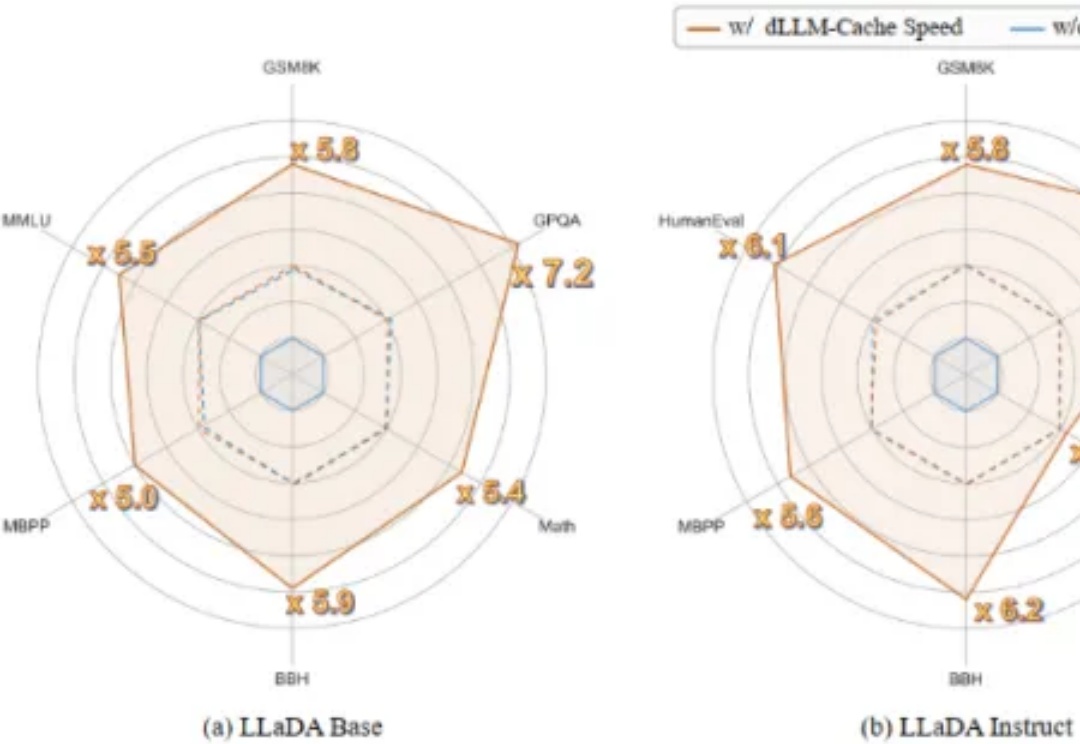

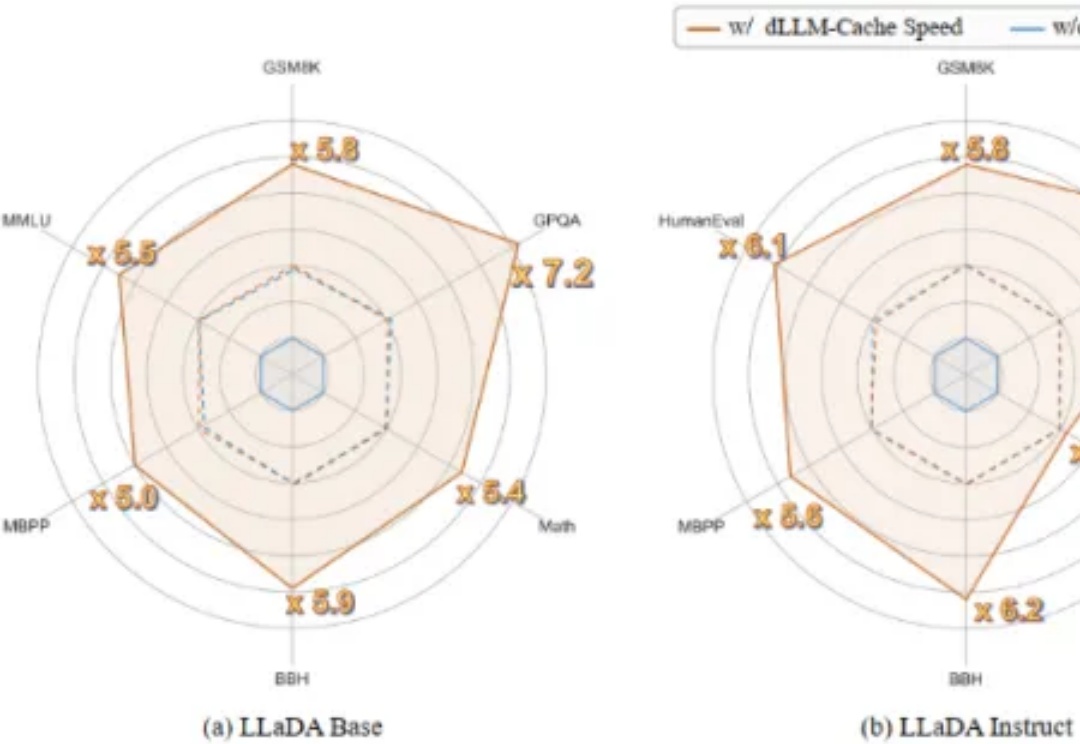

扩散语言模型九倍推理加速!上海交大:KV Cache并非自回归模型的专属技巧首个用于加速扩散式大语言模型(diffusion-based Large Language Models, 简称 dLLMs)推理过程的免训练方法。

首个用于加速扩散式大语言模型(diffusion-based Large Language Models, 简称 dLLMs)推理过程的免训练方法。

1986年,图灵奖得主Fred Brooks在软件工程领域提出了著名的"没有银弹"理论:没有任何一种技术或方法能够独自带来软件工程生产力的数量级提升。近四十年后,这个深刻洞察在AI领域再次得到验证——你是否也曾经历过这样的挫折:

最近,AI 在数学和编程上的能力飞跃令人瞠目结舌 —— 在不少任务上,它已经悄然超越了我们大多数人类。而当它面对真正的专家,会发生什么?

MedGemma是谷歌 “健康人工智能开发者基础”(Health AI Developer Foundations)计划的核心项目。基于 Gemma 3 架构, MedGemma提供多模态和纯文本两种模型变体,旨在降低医疗 AI 开发门槛。

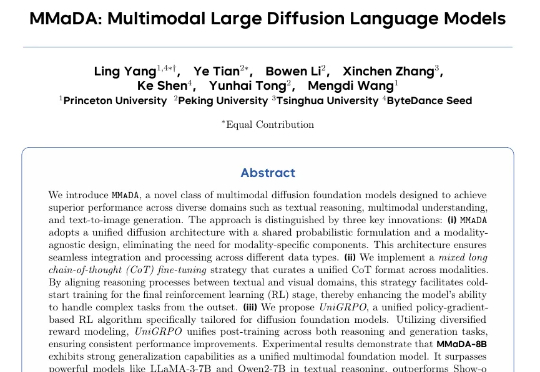

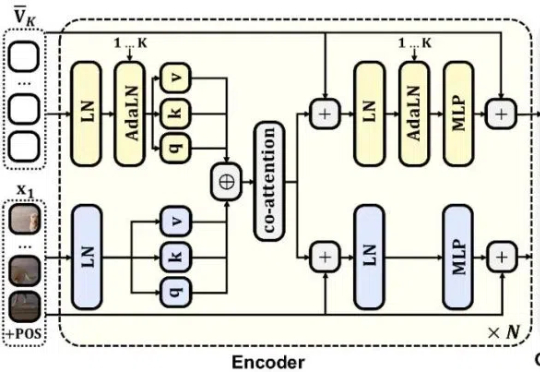

普林斯顿大学与字节 Seed、北大、清华等研究团队合作提出了 MMaDA(Multimodal Large Diffusion Language Models),作为首个系统性探索扩散架构的多模态基础模型,MMaDA 通过三项核心技术突破,成功实现了文本推理、多模态理解与图像生成的统一建模。

如果用一句话为 2025 年写下注脚,那它不会是某个技术名词,而更像是一种哲学上的转变:“这一年,我们不再是孤立地使用软件,而是与智能的代理人(Agent)共舞,它们正悄然重塑我们的工作与生活。”

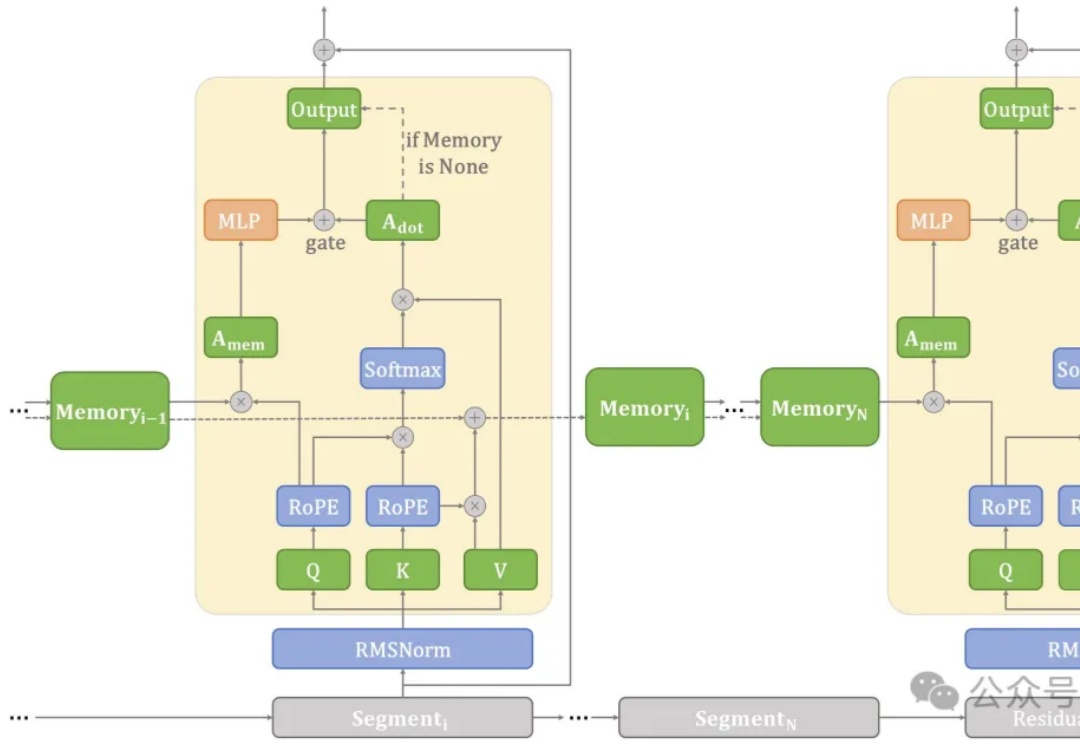

在端侧设备上处理长文本常常面临计算和内存瓶颈。

自回归(AR)范式凭借将语言转化为离散 token 的核心技术,在大语言模型领域大获成功 —— 从 GPT-3 到 GPT-4o,「next-token prediction」以简单粗暴的因果建模横扫语言领域。

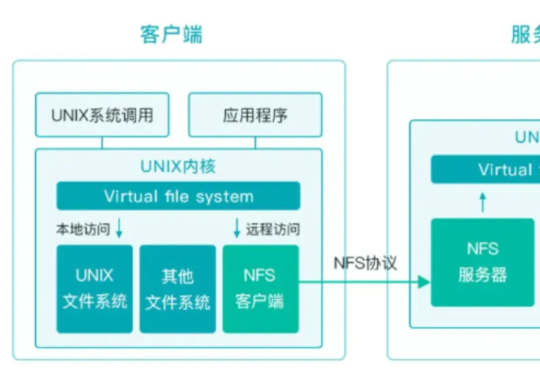

经过对多种开源存储系统的评估对比,我们选择了 JuiceFS 。我们的架构采用 Redis 进行高性能元数据管理,同时构建了自有 MinIO 集群作为底层对象存储,这一架构完美解决了模型训练场景中的数据读写瓶颈、元数据访问延迟以及计算资源之间的存储互通问题。

前谷歌 CEO&董事长 Eric Schmidt 近日在 TED 上表示, AI 被严重低估了,它不仅是语言工具,而是未来战略规划、科学发现乃至国家安全与地缘政治格局的核心力量。