OpenAI最新技术报告:GPT-4o变谄媚的原因万万没想到

OpenAI最新技术报告:GPT-4o变谄媚的原因万万没想到GPT-4o更新后“变谄媚”?后续技术报告来了。

GPT-4o更新后“变谄媚”?后续技术报告来了。

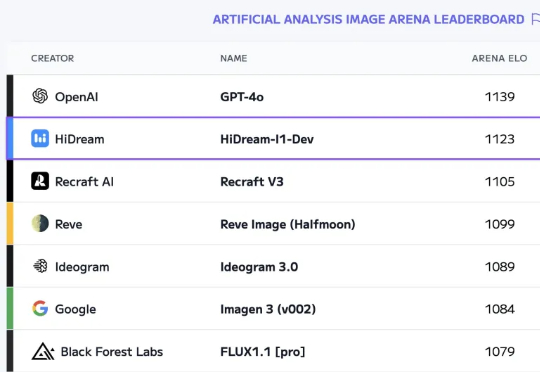

我又发现好东西了!前几天在 Artificial Analysis 上发现了一个新模型:17B 参数的国产模型 HiDream-I1排到第二名,和 GPT-4o 得分非常接近!

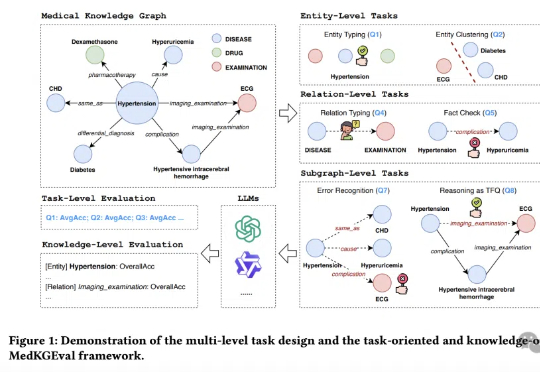

医疗大模型知识覆盖度首次被精准量化!

昨晚,奥特曼在 X 上发了条帖子,大意是由于发现 GPT-4o 「过于谄媚」的问题,所以从周一晚上开始回滚 GPT-4o 的最新更新。

坏了,AI 当「舔狗」这件事藏不住了。今天凌晨,OpenAI CEO Sam Altman 发了一个有趣帖子,大意是:由于最近几轮 GPT-4o 的更新,导致其个性变得过于阿谀奉承,因此官方决定尽快进行修复。

自回归模型,首次生成2048×2048分辨率图像!来自Meta、西北大学、新加坡国立大学等机构的研究人员,专门为多模态大语言模型(MLLMs)设计的TokenShuffle,显著减少了计算中的视觉Token数量,提升效率并支持高分辨率图像合成。

自 OpenAI 发布 chatgpt 以来,业内除了技术公司、媒体公司比较关注其进展以外,还有一个行业比较关注,那就是战略咨询行业。尤其是最近 GPT-4o、Claude 3.7 Sonnet 为代表的最新大模型在数据分析、内容生成、编码和复杂推理方面展现出强大能力,与战略咨询工作的核心环节高度相关 。

GPT-4o又双叒更新了。这一次,在智力和个性方面再次进化,STEM解决能力增强,响应更主动。与此同时,有人曝出它的生图质量大不如前。

视觉AI终极突破来了!英伟达等机构推出超强多模态模型DAM,仅3B参数,就能精准描述图像和视频中的任何细节。刚刚,英伟达联手UC伯克利、UCSF团队祭出首个神级多模态模型——Describe Anything Model(DAM),仅3B参数。

在DeepSeek R1-V3、GPT-4o、Claude-3.7的强势围攻下,Meta坐不住了。曾作为开源之光的Llama在一年的竞争内连连失利,并没有研发出让公众惊艳的功能。创始人扎克伯格下达死命令,今年4月一定要更新。