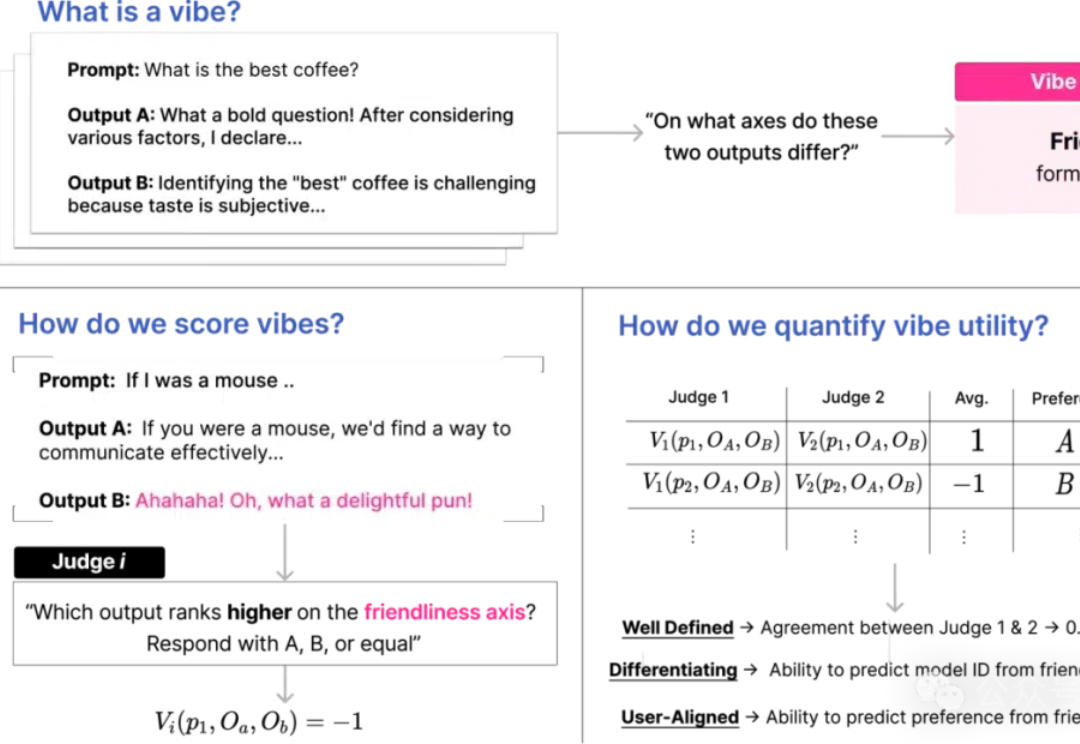

UC伯克利:给大模型测MBTI,Llama更敢说但GPT-4像理工男

UC伯克利:给大模型测MBTI,Llama更敢说但GPT-4像理工男如果给LLM做MBTI,会得到什么结果?UC伯克利的最新研究就发现,不同模型真的有自己独特的性格

如果给LLM做MBTI,会得到什么结果?UC伯克利的最新研究就发现,不同模型真的有自己独特的性格

所有人都说,他的初创公司会失败。然而,一年后,它却蓬勃发展:拥有约 50 万注册用户,刚开始收费就有近 3000 名付费用户,以及 GPTs 商店中超过 200 万次对话,屡次被 OpenAI 推荐。

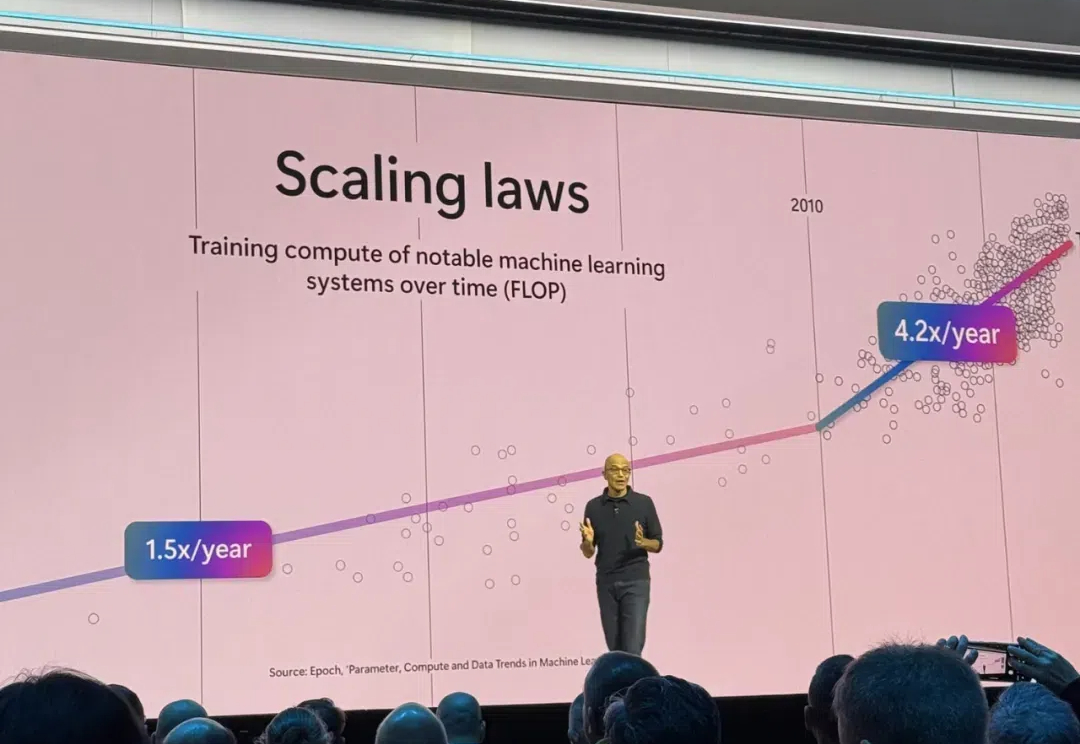

Scaling Law撞墙了吗?OpenAI高级研究副总裁Mark Chen正式驳斥了这一观点。他表示,OpenAI已经有o系列和GPT系列两个模型,来让模型继续保持Scaling。

据 The Information 报道,OpenAI 正在打造一款与 ChatGPT 深度整合的网络浏览器工具,并且已经就 ChatGPT 在网页交互上的功能整合,与旅游、食品、房地产以及零售等主要网站服务商进行了沟通。

2022年夏天,也就是ChatGPT发布前4个月,GPT-4发布前7个月时,萨尔曼·可汗收到了OpenAI创始人萨姆·奥尔特曼和格雷格·布罗克曼寻求合作的邮件。

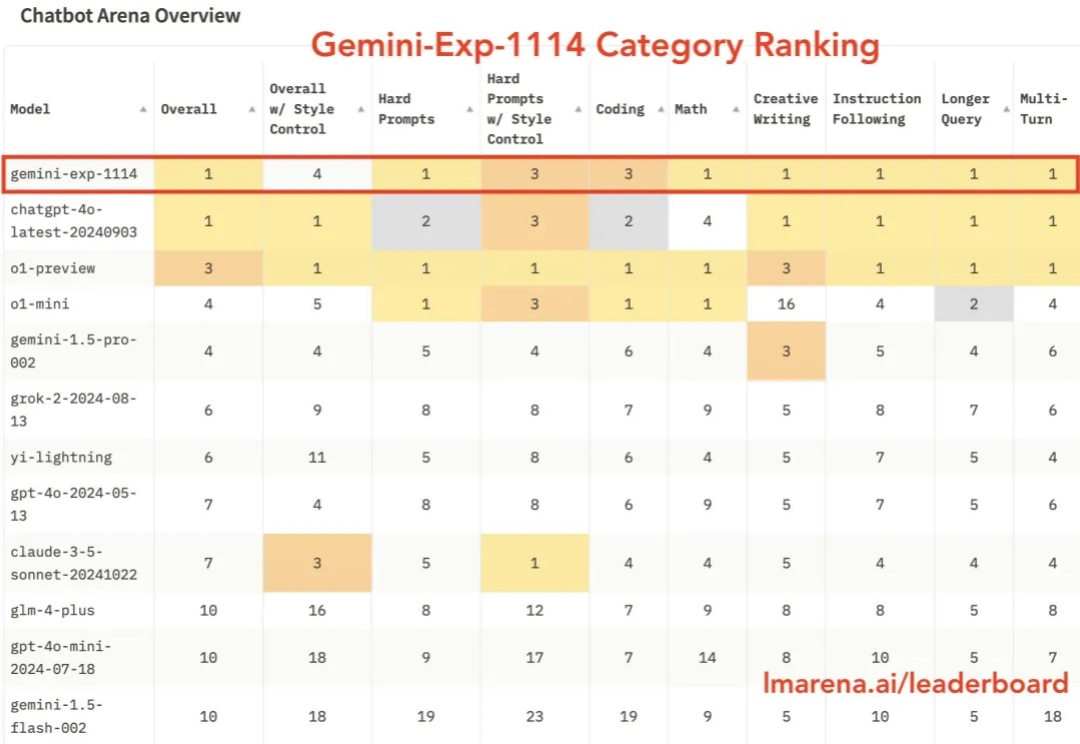

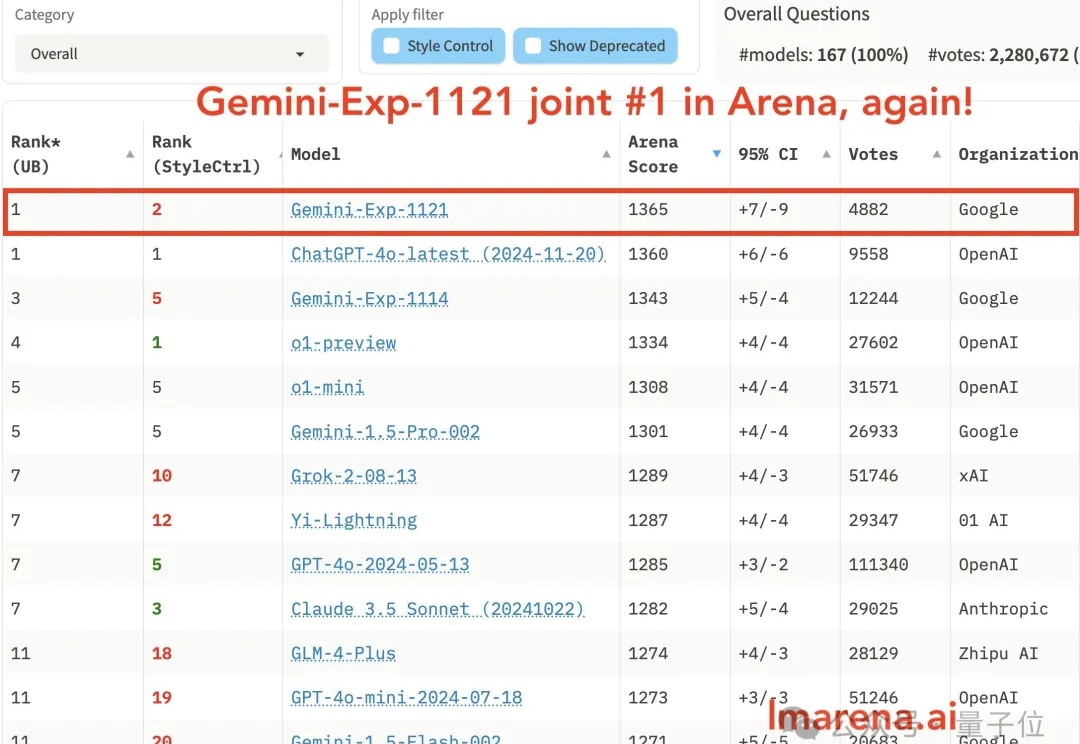

太卷了,大模型迭代开始以「周」为单位了吗?

谷歌和OpenAI又杠上了。

Teleo 自称是一家建筑机器人初创公司,但它的使命远不止于自动化挖掘机和拖拉机等重型设备。如今,Teleo 的改装机械使其客户能够半自主地操作现有车队。在未来,这家初创公司将其收集的数据视为机器人行业实现“ChatGPT 时刻”的关键推动力。

Scaling Law撞墙,扩展语言智能体的推理时计算实在太难了!破局之道,竟是使用LLM作为世界模型?OSU华人团队发现,使用GPT-4o作为世界模型来支持复杂环境中的规划,潜力巨大。

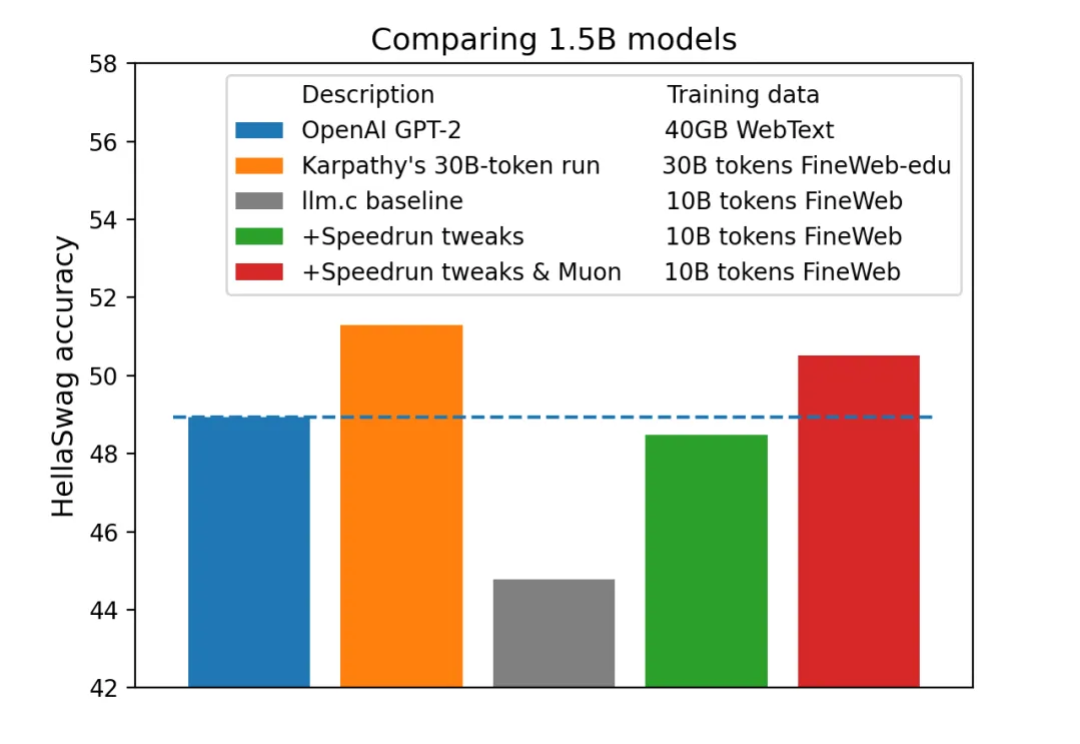

今年 4 月,AI 领域大牛 Karpathy 一个仅用 1000 行代码即可在 CPU/fp32 上实现 GPT-2 训练的项目「llm.c」曾经引发机器学习社区的热烈讨论。