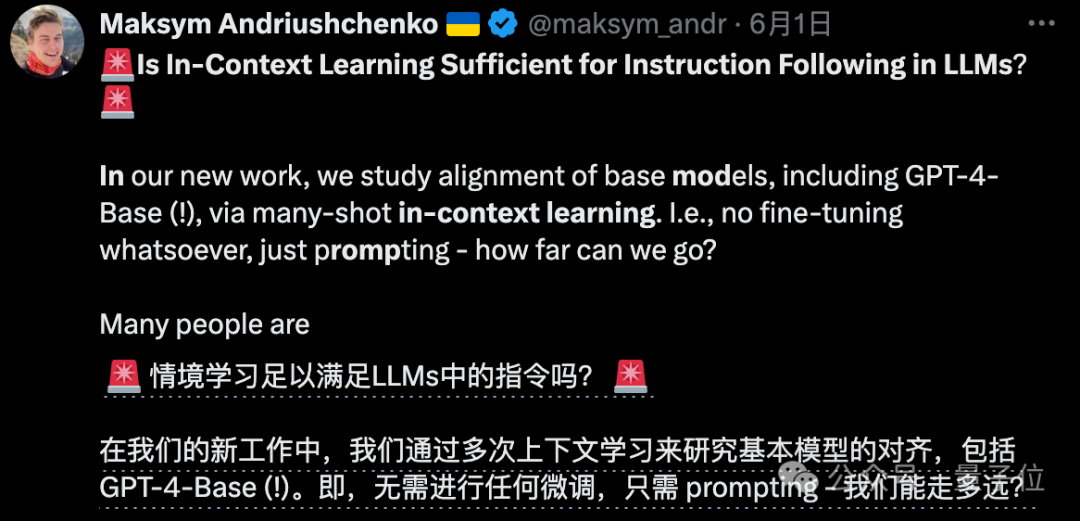

OpenAI把GPT-4原始版给了他们:研究不微调只靠提示词能走多远

OpenAI把GPT-4原始版给了他们:研究不微调只靠提示词能走多远除了OpenAI自己,居然还有别人能用上GPT-4-Base版??

除了OpenAI自己,居然还有别人能用上GPT-4-Base版??

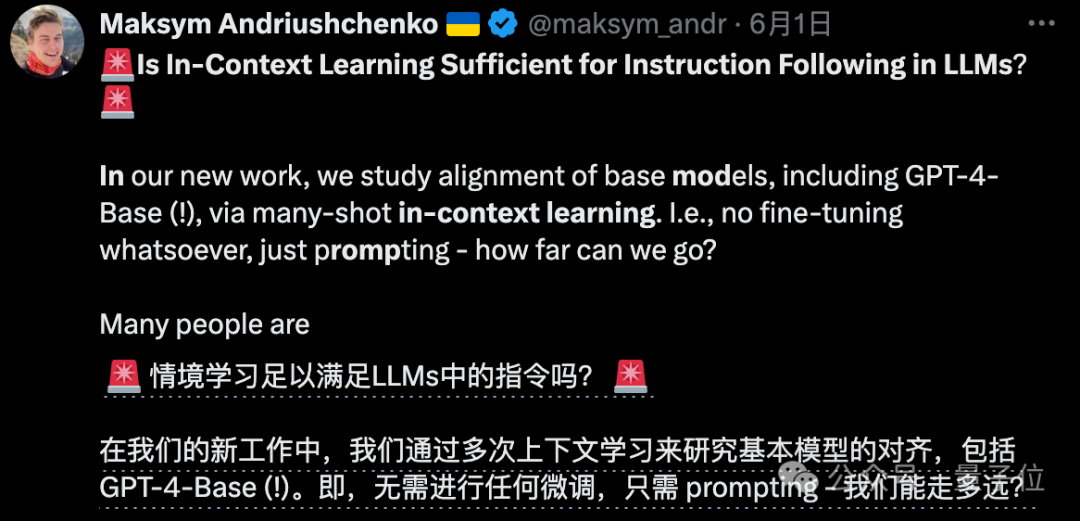

无情戳穿“长上下文”大模型的虚标现象

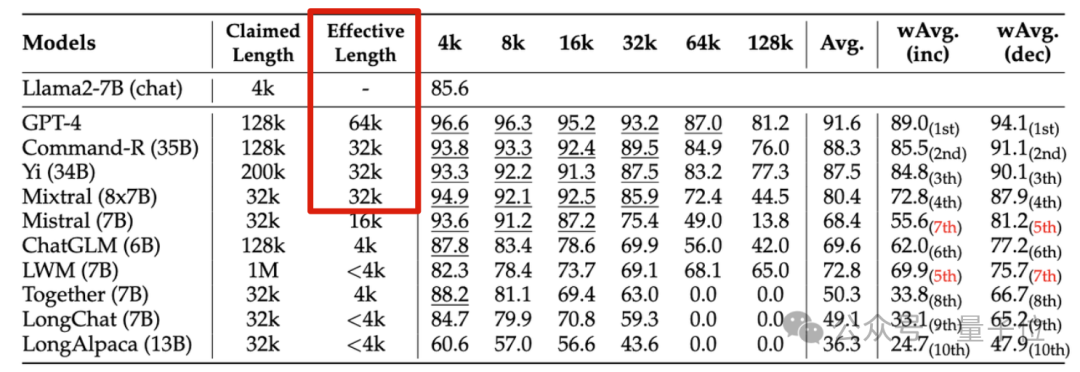

超越Devin!SWEBench排行榜上迎来了新玩家

研究人员提出了一种新的大型语言模型训练方法,通过一次性预测多个未来tokens来提高样本效率和模型性能,在代码和自然语言生成任务上均表现出显著优势,且不会增加训练时间,推理速度还能提升至三倍。

刚刚,老黄又高调向全世界秀了一把:已经量产的Blackwell,8年内将把1.8万亿参数GPT-4的训练能耗狂砍到1/350;英伟达惊人的产品迭代,直接原地冲破摩尔定律;Blackwell的后三代路线图,也一口气被放出。

从2023年开始,全球陆续跑出了一大批AI明星企业,特点是估值涨幅凶猛,融资数额巨大,然而不管是领头羊OpenAI,还是一众新晋独角兽,暂时都在重复移动互联网的故事——未来很长时间一段时间内,将持续面临烧钱、亏损,盈利都不在他们的考虑范围之内。

John Schulman 是 OpenAI 联合创始人、研究科学家(OpenAI 现存最主要具有技术背景的创始人),他领导了 ChatGPT 项目,在 OpenAI 内部长期负责模型 post-traning,在 Ilya 和 Jan Leike 离开 OpenAI 后,下一代模型安全性风险相关的研究也会由 John Schulman 来接替负责。

你期待的是《赛博朋克》,先到来的却是《她》。

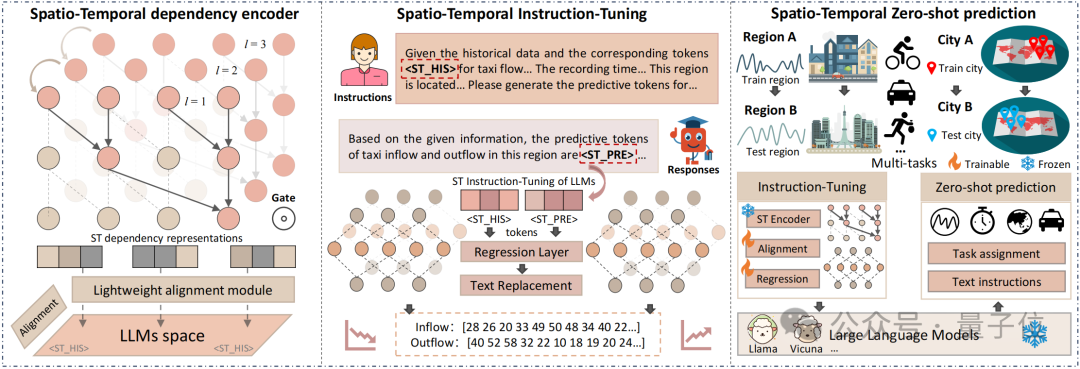

时空预测技术,迎来ChatGPT时刻。

LLM有记忆能力吗?有,也没有。虽然ChatGPT聊天时好像可以记住你之前说的话,但实际上,模型在推理时记不住任何内容,而且它们在训练时的记忆方式也不像我们想象的那么简单。