那个超懂办公方法论的团队,公开了内部AI办公秘籍

那个超懂办公方法论的团队,公开了内部AI办公秘籍ChatGPT到Sora,AI都热闹一年多了,但眼前狂刷存在感、展示自家AI落地姿态的,更更更更更多了。

ChatGPT到Sora,AI都热闹一年多了,但眼前狂刷存在感、展示自家AI落地姿态的,更更更更更多了。

什么?谷歌成功偷家OpenAI,还窃取到了gpt-3.5-turbo关键信息???

这篇文章介绍了实验结果显示,AI在简历筛选中存在歧视现象。通过测试ChatGPT和GPT4,发现它们对不同背景和人群有偏爱或歧视。文章提出了求职者可以适应AI喜好的方法,以应对算法歧视。

ChatGPT居然这么费电?

微软亚研院等发布bGPT,仍旧基于Transformer,但是模型预测的是下一个字节(byte)。

突然间,AGI已经成为了一个新的「5年内实现」的未来技术。从Altman到老黄,都在不同场合表示,达到人类智能水平的AI将很快到来。而技术路径和未来可能出现的能源短缺,可能是达到AGI过程中的最大变数。

拥抱新技术红利,抢占AI大模型先机?

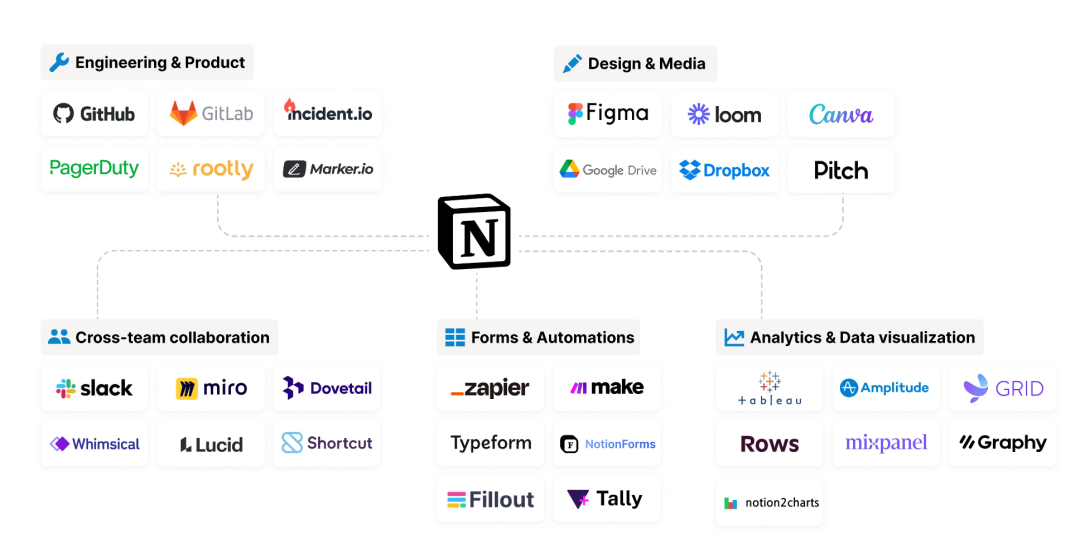

Notion 是生产力工具领域 AI 策略最为激进的一家公司:在 ChatGPT 推出 2 个月后,Notion 就宣布推出 Notion AI,将 GenAI 的体验直接融入到产品,并根据不同需求和场景预设了 prompt,用户只需要空格或“/”即可调用 GPT。

当OepnAI和马斯克连日互杠、Google因文化偏见麻烦缠身、号称抢走GPT-4王位的Claude 3全力瞄准企业级部署的时候,在另一个角落,致力于「为每个人开发服务型AI」的人工智能初创公司Inflection AI,悄悄更新了他们的聊天机器人Pi,以及为之提供支持的新一代大模型Inflection-2.5。

荷兰数据科学家Alex de Vries告诉媒体,他发现人工智能可能具有与加密货币相当的耗电能力,并认为有必要提醒人们“AI也是能源密集型技术”。