一条磁力链爆全网,Mixtral 8x7B论文来了!碾压Llama 2 70B,每token仅需激活13B参数

一条磁力链爆全网,Mixtral 8x7B论文来了!碾压Llama 2 70B,每token仅需激活13B参数爆火社区的Mixtral 8x7B模型,今天终于放出了arXiv论文!所有模型细节全部公开了。

爆火社区的Mixtral 8x7B模型,今天终于放出了arXiv论文!所有模型细节全部公开了。

无需微调,只要四行代码就能让大模型窗口长度暴增,最高可增加3倍!而且是“即插即用”,理论上可以适配任意大模型,目前已在Mistral和Llama2上试验成功。

Vista-LLaMA 在处理长视频内容方面的显著优势,为视频分析领域带来了新的解决框架。

当大家都在研究大模型(LLM)参数规模达到百亿甚至千亿级别的同时,小巧且兼具高性能的小模型开始受到研究者的关注。

华为盘古系列,带来架构层面上新!量子位获悉,华为诺亚方舟实验室等联合推出新型大语言模型架构:盘古-π。

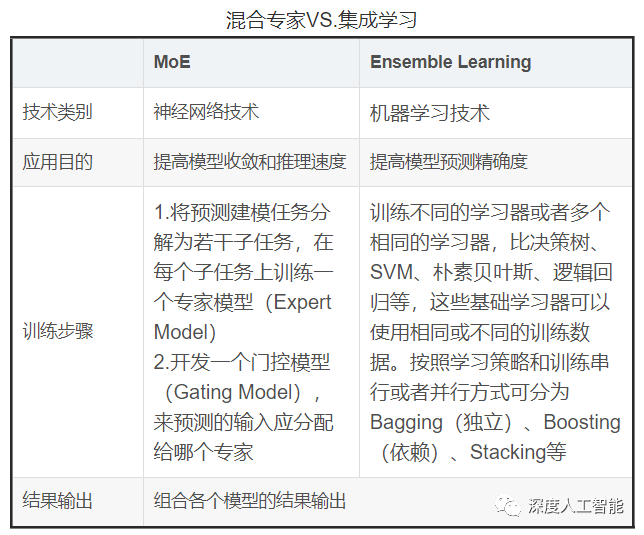

混合专家模型(MoE)成为最近关注的热点。

大模型打开AI新世界,Vision Pro引领空间计算,智能电车超越油车,拼多多“新王”已立,智能手机狂卷创新,新硬件层出不穷,鸿蒙系统加速壮大,AI芯片驱动万物……2023年,科技产业发生了太多重大事件。

据外媒 12 月 20 日消息,由华人创立的 AI 公司 rabbit 又获得了一笔千万美元的融资,这是他们近 2 个月所获得的第 3 笔融资。

都快到年底了,大模型领域还在卷,今天,Microsoft发布了参数量为2.7B的Phi-2——不仅13B参数以内没有对手,甚至还能和Llama 70B掰手腕!

一条神秘磁力链接引爆整个AI圈,现在,正式测评结果终于来了:首个开源MoE大模型Mixtral 8x7B,已经达到甚至超越了Llama 2 70B和GPT-3.5的水平。