LIama 4发布重夺开源第一!DeepSeek同等代码能力但参数减一半,一张H100就能跑,还有两万亿参数超大杯

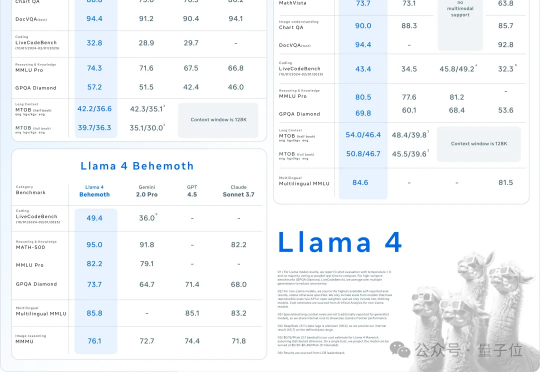

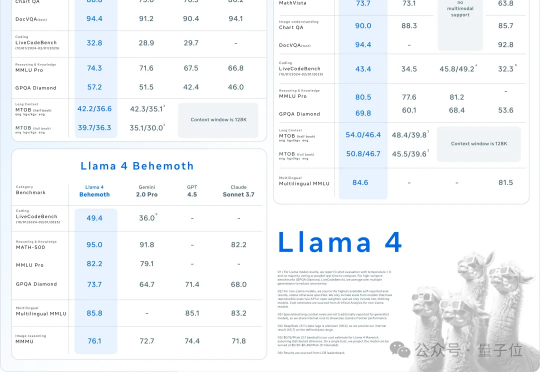

LIama 4发布重夺开源第一!DeepSeek同等代码能力但参数减一半,一张H100就能跑,还有两万亿参数超大杯AI不过周末,硅谷也是如此。大周日的,Llama家族上新,一群LIama 4就这么突然发布了。这是Meta首个基于MoE架构模型系列,目前共有三个款:Llama 4 Scout、Llama 4 Maverick、Llama 4 Behemoth。

AI不过周末,硅谷也是如此。大周日的,Llama家族上新,一群LIama 4就这么突然发布了。这是Meta首个基于MoE架构模型系列,目前共有三个款:Llama 4 Scout、Llama 4 Maverick、Llama 4 Behemoth。

刚刚,奥特曼接连抛出重磅消息:GPT-5不仅将免费开放,还将整合多项尖端技术。o3和o4-mini即将在几周内亮相,还有一个神秘的开源推理模型要来。然而,另一边Meta的Llama 4却因性能瓶颈屡次延期,AI竞赛的格局愈发扑朔迷离。

Meta AI研究副总裁Pineau亲自发帖声称将于5月30日离职,她主导了Llama开源系列及PyTorch项目。此举正逢扎克伯格重金投入AI及LlamaCon AI大会前夕,引发业内对Meta战略调整和未来新作的诸多猜测。

最近,AI 公司 Databricks 推出了一种新的调优方法 TAO,只需要输入数据,无需标注数据即可完成。更令人惊喜的是,TAO 在性能上甚至超过了基于标注数据的监督微调。

家人们震惊了!现在 AI 成精啦,不仅能写能画,现在连唱功都是格莱美级的了!

本文介绍了当前最受科研人员青睐的AI模型,推理出色的o3-mini、全能型DeepSeek-R1、科研常用的Llama、编程利器Claude 3.5 Sonnet和开源明星Olmo 2,它们各有优劣,为科研人员提供了多样选择。

在 2024 年七月的一篇博客文章中,Meta CEO 马克·扎克伯格表示,“出售访问权限”给 Meta 公开可用的 Llama AI 模型“不是 Meta 的商业模式。”

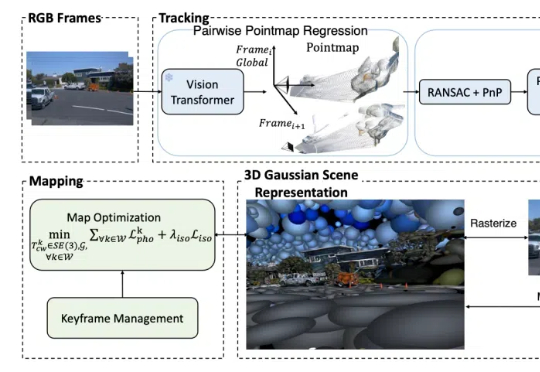

从自动驾驶、机器人导航,到AR/VR等前沿应用,SLAM都是离不开的核心技术之一。

Meta此举,或是要证明他们大规模投资AI基础设施不是在蛮干。

马克·扎克伯格今年正在提升 Meta 人工智能的语音功能,准备从这项快速发展技术中创收。