LLM的Prompt竟然是图灵完备的?LLM提示范式的第一个研究 | 重磅

LLM的Prompt竟然是图灵完备的?LLM提示范式的第一个研究 | 重磅近日,伊利诺伊大学香槟分校的研究团队发布了一篇开创性论文,首次从理论层面证明了大语言模型(LLM)中的prompt机制具有图灵完备性。这意味着,通过合适的prompt设计,一个固定大小的Transformer模型理论上可以计算任何可计算函数。这一突破性发现为prompt工程提供了坚实的理论基础。

近日,伊利诺伊大学香槟分校的研究团队发布了一篇开创性论文,首次从理论层面证明了大语言模型(LLM)中的prompt机制具有图灵完备性。这意味着,通过合适的prompt设计,一个固定大小的Transformer模型理论上可以计算任何可计算函数。这一突破性发现为prompt工程提供了坚实的理论基础。

网络智能体旨在让一切基于网络功能的任务自动发生。比如你告诉智能体你的预算,它可以帮你预订酒店。既拥有海量常识,又能做长期规划的大语言模型(LLM),自然成为了智能体常用的基础模块。

算法设计(AD)对于各个领域的问题求解至关重要。大语言模型(LLMs)的出现显著增强了算法设计的自动化和创新,提供了新的视角和有效的解决方案。

Ichigo[1] 是一个开放的、持续进行的研究项目,目标是将基于文本的大型语言模型(LLM)扩展,使其具备原生的“听力”能力。

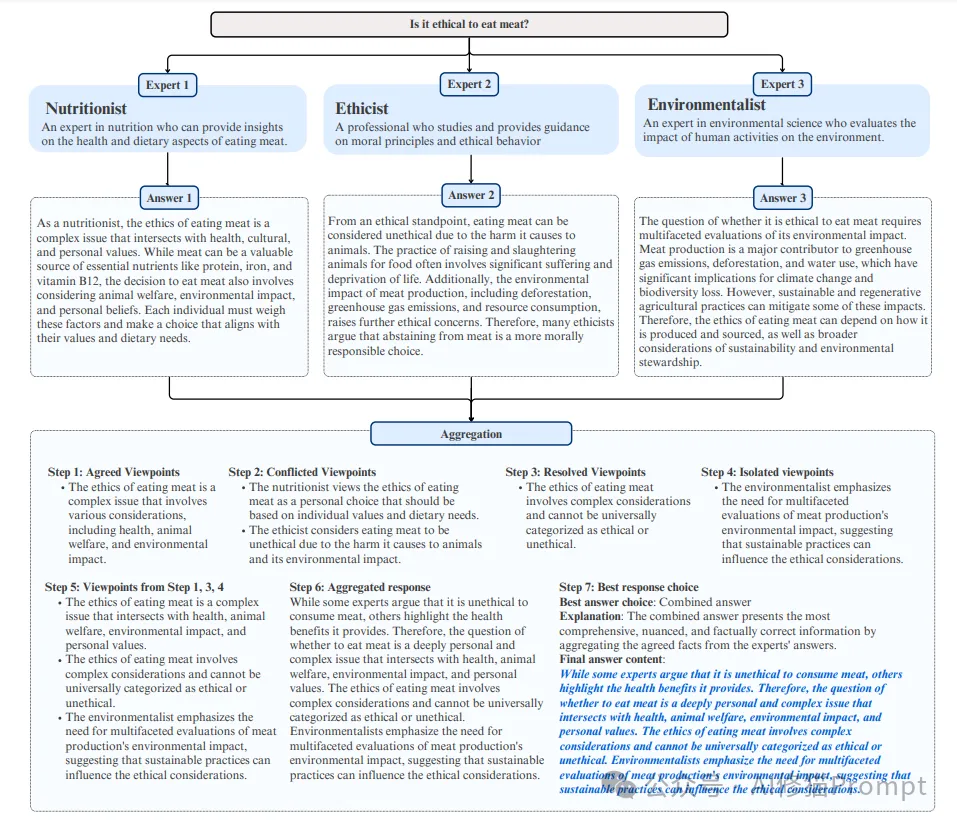

在当前的LLM应用开发中,工程师们通常通过使用单一角色或专家视角的方式来处理复杂问题。这种单一视角虽然能够提供一定的专业性,但也经常因为专家视角的局限性带来偏见,影响输出的全面性和可靠性。

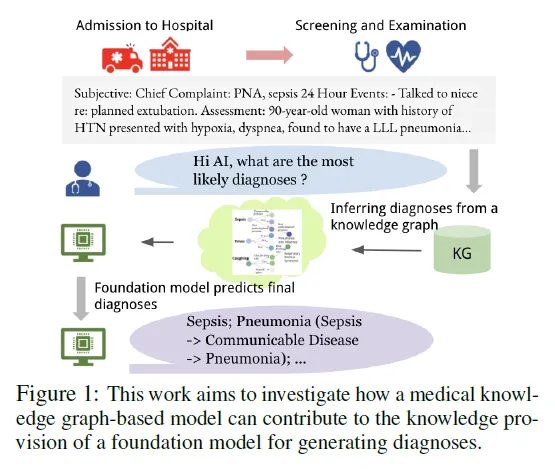

近年来,生成式大型语言模型(LLMs)在各类语言任务中的表现令人瞩目,但在医疗领域的应用面临诸多挑战,尤其是在减少诊断错误和避免对患者造成伤害方面。

让 LLM 在自我进化时也能保持对齐。

斯坦福大学奥马尔(Omar)的DSPy研究团队最近更新了他们的项目文档,发了很多不错的案例,以及很多国际知名企业的DSPy用例,这些可能对您的项目有启发。

AI,LLM,模型训练,人工智能

改进KV缓存压缩,大模型推理显存瓶颈迎来新突破—— 中科大研究团队提出Ada-KV,通过自适应预算分配算法来优化KV缓存的驱逐过程,以提高推理效率。