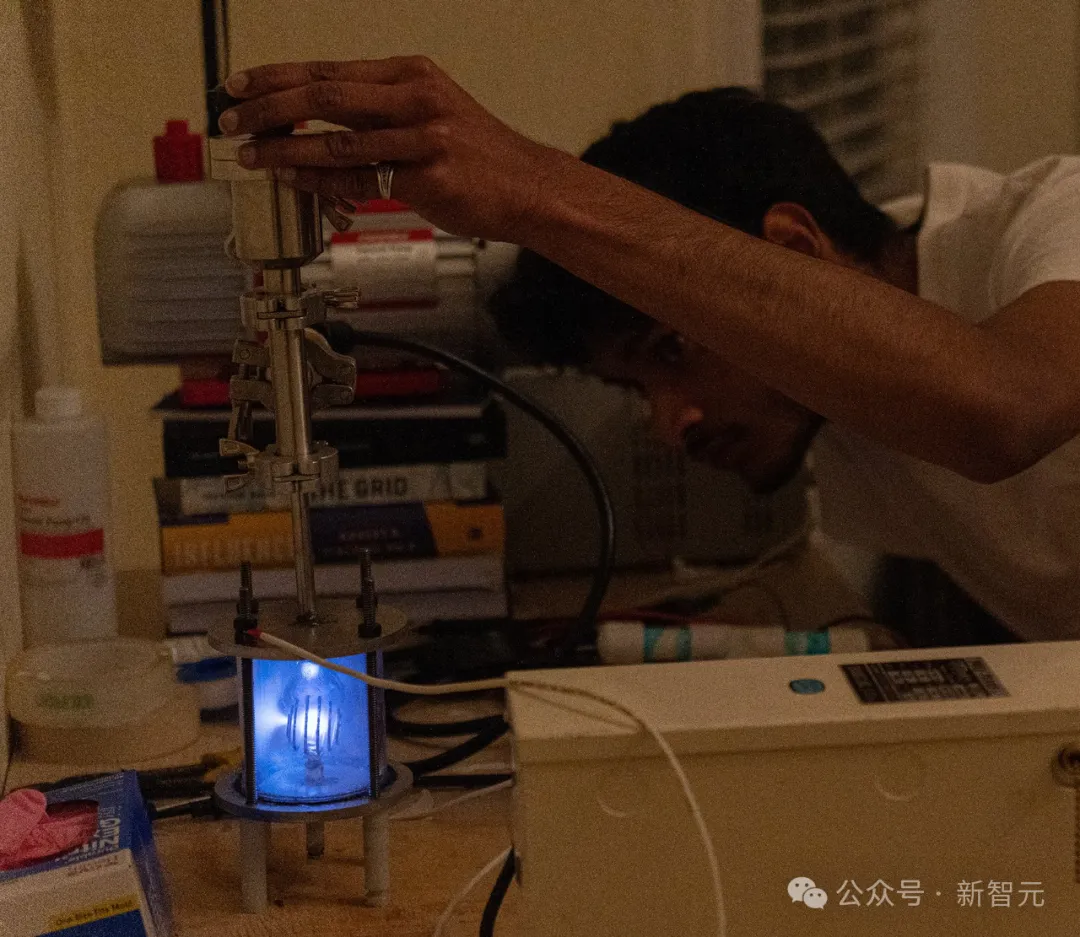

LLM的范式转移:RL带来新的 Scaling Law

LLM的范式转移:RL带来新的 Scaling Law从几周前 Sam Altman 在 X 上发布草莓照片开始,整个行业都在期待 OpenAI 发布新模型。根据 The information 的报道,Strawberry 就是之前的 Q-star,其合成数据的方法会大幅提升 LLM 的智能推理能力,尤其体现在数学解题、解字谜、代码生成等复杂推理任务。这个方法也会用在 GPT 系列的提升上,帮助 OpenAI 新一代 Orion。

从几周前 Sam Altman 在 X 上发布草莓照片开始,整个行业都在期待 OpenAI 发布新模型。根据 The information 的报道,Strawberry 就是之前的 Q-star,其合成数据的方法会大幅提升 LLM 的智能推理能力,尤其体现在数学解题、解字谜、代码生成等复杂推理任务。这个方法也会用在 GPT 系列的提升上,帮助 OpenAI 新一代 Orion。

LLM若以每秒1000+token高速推理,当前最先进的GPU根本无法实现!Cerebras Inference一出世,推理速度赶超英伟达GPU,背靠自研的世界最大芯片加持。而且,还将推理价格打了下来。

SQL 即将被 AI 取代,这种说法你同意吗?

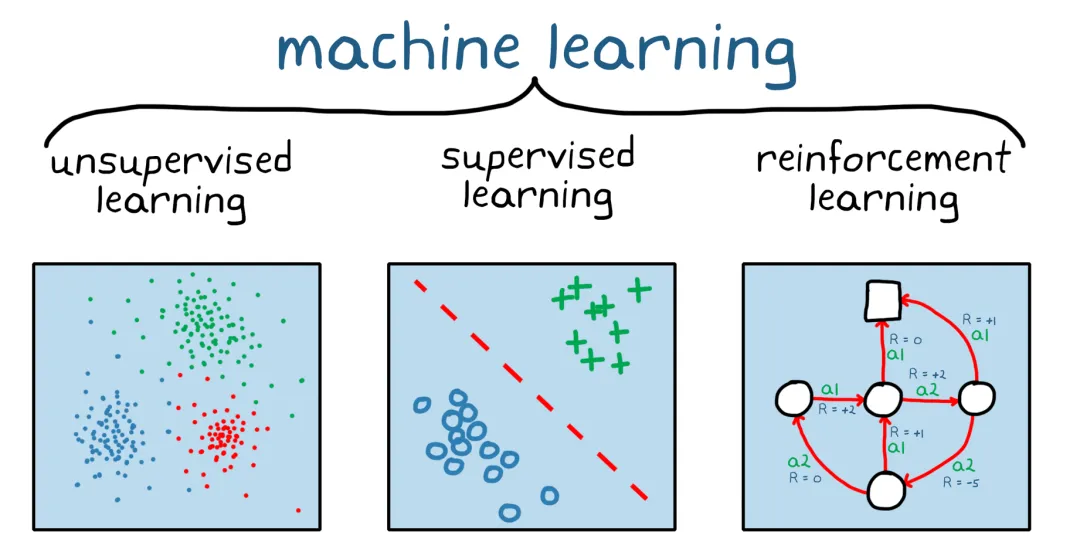

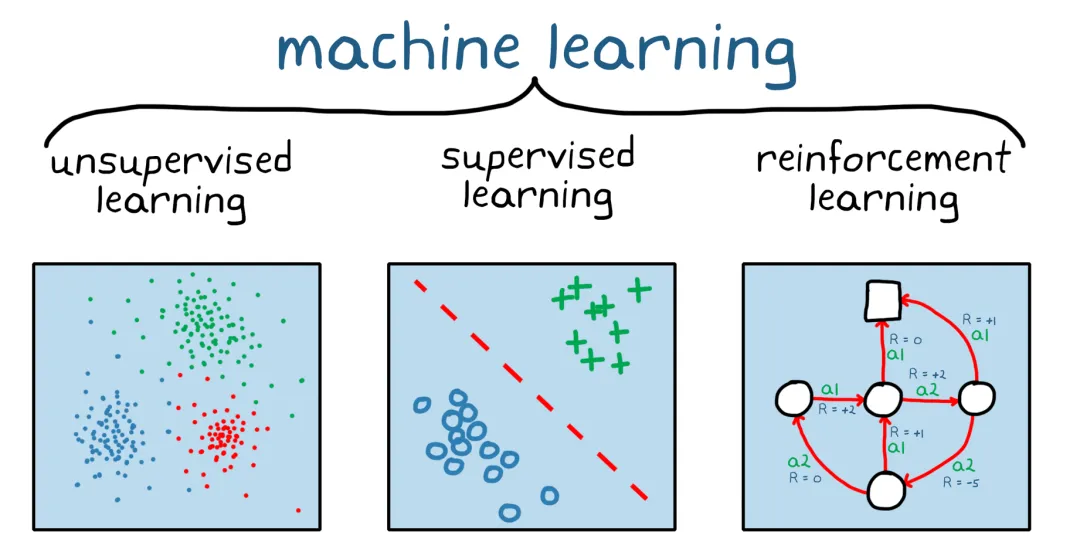

AGI 正在迎来新范式,RL 是 LLM 的秘密武器。

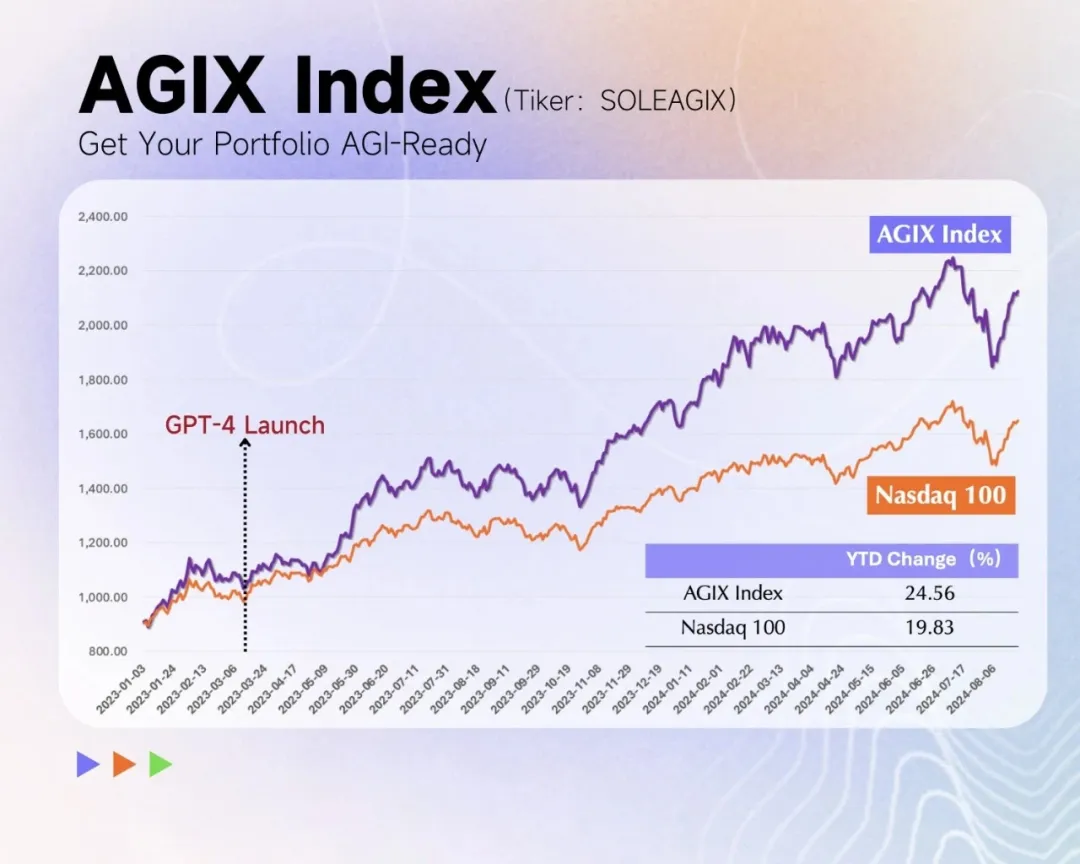

前段时间,Claude 3.5帮助右手骨折工程师一周肝出3000行代码。现在,又有00后数学系本科生借助AI,用了一个月时间,在自家卧室手搓「核聚变反应堆」,震惊一大波网友。

随着LLM不断迭代,偏好和评估数据中大量的人工标注逐渐成为模型扩展的显著障碍之一。Meta FAIR的团队最近提出了一种使用迭代式方法「自学成才」的评估模型训练方法,让70B参数的Llama-3-Instruct模型分数超过了Llama 3.1-405B。

昨天,李沐回到了母校上海交大,做了一场关于 LLM 和个人生涯的分享。本文是机器之心梳理的李沐演讲内容

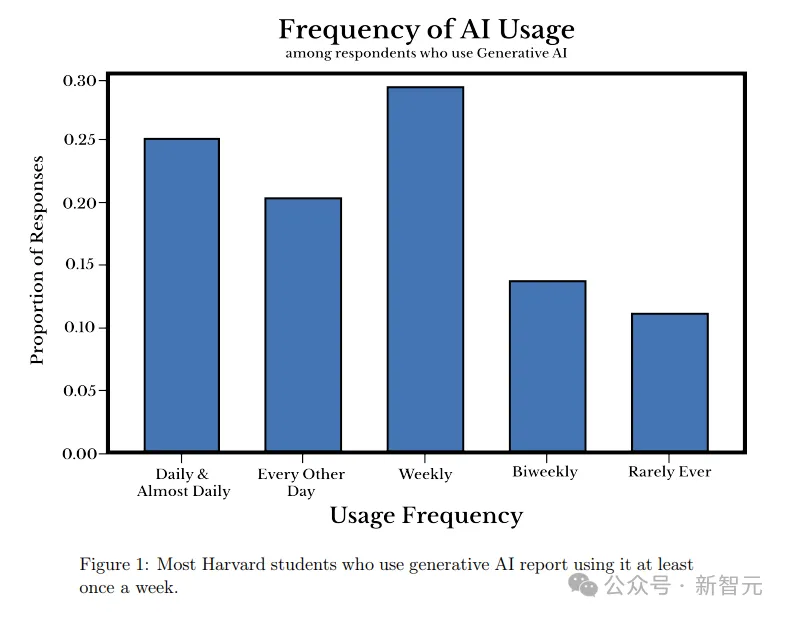

哈佛大学的一项最新研究表明,大语言模型已经深入学生的日常生活。为何学生们对AI的兴趣如此浓厚,背后的原因恐怕是这所大学的教授们。

OpenAI警告说,跟人工智能语音聊天可能会产生「情感依赖」。这种情感依赖是怎么产生的呢?MIT的一项研究指出,这可能是「求仁得仁」的结果,无怪乎连软件工程师也会对AI着迷。

Emory大学的研究团队提出了一种创新的方法,将大语言模型(LLM)在文本图(Text-Attributed Graph, 缩写为TAG)学习中的强大能力蒸馏到本地模型中,以应对文本图学习中的数据稀缺、隐私保护和成本问题。通过训练一个解释器模型来理解LLM的推理过程,并对学生模型进行对齐优化,在多个数据集上实现了显著的性能提升,平均提高了6.2%。