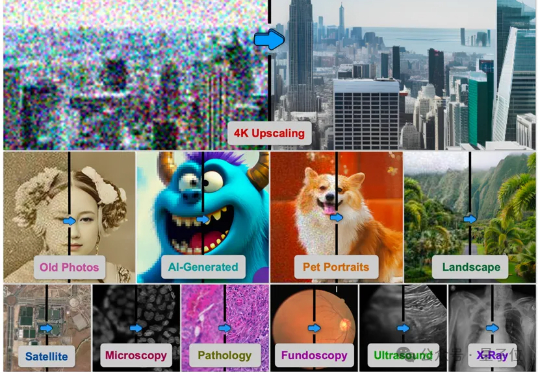

4K超分Agent修图师来了!一键救活所有模糊照片

4K超分Agent修图师来了!一键救活所有模糊照片由德克萨斯A&M大学、斯坦福大学、Snap公司、CU Boulder大学、德克萨斯大学奥斯汀分校、加州理工大学、Topaz Labs以及加州大学Merced分校的研究者联合提出的基于AI智能体的方法4KAgent针对不同类型的图像以及需求对图像进行智能修复并放大到4K分辨率,带来优秀的视觉感知效果。该工作已被NeurIPS 2025接收。

由德克萨斯A&M大学、斯坦福大学、Snap公司、CU Boulder大学、德克萨斯大学奥斯汀分校、加州理工大学、Topaz Labs以及加州大学Merced分校的研究者联合提出的基于AI智能体的方法4KAgent针对不同类型的图像以及需求对图像进行智能修复并放大到4K分辨率,带来优秀的视觉感知效果。该工作已被NeurIPS 2025接收。

在2025年CES上惊艳亮相,并创下近400万美金众筹记录的AI眼镜,再次获得了资本的青睐。

刚刚,才离开 Meta 不久的 Soumith Chintala 发布了一条推文,盛赞 Thinking Machines Lab(以下简称 TML)的人很了不起(incredible)。与此同时,这位 PyTorch 之父也更新了自己的个人介绍,正式官宣加入 TML,并表示正在这家估值已达 500 亿美元的创业公司「创造新东西(Building new things)」 。

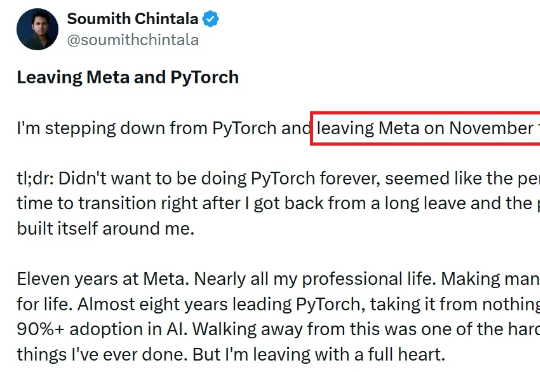

视频创作中,你是否曾希望复刻变成 Labubu 的特效,重现吉卜力风格化,跳出短视频平台爆火的同款舞蹈,或模仿复杂有趣的希区柯克运镜?

当美国巨头如Google、OpenAI 和 Anthropic 竞相开发支撑其 AI 产品的大型语言模型时,Sakana AI、Mistral AI、DeepSeek 和 AI21 Labs 等初创公司正凭借为特定地区、行业或独特功能设计的专业模型开辟自己的细分市场。

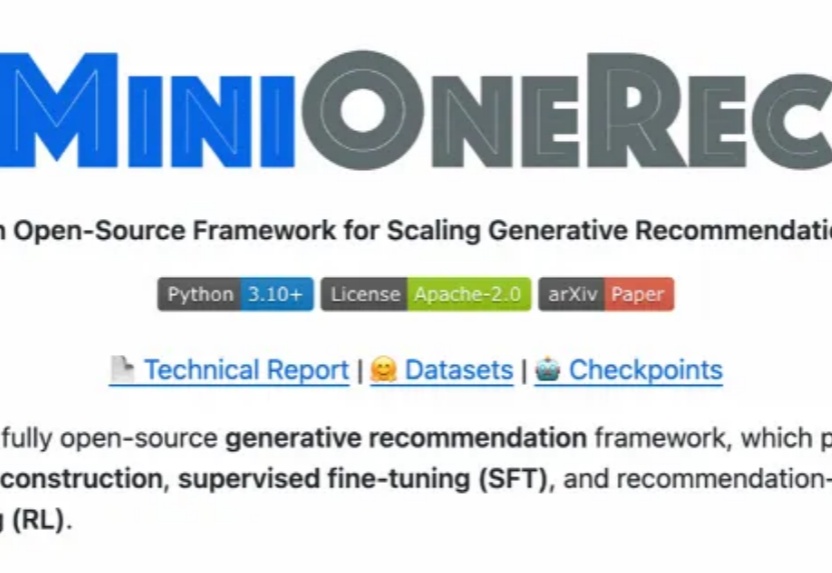

中科大 LDS 实验室何向南、王翔团队与 Alpha Lab 张岸团队联合开源 MiniOneRec,推出生成式推荐首个完整的端到端开源框架,不仅在开源场景验证了生成式推荐 Scaling Law,还可轻量复现「OneRec」,为社区提供一站式的生成式推荐训练与研究平台。

Marble,终于来了。 没错,就是两个月前在 AI 圈刷屏的那个 3D 世界生成模型。就在刚刚,李飞飞旗下的 World Labs 公司官宣向全体用户开放,还一次性放出了一大波新功能。 多模态生成:

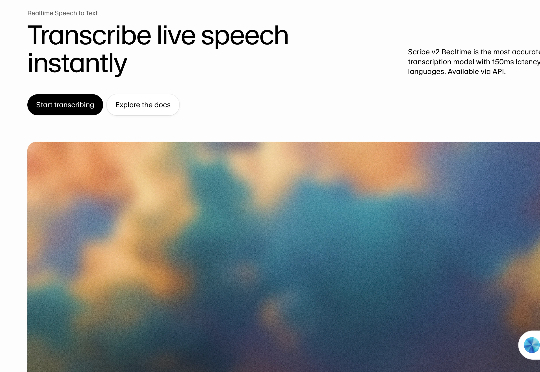

来自AI语音独角兽公司ElevenLabs,刚刚发布了Scribe v2 Realtime实时语音转文本模型,网友表示:Next-Level。150毫秒的超低延迟,93.5%的高准确率,还覆盖了90多种语言。

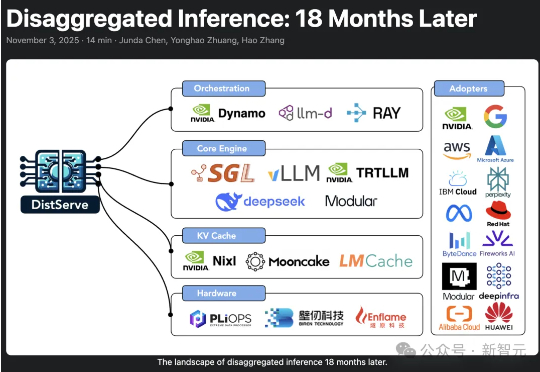

2024年,加州大学圣地亚哥分校「Hao AI Lab」提出了DistServe的解耦推理理念,短短一年多时间,迅速从实验室概念成长为行业标准,被NVIDIA、vLLM等主流大模型推理框架采用,预示着AI正迈向「模块化智能」的新时代。

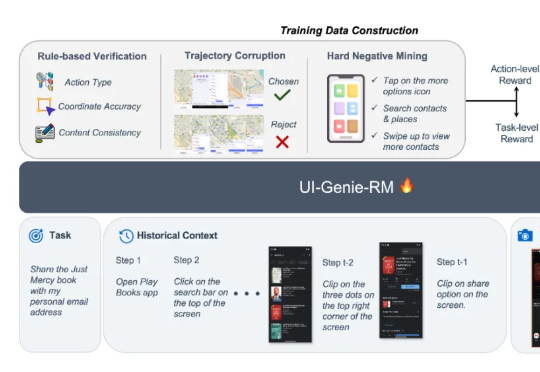

本文来自于香港中文大学 MMLab 和 vivo AI Lab,其中论文第一作者肖涵,主要研究方向为多模态大模型和智能体学习,合作作者王国志,研究方向为多模态大模型和 Agent 强化学习。项目 le