利好AI大模型,MIT团队推出数据集审查工具DPExplorer,对“不合适”训练数据说no

利好AI大模型,MIT团队推出数据集审查工具DPExplorer,对“不合适”训练数据说no训练数据的质量优劣,直接影响人工智能(AI)大模型的能力水平。

训练数据的质量优劣,直接影响人工智能(AI)大模型的能力水平。

在我的世界里,出现了有史以来第一个智能体文明。1000多个智能体一同协作,在虚拟世界中构建起,自己的经济、文化、宗教和政府。网友纷纷惊呼,西部世界真的来了。

据TechCrunch报道,EliseAI 是一家为房东开发人工智能物业管理工具的公司,该公司在 D 轮融资中筹集了 7500 万美元,估值达 10 亿美元。

MIT研究发现:在AI的操纵下,人类会被植入虚假记忆!36.4%的参与者会被聊天机器人误导,形成「现场有枪」的错误记忆。有趣的是,AI的阿谀奉承,会产生「回音室效应」,让偏见更加强化。

4名MIT本科生创业,才两年公司就已经估值4亿美元。开发AI编码助手Cursor的Anysphere,最近在A轮融资中已经筹集超6000万美元。而且,这是一家只有12人的公司。AI编程助手,就是行业的下一个风口?

OpenAI警告说,跟人工智能语音聊天可能会产生「情感依赖」。这种情感依赖是怎么产生的呢?MIT的一项研究指出,这可能是「求仁得仁」的结果,无怪乎连软件工程师也会对AI着迷。

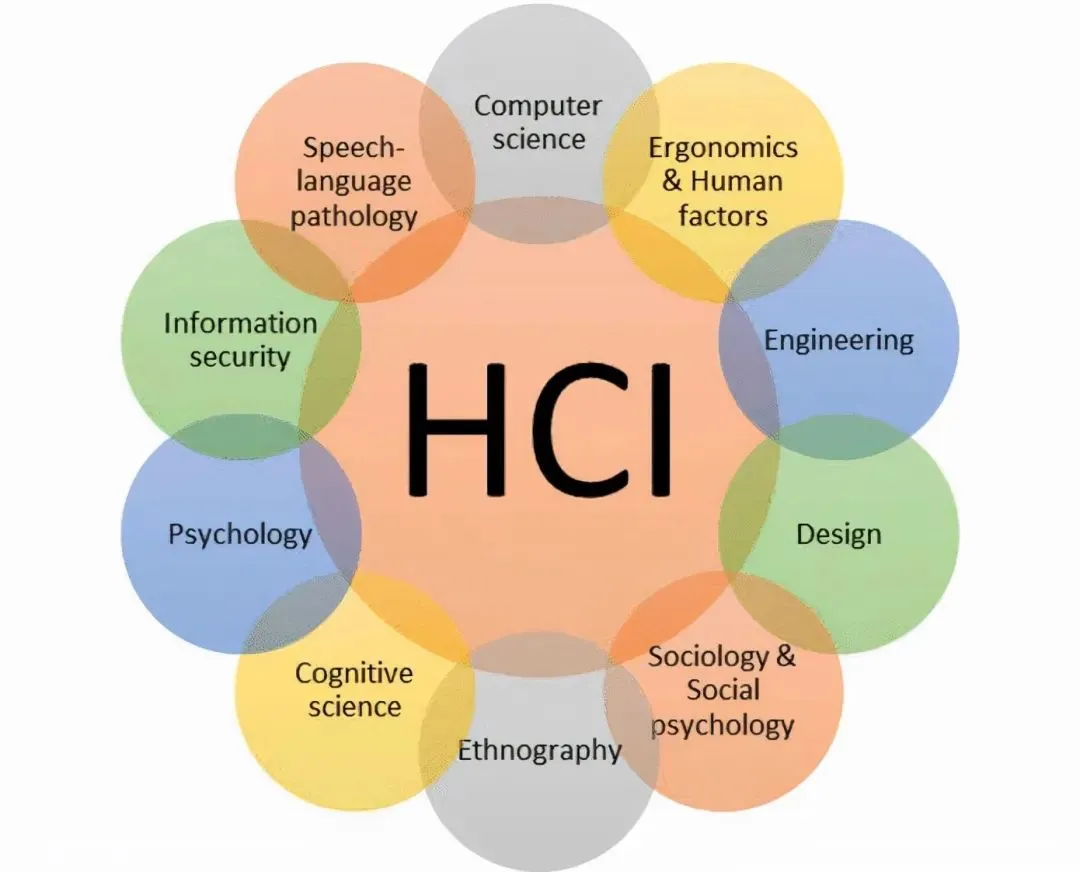

HCI(人机交互),作为一个新名词被国人慢慢熟悉,也就是这几年的事情。很多同学也想着往HCI转,但最近一篇文《HCI已经成为夕阳专业》的文章,顿时让不少人感到一阵焦虑。担心AI的发展是否会让这个很新的领域,受到严重的冲击。

AI智能体遍布整个网络,未来如何防止被骗?如何保护隐私?OpenAI微软MIT等25个机构联手提出「人格凭证」,可以证明自己是真人,还不用披露任何个人信息。

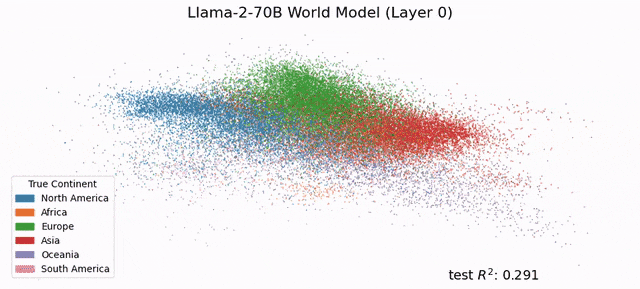

MIT CSAIL的研究人员发现,LLM的「内心深处」已经发展出了对现实的模拟,模型对语言和世界的理解,绝不仅仅是简单的「鹦鹉学舌」。也就说,在未来,LLM会比今天更深层地理解语言。

大模型对现实世界,可以形成自己的理解!