Llama 4发布在即,Meta AI负责人突然官宣离职

Llama 4发布在即,Meta AI负责人突然官宣离职Meta AI研究副总裁Pineau亲自发帖声称将于5月30日离职,她主导了Llama开源系列及PyTorch项目。此举正逢扎克伯格重金投入AI及LlamaCon AI大会前夕,引发业内对Meta战略调整和未来新作的诸多猜测。

Meta AI研究副总裁Pineau亲自发帖声称将于5月30日离职,她主导了Llama开源系列及PyTorch项目。此举正逢扎克伯格重金投入AI及LlamaCon AI大会前夕,引发业内对Meta战略调整和未来新作的诸多猜测。

简单的任务,传统的Transformer却错误率极高。Meta FAIR团队重磅推出多token注意力机制(MTA),精准捕捉复杂信息,带来模型性能飞升!

还记得那个自制 AI 工具 Interview Coder、以此斩获了亚马逊、Meta 和 TikTok 等大厂 Offer 的 21 岁哥伦比亚大学学生 Chungin Lee(Roy Lee)吗?

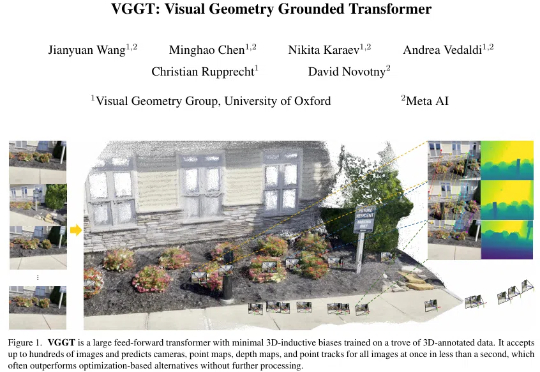

「仅需一次前向推理,即可预测相机参数、深度图、点云与 3D 轨迹 ——VGGT 如何重新定义 3D 视觉?」

DeepWisdom完成亿元级融资,旗下智能体产品mgx.dev以零推广首月狂揽百万美元ARR,连续四周霸榜Product Hunt全球榜首。它让普通人也能一句话做出自己的APP。

据当地媒体报道,韩国 AI 应用芯片初创公司 FuriosaAI 拒绝了 Meta 的 8 亿美元收购,选择继续专注于开发和生产其 AI 芯片。

据与两家公司高管交谈的两位人士透露,OpenAI 高管在最近几个月多次与信实工业(Reliance Industries)的高管会面,讨论了潜在的产品和销售合作伙伴关系。

在 2024 年七月的一篇博客文章中,Meta CEO 马克·扎克伯格表示,“出售访问权限”给 Meta 公开可用的 Llama AI 模型“不是 Meta 的商业模式。”

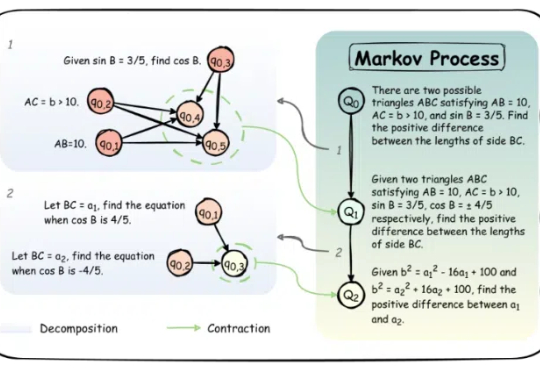

大语言模型(LLM)近年来凭借训练时扩展(train-time scaling)取得了显著性能提升。然而,随着模型规模和数据量的瓶颈显现,测试时扩展(test-time scaling)成为进一步释放潜力的新方向。

Meta此举,或是要证明他们大规模投资AI基础设施不是在蛮干。