LLM上下文窗口突破200万!无需架构变化+复杂微调,轻松扩展8倍

LLM上下文窗口突破200万!无需架构变化+复杂微调,轻松扩展8倍大型语言模型(LLM)往往会追求更长的「上下文窗口」,但由于微调成本高、长文本稀缺以及新token位置引入的灾难值(catastrophic values)等问题,目前模型的上下文窗口大多不超过128k个token

大型语言模型(LLM)往往会追求更长的「上下文窗口」,但由于微调成本高、长文本稀缺以及新token位置引入的灾难值(catastrophic values)等问题,目前模型的上下文窗口大多不超过128k个token

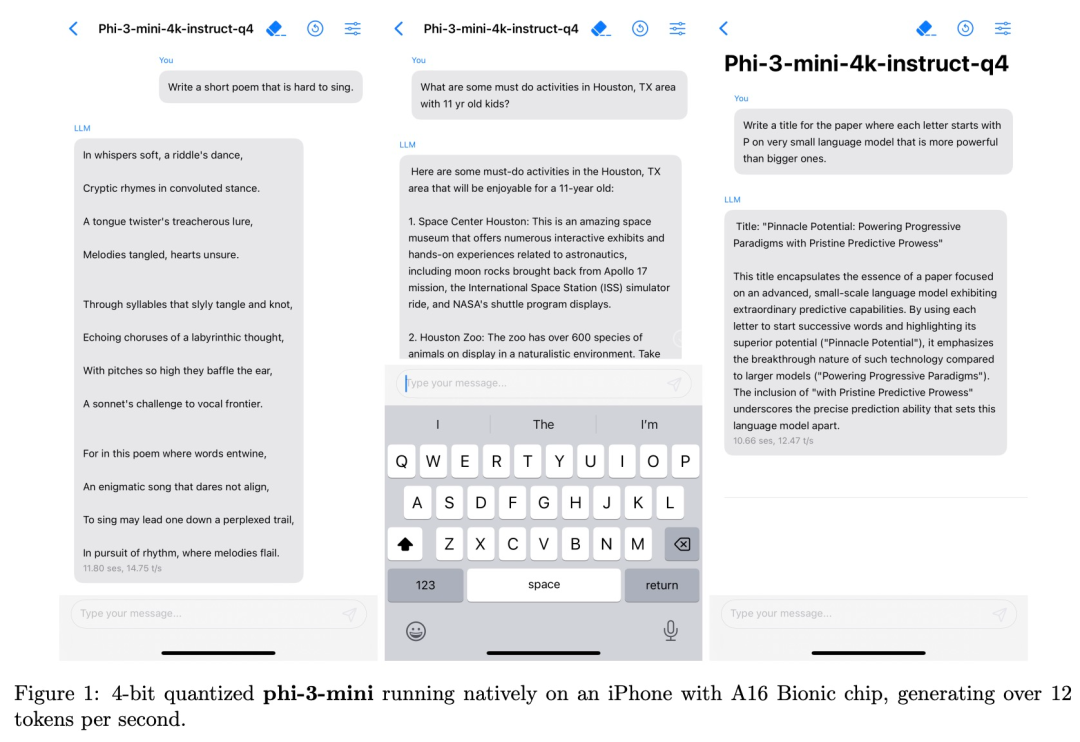

从Llama 3到Phi-3,蹭着开源热乎劲儿,苹果也来搞事情了。

Llama-3 刚发布没多久,竞争对手就来了,而且是可以在手机上运行的小体量模型。

Llama 3发布刚几天,微软就出手截胡了?

以脉冲神经网络(SNN)为代表的脑启发神经形态计算(neuromorphic computing)由于计算上的节能性质在最近几年受到了越来越多的关注 [1]。受启发于人脑中的生物神经元,神经形态计算通过模拟并行的存内计算、基于脉冲信号的事件驱动计算等生物特性,能够在不同于冯诺依曼架构的神经形态芯片上以低功耗实现神经网络计算。

两年的时间见证了DeepMind基于AlphaFold建立Isomorphic Lab,微软建立AI4Science Initiative, 以及国内深势科技,AISI等大力推动AI4Science建设的企业,学术机构的不断发展壮大。

谷歌旗下AI制药公司与全球两大制药巨头达成合作,标志着人工智能+生物医疗进入新的历史阶段。当地时间周一,Isomorphic Labs宣布与礼来和诺华签署了首个制药合作伙伴关系合同,将AI技术用于新药物的发现。

Coatue是一家总部位于纽约的对冲基金,以持之以恒地对TMT赛道押注受业界关注,自1999年由Philippe Laffont(菲利普·拉丰)离开老虎基金之后创办至今,它的管理规模已从4500万跨越到190亿美元。

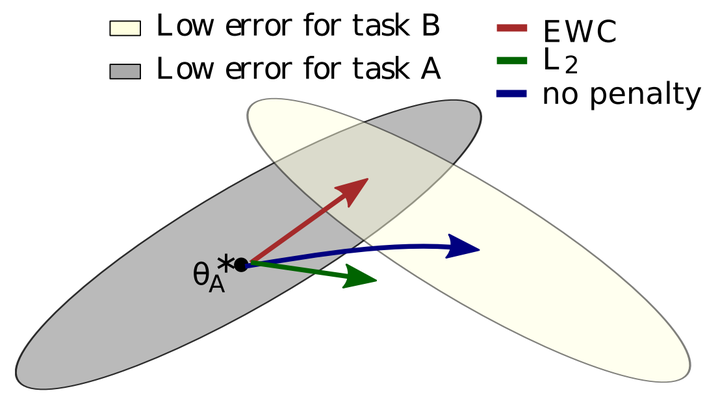

所谓灾难性遗忘,就是一个在原始任务上训练好的神经网络在训练完新任务后,在原始任务上的表现崩溃式的降低。

无法控制成本的大模型终将被“快好省”的小模型取代今年最热的AI赛道中,机构们自然也得下一些判断,比如说——2024年大模型的一个趋势,是将变得“越来越小”。