深度|Pytorch华人负责人押注复合AI:行业已经从依赖Scaling Law逐渐转向强调模型的推理能力

深度|Pytorch华人负责人押注复合AI:行业已经从依赖Scaling Law逐渐转向强调模型的推理能力我亲眼见证了数据量的爆炸式增长以及行业的巨额投入。当时就很明显,AI是推动这些数据增长背后的关键动力。那是一个非常有趣的时刻——Meta正在完成“移动优先”的过渡,开始迈向“AI 优先”。

我亲眼见证了数据量的爆炸式增长以及行业的巨额投入。当时就很明显,AI是推动这些数据增长背后的关键动力。那是一个非常有趣的时刻——Meta正在完成“移动优先”的过渡,开始迈向“AI 优先”。

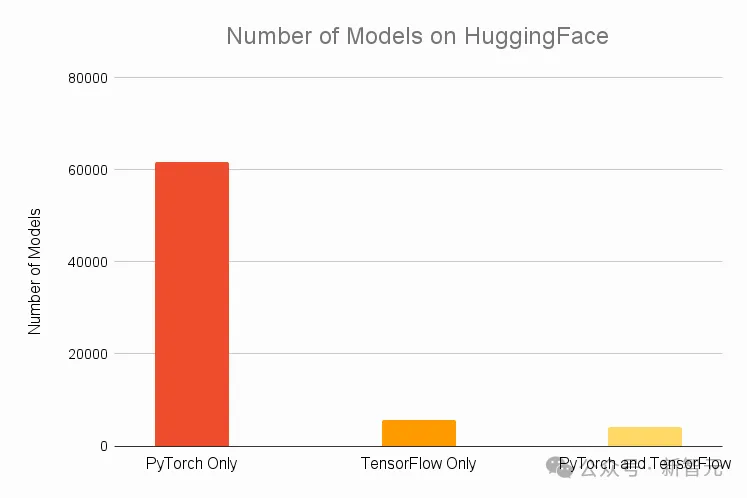

简单性可以扩展:PyTorch的成功源于其对研究人员简单性的关注,这种关注随后流向了生产环境。在Fireworks,他们在幕后拥抱了巨大的复杂性,以提供一个简单的API给开发者。这种方法让客户能够专注于创新和产品设计,而不是纠结于技术复杂性。

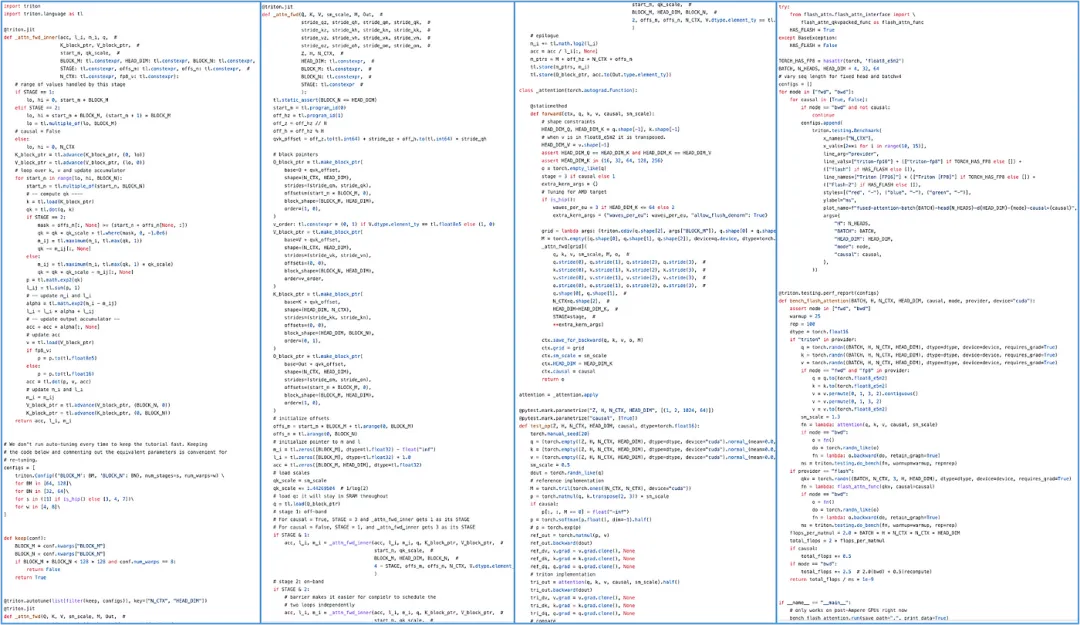

近日,来自 CMU 的 Catalyst Group 团队发布了一款 PyTorch 算子编译器 Mirage,用户无需编写任何 CUDA 和 Triton 代码就可以自动生成 GPU 内核,并取得更佳的性能。

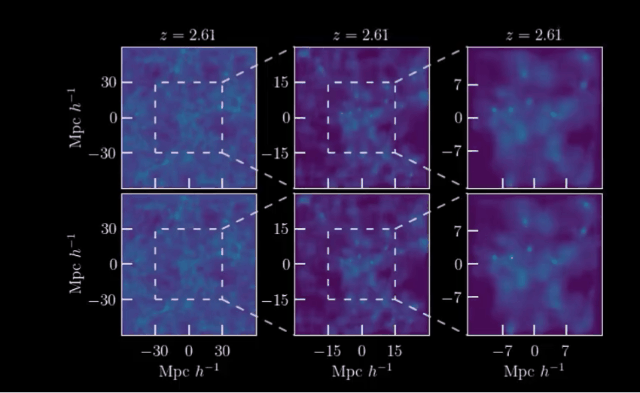

AI开启模拟宇宙!近日,来自马克斯·普朗克研究所等机构,利用宇宙学和红移依赖性对宇宙结构形成进行了场级仿真,LeCun也在第一时间转发和推荐。

用英伟达的GPU,但可以不用CUDA?PyTorch官宣,借助OpenAI开发的Triton语言编写内核来加速LLM推理,可以实现和CUDA类似甚至更佳的性能。

用 FlexAttention 尝试一种新的注意力模式。

最近,PyTorch团队首次公布了开发路线图,由内部技术文档直接修改而来,披露了这个经典开源库下一步的发展方向。

Moshi 具有彻底改变人机通信的潜力。

一夜之间,微软的AI全宇宙已经成型。

AI 生产力的未来会是什么样子?全世界都在等待微软的答案。