Qwen紧追OpenAI开源4B端侧大模型,AIME25得分超越Claude 4 Opus

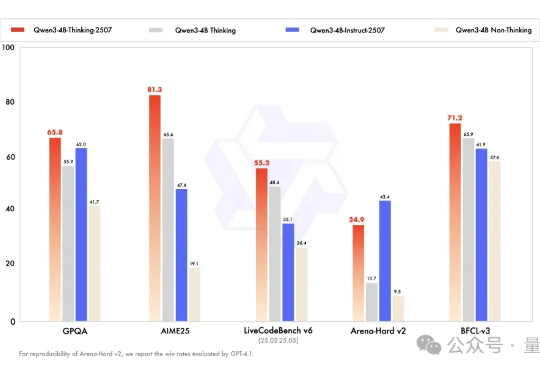

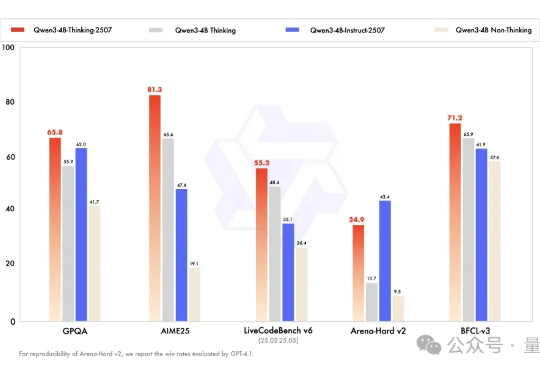

Qwen紧追OpenAI开源4B端侧大模型,AIME25得分超越Claude 4 Opus三天不开源,Qwen团队手就痒。 昨天深夜再次放出两个端侧模型: Qwen3-4B-Instruct-2507:非推理模型,大幅提升通用能力 Qwen3-4B-Thinking-2507:高级推理模型,专为专家级任务设计

三天不开源,Qwen团队手就痒。 昨天深夜再次放出两个端侧模型: Qwen3-4B-Instruct-2507:非推理模型,大幅提升通用能力 Qwen3-4B-Thinking-2507:高级推理模型,专为专家级任务设计

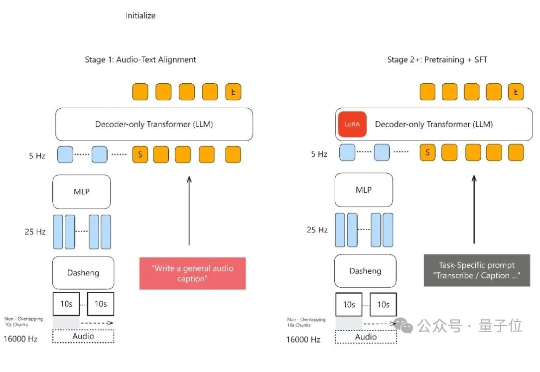

声音理解能力新SOTA,小米全量开源了模型。 MiDashengLM-7B,基于Xiaomi Dasheng作为音频编码器和Qwen2.5-Omni-7B Thinker作为自回归解码器,通过创新的通用音频描述训练策略,实现了对语音、环境声音和音乐的统一理解。

通义模型家族,刚刚又双叒开源了,这次是Qwen-Image——一个200亿参数、采用MMDiT架构的图像生成模型。 这也是通义千问系列中首个图像生成基础模型。

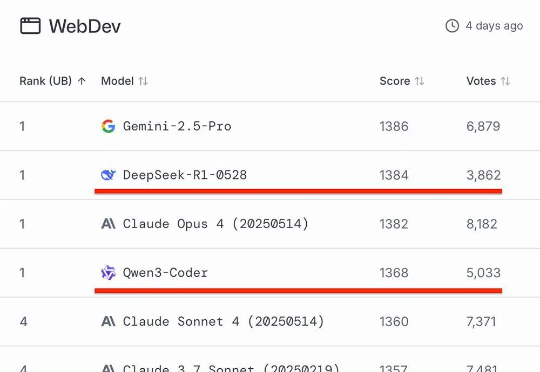

知名AI大模型评测Chatbot Arena放榜!阿里Qwen3-235B-A22B-Instruct-2507位列大语言模型总榜第三,月之暗面Kimi-K2-0711-preview、深度求索DeepSeek-R1-0528并列为总榜第五,以开源之姿超越Claude 4、GPT-4.1等顶尖闭源模型。

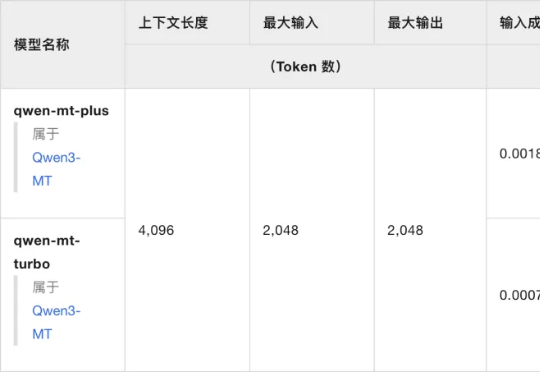

Qwen最近属实声势不小,开源方面刚靠Qwen3-Coder炸场,在翻译领域也卷出花

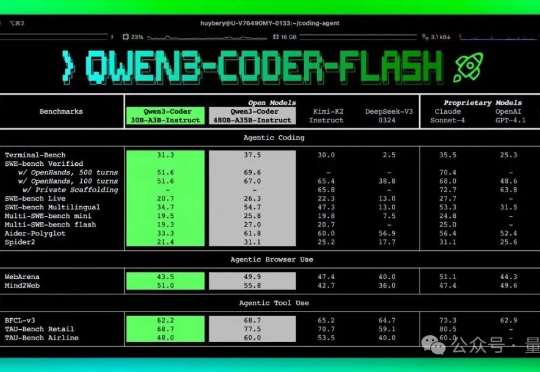

开源编程模型的天花板,要被Qwen3-Coder掀翻了。 今天凌晨,Qwen3-Coder-Flash也重磅开源!

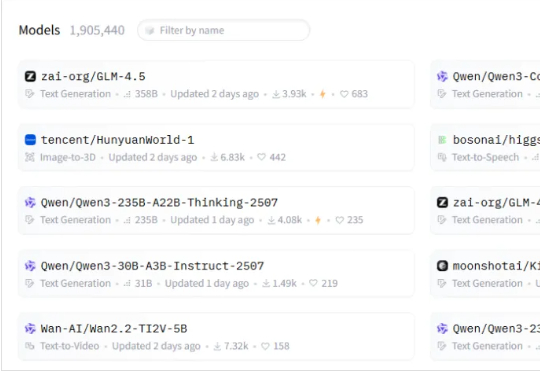

最近,国产模型开源非常多。 MiniMax、Kimi、Qwen、混元、智谱、昆仑万维等等,都在疯狂开源。

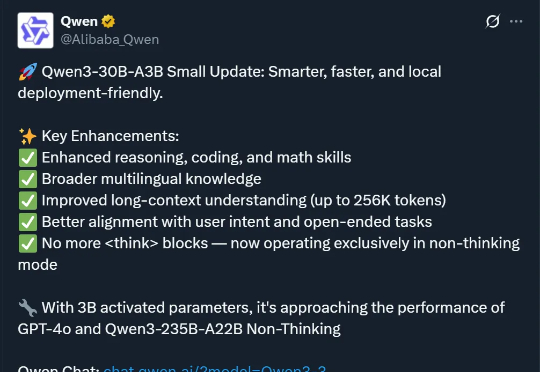

继前段时间密集发布了三款 AI 大模型后,Qwen 凌晨又更新了 —— 原本的 Qwen3-30B-A3B 有了一个新版本:Qwen3-30B-A3B-Instruct-2507。

卷疯了,通义千问真的卷疯了。

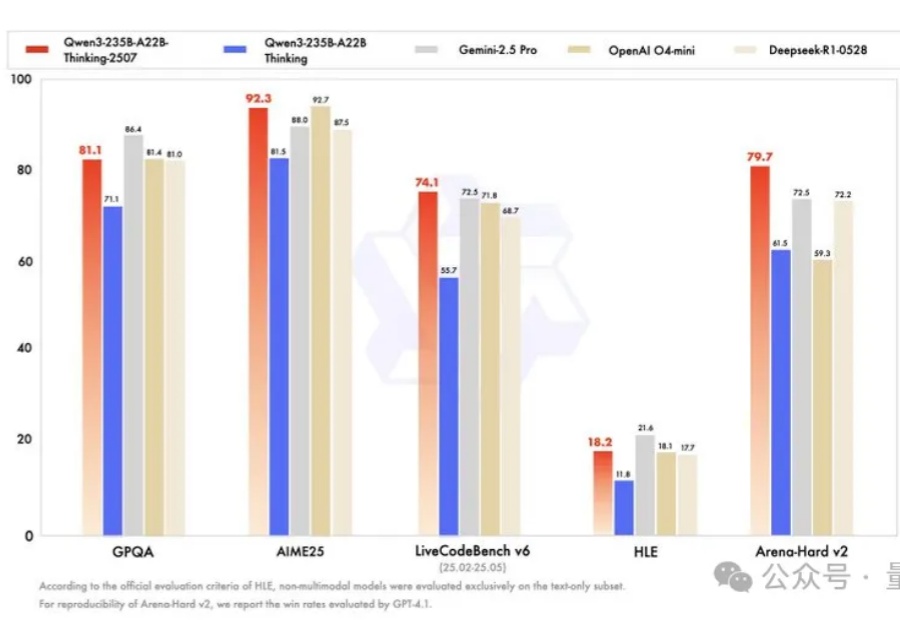

就在刚刚,阿里正式发布全球最强开源推理模型——Qwen3-235B-A22B-Thinking-2507。就在刚刚,阿里正式发布全球最强开源推理模型——Qwen3-235B-A22B-Thinking-2507。