大型语言模型稳定强化学习的新路径:几何平均策略优化GMPO

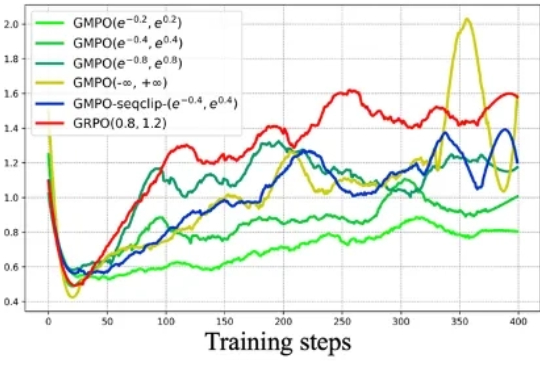

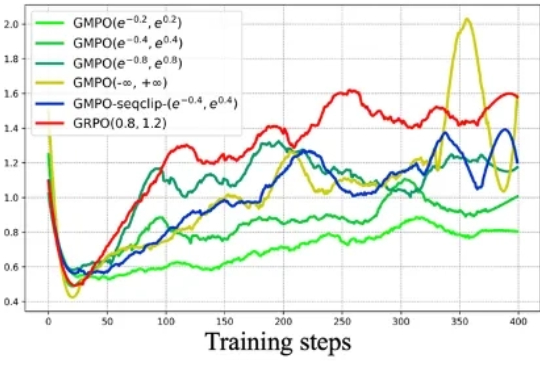

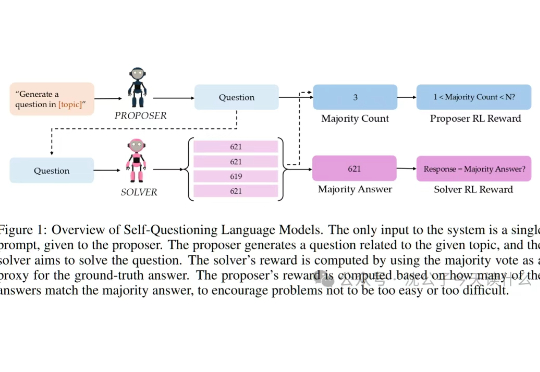

大型语言模型稳定强化学习的新路径:几何平均策略优化GMPO近年来,强化学习(RL)在大型语言模型(LLM)的微调过程中,尤其是在推理能力提升方面,取得了显著的成效。传统的强化学习方法,如近端策略优化(Proximal Policy Optimization,PPO)及其变种,包括组相对策略优化(Group Relative Policy Optimization,GRPO),在处理复杂推理任务时表现出了强大的潜力。

近年来,强化学习(RL)在大型语言模型(LLM)的微调过程中,尤其是在推理能力提升方面,取得了显著的成效。传统的强化学习方法,如近端策略优化(Proximal Policy Optimization,PPO)及其变种,包括组相对策略优化(Group Relative Policy Optimization,GRPO),在处理复杂推理任务时表现出了强大的潜力。

在今年三月份,清华 AIR 和字节联合 SIA Lab 发布了 DAPO,即 Decoupled Clip and Dynamic sAmpling Policy Optimization(解耦剪辑和动态采样策略优化)。

中国自研世界模型Matrix-3D只需单张图就能生成可自由探索的3D世界,不仅效果对标李飞飞的World Labs,而且还能实现更大范围的探索空间,率先进入AI理解世界的前沿领域。

硅星人独家了解到,星海图即将开源全球首个开放场景高质量真机数据集Galaxea Open-World Dataset,及其G0-快慢双系统全身智能VLA模型。这一举动无疑在相对各自为战的机器人行业打开了一条新的路径。

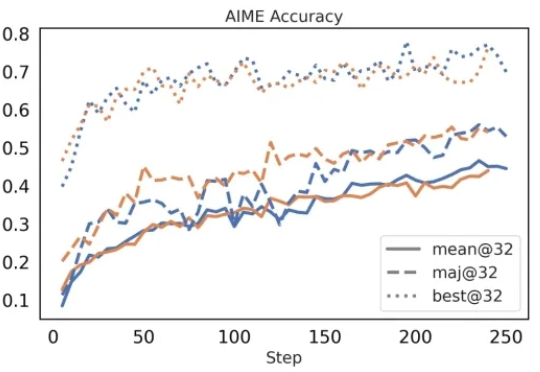

一句话概括,本文探索了语言模型的终极内卷模式:不再依赖人类投喂,通过“自问自答”的左右互搏,硬生生把自己逼成了学霸。AlphaGo下棋我懂,这大模型自己给自己出数学题做就有点离谱了,堪称AI界的“闭关修炼”,出关即无敌。

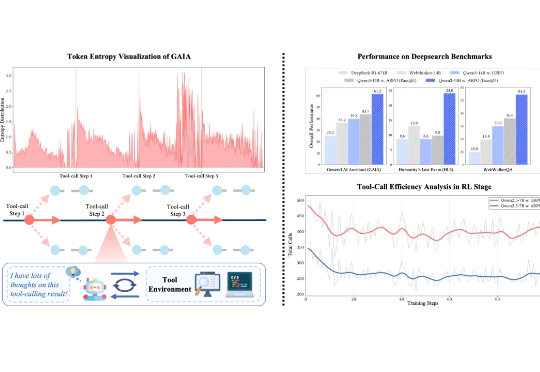

在可验证强化学习(RLVR)的推动下,大语言模型在单轮推理任务中已展现出不俗表现。然而在真实推理场景中,LLM 往往需要结合外部工具进行多轮交互,现有 RL 算法在平衡模型的长程推理与多轮工具交互能力方面仍存在不足。

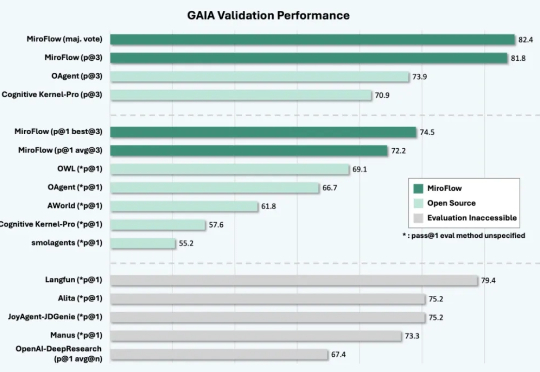

全栈开源生态系统:涵盖Agent框架(MiroFlow)、模型(MiroThinker)、数据(MiroVerse)和训练基础设施(MiroTrain / MiroRL)的全栈开源方案,所有组件和流程均开放共享,便于学习、复用与二次开发。

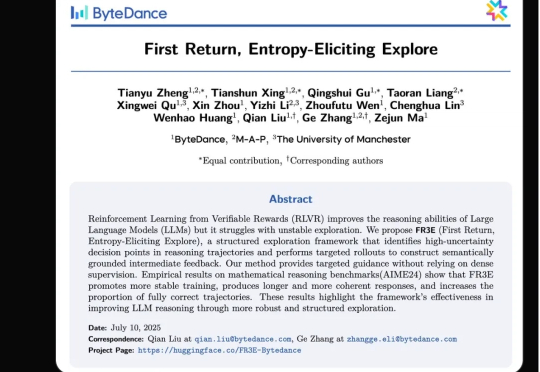

强化学习(RL)范式虽然显著提升了大语言模型(LLM)在复杂任务中的表现,但其在实际应用中仍面临传统RL框架下固有的探索难题。

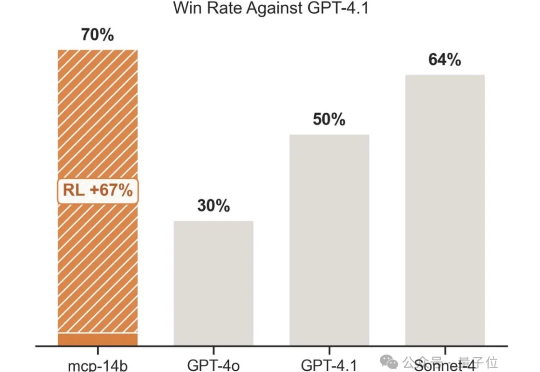

强化学习+任意一张牌,往往就是王炸。专注于LLM+RL的科技公司OpenPipe提出全新开源强化学习框架——MCP·RL。

OpenAI前研究员、Meta「AI梦之队员」毕书超在哥大指出:AGI就在眼前,突破需高质数据、好奇驱动探索与高效算法;Scaling Law依旧有效,规模决定智能,终身学习才是重点。