英伟达揭示RL Scaling魔力!训练步数翻倍=推理能力质变,小模型突破推理极限

英伟达揭示RL Scaling魔力!训练步数翻倍=推理能力质变,小模型突破推理极限强化学习(RL)到底是语言模型能力进化的「发动机」,还是只是更努力地背题、换个方式答题?这个问题,学界争论已久:RL 真能让模型学会新的推理技能吗,还是只是提高了已有知识的调用效率?

强化学习(RL)到底是语言模型能力进化的「发动机」,还是只是更努力地背题、换个方式答题?这个问题,学界争论已久:RL 真能让模型学会新的推理技能吗,还是只是提高了已有知识的调用效率?

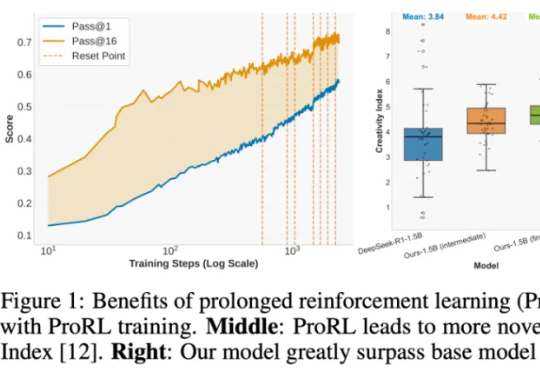

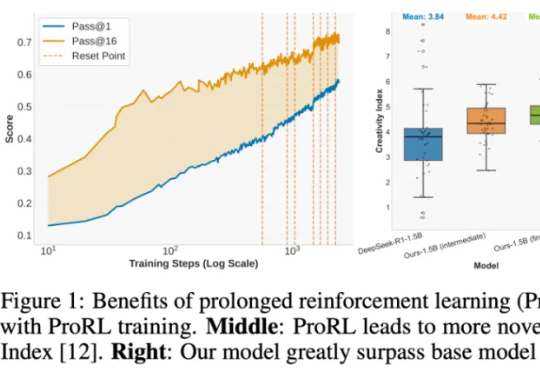

想训练属于自己的高性能推理模型,却被同步强化学习(RL)框架的低效率和高门槛劝退?AReaL 全面升级,更快,更强,更好用!

李飞飞空间智能创业公司World Labs,开源一项核心技术!

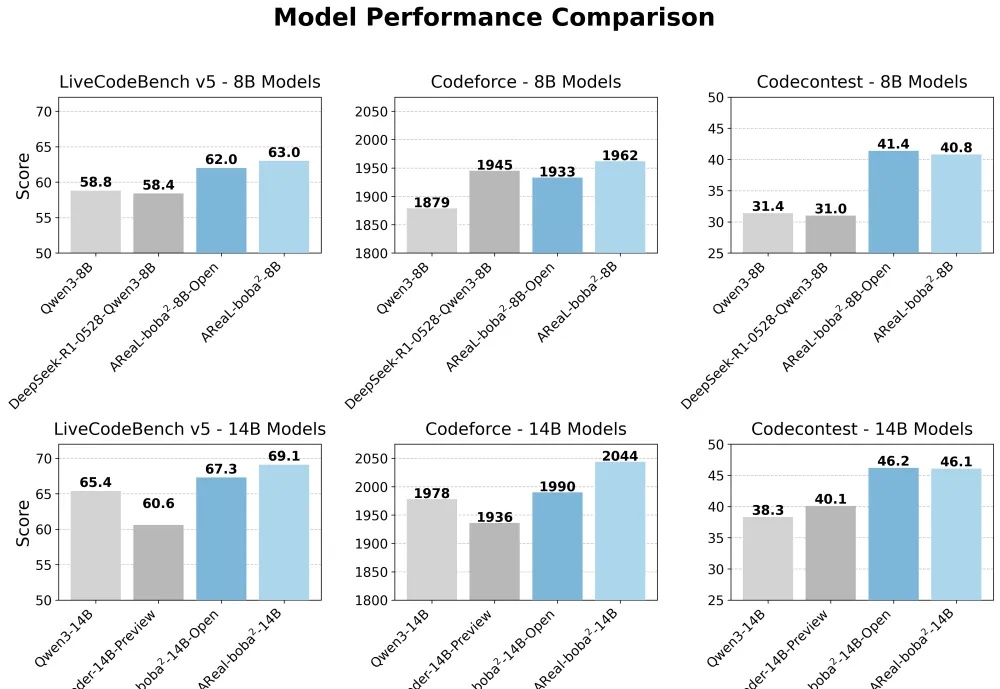

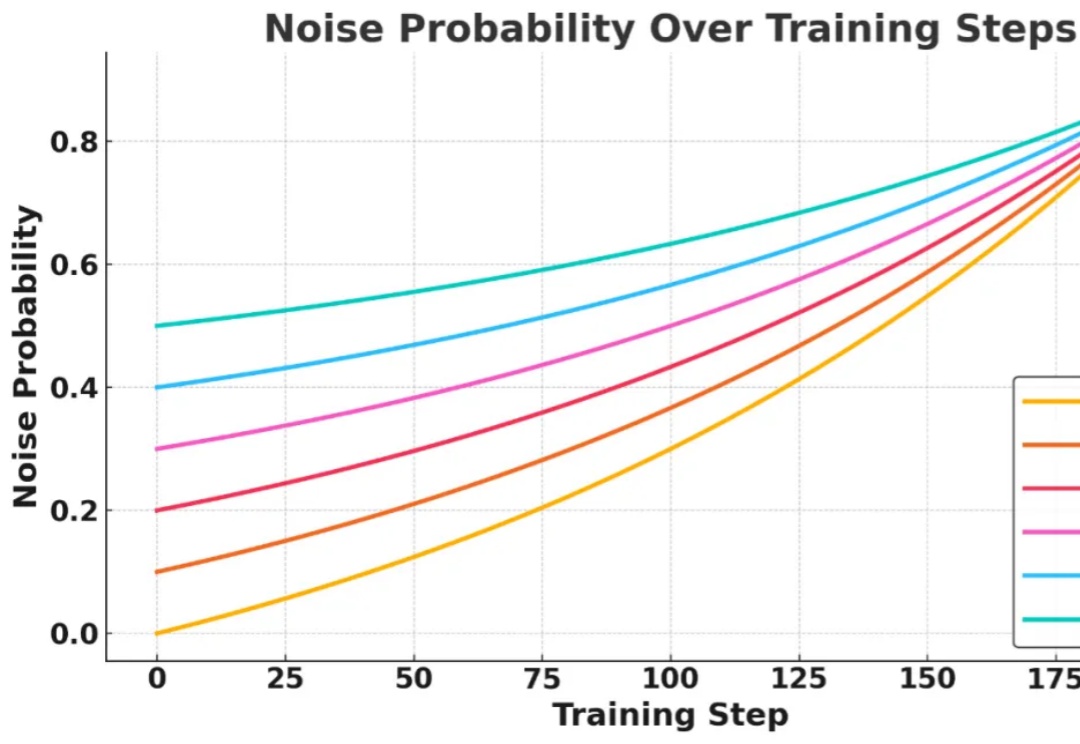

推理模型常常表现出类似自我反思的行为,但问题是——这些行为是否真的能有效探索新策略呢?

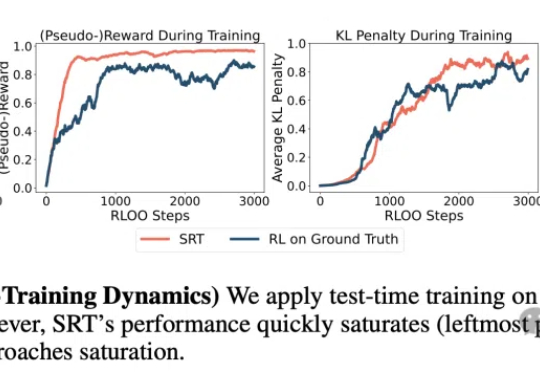

数据枯竭正成为AI发展的新瓶颈!CMU团队提出革命性方案SRT:让LLM实现无需人类标注的自我进化!SRT初期就能迭代提升数学与推理能力,甚至性能逼近传统强化学习的效果,揭示了其颠覆性潜力。

复刻DeepSeek-R1的长思维链推理,大模型强化学习新范式RLIF成热门话题。

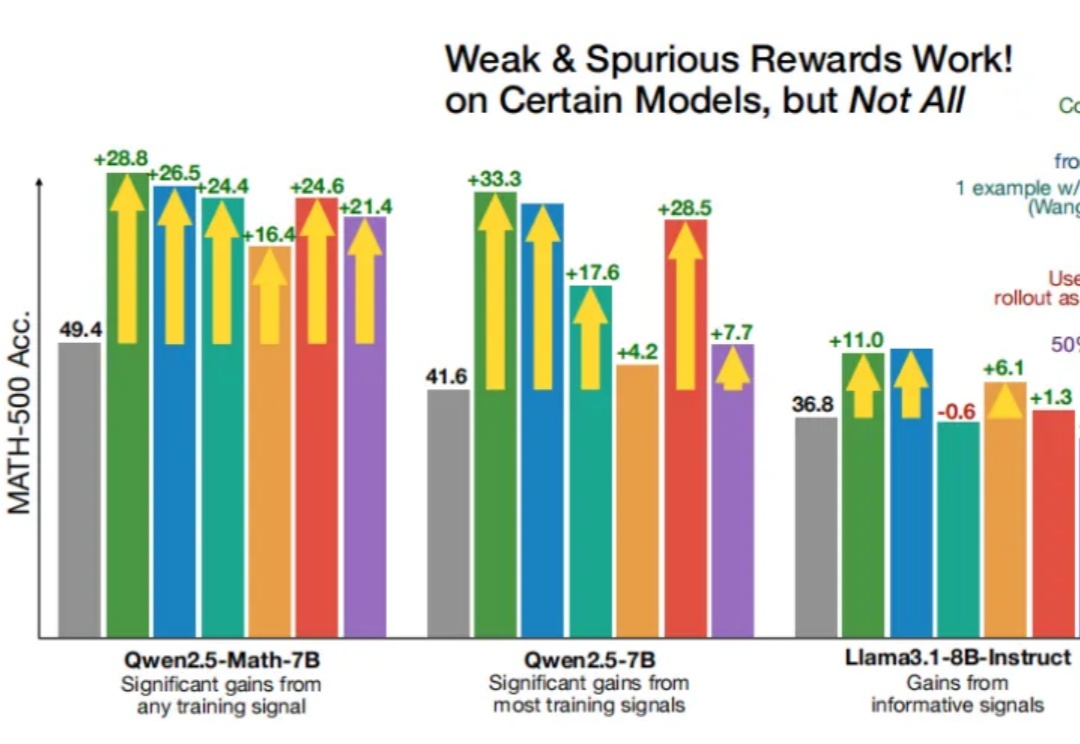

即使RLVR(可验证奖励强化学习)使用错误的奖励信号,Qwen性能也能得到显著提升?

信息检索能力对提升大语言模型 (LLMs) 的推理表现至关重要,近期研究尝试引入强化学习 (RL) 框架激活 LLMs 主动搜集信息的能力,但现有方法在训练过程中面临两大核心挑战:

来自华盛顿大学、AI2、UC伯克利研究团队证实,「伪奖励」(Spurious Rewards)也能带来LLM推理能力提升的惊喜。

你有没有遇到过这样的算力困境:买了 GPU,用不了几次就闲置烧钱,偶尔想用的时候却一卡难求?