NeurIPS Spotlight|运动遮挡都不怕,0先验、一段视频精准预测相机参数

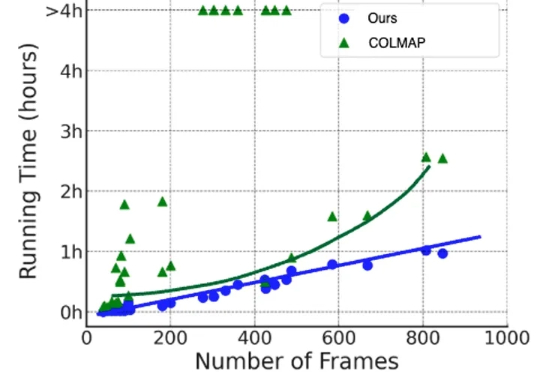

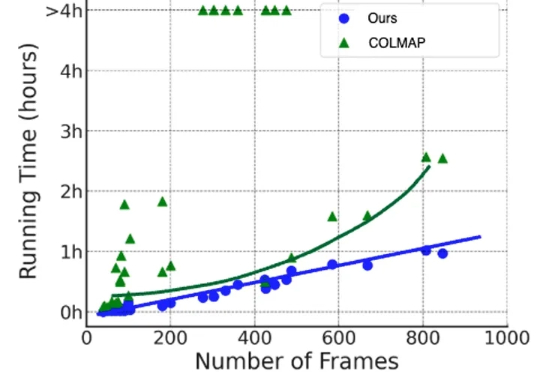

NeurIPS Spotlight|运动遮挡都不怕,0先验、一段视频精准预测相机参数在三维重建、NeRF 训练、视频生成等任务中,相机参数是不可或缺的先验信息。传统的 SfM/SLAM 方法(如 COLMAP)在静态场景下表现优异,但在存在人车运动、物体遮挡的动态场景中往往力不从心,并且依赖额外的运动掩码、深度或点云信息,使用门槛较高,而且效率低下。

在三维重建、NeRF 训练、视频生成等任务中,相机参数是不可或缺的先验信息。传统的 SfM/SLAM 方法(如 COLMAP)在静态场景下表现优异,但在存在人车运动、物体遮挡的动态场景中往往力不从心,并且依赖额外的运动掩码、深度或点云信息,使用门槛较高,而且效率低下。

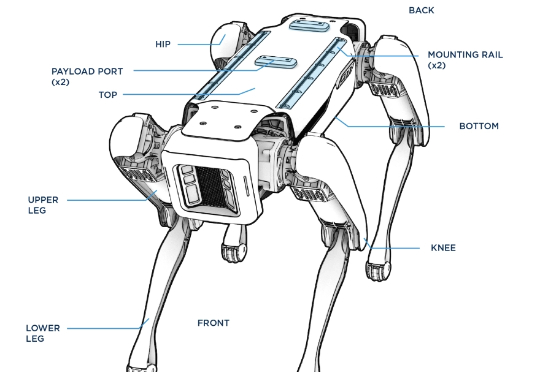

刚刚,风头被中国机器人盖过的波士顿动力,又整了个大活!前后空翻我还能理解,这侧空翻?(不是哥们,你真会啊!)他们先在仿真环境中进行强化学习,一旦策略出现问题,那么他们就将其部署在真机上进行测试,观察问题,然后反复测试迭代,加强Spot的稳定性。

苹果已悄然成立代号「AKI」(Answers, Knowledge & Information)新团队,致力打造类ChatGPT的「答案引擎」,可整合网页信息直接生成回答,计划嵌入Siri、Safari、Spotlight等系统核心功能。这是苹果重塑AI搜索主控权的重大举措。

我非常不理解为什么有AI创业者选择播客赛道。 音频播客是一个非常小众的市场。小宇宙日活只有几百万,基本只有一线城市白领收听。就算是海外市场,Spotify都不能靠播客盈利,播客只会拖累其利润。 AI播客更是一个纯粹的、非常伪的伪命题。

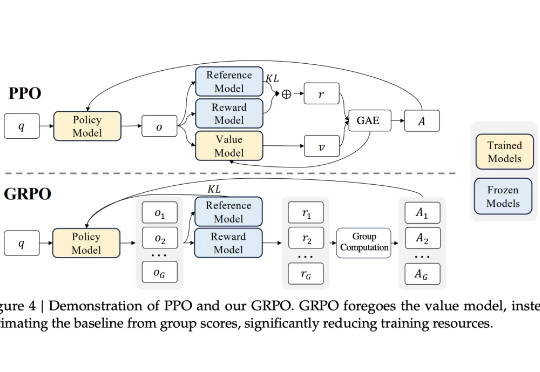

众所周知,大型语言模型的训练通常分为两个阶段。第一阶段是「预训练」,开发者利用大规模文本数据集训练模型,让它学会预测句子中的下一个词。第二阶段是「后训练」,旨在教会模型如何更好地理解和执行人类指令。

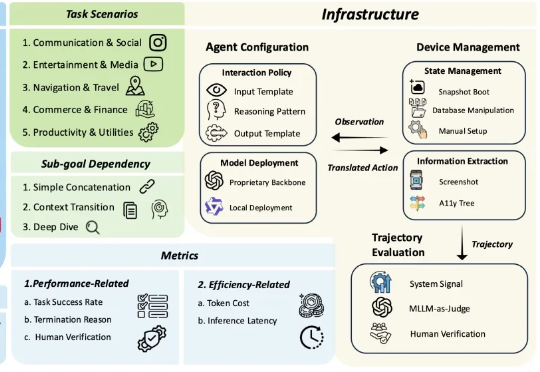

多模态大模型 (MLLM) 驱动的 OS 智能体在单屏动作落实(如 ScreenSpot)、短链操作任务(如 AndroidControl)上展现出突出的表现,标志着端侧任务自动化的初步成熟。

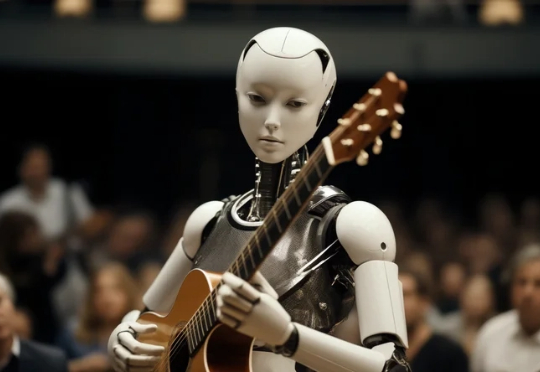

AI音乐人如Aventhis在Spotify等平台走红,由Suno等AI工具生成,引发版权归属模糊、收入被分流及平台默许传播争议。规则滞后于技术,Deezer等开始限制以保护人类创作者,但真假边界模糊威胁音乐产业生态。

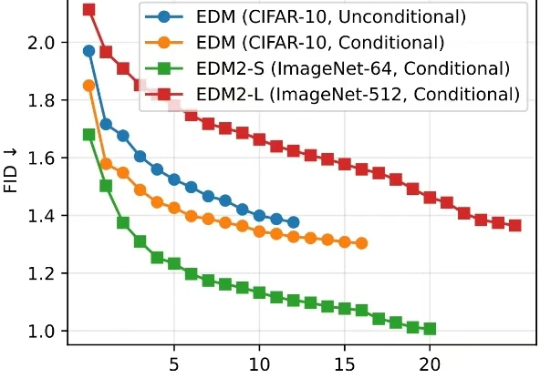

清华大学朱军教授团队与 NVIDIA Deep Imagination 研究组联合提出一种全新的视觉生成模型优化范式 —— 直接判别优化(DDO)。

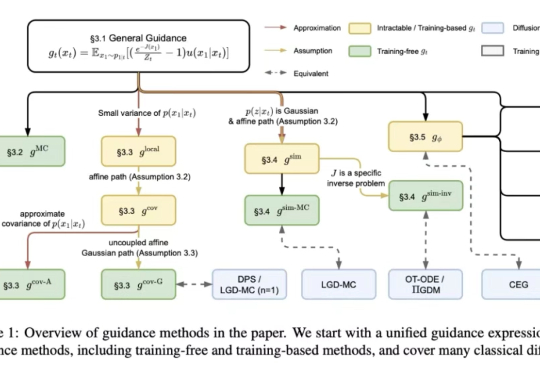

在解决离线强化学习、图片逆问题等任务中,对生成模型的能量引导(energy guidance)是一种可控的生成方法,它构造灵活,适用于各种任务,且允许无额外训练条件生成模型。同时流匹配(flow matching)框架作为一种生成模型,近期在分子生成、图片生成等领域中已经展现出巨大潜力。

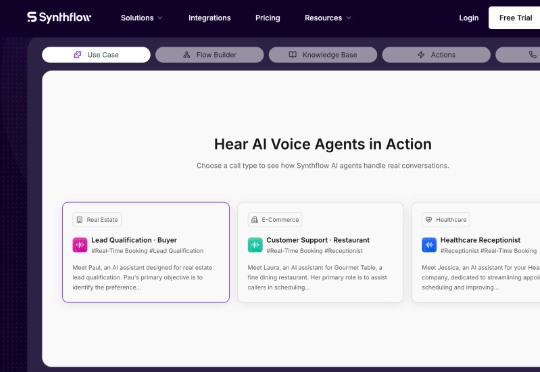

杜塞尔多夫讯,AI初创企业Synthflow近日完成2000万美元(约合人民币1.45亿元)融资。此次A轮融资由美国投资机构安克创投(Accel)领投,该机构曾投资支付平台Klarna、流媒体Spotify及流程优化软件Celonis。现有投资方Atlantic Labs和Singular也参与本轮注资。《商报》独家获悉此消息。