Meta:AI基础设施的未来(演讲/PPT)

Meta:AI基础设施的未来(演讲/PPT)在2024年AI Infra @Scale会议上发表开幕主旨演讲

在2024年AI Infra @Scale会议上发表开幕主旨演讲

近日,OpenAI现任董事会主席、AI初创公司Sierra创始人Bret Taylor做客播客节目Masters of Scale,与主持人Reid Hoffman就AI对商业社会的影响、创业经验以及科技公司的社会责任等话题展开讨论。

第一次拜访K-Scale Labs的时候,好像走进了美剧《硅谷》的拍摄现场。

Scale AI 的创始人 8 年前意识到,所有干 AI 的都认为数据至关重要,但没多少人把数据当成主业。

亚历山大·王从麻省理工学院辍学后开始创业,25岁被《福布斯》评为“世界上最年轻的白手起家的亿万美元富翁”。

市值140亿美元的初创公司Scale AI正在招聘博士训练LLM,用人成本的升高让该公司的毛利率在2023年有所下降,但创始人Alexandr Wang预计今年营收将增加两倍,突破十亿美元。

背后“包工头”,身价估值过百亿美元。

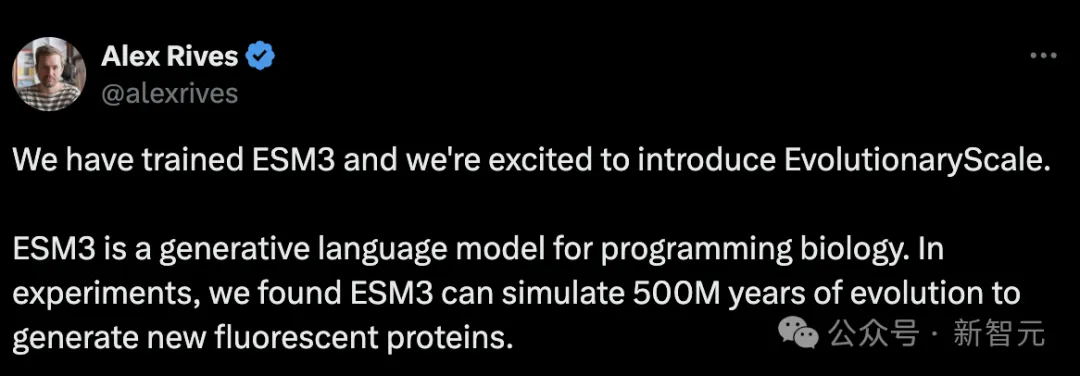

前Meta老将开发蛋白质生成式AI模型 ESM3。

从MIT辍学后,华裔少年Alexandr Wang开始建立自己的初创公司,从此开始走向人生巅峰。押对数据标注方向后,他在27岁时就成为了亿万富翁。The Information刚刚发了长文,爆料了Wang的公司崛起的内幕。

能抗衡AlphaFold 3的生命科学大模型终于出现了。初创公司Evolutionary Scale AI发布了他们最新的98B参数蛋白质语言模型ESM3。不仅支持序列、结构、功能的all-to-all推理,团队还在实验中发现,它设计的新蛋白质相当于模拟自然界5亿年的进化。