苹果加入开源大战,官宣端侧小模型OpenELM!参数2.7亿到30亿一台M2 Mac可跑

苹果加入开源大战,官宣端侧小模型OpenELM!参数2.7亿到30亿一台M2 Mac可跑从Llama 3到Phi-3,蹭着开源热乎劲儿,苹果也来搞事情了。

从Llama 3到Phi-3,蹭着开源热乎劲儿,苹果也来搞事情了。

近年来,多模态大型语言模型(MLLM)在各个领域的应用取得了显著的成功。然而,作为许多下游任务的基础模型,当前的 MLLM 由众所周知的 Transformer 网络构成,这种网络具有较低效的二次计算复杂度。

Transformers 的二次复杂度和弱长度外推限制了它们扩展到长序列的能力,虽然存在线性注意力和状态空间模型等次二次解决方案

继Mamba之后,又一敢于挑战Transformer的架构诞生了!

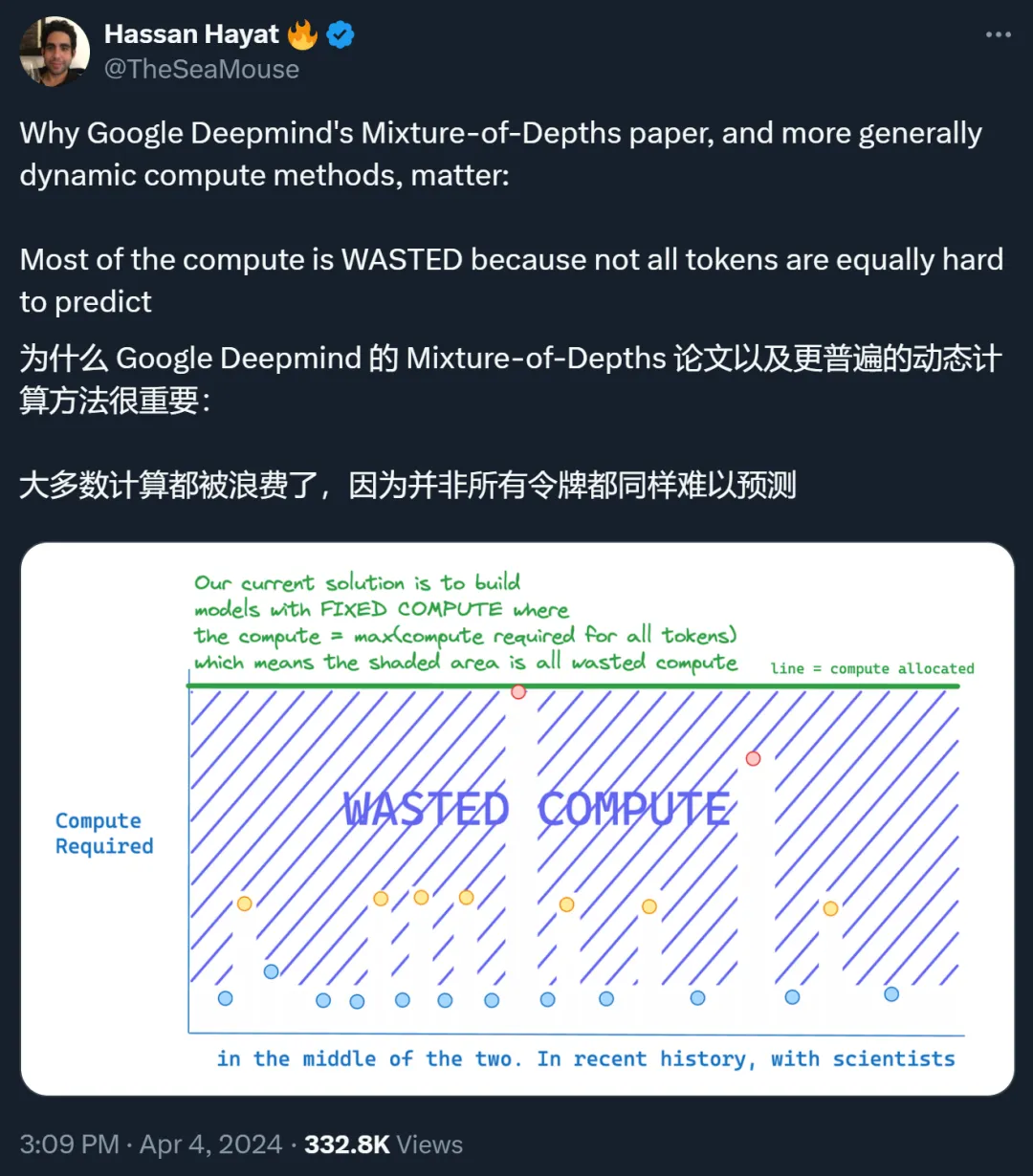

Transformer 的重要性无需多言,目前也有很多研究团队致力于改进这种变革性技术,其中一个重要的改进方向是提升 Transformer 的效率,比如让其具备自适应计算能力,从而可以节省下不必要的计算。

提出图像生成新范式,从预测下一个token变成预测下一级分辨率,效果超越Sora核心组件Diffusion Transformer(DiT

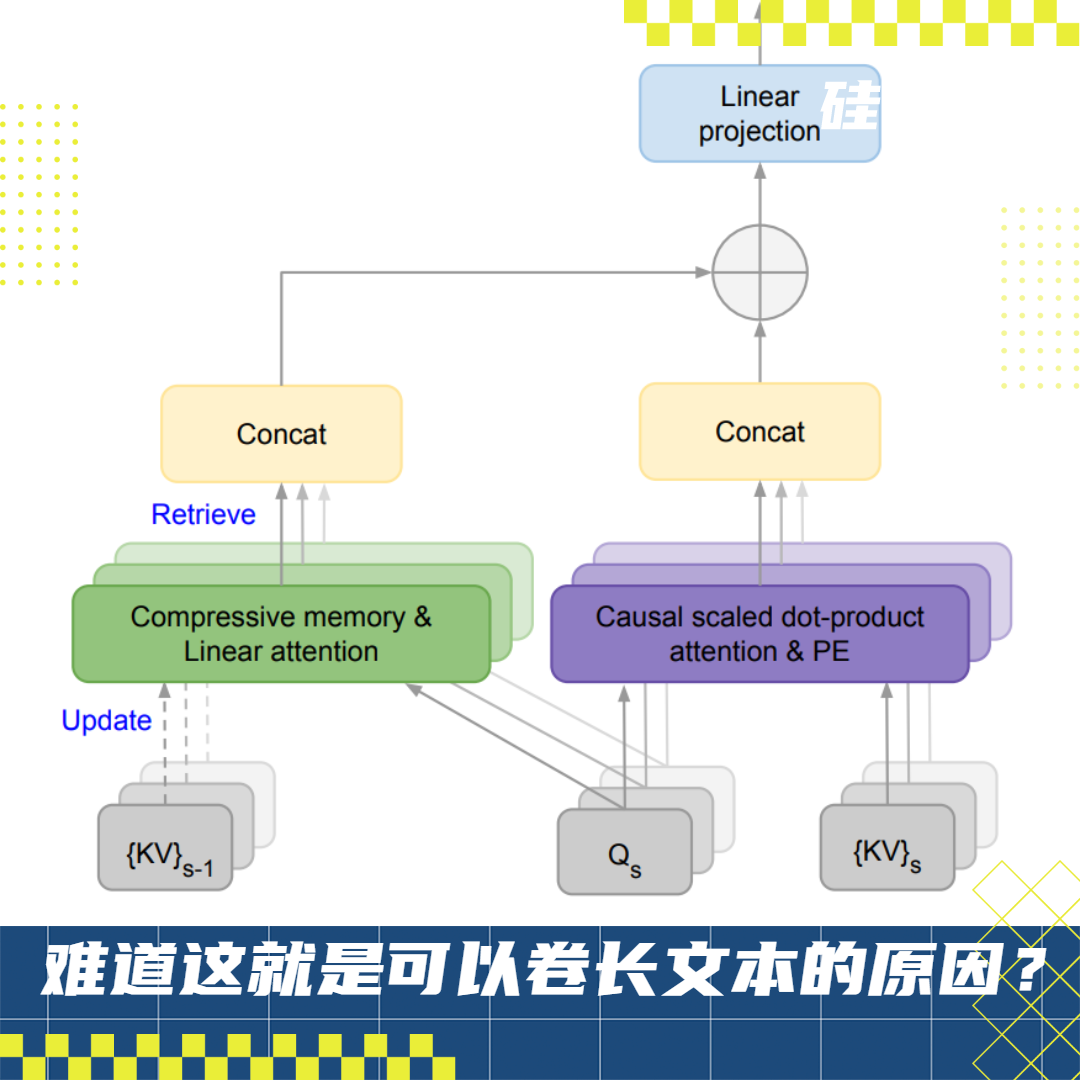

通过这项技术,能使transformer大模型在有限的计算资源 条件下,处理无限长度的输入。

为解决大模型(LLMs)在处理超长输入序列时遇到的内存限制问题,本文作者提出了一种新型架构:Infini-Transformer,它可以在有限内存条件下,让基于Transformer的大语言模型(LLMs)高效处理无限长的输入序列。实验结果表明:Infini-Transformer在长上下文语言建模任务上超越了基线模型,内存最高可节约114倍。

它通过将压缩记忆(compressive memory)整合到线性注意力机制中,用来处理无限长上下文

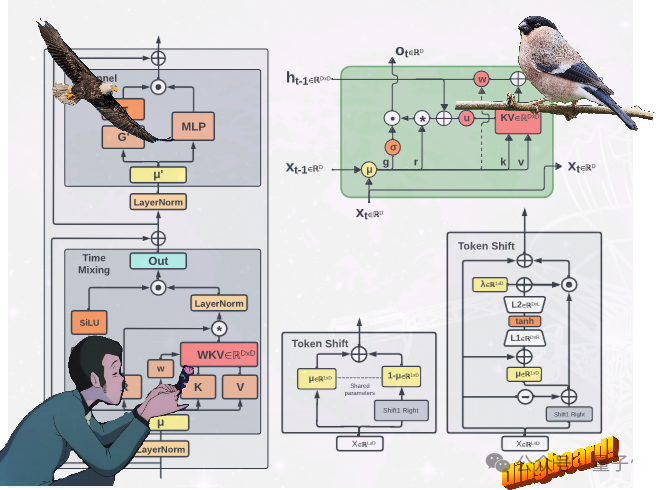

不走Transformer寻常路,魔改RNN的国产新架构RWKV,有了新进展: 提出了两种新的RWKV架构,即Eagle (RWKV-5) 和Finch(RWKV-6)。