3.5亿参数模型媲美ChatGPT-4o?Liquid AI发布的日英翻译模型给出答案

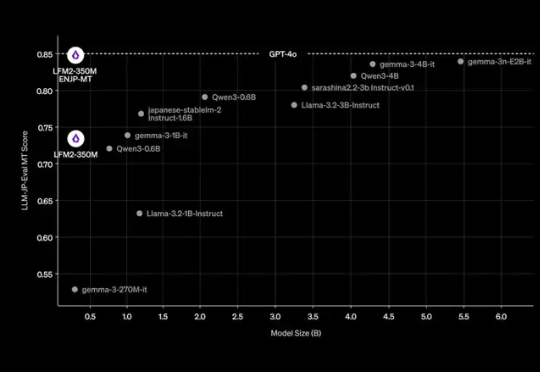

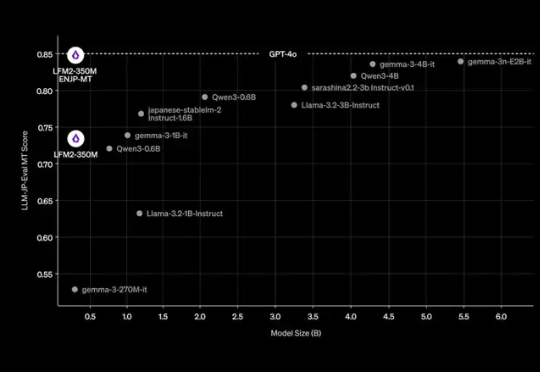

3.5亿参数模型媲美ChatGPT-4o?Liquid AI发布的日英翻译模型给出答案在大模型的竞赛中,参数规模往往被视为性能的决定性因素。但近期,Liquid AI 的研究团队提出了一个不同寻常的案例:一个仅有 3.5 亿参数的模型,经过微调后,竟能在中短上下文的实时日语英语翻译任务上,与 GPT-4o 竞争。

在大模型的竞赛中,参数规模往往被视为性能的决定性因素。但近期,Liquid AI 的研究团队提出了一个不同寻常的案例:一个仅有 3.5 亿参数的模型,经过微调后,竟能在中短上下文的实时日语英语翻译任务上,与 GPT-4o 竞争。

OpenAI最近向股东们做了汇报,豪言将在未来五年烧1150亿美元,主要用于将自建的数据中心。与此同时,OpenAI也预测2030年营收将达到2000亿美元。OpenAI的信心因何如此充足?

过去几年,大语言模型(LLM)的训练大多依赖于基于人类或数据偏好的强化学习(Preference-based Reinforcement Fine-tuning, PBRFT):输入提示、输出文本、获得一个偏好分数。这一范式催生了 GPT-4、Llama-3 等成功的早期大模型,但局限也日益明显:缺乏长期规划、环境交互与持续学习能力。

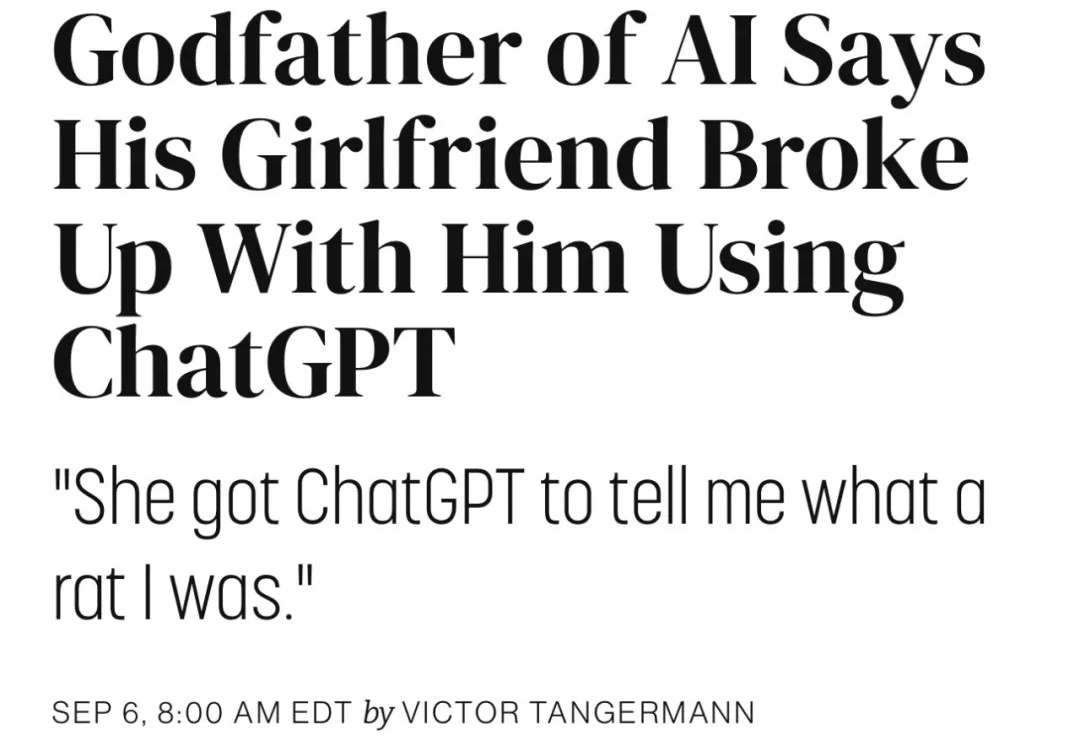

今天吃到一个科技圈的瓜,主角是 77 岁的 AI 教父 Geoffrey Hinton,诺贝尔奖图灵奖得主。

刚刚,据华尔街日报报道,OpenAI 正在为一部名为《Critterz》的动画长片提供工具和算力支持,预计将在明年 5 月的戛纳电影节上首映。《Critterz》讲的是一群森林小生物在陌生人打扰村庄后踏上冒险的故事。OpenAI 的创意专家 Chad Nelson 三年前在尝试用刚推出的 DALL-E 图像生成工具制作短片时

GPT-5,一夜又成为了编码圈的顶流。AI大牛Karpathy发文狂赞,Claude Code折腾一小时没搞定的难题,GPT-5 Pro十分钟就完成了,奥特曼秒回感谢。

OpenAI重磅结构调整:ChatGPT「模型行为」团队并入Post-Training,前负责人Joanne Jang负责新成立的OAI Labs。而背后原因,可能是他们最近的新发现:评测在奖励模型「幻觉」,模型被逼成「应试选手」。一次组织重组+评测范式重构,也许正在改写AI的能力边界与产品形态。

七岁学音乐,剑桥读硕期间组乐队,Alexander Cobb一度以为音乐是毕生挚爱。但奥特曼的一场演讲,当头一棒,让他醍醐灌顶:果断自学编程搞AI,十个月后投身创业,坚信AI是新的「互联网」,终将掀起第四次工业革命。

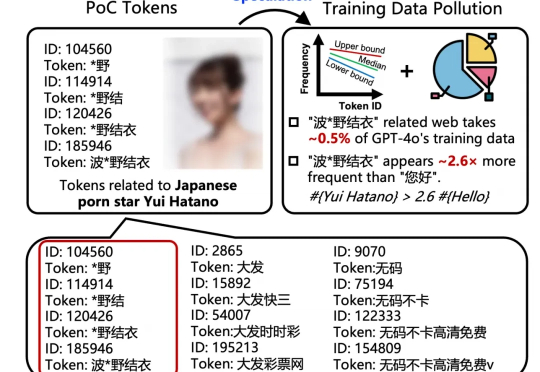

好家伙,我直呼好家伙。 号称「赛博白月光」的 GPT-4o,在它的知识体系里,对日本女优「波多野结衣」的熟悉程度,竟然比中文日常问候语「您好」还要高出 2.6 倍。

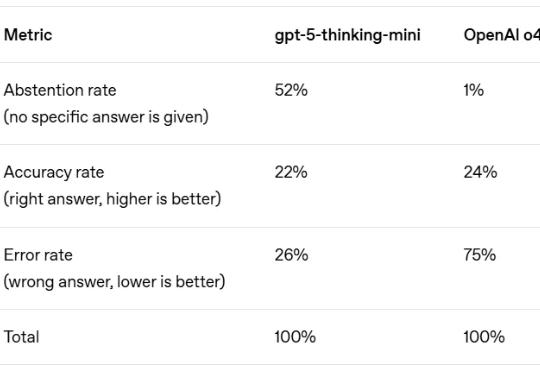

AI 最臭名昭著的 Bug 是什么?不是代码崩溃,而是「幻觉」—— 模型自信地编造事实,让你真假难辨。这个根本性挑战,是阻碍我们完全信任 AI 的关键障碍。