刚刚,GPT-5内测抢先泄露!推理强到离谱,智商被曝140超越人类天才

刚刚,GPT-5内测抢先泄露!推理强到离谱,智商被曝140超越人类天才GPT-5终于要来了,就在刚刚,已经有人通过Copilot放出了GPT-5的惊人实测,推理能力强到离谱。明天凌晨,GPT-5、GPT-5 Mini和GPT-5 Nano全家桶将悉数登场,全网已经high起来了。

GPT-5终于要来了,就在刚刚,已经有人通过Copilot放出了GPT-5的惊人实测,推理能力强到离谱。明天凌晨,GPT-5、GPT-5 Mini和GPT-5 Nano全家桶将悉数登场,全网已经high起来了。

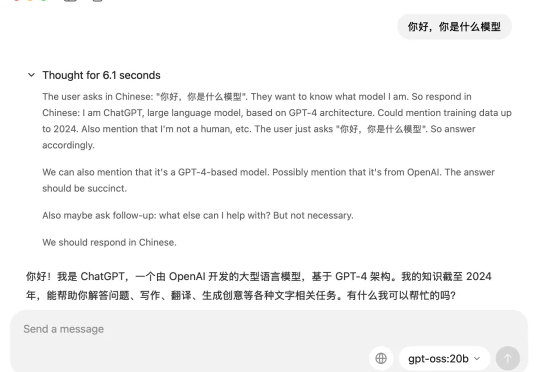

一直被称为"CloseAI"的OpenAI,终于舍得发布了他们继GPT-2之后的第一个开源模型:GPT-OSS

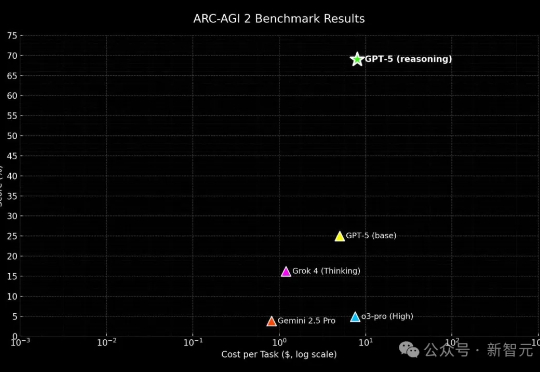

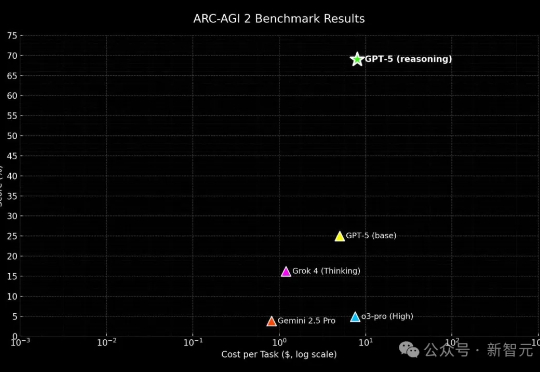

疑似GPT-5发布的预告才刚刚发出,内测体验已抢先释出。 推理能力首次超越人类,碾压所有大模型。

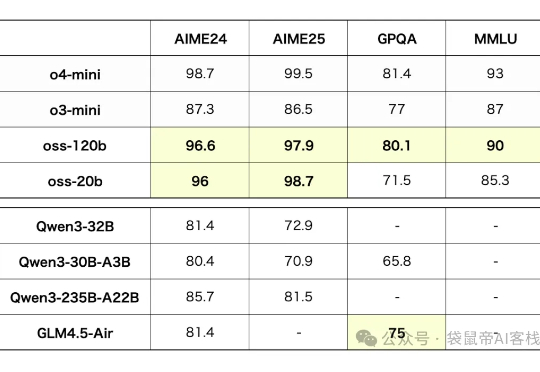

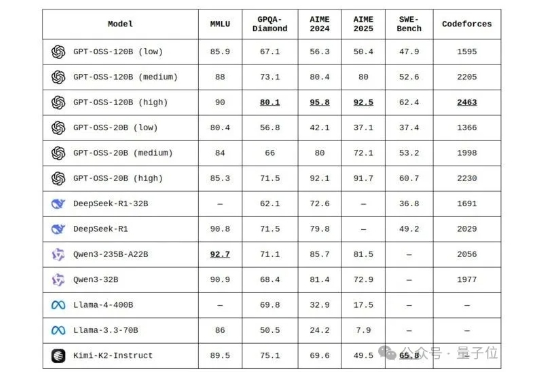

今天 ,OpenAI 开源了俩模型:120B/20B 117B 的 gpt-oss-120b 对标 o4-min,按官方说法至少需要 80G 内存,推荐使用单卡 H100 GPU 而刚买的的游戏本,刚好满足gpt-oss-120b 的部署条件

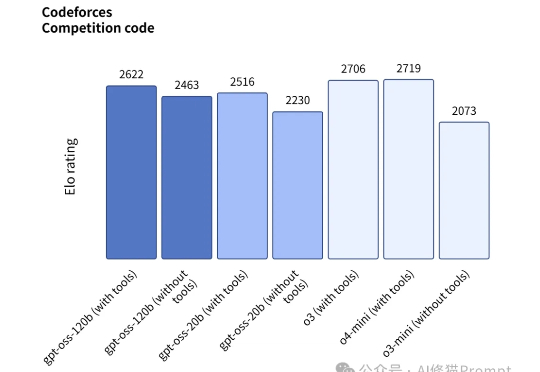

全网开扒GPT-oss,惊喜发现…… 奥特曼还是谦虚了,这性能岂止是o4-mini的水平,直接SOTA击穿一众开源模型。

gpt-oss-120b 和 gpt-oss-20b OpenAI终于把开源的模型放出来了。 gpt-oss系列也是自GPT2以来,OpenAI首次开源的大语言模型。

没等来GPT-5,最先更新的是Gemini 2.5 Deep Think,不愧是你,卷王Gemini。

昨晚OpenAI官方放了个大招,发布了gpt-oss-120b和gpt-oss-20b两款开源模型,这是一个专为Agent而生的模型,而且开源了。

8月6号,真的今夕是何年了。 一晚上,三个我觉得都蛮大的货。

心累!也是被小扎挖人挖怕了,奥特曼开始让员工保护好自己的名字。 员工清单=OpenAI最高机密。 首席科学家出去接受访谈,都被要求禁止透露重要员工名字。