反击AI论文!arXiv每年拒掉2%造假内容,自动化工具加入审核

反击AI论文!arXiv每年拒掉2%造假内容,自动化工具加入审核AI生成论文泛滥成灾,arXiv平台看不下去了—— 紧急升级审核机制,用自动化工具来检测AI生成内容。 Nature最新发现,原来每年竟然都有2%的论文会因为AI使用被拒?! 比如像,bioRxiv和medRxiv每天都要拒绝十多篇公式化AI手稿,每个月就高达7000多份。

AI生成论文泛滥成灾,arXiv平台看不下去了—— 紧急升级审核机制,用自动化工具来检测AI生成内容。 Nature最新发现,原来每年竟然都有2%的论文会因为AI使用被拒?! 比如像,bioRxiv和medRxiv每天都要拒绝十多篇公式化AI手稿,每个月就高达7000多份。

Notion 可以说是最早一批在产品内落地 AI 的公司了。 2023 年 2 月就上线了 Notion AI,甚至早于 GPT-4 的发布。后续又陆续了发布了 Q&A 、Meeting Notes、企业搜索、AI for Work 等功能。

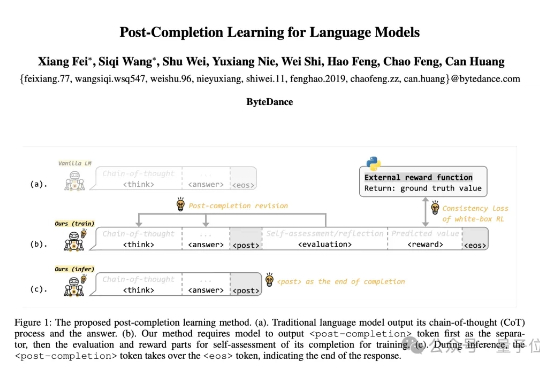

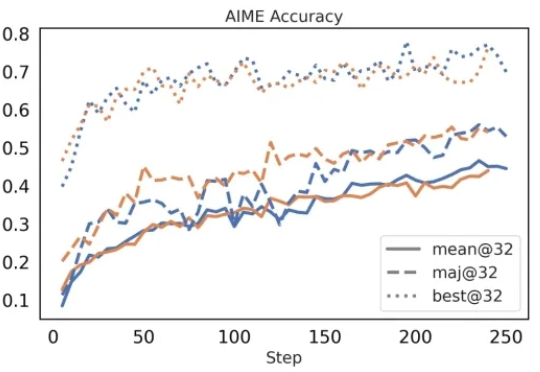

首次实现“训练-推理不对称”,字节团队提出全新的语言模型训练方法:Post-Completion Learning (PCL)。 在训练时让模型对自己的输出结果进行反思和评估,推理时却仅输出答案,将反思能力完全内化。

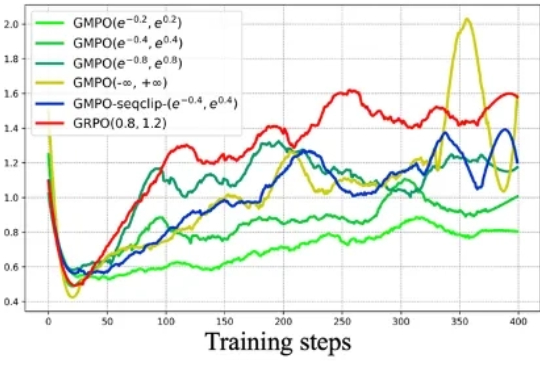

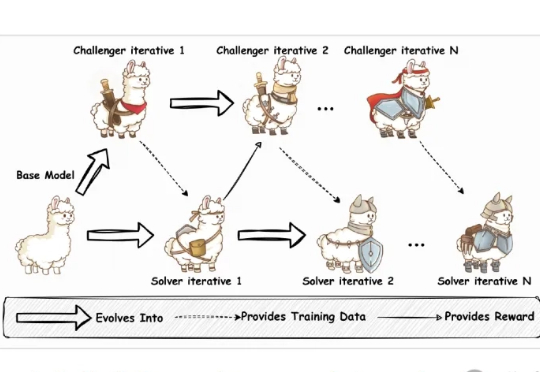

近年来,强化学习(RL)在大型语言模型(LLM)的微调过程中,尤其是在推理能力提升方面,取得了显著的成效。传统的强化学习方法,如近端策略优化(Proximal Policy Optimization,PPO)及其变种,包括组相对策略优化(Group Relative Policy Optimization,GRPO),在处理复杂推理任务时表现出了强大的潜力。

当前训练强大的大语言模型(LLM),就像是培养一个顶尖运动员,需要大量的、由专家(人类标注员)精心设计的训练计划和教材(高质量的标注数据)。

在今年三月份,清华 AIR 和字节联合 SIA Lab 发布了 DAPO,即 Decoupled Clip and Dynamic sAmpling Policy Optimization(解耦剪辑和动态采样策略优化)。

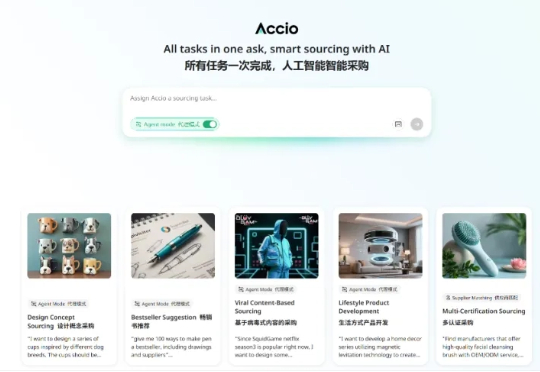

全世界可能是第一个,能做生意的Agent来了。 这,就是阿里国际站最近升级的Accio Agent。

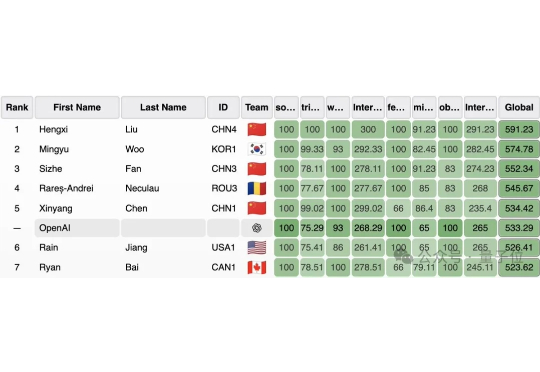

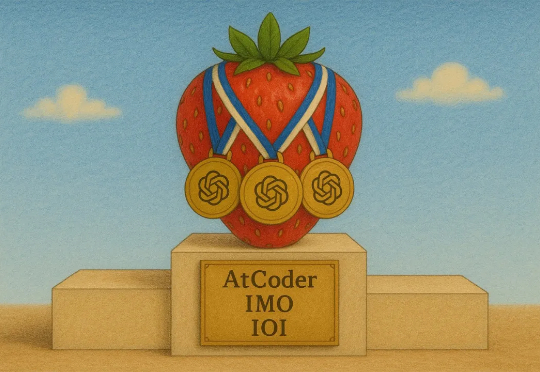

刚刚,OpenAI官宣:IOI金牌收入囊中! 其推理模型在今年IOI线上竞赛中成绩刷新纪录: 总分533.29,在全球330名人类选手中总排名位列第六;而在所有AI参赛者中,稳居第一。

一觉醒来,OpenAI 的大模型又完成了一项壮举!在全球顶级编程赛事之一 ——2025 年国际信息学奥林匹克(IOI)中,OpenAI 的推理模型取得了足以摘得金牌的高分,并在 AI 参赛者中排名第一!

近年来,文生图模型(Text-to-Image Models)飞速发展,从早期的 GAN 架构到如今的扩散和自回归模型,生成图像的质量和细节表现力实现了跨越式提升。这些模型大大降低了高质量图像创作的门槛,为设计、教育、艺术创作等领域带来了前所未有的便利。