90分钟生成10万Token,新框架实现3倍无损加速超长文本生成,支持DeepSeek-R1和QwQ!

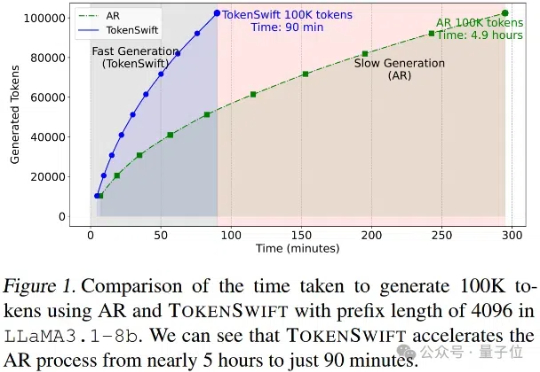

90分钟生成10万Token,新框架实现3倍无损加速超长文本生成,支持DeepSeek-R1和QwQ!大语言模型长序列文本生成效率新突破——生成10万Token的文本,传统自回归模型需要近5个小时,现在仅需90分钟!

大语言模型长序列文本生成效率新突破——生成10万Token的文本,传统自回归模型需要近5个小时,现在仅需90分钟!

LLM 在生成 long CoT 方面展现出惊人的能力,例如 o1 已能生成长度高达 100K tokens 的序列。然而,这也给 KV cache 的存储带来了严峻挑战。

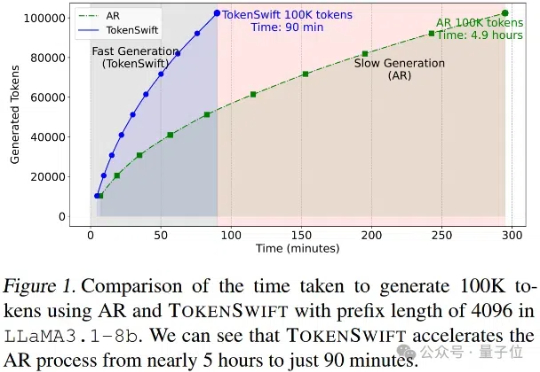

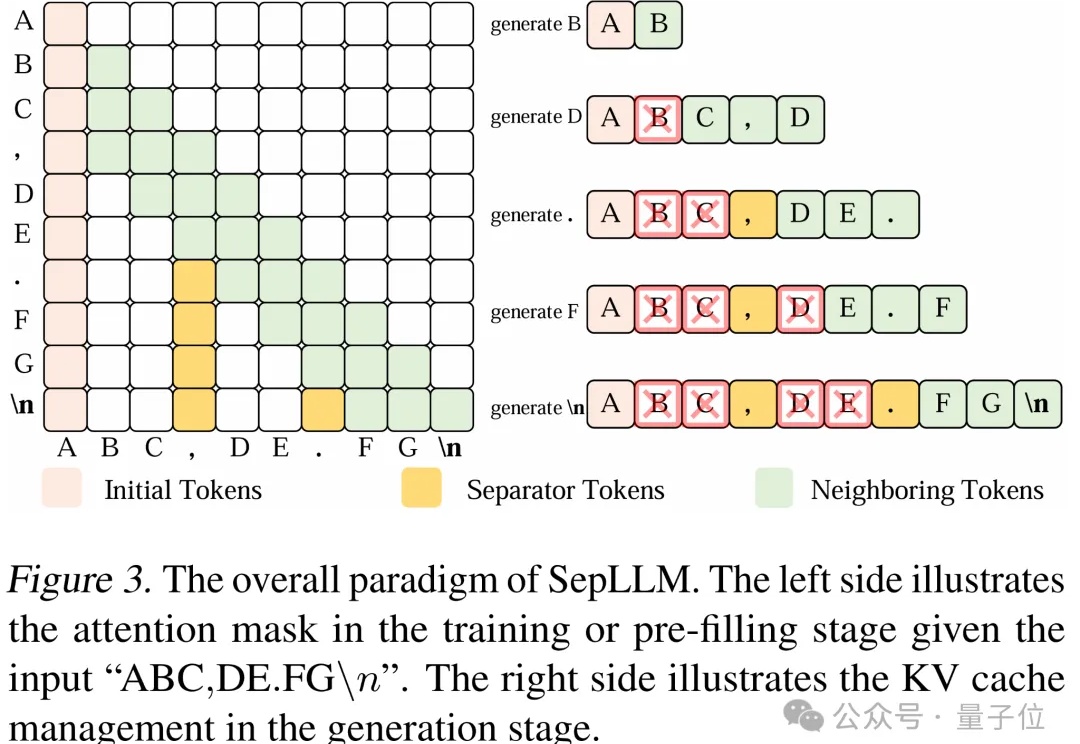

文字中貌似不起眼的标点符号,竟然可以显著加速大模型的训练和推理过程?

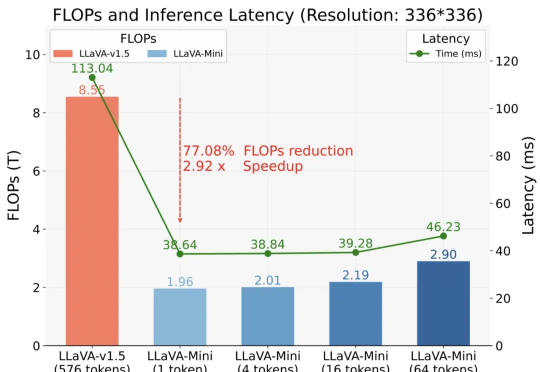

以 GPT-4o 为代表的实时交互多模态大模型(LMMs)引发了研究者对高效 LMM 的广泛关注。现有主流模型通过将视觉输入转化为大量视觉 tokens,并将其嵌入大语言模型(LLM)上下文来实现视觉信息理解。

国产大模型云服务平台SiliconCloud(硅基流动),首发上线了基于华为云昇腾云服务的DeepSeek-V3、DeepSeek-R1。 DeepSeek-V3:输入只需1块钱/M tokens,输出2块钱/M tokens

谈到大模型的“国货之光”,除了DeepSeek之外,阿里云Qwen这边也有新动作——首次将开源Qwen模型的上下文扩展到1M长度。

创立10年内估值超过10亿美元的创新公司,被称之为独角兽,它们是市场潜力无限的绩优股,是为行业带来技术创新、模式创新的佼佼者。

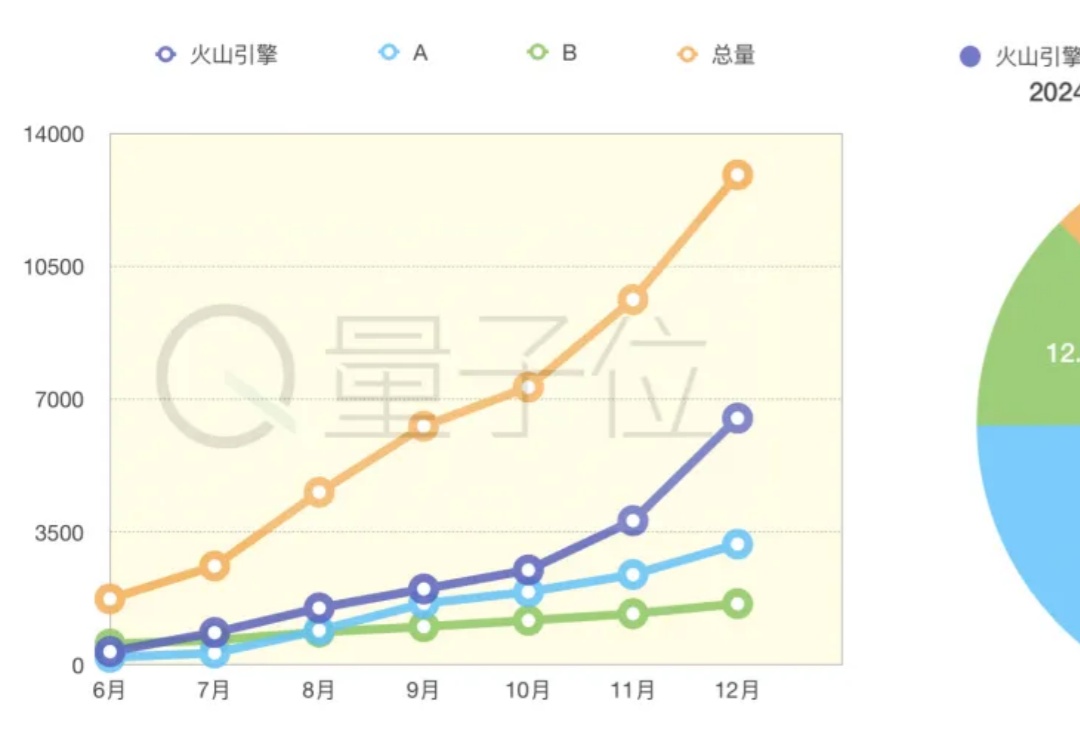

大模型应用落地元年,谁家业务更值得关注?

如果2023年给大模型的关键词是席卷,那么在2024,这个关键词应该是渗透。最常用的软件、手机PC本身、甚至厨卫/电源开源,都在被AI重塑。主观感受中,这一年,AI更加强大,以前所未有的速度嵌入各行各业。

很多大模型的官方参数都声称自己可以输出长达32K tokens的内容,但这数字实际上是存在水分的??