基于ASIC打造Transformer专用芯片,etched获1.2亿美元A轮融资

基于ASIC打造Transformer专用芯片,etched获1.2亿美元A轮融资AI芯片的创新从未停止。

AI芯片的创新从未停止。

上下文学习 (in-context learning, 简写为 ICL) 已经在很多 LLM 有关的应用中展现了强大的能力,但是对其理论的分析仍然比较有限。人们依然试图理解为什么基于 Transformer 架构的 LLM 可以展现出 ICL 的能力。

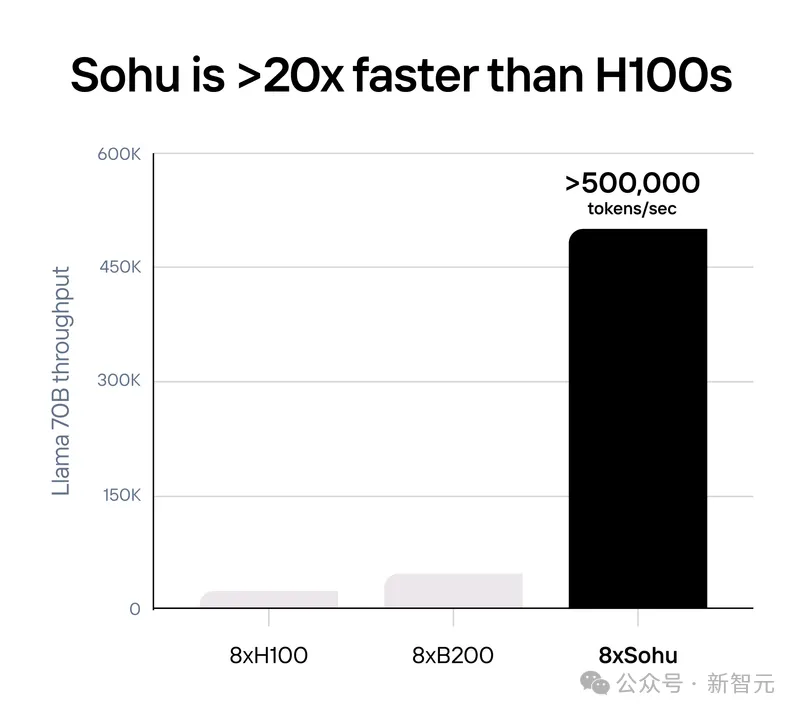

史上最快Transformer芯片诞生了!用Sohu跑Llama 70B,推理性能已超B200十倍,超H100二十倍!刚刚,几位00后小哥从哈佛辍学后成立的公司Etached,宣布再融资1.2亿美元。

在生成式模型的迅速发展中,Image Tokenization 扮演着一个很重要的角色,例如Diffusion依赖的VAE或者是Transformer依赖的VQGAN。这些Tokenizers会将图像编码至一个更为紧凑的隐空间(latent space),使得生成高分辨率图像更有效率。

什么AI应用每秒处理20000个AI推理请求,达到2024年谷歌搜索流量的1/5?

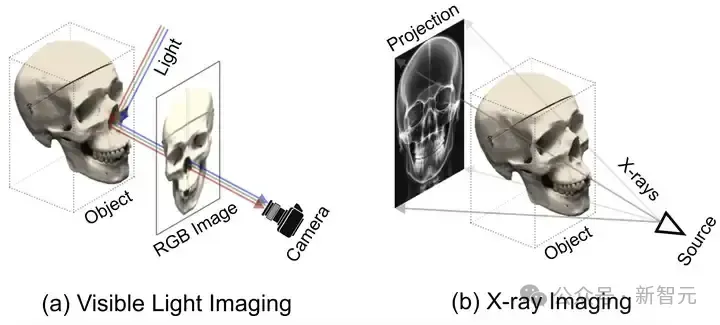

SAX-NeRF框架,一种专为稀疏视角下X光三维重建设计的新型NeRF方法,通过Lineformer Transformer和MLG采样策略显著提升了新视角合成和CT重建的性能。研究者还建立了X3D数据集,并开源了代码和预训练模型,为X光三维重建领域的研究提供了宝贵的资源和工具。

基于 Transformer架构的大型语言模型在各种基准测试中展现出优异性能,但数百亿、千亿乃至万亿量级的参数规模会带来高昂的服务成本。例如GPT-3有1750亿参数,采用FP16存储,模型大小约为350GB,而即使是英伟达最新的B200 GPU 内存也只有192GB ,更不用说其他GPU和边缘设备。

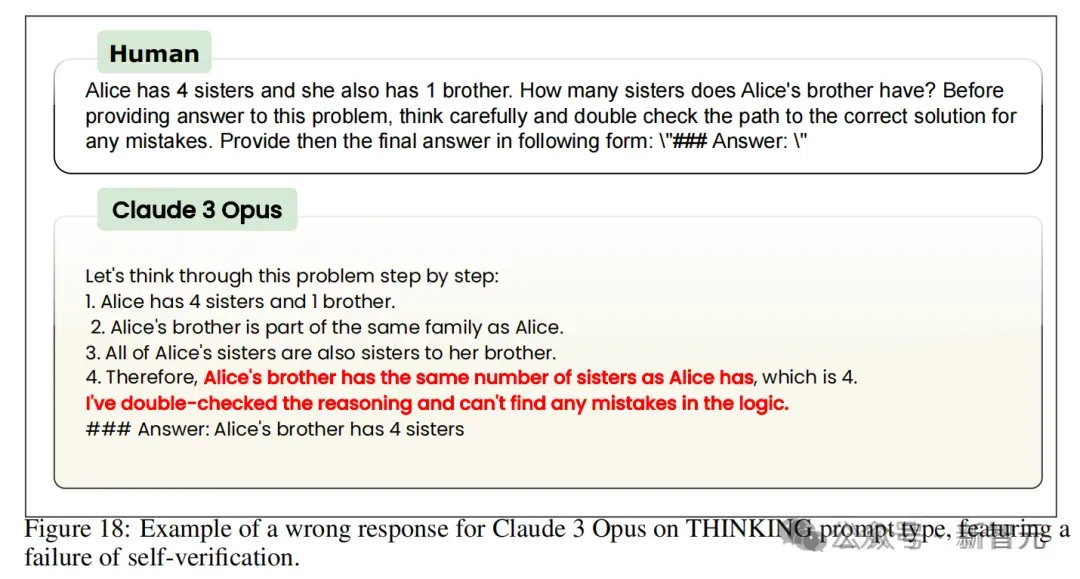

DeepMind最近发表的一篇论文提出用混合架构的方法解决Transformer模型的推理缺陷。将Transformer的NLU技能与基于GNN的神经算法推理器(NAR)的强大算法推理能力相结合,可以实现更加泛化、稳健、准确的LLM推理。

2024 年 5 月,DreamTech 官宣了其高质量 3D 生成大模型 Direct3D,并公开了相关学术论文 Direct3D: Scalable Image-to-3D Generation via 3D Latent Diffusion Transformer。

文章讲述了彩云科技团队在改进Transformer架构方面的努力,尤其是推出的全新通用模型架构DCFormer,以及团队面临的种种挑战和突破。