首款无限Agent Neo深度实测,出道两年半的AI转正了

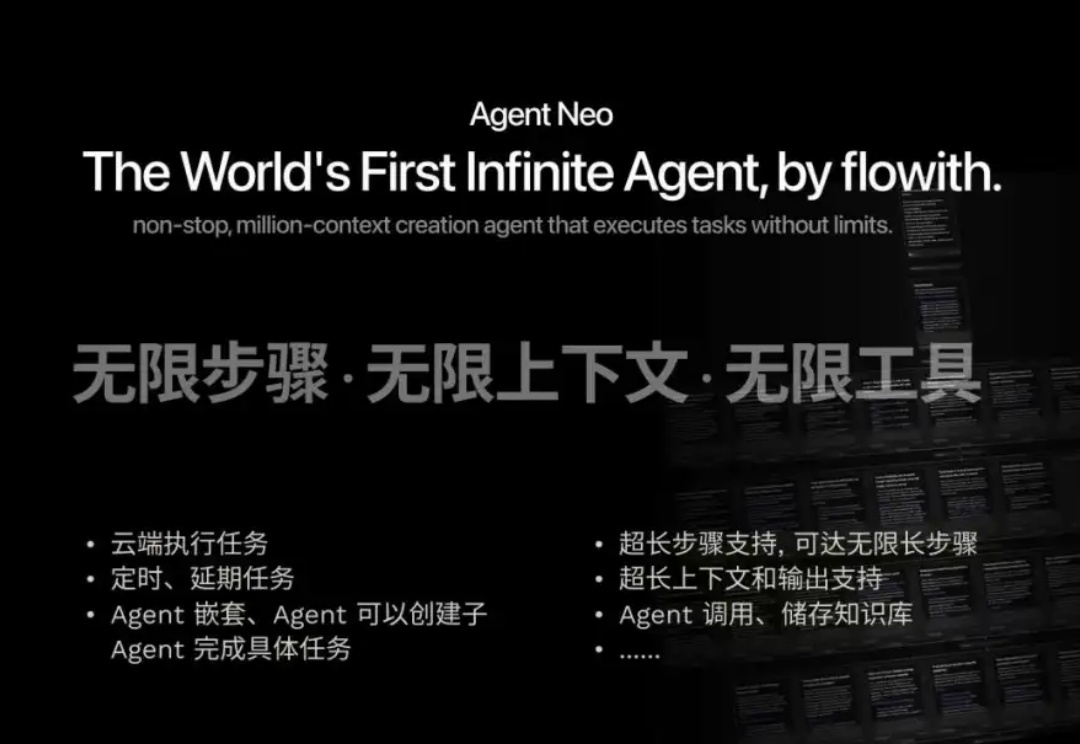

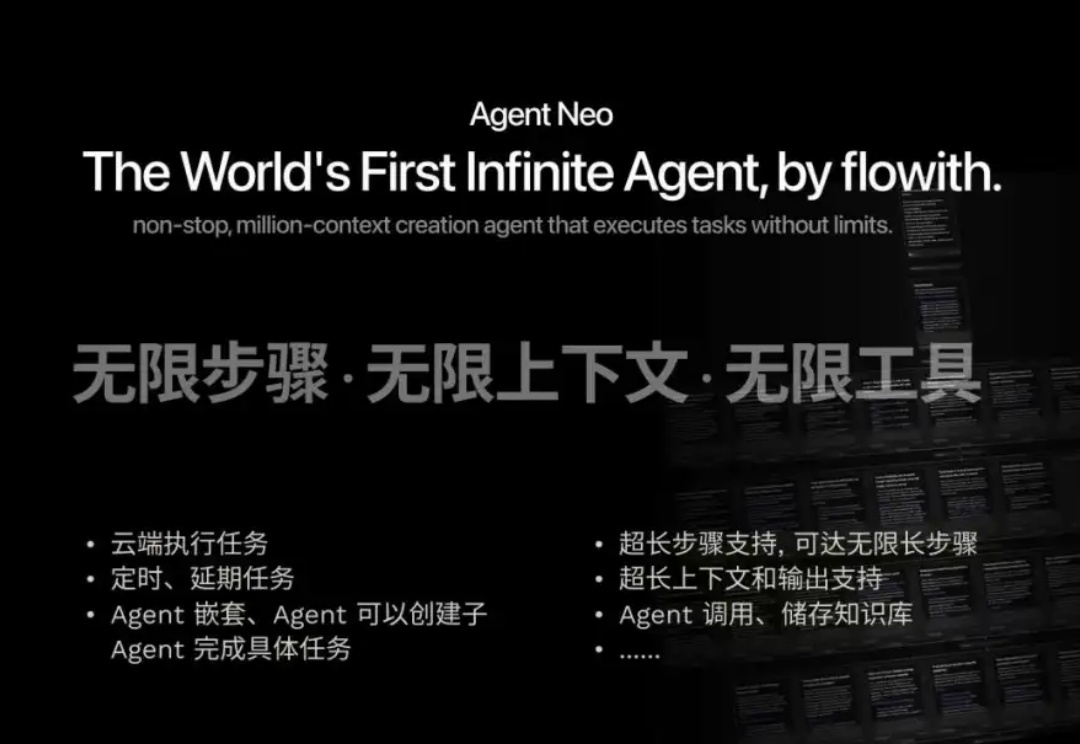

首款无限Agent Neo深度实测,出道两年半的AI转正了AI不再相信人类 关于 Agent, flowith 给出了自己的答案 —— Neo

AI不再相信人类 关于 Agent, flowith 给出了自己的答案 —— Neo

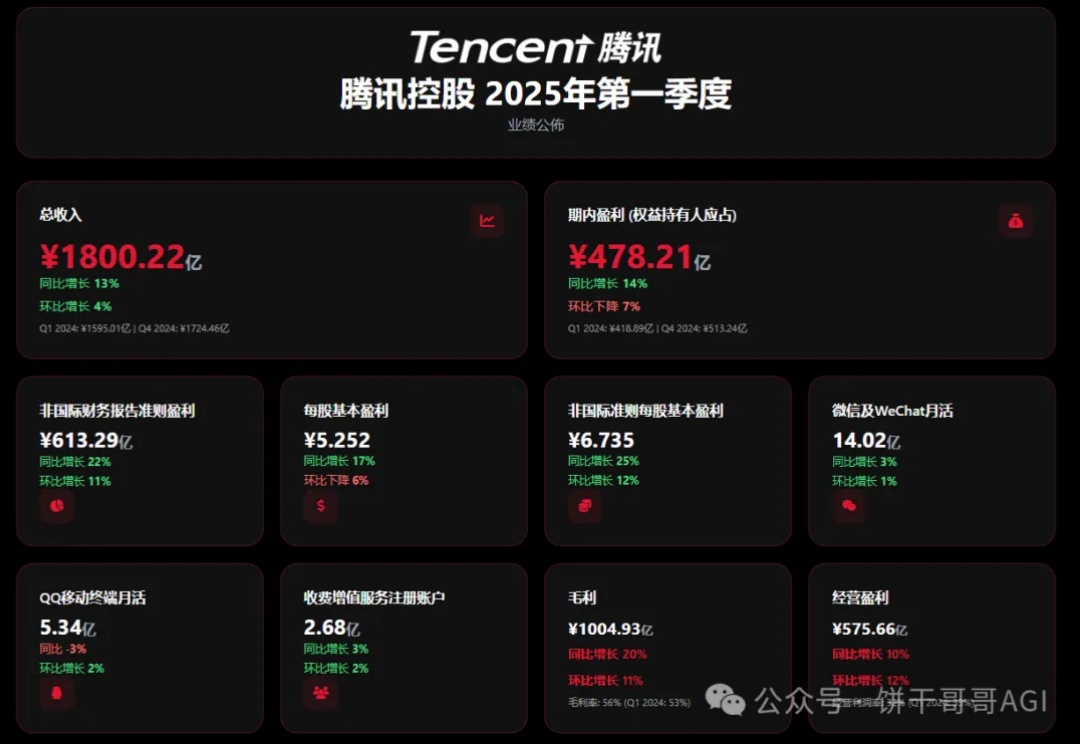

得益于AI上下文和审美能力的提升,现在做HTML已经没什么门槛了,可以应用到很多方面,例如小红书封面、PPT、原型图、数据看板等等。

北京时间5月21日凌晨,谷歌在每年一度的I/O大会上再度炸场——谷歌搜索的AI模式正式上线。其中,最受瞩目的一个功能是Personal Context(个人上下文)。北京时间5月21日凌晨,谷歌在每年一度的I/O大会上再度炸场——谷歌搜索的AI模式正式上线。其中,最受瞩目的一个功能是Personal Context(个人上下文)。

GPT-4.1,在ChatGPT中可用了!现在,它不仅在API中开放,Plus、Pro和Team用户都可以使用。网友们兴奋地展开实测后,纷纷吐槽:OpenAI这是诈骗吧,说好的一百万超长上下文呢?

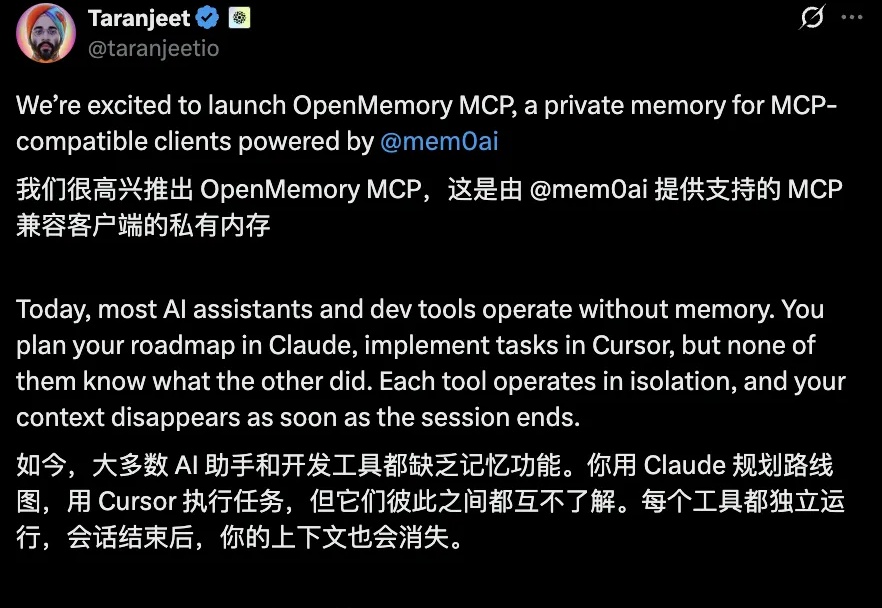

聊完就忘?当下多数AI助手和开发工具各自独立运行,会话结束上下文即消失,严重影响了使用体验和效率。

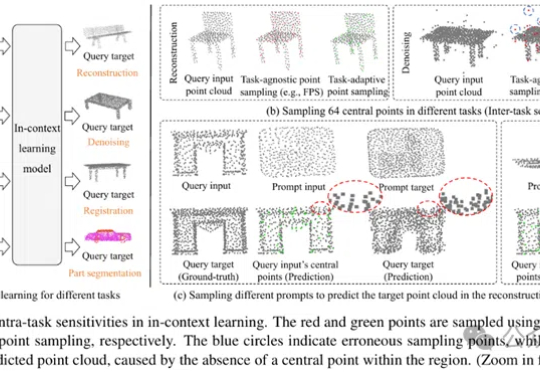

MICAS是一种专为3D点云上下文学习设计的多粒度采样方法,通过任务自适应点采样和查询特定提示采样,提升模型在点云重建、去噪、配准和分割等任务中的稳健性和适应性,显著优于现有技术。

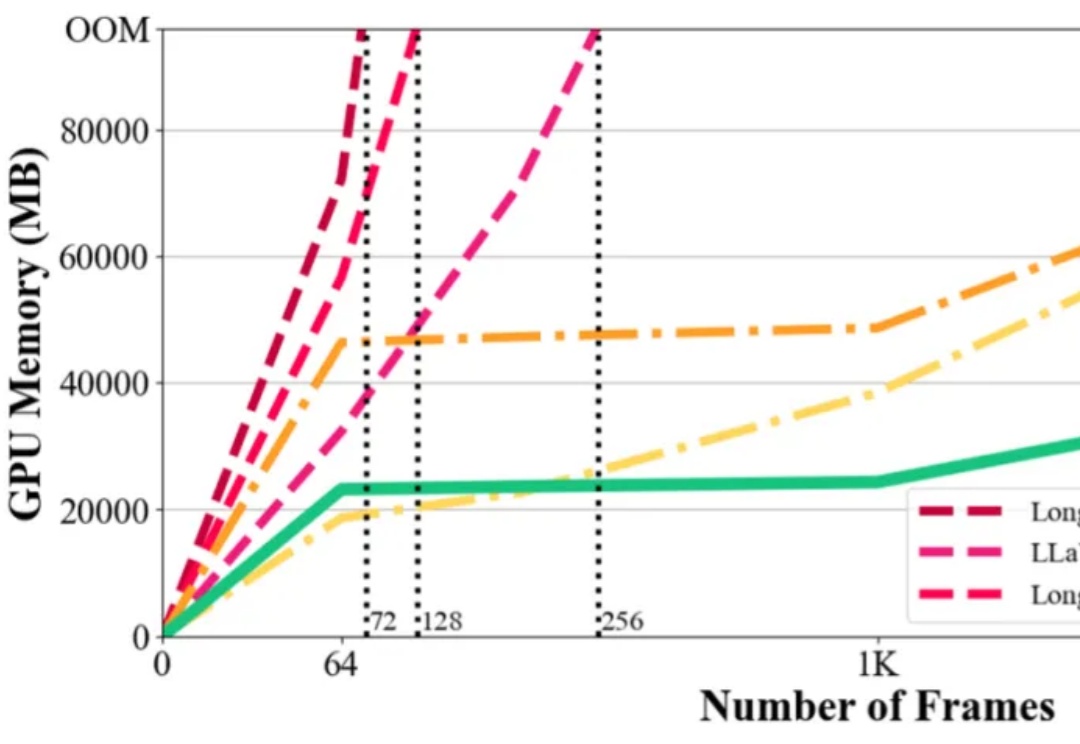

在视觉语言模型(Vision-Language Models,VLMs)取得突破性进展的当下,长视频理解的挑战显得愈发重要。以标准 24 帧率的标清视频为例,仅需数分钟即可产生逾百万的视觉 token,这已远超主流大语言模型 4K-128K 的上下文处理极限。

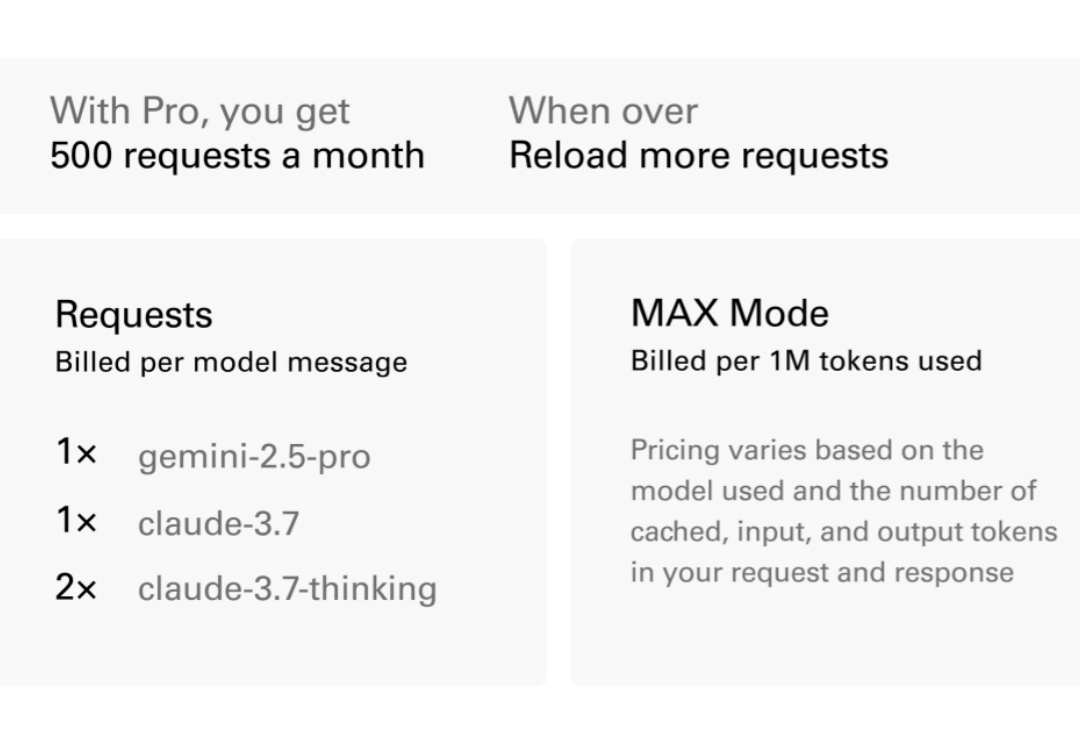

简单来说,Cursor 0.50 版本核心亮点包括:计费模式大统一、Max Mode 能力爆表、超前瞻的后台 Agent、代码库上下文理解MAX、编辑体验丝滑、多项目工作区支持,以及一系列聊天功能优化!设计师们(哦不,是开发者们)估计又要惊呼YYDS了!

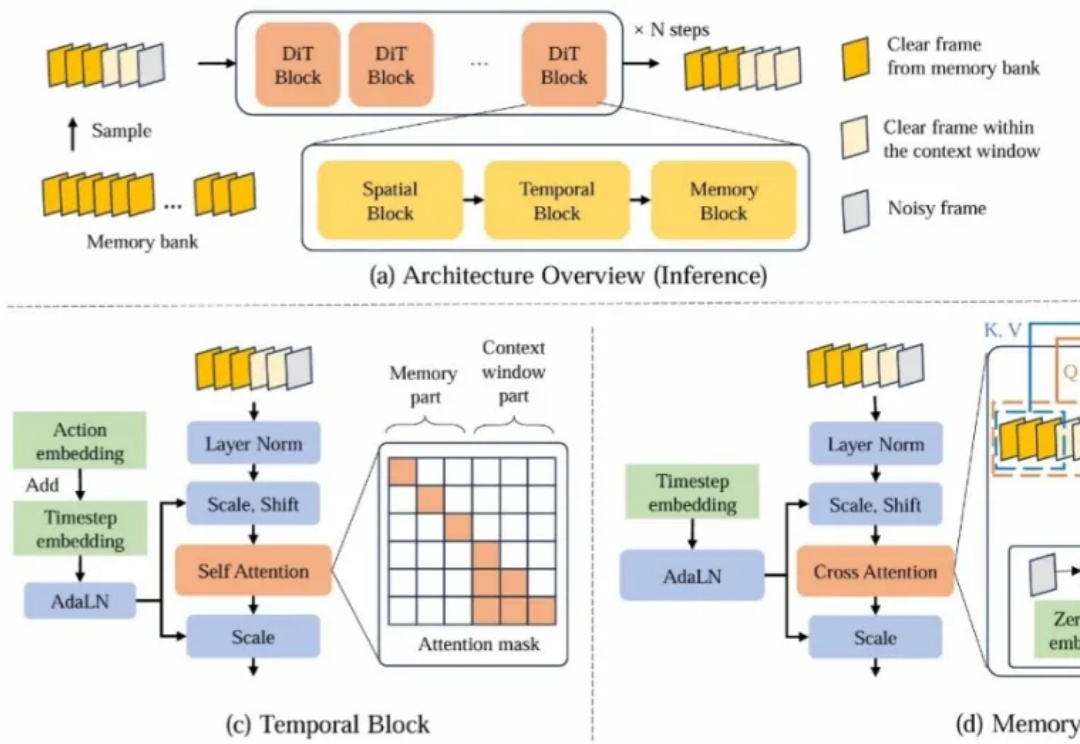

近年来,基于视频生成模型的可交互世界生成引发了广泛关注。尽管现有方法在生成质量和交互能力上取得了显著进展,但由于上下文时间窗口受限,生成的世界在长时序下严重缺乏一致性。

大型语言模型(LLMs)在上下文知识理解方面取得了令人瞩目的成功。