让ChatGPT连读“A”,直接崩溃到念广告词,网友:拿付费用户做测试呢?

让ChatGPT连读“A”,直接崩溃到念广告词,网友:拿付费用户做测试呢?网友挺生气。

网友挺生气。

大语言模型(LLMs)作为由复杂算法和海量数据驱动的产物,会不会“无意中”学会了某些类似人类进化出来的行为模式?这听起来或许有些大胆,但背后的推理其实并不难理解:

二者存在着根本的差异。

“新物种”爆发前夜。

杯子在我的左边还是右边?

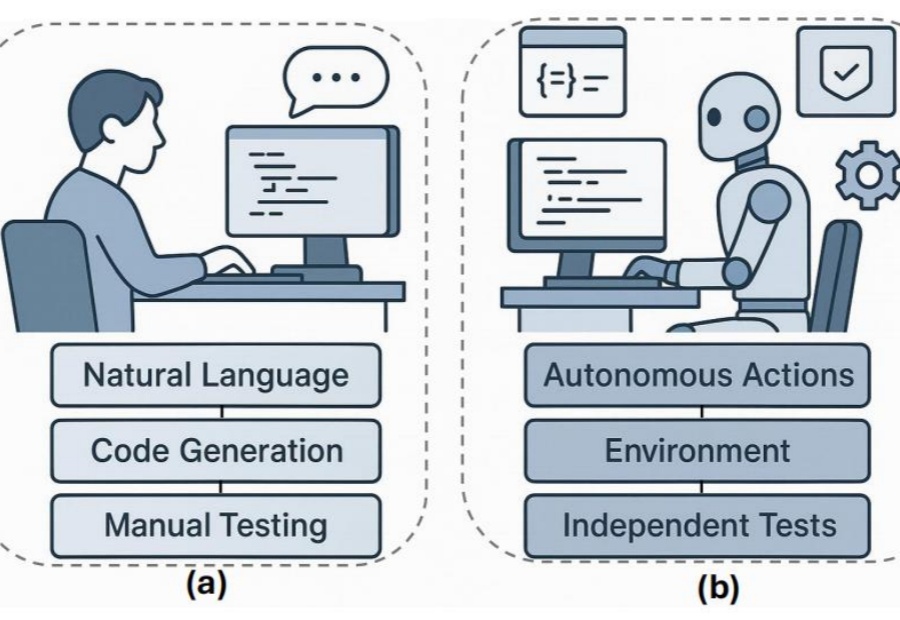

在多智能体AI系统中,一旦任务失败,开发者常陷入「谁错了、错在哪」的谜团。PSU、杜克大学与谷歌DeepMind等机构首次提出「自动化失败归因」,发布Who&When数据集,探索三种归因方法,揭示该问题的复杂性与挑战性。

生成式AGI已经颠覆了人们的生活,但AI工具并没有随着用户使用场景的融合而整合。各个赛道的头部玩家依靠独家的数据库发展模型,现有算力和数据量难以支撑多模态和跨业务领域拓展,急需形成用户粘性的市场竞争也使得AI的生成稳定性被优先考虑。

AI时代的护城河究竟在哪里?这个问题一直是这波AI浪潮中被大家广泛讨论的一个点。两年前,我没有找到这个问题的答案,所以在探索了半年AI创业后(可以看我23年的总结文章),我选择了做Advisor,接触更多的产品和创始人,试图从中找到这个问题的答案。

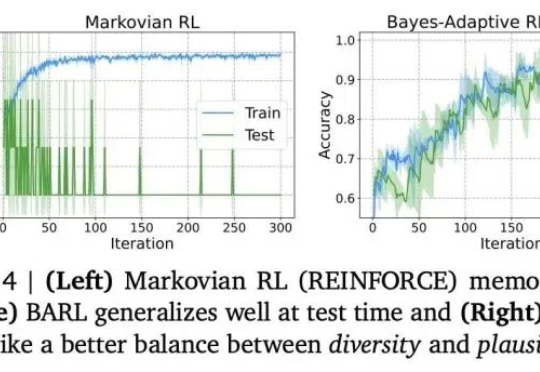

推理模型常常表现出类似自我反思的行为,但问题是——这些行为是否真的能有效探索新策略呢?

近年来,大语言模型(LLMs)的能力突飞猛进,但随之而来的隐私风险也逐渐浮出水面。