英伟达帮你省钱,让大模型推理「短而精」,速度快5倍

英伟达帮你省钱,让大模型推理「短而精」,速度快5倍大模型推理到底要不要「长篇大论」?过去一年,OpenAI o 系列、DeepSeek-R1、Qwen 等一系列推理模型,把「长链思维」玩到极致:答案更准了,但代价是推理链越来越长、Token 消耗爆炸、响应速度骤降。

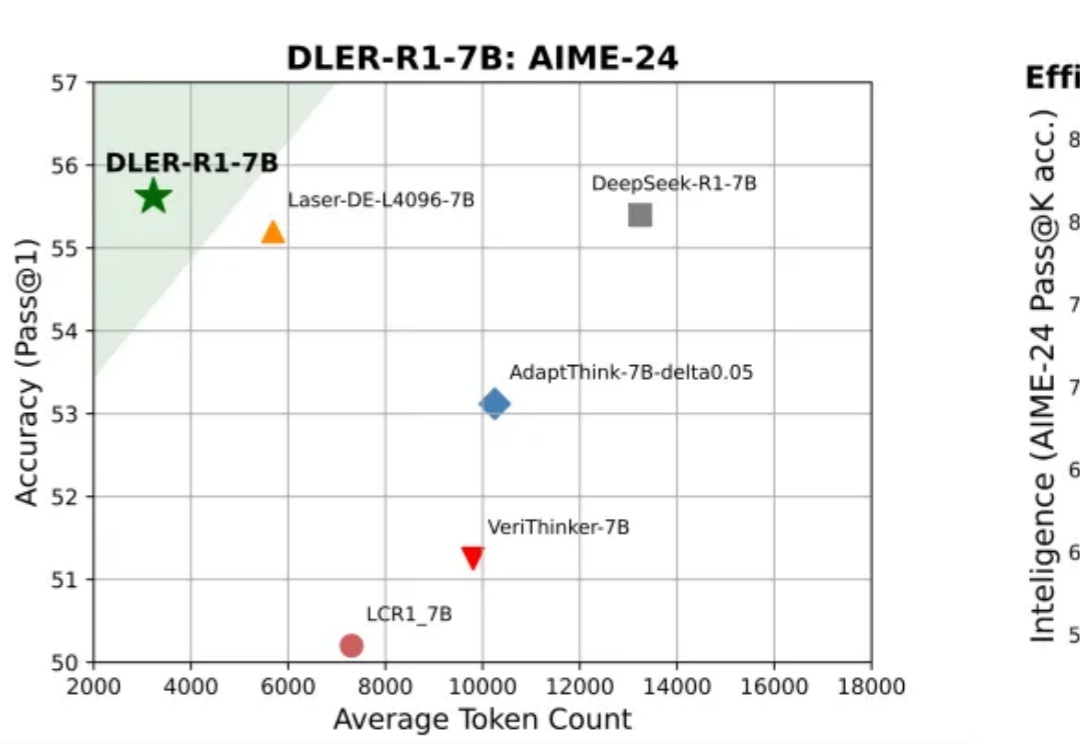

大模型推理到底要不要「长篇大论」?过去一年,OpenAI o 系列、DeepSeek-R1、Qwen 等一系列推理模型,把「长链思维」玩到极致:答案更准了,但代价是推理链越来越长、Token 消耗爆炸、响应速度骤降。

11 月 2 日,英伟达首次把 H100 GPU 送入了太空。作为目前 AI 领域的主力训练芯片,H100 配备 80GB 内存,其性能是此前任何一台进入太空的计算机的上百倍。在轨道上,它将测试一系列人工智能处理应用,包括分析地球观测图像和运行谷歌的大语言模型(LLM)。

是孩子该看的东西。

当用户向大语言模型提出一个简单问题,比如「单词 HiPPO 里有几个字母 P?」,它却正襟危坐,开始生成一段冗长的推理链:

从豆包的「产品卡」里,可以窥见大模型对产品销售的新链路已经展开。

传统智能体系统难以兼顾稳定性和学习能力,斯坦福等学者提出AgentFlow框架,通过模块化和实时强化学习,在推理中持续优化策略,并使小规模模型在多项任务中超越GPT-4o,为AI发展开辟新思路。

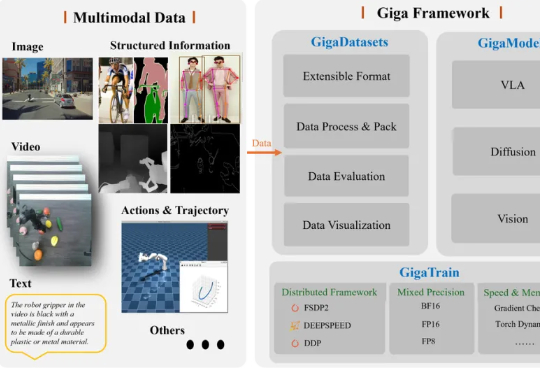

据《智能涌现》获悉,极佳视界近日完成新一轮亿元级A1轮融资,本轮融资由华为哈勃、华控基金联合投资。此前8月底,极佳视界宣布完成Pre-A&Pre-A+连续两轮数亿元融资。2个月3轮融资,体现了资本市场对极佳视界团队实力、技术路线和业务推进的认可,也折射出投资方对“物理世界通用智能”(物理AI)关键转折点的判断。

寒武纪成立的初衷是为「人工智能的大爆发」提供底层算力支持,不仅要硬件算力强大,更要软件通用、易用。寒武纪基础软件平台Cambricon NeuWare,让用户与开发者能够跨越不同的寒武纪硬件和应用场景,降低上手难度,提升开发效率,快速迁移与部署AI应用。

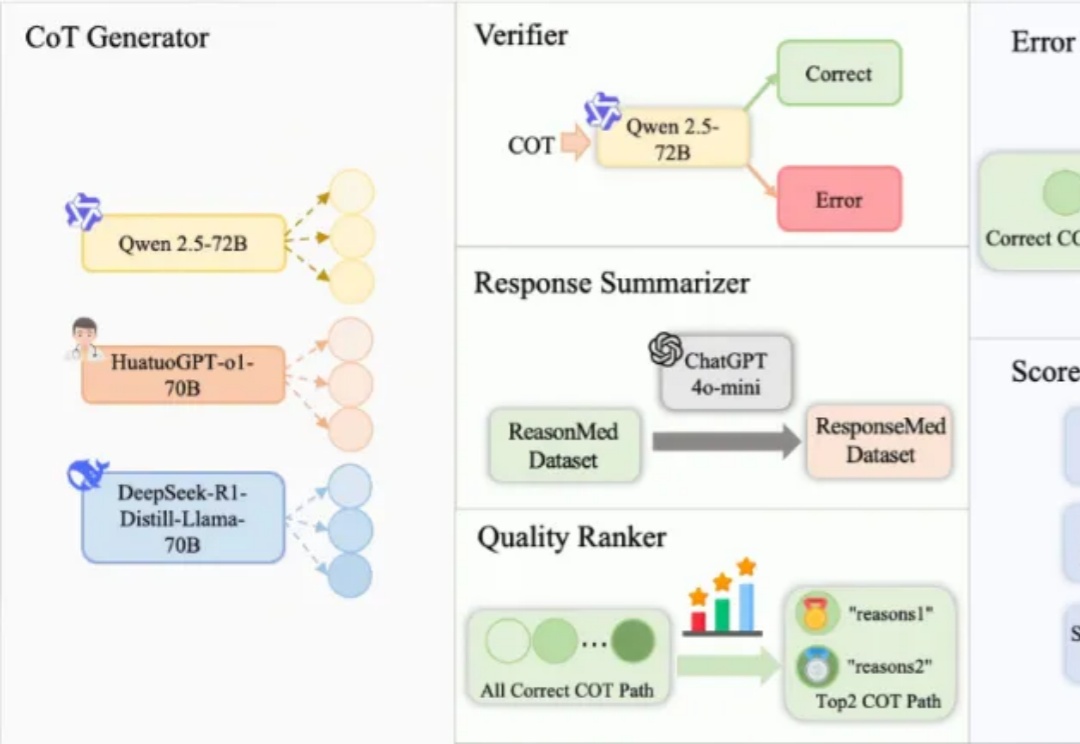

在人工智能领域,推理语言模型(RLM)虽然在数学与编程任务中已展现出色性能,但在像医学这样高度依赖专业知识的场景中,一个亟待回答的问题是:复杂的多步推理会帮助模型提升医学问答能力吗?要回答这个问题,需要构建足够高质量的医学推理数据,当前医学推理数据的构建存在以下挑战:

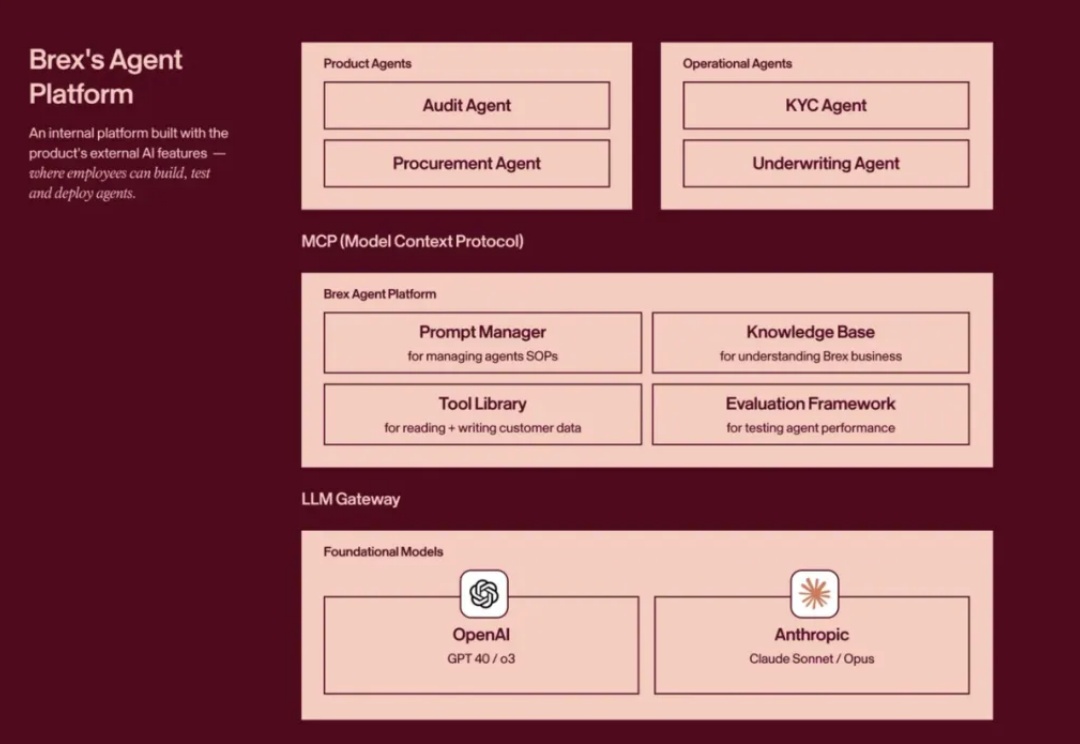

旧金山的超级独角兽,Brex,一家金融科技公司,做 Startup 内部的商业信用卡和现金管理平台。他们在公司内部运营的 AI 化上,非常非常激进,几乎完全实现了流程自动化。