有些时候真觉得,AI总结和“三分钟看电影”没啥区别。

有些时候真觉得,AI总结和“三分钟看电影”没啥区别。我好像有点,越来越不喜欢AI总结这件事了。

我好像有点,越来越不喜欢AI总结这件事了。

国庆不放假,国内AI厂商都在干嘛?百度:卷!

GPT-5一场闹剧,让OpenAI出大糗了!让所有人都以为GPT-5破解了十道Erdos难题,没想到竟是查文献给出了答案。Hassabis点评,这太尴尬了。

拒绝世界首富是什么体验?卡帕西:这事我熟!刚刚,马斯克高调邀请卡帕西,与Grok 5来一场编程对决——就像当年的“卡斯帕罗夫大战深蓝”。

10月18日,在离开OpenAI,联合创办Thinking Machines后,Lilian Weng在硅谷难得地参加了一场公开对话。在这场华源Hysta2025年年会的炉边对谈里,她和主持人、硅谷知名投资人Connie Chan聊了聊她自己的研究经历、研究习惯、在OpenAI的研究思考和Thinking Machines 的发展方向。

在近日的一次访谈中,Andrej Karpathy深入探讨了AGI、智能体与AI未来十年的走向。他认为当前的「智能体」仍处早期阶段,强化学习虽不完美,却是目前的最优解。他预测未来10年的AI架构仍然可能是类似Transformer的巨大神经网络。

英伟达不光自己成长高速,现在它在AI领域的投资也坐上火箭了。 最新数据显示,2025年过去的三个季度里,英伟达参与了50笔AI相关风险投资,这个数量已经超过了2024年全年的48笔。

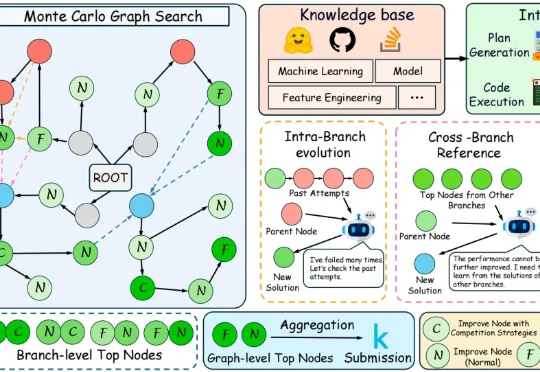

在代码层面,大语言模型已经能够写出正确而优雅的程序。但在机器学习工程场景中,它离真正“打赢比赛”仍有不小差距。

硬刚Sora2,谷歌刚刚发布新动作——Veo3.1。

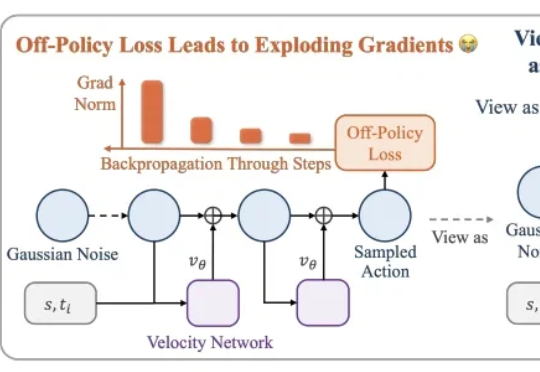

本文介绍了一种用高数据效率强化学习算法 SAC 训练流策略的新方案,可以端到端优化真实的流策略,而无需采用替代目标或者策略蒸馏。SAC FLow 的核心思想是把流策略视作一个 residual RNN,再用 GRU 门控和 Transformer Decoder 两套速度参数化。