安卓率先跑通多模态大模型,终端本地就能看图生成文本!高通:WiFi都会AI起来

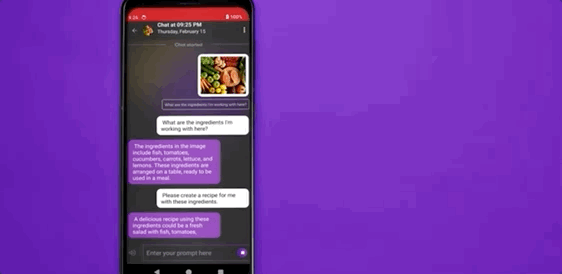

安卓率先跑通多模态大模型,终端本地就能看图生成文本!高通:WiFi都会AI起来多模态大模型,首次本地部署在安卓手机上了!

多模态大模型,首次本地部署在安卓手机上了!

近日,获悉多模态大模型初创公司香港 Weitu AI 公司完成了天使轮融资,天使轮估值一亿美金。天使轮投资人为拥有全球数亿月活的互联网科技公司和著名天使投资人。据了解,该公司目前刚刚成立,超过半数成员来自北美名校毕业并拥有海外大厂的工作经验。

去年年底,谷歌 Gemini 震撼了业界,它是谷歌「最大、最有能力和最通用」的 AI 系统,号称第一个原生多模态大模型,能力超越 GPT-4,也被认为是谷歌反击微软和 OpenAI 的强大工具。

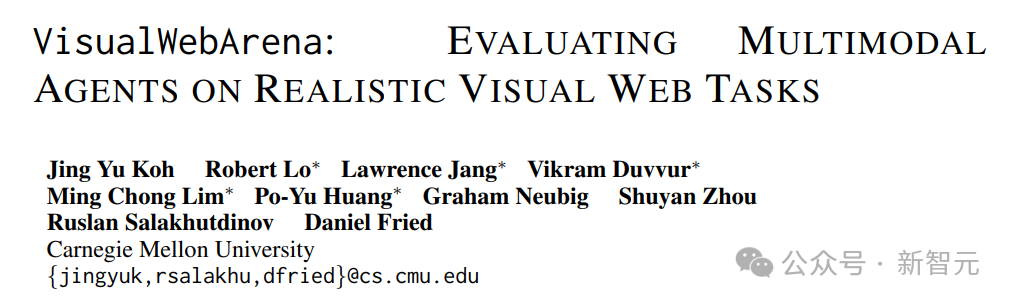

大模型的新考验来了!近日,来自卡内基梅隆大学的研究人员发布了评估LLM多模态Web代理性能的基准测试。

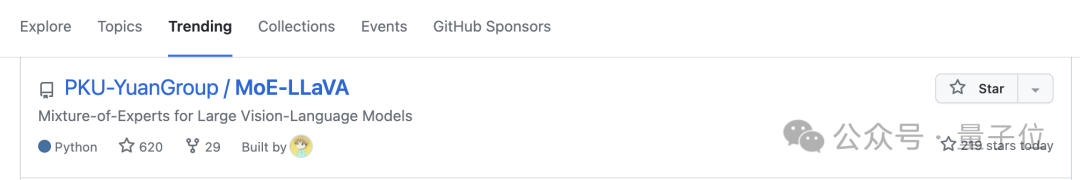

混合专家(MoE)架构已支持多模态大模型,开发者终于不用卷参数量了!北大联合中山大学、腾讯等机构推出的新模型MoE-LLaVA,登上了GitHub热榜。

随着多模态大语言模型(Multimodal Large Language Model,MLLM)的快速发展,以 MLLM 为基础的多模态 agent 逐渐应用于各种实际应用场景中,这使得借助多模态 agent 实现手机操作助手成为了可能。

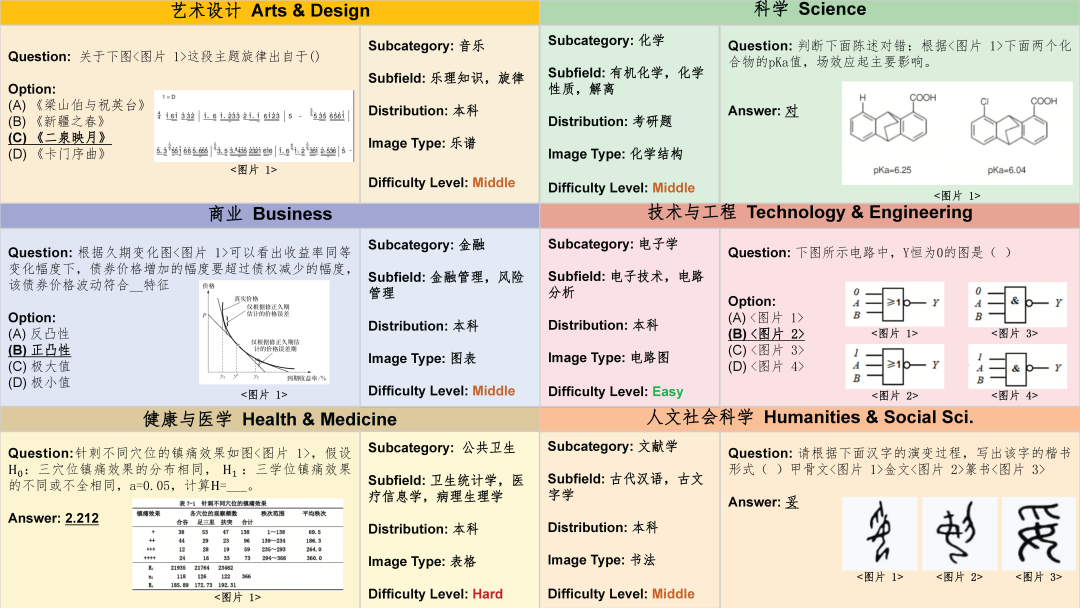

华中科技大学联合华南理工大学、北京科技大学等机构的研究人员对14个主流多模态大模型进行了全面测评,涵盖5个任务,27个数据集。

对于大型视觉语言模型(LVLM)而言,扩展模型可以有效提高模型性能。然而,扩大参数规模会显著增加训练和推理成本,因为计算中每个 token 都会激活所有模型参数。

动态视觉分词统一图文表示,快手与北大合作提出基座模型 LaVIT 刷榜多模态理解与生成任务。

近期,随着多模态大模型(LMM) 的能力不断进步,评估 LMM 性能的需求也日益增长。与此同时,在中文环境下评估 LMM 的高级知识和推理能力的重要性更加突出。