当奖励成为漏洞:从对齐本质出发自动「越狱」大语言模型

当奖励成为漏洞:从对齐本质出发自动「越狱」大语言模型本文第一作者为香港大学博士研究生谢知晖,主要研究兴趣为大模型对齐与强化学习。

本文第一作者为香港大学博士研究生谢知晖,主要研究兴趣为大模型对齐与强化学习。

罗盟,本工作的第一作者。新加坡国立大学(NUS)人工智能专业准博士生,本科毕业于武汉大学。主要研究方向为多模态大语言模型和 Social AI、Human-eccentric AI。

当前的大型语言模型似乎能够通过一些公开的图灵测试。我们该如何衡量它们是否像人一样聪明呢?

在技术发展和用户需求的双重驱动下,大量AI虚拟角色对话类产品接连出现,如Character.ai、Glow等。大语言模型使AI能够更好地理解和模拟人类情感,提供更自然、个性化的交互体验,同时又能赋予现实生活中不存在的角色以“灵魂”,让许多动漫、影视中的角色“活过来”,满足用户情感互动与内容娱乐消费的诉求。

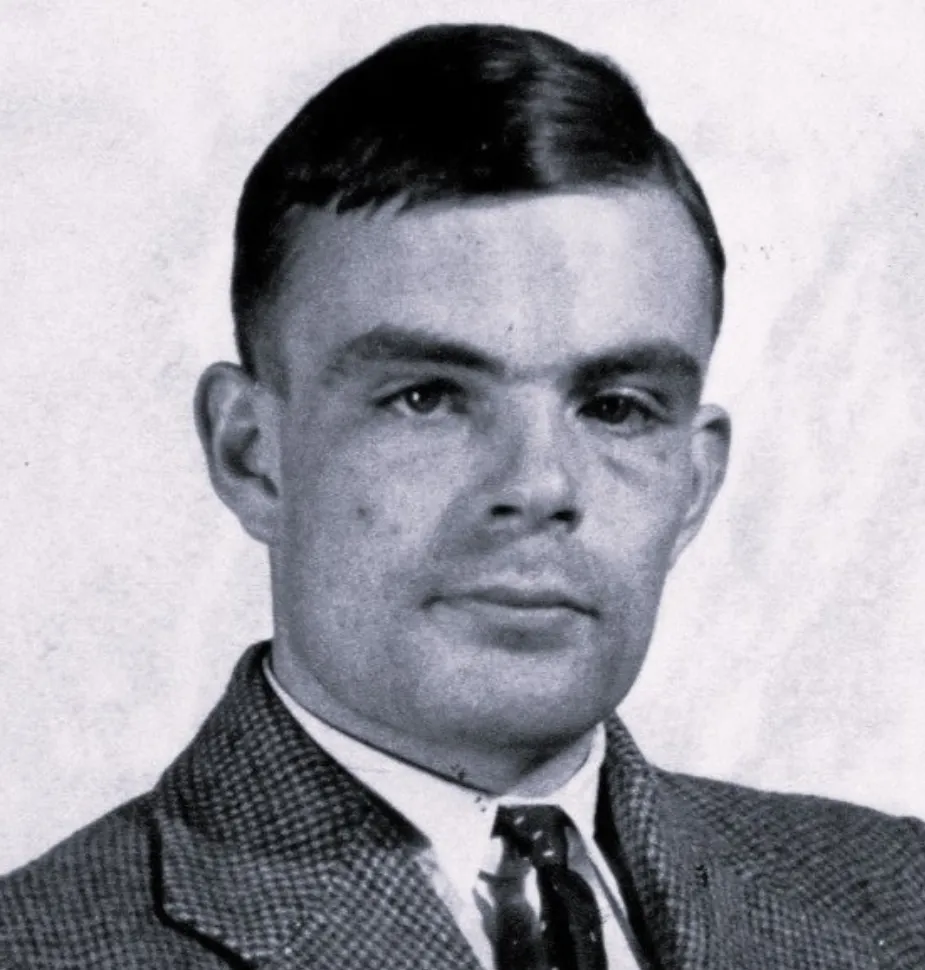

在当今人工智能领域,大语言模型及其相关工具正在迅速发展,涵盖了编程、数据库、检索引擎、聊天机器人、生成式 AI 工具、模型 API、开发框架和平台等各个方面。

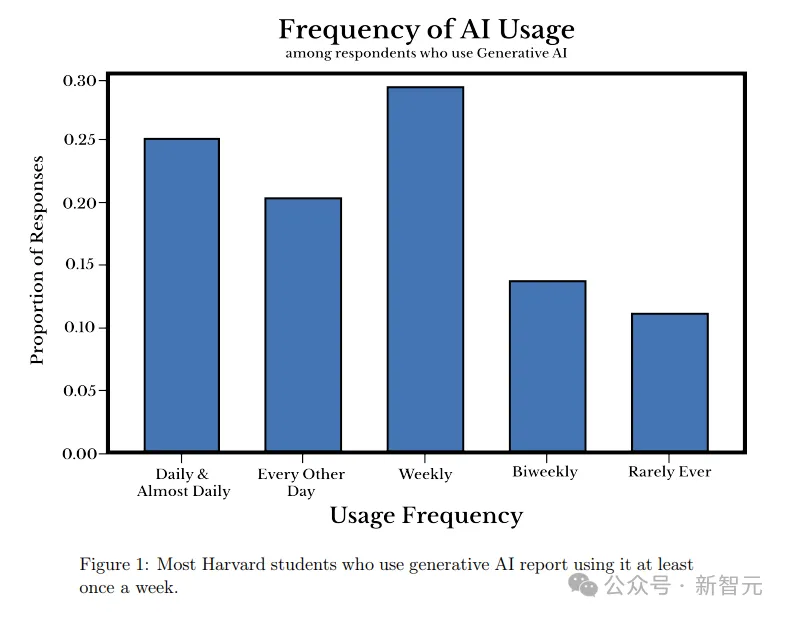

哈佛大学的一项最新研究表明,大语言模型已经深入学生的日常生活。为何学生们对AI的兴趣如此浓厚,背后的原因恐怕是这所大学的教授们。

Emory大学的研究团队提出了一种创新的方法,将大语言模型(LLM)在文本图(Text-Attributed Graph, 缩写为TAG)学习中的强大能力蒸馏到本地模型中,以应对文本图学习中的数据稀缺、隐私保护和成本问题。通过训练一个解释器模型来理解LLM的推理过程,并对学生模型进行对齐优化,在多个数据集上实现了显著的性能提升,平均提高了6.2%。

虽然大语言模型(LLM)的能力不断突破,但在长文生成方面却一直存在瓶颈。近日,清华大学和智谱AI联合发布的最新研究成果,为解决这一难题提供了创新方案。这项名为"LongWriter"的技术,成功将AI模型的长文生成能力从约2000字提升至10000字以上,同时保持了高质量输出。这一成果通过创新的数据构建方法、模型训练策略和评估基准,为AI长文创作开辟了新天地。

AI 技术在辅助抗体设计方面取得了巨大进步。然而,抗体设计仍然严重依赖于从血清中分离抗原特异性抗体,这是一个资源密集且耗时的过程。

在未来,从大语言模型的角度,「Canva可画」会向着更加垂直、更加深耕的方向来发展。