VLM集体「失明」?视力测试惨败,GPT-4o、Claude 3.5全都不及格

VLM集体「失明」?视力测试惨败,GPT-4o、Claude 3.5全都不及格视觉大语言模型在最基础的视觉任务上集体「翻车」,即便是简单的图形识别都能难倒一片,或许这些最先进的VLM还没有发展出真正的视觉能力?

视觉大语言模型在最基础的视觉任务上集体「翻车」,即便是简单的图形识别都能难倒一片,或许这些最先进的VLM还没有发展出真正的视觉能力?

最近,新加坡国立大学联合南洋理工大学和哈工深的研究人员共同提出了一个全新的视频推理框架,这也是首次大模型推理社区提出的面向视频的思维链框架(Video-of-Thought, VoT)。视频思维链VoT让视频多模态大语言模型在复杂视频的理解和推理性能上大幅提升。该工作已被ICML 2024录用为Oral paper。

基于 ChatGPT、LLAMA、Vicuna [1, 2, 3] 等大语言模型(Large Language Models,LLMs)的强大理解、生成和推理能力

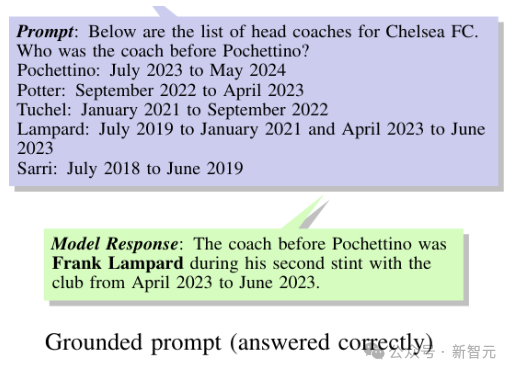

近日,来自谷歌DeepMind的研究人员,推出了专门用于评估大语言模型时间推理能力的基准测试——Test of Time(ToT),从两个独立的维度分别考察了LLM的时间理解和算术能力。

大语言模型有道德推理能力吗?不仅有,甚至可能在道德推理方面超越普通人和专家学者!最新研究发现:GPT-4o针对道德难题给出的建议比人类专家更让人信服。

开源大语言模型(LLM)百花齐放,为了让它们适应各种下游任务,微调(fine-tuning)是最广泛采用的基本方法。基于自动微分技术(auto-differentiation)的一阶优化器(SGD、Adam 等)虽然在模型微调中占据主流,然而在模型越来越大的今天,却带来越来越大的显存压力。

马斯克连回两条推文为xAI造势,宣布8月发布Grok 2,年底将推出在10万张H100上训练的Grok 3,芯片加持创新数据训练,打造对标GPT的新一代大语言模型。

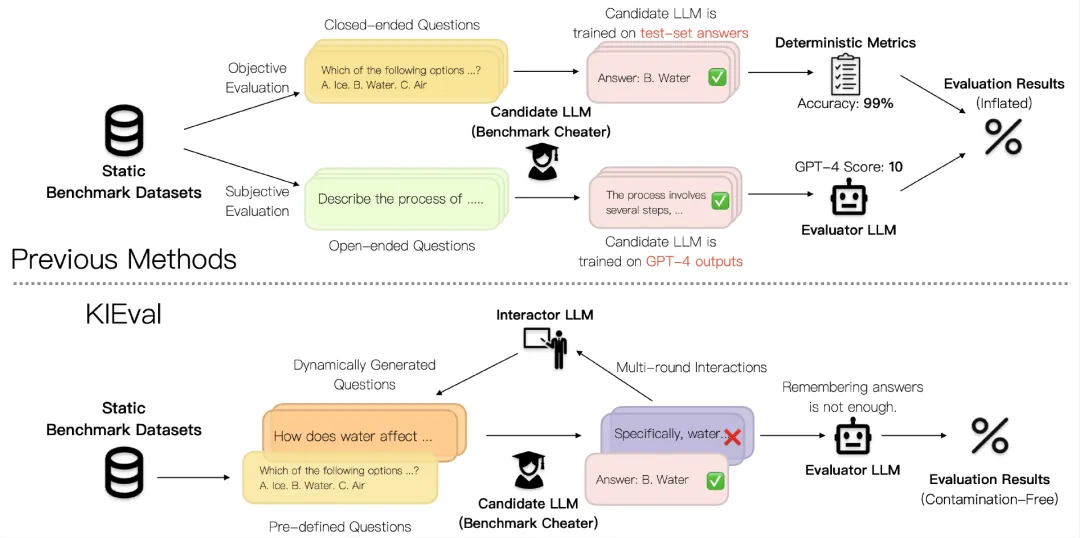

当前大语言模型(LLM)的评估方法受到数据污染问题的影响,导致评估结果被高估,无法准确反映模型的真实能力。北京大学等提出的KIEval框架,通过知识基础的交互式评估,克服了数据污染的影响,更全面地评估了模型在知识理解和应用方面的能力。

本文研究发现大语言模型在持续预训练过程中出现目标领域性能先下降再上升的现象。

本文介绍了一篇语言模型对齐研究的论文,由瑞士、英国、和法国的三所大学的博士生和 Google DeepMind 以及 Google Research 的研究人员合作完成。